Yann LeCun'un yeni çalışması: 473 modelin büyük bir karşılaştırması Çin, Japonya ve Kore'de metin sınıflandırması için ne tür kodlama kullanılmalıdır?

Leifeng.com AI Teknolojisi Yorumu: Sadece birkaç gün önce, Yann LeCun (Çince adı: Yang Likun, evrişimli ağların babası olarak bilinir) ve öğrencisi Zhang Xiang, arXiv'de "Metin için En İyi Kodlama" adlı yeni bir çalışma yayınladı. Çince, İngilizce, Japonca ve Korece sınıflandırması? ". Bu makale 473 model içeren geniş çaplı bir karşılaştırmalı deney gerçekleştirdi Deneyin amacı, metin sınıflandırma görevlerinde farklı dillerin (İngilizce, Çince, Korece ve Japonca) farklı düzeylerini (utf-8, karakterler vb.) Ve kodlamalarını karşılaştırmaktır. (Kelime torbası, vb.) Farklı modellerin (doğrusal modeller, fastText, ConvNets, vb.) Birleşik etkileri test edildi ve bir dizi değerli sonuç elde edildi. Bu makalede, Leifeng.com bu makaleyi ayrıntılı olarak analiz edecektir.

Metin sınıflandırması, otomatik makale sınıflandırması, otomatik posta sınıflandırması, istenmeyen posta tanıma, kullanıcı duyarlılığı sınıflandırması vb. Gibi doğal dil işlemede en yaygın uygulamalardan biridir. Hayatta pek çok örnek vardır. Ancak, farklı diller arasındaki büyük farklılıklar nedeniyle (örneğin, Çince, Korece, Japonca gibi CJK dilleri ve İngilizce gibi alfabetik diller işleme açısından çok farklıdır). Örneğin, son zamanlarda bazı insanlar dilde kelime segmentasyonu ile başa çıkmak için karakter seviyesinde kodlama sinir ağlarını (ConvNets) kullanıyorlar, ancak ne yazık ki, CJK diliyle başa çıkmak için karakterleri kullanmak pek iyi değil, çünkü karakter sayısı şu anda çok artacak. . Öyleyse tüm bu doğal dilleri işlemede iyi performans gösteren bir model bulabilir miyiz? Yazarın yaklaşımı, bir dizi modeli (473) listelemek ve performanslarını karşılaştırmaktır.

1. Veri setleri

Bu makale Çince, İngilizce, Japonca ve Korece olmak üzere 4 dili ele almaktadır. Yazarlar Dianping (Çince, restoran), JD (Çince, çevrimiçi mağaza), Rakuten (çevrimiçi mağaza, Japonca), 11inci (çevrimiçi mağaza, Korece), Amazon (İngilizce, çevrimiçi mağaza), Phoenix.com (Çince, haberler) China Daily (Çince, Haberler) ve NYnews (İngilizce, Haberler) dahil olmak üzere sekiz web sitesi, 8 duyarlılık sınıflandırma veri kümesini taradı. Bunların arasında Jingdong, Rakuten, 11. ve Amazon veri setleri beş yıldızlı sınıflandırma ve çift sınıflandırmaya ayrılmıştır (1, 2 yıldız negatif, 3 yıldız atılmıştır ve 4, 5 yıldız pozitif). Ek olarak, bu dört web sitesinin tamamı çevrimiçi mağaza olduğu için, iki ortak veri setinde birleştirmek için kullanılabilirler (tümü beş yıldızlı ve ikiye bölme yöntemi). Bu iki veri seti dört dilin bir karışımı olduğu için kullanılabilirler. Modelin farklı dilleri işleme yeteneğini kontrol edin. Özetle, 14 duyarlılık sınıflandırma veri seti vardır.

2. Kodlama seviyesi

Sözde kodlama seviyesi, metin analizi düşünüldüğünde en küçük birimdir. Metinde belirtilen kodlama seviyeleri şunları içerir: karakterler, UTF-8 (bayt), latin harflerle yazılmış karakterler, kelimeler, latin harflerle yazılmış kelimeler vb.

3. Kodlama Mekanizması

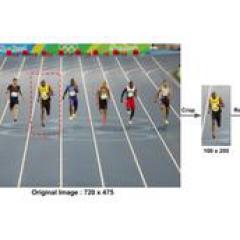

Bu makalede seçilen derin öğrenme modeli, ağ katmanlarının sayısına göre büyük Ağ (12 katman) ve küçük Ağ (8 katman) olarak ikiye ayrılan ConvNets (ConvNets) 'dir. Evrişimli ağ modelinin eğitiminde, metnin makine tarafından tanınması için kodlanması gerekir. Bu makalede üç kodlama mekanizması yer almaktadır: Karakter Glifi, Tek Sıcak Kodlama ve Gömme.

1. Karakter Kabartma (Karakter Kabartması)

Sözde glif, okuma ve yazmada tanınabilen bir semboldür Örneğin, Çince karakterlerde "" veya İngilizce'de "a" konturu tanınabilir bir gliftir. Bu makalede yazar, her glifi 16 * 16 piksellik bir matrise dönüştürüyor. Açıkçası, bu kodlama mekanizması CJK dili için (daha zengin karakterlerle) çok uygundur. Bununla birlikte, bu yöntem yalnızca karakter düzeyinde gerçekleştirilebilir, bu nedenle yalnızca GlyphNet adı verilen evrişimli bir ağ modeli oluşturulabilir.

2. Tek Sıcak Kodlama

Bir sıcak kod, sezgisel olarak konuşursak, durumların olduğu kadar çok bitin olduğu ve sadece bir bitin 1 ve diğerlerinin hepsinin 0 olduğu bir kod sistemidir. Örneğin, 6 durumlu tek sıcak kod durum kodları şunlardır: 000001, 000010, 000100, 001000, 010000, 100000. İngilizce bir harf kodlamasıysa, durum kodu uzunluğunun 26 olması gerekir. Tek sıcak kod kodlamasının en büyük avantajı, durumları karşılaştırırken yalnızca bir bitin karşılaştırılması gerektiğidir, bu da kod çözme mantığını belirli bir dereceye kadar basitleştirir. Bununla birlikte, tabii ki, karakter sayısı çok büyükse (CJK dili), tek sıcak kodun kod uzunluğu çok büyük olacaktır. Bununla birlikte, bu makalede yazar, bu sorunu çözmek için iki yol üzerinde durmaktadır: Birincisi, tüm metni (UTF-8) bir bayt dizisi olarak ele almak, onu bayt düzeyinde kodlamak ve bir evrişim oluşturmaktır. Ağ modeli, bayt düzeyinde OnehotNet olarak adlandırılır; ikincisi, metni romanlaştırmak, yani kodlamak için İngilizce harfleri kullanmaktır (bu yöntemin, bayt düzeyinde kodlamak için romanlaştırılmış metin kullanmaya eşdeğer olduğunu belirtmek gerekir), Oluşturulan evrişimli ağ modeline Romanization OnehotNet denir. Bayt düzeyinde işlemenin avantajı, dilin karakter veya yazı tipi düzeyinde kaç varlık içerdiğine bakılmaksızın herhangi bir dile uygulanabilmeleridir, böylece CJK diline de kolayca uygulanabilirler.

3. Gömme

Sözde gömülü kod, her bir varlığın sabit uzunlukta bir vektör ile temsil edildiği anlamına gelir. Örneğin, "A B A C B F G" gibi bir dizi için, sonunda şunu elde edebiliriz: Karşılık gelen bir vektör, B'ye karşılık gelen vektör (buradaki değer yalnızca gösterim içindir). Bu vektör gösterimi rasgele başlatıldığından, tek etkin kod kadar katı değildir, dolayısıyla bellekte tek etkin koddan daha küçüktür. Diğer bir avantajı, herhangi bir kodlama seviyesine uygulanabilmesidir. Bu nedenle, bu makalede yazar, gömme kodlarını kodlamak ve karşılaştırmak için farklı kodlama seviyelerinde bayt, karakter, kelime, Latin harfli karakter, Latin harfli kelimeler vb. Kullanmaktadır.Gömülü kod vektörünün uzunluğu 256'dır.

Bu şekilde oluşturulan evrişimli ağ modeli EmbedNet olarak adlandırılır. Bu model kodlaması beş düzeyde gerçekleştirilebilir: karakterler, bayt, robotlaştırılmış karakterler, sözcükler ve robotlaştırılmış sözcükler, dolayısıyla beş model vardır.

Özetle, (1 + 2 + 5) * 2 = 16 evrişimli ağ modeli vardır.

Üç, doğrusal model ve fastText modeli

Evrişimli ağ modeline ek olarak, bu makalede yazar ayrıca karşılaştırma için bir doğrusal model (doğrusal model) ve fastText modeli seçmiştir.

1. Doğrusal model

Geleneksel metin sınıflandırma yönteminin süreci, bazı özellikleri manuel olarak tasarlamak, orijinal belgedeki özellikleri çıkarmak ve ardından LR ve SVM gibi sınıflandırıcılar belirlemek ve modeli metni sınıflandırmak üzere eğitmektir. Frekans yöntemi (makalede açıkça belirtilmiştir), TF-IDF, vb. Gibi daha klasik özellik çıkarma yöntemleri. Sözde frekans yöntemi, adından da anlaşılacağı gibi, sınıflandırma için her bir metindeki varlıkların frekans dağılımını (karakter, kelime ve latinleştirilmiş kelime gibi) kaydetmek ve saymaktır. Ancak "" ve "" gibi bazı kelimeler daha sık görünse de aslında anlamsızdır. Böylece başka bir doğrusal model TF-IDF önerildi. TF, metindeki öğenin sıklığını temsil eden, ancak IDF'nin ağırlığını (ters belge sıklığı) ekleyen terim sıklığı anlamına gelir. Tüm belgelerde ortaya çıkma sıklığı ne kadar büyükse, örnekteki terimin IDF'si o kadar küçük olur. Dolayısıyla TF * IDF, basit frekans istatistiklerinden daha doğru olan bir projenin istatistiksel sonucu olarak kullanılabilir.

2. fastText modeli

FastText modeli, 2016 yılında Joulin ve diğerleri tarafından önerilen hızlı bir sınıflandırma modelidir. Model, hiyerarşik softmax ve özellik karması gibi teknikleri içerir. Bu model, girdi metnini birkaç büyüklük sırasına göre ConvNets modelinden daha hızlı işleyebilir. Temelde, fastText modeli, doğrusal olmama olmaksızın, 2 katmanlı, tamamen bağlı bir sinir ağıdır.

Yukarıdaki iki modelde, yazar karakter, kelime ve romantize edilmiş kelimeyi üç kodlama seviyesini seçti, ancak hala çözülmemiş bir sorun var, yani istatistik / yargılama birimi ne kadar büyük? Bu bir kavramı içerir: n-gram. Verilen metni bir dizi uzunluk terimine dönüştürmek anlamına gelir. Örneğin, "Bugün tatil yaptınız mı?", 2 gramlık sekansı: "Bugün, bugün, günlük tatil, tatil, tatil misiniz?" Yazar, doğrusal model için 1 gram ve 5 gram ve fastText modeli için 1 gram, 2 gram ve 5 gram seçti.

Özetle, yazar 3 * 2 * 2 = 12 doğrusal model ve 3 * 3 = 9 fastText modeli oluşturmuştur.

Dördüncü olarak, sonuç

Yukarıdaki dört dil için, Çince, Japonca, Korece ve birleşik olarak 11 veri kümesi vardır, her biri 37 modeldir; İngilizce 3 veri kümesi, her biri 22 model içerir. Karşılaştırmaya toplam 473 model katıldı. Tablodaki veriler, eğitim hatası yüzdesini temsil eder.

Ayrıca her modelin harcadığı zaman da farklıdır ve farkın büyüklüğü çok büyüktür. Yazar, ortak iki taraflı veri setinin 1 milyon örneğini eğiterek aşağıdaki karşılaştırma verilerini elde etti. Bu karşılaştırma yalnızca referans içindir ve özel durum, bilgisayar ortamına göre değişiklik gösterecektir.

V. Sonuç

Yazar, yukarıdaki tablodaki hata oranlarını karşılaştırarak aşağıdaki sonuçlara varır:

1. FastText modeli, karakter düzeyinde kodlamada Çince, Japonca ve Korece metin (CJK dili metni) için daha iyi işleme sonuçlarına sahipken, İngilizce metin için kelime düzeyinde kodlamada daha iyi işleme sonuçları vardır;

2. FastText ve lineer modeller için CJK dilinin kelime düzeyinde kodlaması, mükemmel segmentasyon olmaksızın aynı etkiye sahiptir;

3. Evrişimli ağlar için en iyi kodlama mekanizması, bayt düzeyinde tek sıcak kodlamadır. Bu, evrişimli ağların metni düşük seviyeli temsillerden anlayabildiğini ve birden çok dili işlemek için tutarlı ve birleşik bir yol sağladığını gösterir.

4. FastText, evrişimli ağlara göre aşırı uyuma daha yatkındır ve doğrusal modellerden daha fazla temsil kapasitesi göstermez.

Tabii ki, yazar karşılaştırma için 473 model listelese de hepsi değil. Örneğin, derin öğrenme modeli bu makaledeki yalnızca evrişimli ağ modelini kullanır, ancak aslında yinelenen ağlar gibi başka ilginç modeller de vardır. Yazar, gelecekte periyodik ağı incelemeyi ve aynı zamanda evrişimli ağ modelini nasıl bir etkiye sahip olacağını görmek için geliştirmeyi planlıyor gibi görünüyor.

Leifeng.com'a göre, makalede kullanılan tüm kaynak kodların ve veri setlerinin daha sonra yayınlanacağı söyleniyor.

Kağıt indirme: https://arxiv.org/pdf/1708.02657.pdf

-

- Kuvvetli rüzgar ve şiddetli yağmur Quanzhou'ya baskın düzenledi! Ağaç küçük arabaya düştü! Lütfen Qingming'e geri dönün ...

-

- Vatanseverlik eğitiminin güçlendirilmesi Hunan'da 2019 yılında "Kitabevim · Hayalim" okuma uygulaması başlatıldı

-

- Bellek / SSD fiyatları düşüyor mu? Yetersiz talep nedeniyle, depolama peletlerinin sözleşme fiyatı düşmeye devam ediyor