IBM Kıdemli Ar-Ge Mühendisi Wu Wei: Dağıtılmış derin öğrenme modelleri nasıl eğitilir? | Özeti paylaş

Leifeng Net AI Araştırma Enstitüsü Basın : Derin öğrenme sinir ağlarının artan ölçeğiyle, derin bir sinir ağını (Derin Sinir Ağları, DNN'ler) eğitmek genellikle günler hatta haftalar alır. Öğrenme hızını artırmak için, genellikle tüm eğitimi tamamlamak için dağıtılmış bir CPU / GPU kümesine ihtiyaç vardır. Bu makale size dağıtılmış eğitim derin öğrenme modellerinin nasıl yapılacağına dair kısa bir giriş verecektir.

Leifeng.com AI Araştırma Enstitüsü'nün son çevrimiçi açık sınıfında, IBM Sistemler Departmanından bir Ar-Ge mühendisi olan Dr. Wu Wei size "Derin Öğrenmede Dağıtılmış Eğitim" konulu bir çevrimiçi paylaşım oturumu verdi. Canlı yayını kaçıran öğrenciler Bu makaleyi okuduktan sonra herhangi bir şüpheniz varsa, Leifeng.com AI MOOC Academy'de de izleyebilirsiniz. Video oynatma .

Aşağıdakiler, Leifeng.com tarafından canlı video içeriğinin kısa bir incelemesidir:

Wu Wei, IBM Sistem Departmanında Ar-Ge mühendisidir. Eskiden Huawei Büyük Veri Ürün Departmanı ve IBM Çin Araştırma Enstitüsü'nde sistem mühendisi / araştırmacı olarak çalışıyordu. Xian Jiaotong Üniversitesi'nden sistem mühendisliği alanında doktorası var. Mevcut araştırma ve geliştirme yönergeleri, derin öğrenmede dağıtılmış eğitim çerçeveleri ve model.

Ana hatları paylaşın:

-

Neden dağıtılmış eğitim derin öğrenme modellerine ve dağıtılmış TensorFlow mimarisine ihtiyacımız var?

-

TensorFlow grafik içi kopya ve grafikler arası kopya.

-

Derin öğrenme modellerinin asenkron eğitimi ve senkronize eğitimi.

-

Örnek Olay: Bağımsız model nasıl dağıtılır.

-

Dağıtılmış model eğitim performansına giriş.

İçerik paylaşma:

Herkese merhaba. Ben Wu Wei. Bugünün paylaşımının ilk bölümü dağıtılmış eğitimin ve dağıtılmış TensorFlow mimarisinin neden kullanıldığını tanıtacak. İkinci bölüm TensorFlow grafik içi çoğaltma ve grafikler arası çoğaltma hakkında konuşuyor. Üçüncü bölüm dağıtılmış eğitimle ilgili. Eşzamanlı eğitim ve eşzamansız eğitime kısa bir giriş. Dördüncü bölüm, bağımsız modelin dağıtılmış bir modele nasıl dağıtılacağıyla ilgilidir ve beşinci bölüm, dağıtılmış eğitimin performansına bir giriş niteliğindedir.

Dağıtık eğitim neden kullanılmalı, dağıtılmış eğitim esas olarak hangi sorunlarla ilgilenir ve bununla nasıl başa çıkılır?

Aşağıdaki şekil TPU mimarisi veri merkezi hakkındadır

İlk neden eğitim verimini artırmak, ikinci neden ise genellikle tek bir cihaza sığamayan büyük modeller yetiştirmektir.

Aşağıdaki soldaki şekildeki apsis, GPU sayısı olarak düşünülebilir ve ordinat, görüntü işleme hızıdır.

Büyük modeller için nasıl eğitim verilir? Mevcut yöntem, modeli farklı GPU kartlarına ayırmak ve her bir GPU kartının bir kısmını eğitmektir, böylece büyük bir model dağıtılmış bir şekilde eğitilebilir.

Bu süreç nasıl uygulanır

Solda TensorFlow'un temel çalışan bir süreci var.

TensorFlow'un geliştirme süreci

Dağıtılmış TensorFlow mimarisi, mimarisi Master ve Slaver mimarisine dayanmaktadır.

Yukarıdakiler, usta ve köleci perspektifinden derin öğrenme dağıtılmış mimaridir, aşağıdakiler işçi perspektifindedir:

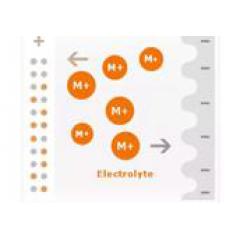

Derin öğrenmenin önce parametreleri eğitmesi gerekir. Dağıtılmış olarak, parametreler parametre sunucusunda saklanacaktır.Çalışanın hesaplaması gerekiyorsa, önce parametreleri parametre sunucusundan CPU'ya okuyun. Şu anda, derin öğrenme eğitiminin çoğu GPU cihazlarında gerçekleştirilmektedir, bu nedenle okunan verilerin GPU'ya kopyalanması gerekir ve GPU, soldan sağa hesaplamaya başlayabilir. Son olarak, değişkene karşılık gelen gradyan türetilerek bulunur ve daha sonra gradyan makinedeki karşılık gelen CPU'ya kopyalanır ve CPU bunu ağ iletişimi yoluyla parametre sunucusuna gönderir.Bu, dağıtılmış mimariye tüm çalışanın perspektifinden bakmak içindir.

TensorFlow'un dağıtılmış eğitimde iki önemli kavramı daha vardır: "grafik içi replikasyon" ve "grafikler arası replikasyon". Dağıtılmış eğitim, bir küme olduğu ve ilk önce dağıtılmış bir küme tanımlandığı anlamına gelir. Aşağıdaki resimdeki kopyadır, bu durum çoklu kartlı tek bir makine için uygundur.

Birden fazla bilgisayar varsa, veri dağıtımının neden olduğu veri darboğazı nispeten büyük olacaktır.Grafik içi çoğaltma kullanılırsa, veri iletimi bir darboğaz oluşturacaktır. Şu anda, grafikler arasında kopyalamanız gerekir.İki grafik, değişkenleri aralarında paylaşabilir, bu da eğitim veri dağıtımı sorununu çözer.Bu yöntem, çok makineli çoklu kart eğitimi için uygundur. Resimler arasında kopyalamak için birden fazla istemci ve resimlerin içini kopyalamak için yalnızca bir istemci vardır.

TensorFlow, yüksek seviyeli API'yi kapsüller, parametreleri otomatik olarak parametre sunucusuna dağıtır ve aritmetik işlemleri işçilere ayarlar. Bunlar, istemci programlarının yazılmasını basitleştirerek birden çok çalışan üzerinde çalışabilen bir kod uygular.

Dağıtılan optimum W nasıl bulunur? Senkronize eğitim ile asenkron eğitim arasındaki fark nedir?

Stokastik gradyan iniş yöntemi: İlk denklem, hesaplama açısından çok pahalı ve pratik olmayan kısmi türevi elde etmek için kullanılır. Türev ve analitik çözümü bulmak için genellikle analiz kullanılır.

Dağıtılmış stokastik gradyan inişi

Eşzamansız eğitim süreci: Eşzamansız eğitim, TensorFlow'daki her düğümdeki görevlerin bağımsız eğitim yöntemleri olduğu ve gradyanları parametre sunucusundaki diğer düğümlerle senkronize etmeye gerek olmadığı anlamına gelir.

Eşzamanlı eğitim süreci: Eşzamanlı eğitimin, diğer düğümlerle parametre sunucusundaki gradyanları azaltması gerekir.

Dördüncü bölüm, dağıtılmış bir eğitim modelinin nasıl yazılacağıdır, video oynatımını izleyebilirsiniz.

Aşağıdaki şekil, bağımsız bir doğrusal regresyon modelinin bir örneğidir

Beşinci bölüm Dağıtılmış eğitimin performans karşılaştırması

Değerlendirme göstergeleri genellikle model yönlerine ve platform yönlerine ayrılır. Modeller açısından yaygın olarak kullanılan göstergeler şunlardır: doğruluk, geri çağırma, AP vb. Platform yönü

Esas olarak iş hacmine ve hızlanmaya bağlıdır.

Eşzamansız eğitimin verimi eşzamanlı eğitimden daha iyidir, bu nedenle eşzamansız eğitim eşzamanlı eğitime göre daha hızlıdır.

Senkron ve asenkron algoritmaların karşılaştırılması

Yukarıdakiler bu paylaşımın ana içeriğidir.Kod uygulama bölümünde, öğrencilerin kayıttan yürütme videosunu doğrudan izlemeleri veya konuk Wu Wei'nin GitHub adresini takip etmeleri önerilir.

WeChat herkese açık hesap: "AI Araştırma Kulübü", uzun vadeli ücretsiz canlı video kursları sağlar, takip etmeye hoş geldiniz!

-

- Renminbi ile bağlantılı binlerce konu var "Devalüasyonsuz insanlar" oluşturulmuş mu? "2017 Daha İyi mi?" Outlook II | Xiaoqian Kanalı

-

- Liao Fangzhou, Tsinghua Üniversitesi: Düşman örnekleri oluşturmak ve savunmak için yeni bir yöntem | Özeti paylaş

-

- "Istakoz Dedektifi" Filmde binlerce kişi ıstakoz pia dansı yapıyor Yuan Shanshan, babası bile şekli tanıyamıyor

-

- Cao Dewangın "yüksek vergi yükü ve yüksek maliyeti" Çinin "reel ekonomisi" üzerinde gerçekten bir yük mü? Havalı düşünme