Özet | Gradyan artırıcı ağaç algoritması ilkesinin özeti

Önsöz

Bu makale, artırma ailesinin artırma ağacı algoritmasını ve gradyan artırma (GBDT) algoritmasını tanıtır. GBDT algoritması, genellikle regresyon ve sınıflandırma sorunlarını çözmek için kullanılır ve güçlü bir genelleme yeteneğine sahiptir. Bu makale, GBDT algoritmasını basit bir şekilde özetler.

içindekiler

1. Tek karar ağacı ile güçlendirilmiş ağaç algoritması arasındaki fark

3. Yükseltilmiş Ağaç Algoritması

4. GBDT algoritması

5. GBDT yaygın olarak kullanılan kayıp işlevi

6. GBDT'nin düzenlenmesi

7. GBDT ve AdaBoost arasındaki model karşılaştırması

8. Özet

Karar ağacı tek bir öğrencidir ve güçlendirme ağacı, temel öğrenci olarak CART karar ağacını kullanan bir güçlendirme yöntemidir. Bu bölüm, sonuç değerlendirme perspektifinden ikisi arasındaki farkı ve kayıp fonksiyonu perspektifini açıklamaktadır. Karar ağacının öğrenci modelinin f (x) olduğunu varsayarsak, güçlendirilmiş ağaçta K zayıf öğrenci vardır.

, Burada i = 1,2, ..., K.

1. Sonuç değerlendirme yöntemi:

Belirli bir giriş verisi için xi

Karar ağacı modelinin çıktı sonucu yi:

Yükseltilmiş ağaç modelinin çıktısı yi:

Bunlar arasında, i zayıf bir öğreneni temsil eder, T bir sınıflandırma modelini temsil eder (lojistik doğrusal regresyon veya işaret fonksiyonu gibi)

2. Model yapım yöntemi

(1) Karar ağacı modeli yapım yöntemi

Karar ağacı, modelin kayıp fonksiyonunu hesaplamak için Gini indeksini kullanır.Karar ağacı oluşturma aşaması, modelin kayıp fonksiyonunu en aza indirgemek ve karar ağacının derinliğini maksimize etmektir; karar ağacı budama aşaması, düzenlenmiş kayıp fonksiyonu kullanılarak ve son olarak çapraz doğrulama ile tamamlanır. En iyi alt ağacı seçme yöntemi;

(2) Ağaç modelini kaldırmanın yapım yöntemi

Güçlendirme ağacı, birden çok karar ağacını güçlü bir öğrenen olarak birleştiren artırıcı bir yöntemdir.Her bir karar ağacının karmaşıklığı tek bir karar ağacından çok daha düşüktür. Bu nedenle, tek bir karar ağacı gibi kayıp işlevini en aza indirmek için karar ağacının derinliğini maksimize edemez. Karar ağacı, destekleyici ailenin bir üyesidir.Zayıf öğrenci, seri ve yinelemeli olarak üretilir.Yükseltici ağaç modeli, her adımda zayıf öğrencinin kayıp işlevini en aza indirerek oluşturulur.

onların arasında,

Karar ağacını temsil eder,

Karar ağacının parametrelerini temsil eder ve M, ağaç sayısıdır.

Ağaç algoritmasını güçlendirmek:

Güçlendirilmiş ağaç algoritması, ilk yükseltilmiş ağacı varsayarak ileri dağıtım algoritmasını kullanır.

M. Adımın modeli:

onların arasında,

Önceki model için, mevcut modelin parametreleri ampirik risk minimizasyonu yoluyla belirlenir.

L kayıp fonksiyonunu temsil ettiğinde,

ile

Formül (1) 'den görülebileceği gibi bir sabittir, kayıp fonksiyonu L'yi bildiğimiz sürece, her tur için model parametrelerini alabiliriz

Mevcut modeli kullanmak olarak da anlaşılabilir

Modelin önceki turunun kalıntılarına uyması için. Bu nedenle, güçlendirilmiş ağaç algoritmasının ilkesi, mevcut kayıp fonksiyonu değerini en aza indirmek için son model kalıntılarına uyacak şekilde mevcut karar ağacını kullanmaktır.

misal Eğer bir kişi 30 yaşındaysa, ilk önce 20 yılını sığdırmak için kullanırız ve kaybın 10 yaşında olduğunu buluruz, sonra sığdırmak için 6 yıl kullanırız ve kayıp fonksiyonu gereksinimlerimizi karşılayana kadar yineleriz Bu, ağacı kaldırma fikridir.

Doğrudan uydurmak için neden sadece 30 kullanmadığımızı hiç merak ettiniz mi? Bunu yapmak için gereken adımlar, karar ağacının derinliğini en üst düzeye çıkarmakla eşdeğerdir ve ortaya çıkan model zayıf bir sınıflandırıcı değildir ve aşırı uyum sorunlarına yol açar.

Önceki bölümdeki örneği tekrar gözden geçirelim. Kaybı uydurmak için önce 10 yıl kullanırsak ve kaybın 20 yaşında olduğunu bulursak ve ardından kaybı 12 yıla sığdırmak için 8 yıl kullanırsak, yinelemeli olarak, önceki bölümle aynı kayıp işlevi değeri Daha fazla yinelemeye ihtiyaç vardır Bu, GBDT algoritmasının fikridir: Kalıntıyı kayıp fonksiyonunun negatif gradyanı ile yaklaşık olarak belirleyin ve bu turun minimum kayıp fonksiyonunu elde etmek için negatif gradyanı regresyon ağacına sığdırın. Güçlendirilmiş ağaç doğrudan kalıntılara uyduğundan, aynı kayıp işlevi değerine ulaşıldığında, güçlendirilmiş ağaç için gereken yinelemeli adımlar çok daha küçüktür.

adım:

(1) Şu şekilde ifade edilen, kayıp fonksiyonunun negatif gradyanıyla yaklaşık olarak kalıntısı:

(2) Regresyon ağacı, negatif gradyana uydurulur ve yaprak düğüm alanı Rmj, j = 1,2, ..., J elde edilir. J, yaprak düğümlerinin sayısıdır ve m, m'inci regresyon ağacıdır.

(3) Her bir yaprak düğümündeki örnekler için, takılan yaprak düğümün en iyi çıkış değerini Cmj elde etmek için minimum kayıp fonksiyonunu aşağıdaki gibi buluruz:

(4) Regresyon ağacı modelini güncelleyin:

(5) Son regresyon ağacı modelini alın:

Muhtemelen anlaşılması en zor olan, modeli negatif gradyan yönünde küçültmek olarak anlayabileceğimiz üçüncü adımdır. Negatif gradyan yönü, kayıp fonksiyonunun negatif gradyanının regresyon ağacı bölme kuralı olarak anlaşılır ve kural, kayıp fonksiyonunu en aza indirmek için kullanılır.

M yineleme sayısını temsil ettiğinde,

Toplam m yinelemeden sonra öğrenme modelini temsil eder,

Modelin kayıp fonksiyonunu temsil eder.Ağaç kaldırma prensibine göre modelin kayıp fonksiyonu iterasyon sayısı arttıkça azalır. Yukarıdaki şekilde gösterildiği gibi, gradyan ve negatif gradyan sırasıyla yeşil çizgi ve kırmızı çizgidir. Mevcut öğrenme modelini kullandığımızda

Negatif gradyan yönü boyunca artarken, kayıp fonksiyonu en hızlı şekilde düşer, bu nedenle GBDT algoritması fikri uygulanabilir.

Not: Li Hang tarafından "İstatistiksel Öğrenme Yöntemleri" nin P152'deki GBDT algoritmasının ifadesi:

Şahsen aşağıdaki model sunumunun daha iyi olabileceğini düşünüyorum:

Yukarıdaki iki bölümden, güçlendirme ağacının son kayıp tur fonksiyonuna uyması için karar ağacını kullandığı ve GBDT'nin son kayıp turunun gradyanına uyması için karar ağacını kullandığı görülebilir. Bu nedenle, modelin kayıp fonksiyonu bilindiği sürece, zayıf öğrenen modelinin her turunun parametreleri ileri dağıtım algoritması ile hesaplanabilir.Bu bölüm, GBDT'nin yaygın olarak kullanılan kayıp fonksiyonlarını özetlemektedir.

(1) Sınıflandırma algoritması

a) Üstel kayıp fonksiyonu:

Negatif gradyana karşılık gelen:

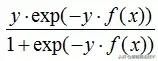

b) Günlük kaybı işlevi

(2) Regresyon algoritması

Ortalama kare hatası ve mutlak kayıp fonksiyonu gibi en sık kullanılan kayıp fonksiyonları burada tartışılmamaktadır. Bu bölüm, aykırı değerlere karşı sağlam olan Huber kaybını ve nicelik kaybını tanıtır.

onların arasında,

Düzenli hale getirme, modelin aşırı sığmasını önlemektir. GBDT'yi düzenlemenin üç ana yolu vardır:

V'nin değer aralığı: 0 < v 1. Aynı eğitim seti öğrenme etkisini elde etmek için formül (2) daha fazla yineleme gerektirir, yani modelin (2) karmaşıklığı daha küçüktür.

(2) Eğitim setini değiştirmeden örnekleme, örnekleme oranı v (0 < v 1). GBDT karar ağacına uyacak bazı örneklerin alınması varyansı azaltabilir, ancak yanlılığı artıracaktır.

(3) Her turda takılan kayıp fonksiyonunun gradyanının regresyon ağacını budayarak, budama algoritması CART budama sürecini ifade eder.

Başlatma varsayılıyor

İki formülü karşılaştırdığınızda, GBDT modelinin bir i ağırlığına sahip olmadığını göreceksiniz. Nedeni şudur: AdaBoost, bir dizi zayıf öğrenen elde etmek için orijinal veri kümesini her seferinde farklı dağılımlarla (ağırlıklarla) eğitir ve ardından son halini almak için ağırlıkları birleştirir Model: GBDT modelinin ağırlıkları yoktur çünkü zayıf öğrenci önceki turun kalıntılarına uymaktadır Regresyon ağaçlarının sayısı arttıkça, kalıntılar küçüldükçe küçülür, bu nedenle zayıf öğrencilerin ağırlıklara ihtiyacı yoktur.

Bu makale, artırıcı ailenin artırıcı ağaç algoritmasını ve GBDT algoritmasını tanıtmaktadır.Yükseltici ağaç algoritmasının her turunun zayıf öğrenicisi, önceki turun kalıntısı uydurularak üretilir ve GBDT algoritmasının her turunun zayıf öğrenicisi, önceki turun kayıp işlevine uydurur. Negatif gradyan tarafından oluşturulur. Hem güçlendirilmiş ağaç algoritması hem de GBDT algoritması zayıf bir öğrenen olarak CART regresyon ağacını kullanır.Modelin kayıp fonksiyonu belirlendiği sürece, güçlendirilmiş ağaç ve GBDT ileri dağıtım algoritması tarafından oluşturulabilir.

referans: https://www.cnblogs.com/pinard/p/6140514.html

Kaynak: makine öğrenimi algoritmalarıyla ilgili şeyler

-

- Tanrıların akvaryumu olarak bilinen güzel ada, paranın 1 / 4'üne net ünlü su evinde yaşayabilirsiniz.

-

- Askeri sanat grubumuzun performans kostümlerinin evrimi - ilk performans kostümleri Sovyet kazaklarıydı

-

- Ulusal kamu kurbanları için ilk yerel mevzuat Nanjing, Jiangsu'da doğdu! "Jing günü" davranışı cezalandırılacak