Üç günde bir AI Go ustası nasıl eğitilir? Size AlphaGo Zero'nun 3 numarasını öğretin

Orijinal Seth Weidman tarafından

Xia Yi, HackerNoon'dan Derlenen Geng'e Sordu

Qubit Üretildi | Genel Hesap QbitAI

Geçtiğimiz yıl, AI alanındaki en heyecan verici ilerleme, AlphaGo'nun sürekli ilerlemesi olabilir. AlphaGo Zero sadece yeni bir ağ mimarisi önermiyor, aynı zamanda bazı yeni sinir ağı eğitim teknikleri getiriyor.

DeepMind bir makale yayınlamasına ve Reddit forumunda halka açık bir Soru-Cevap yapmasına rağmen, bazı insanlar daha sonra AlphaGo Zero algoritmasını uyguladılar, ancak nasıl eğitilir? Hangi numaralar var?

HackerNoon'da yayınlanan yeni bir blog yazısı sezgisel bir yorum sağlar:

AlphaGo'nun her bir sürümünde aynı satırda bulunan iki yöntemle başlayalım: biri ileriye dönük Monte Carlo ağaç araması, diğeri ise yerleştirme konumunu "sezgi" temelinde değerlendirmektir, DeepMind buna strateji ağı ve değer ağı dediği şeydir. Bu iki yöntemin birleşimi, AlphaGo'nun her sürümünün özünü oluşturur.

Daha yüksek bir tartışma seviyesinden, AlphaGo Zero, AlphaGo ile aynı şekilde çalışır.Hepsi, sinir ağı rehberliği ile desteklenen MCTS'ye dayalı ileri arama kullanır. Bununla birlikte, AlphaGo Zero'nun sinir ağı veya "sezgisi", AlphaGo'nun eğitim yönteminden tamamen farklıdır.

İşte bilmeniz gereken üç numara.

İpucu 1: AlphaGo Zero nasıl eğitilir

Go oynamayı öğrenen sözde sinir ağı, mevcut durumda bir sonraki hamle için en iyi konumu belirleyebilmektir. DeepMind, cehaletten Go ustasına kadar sinir ağı ne kadar akıllı olursa olsun, MTCS kullanmanın her zaman daha iyi bir değerlendirme ve yargı planı olduğunu buldu.

Temel olarak, MCTS ileriye dönük bir araştırmadır.Eğer yeterli zaman varsa, insan Go ustaları da bunu tamamlayabilir. Bu süreç, oyunda gelecekteki değişiklikleri sürekli olarak telafi etmekten ve hangi "rutinlerin" en iyi çözüm olabileceğini değerlendirmekten başka bir şey değildir.

Örneğin. İlk yerleştirme planı sonunda bir beraberliğe yol açabilir ve değerlendirme puanı 0.0'dır. Sonra ikinci şemaya bakın Sinir ağı bu şekilde kazanabileceğini hesaplar ve değerlendirme puanı 0.5.

Bu süreç devam ederse, ileriye doğru arama her zaman daha iyi bir çözümü değerlendirebilecektir.

Elbette bu, sinir ağının zafer getirmek için satranç taşlarının nasıl oynanacağını belirleyebilmesini de gerektirir. Ajan, MCTS'nin iyileştirilmiş değerlendirmesine ve sinir ağının mevcut durumuna dayanarak, sürekli olarak kendi oyununu başlatır.

DeepMind'ın AlphaGo Zero'yu eğitmek için kullandığı verilerin tamamı ileri arama ve kendi kendine oyun yoluyla oluşturulur.

Aslında insan satrancı verilerini kullanmadan yapılan bir hile. Bu şekilde, verilen her pozisyon için sinir ağı, MCTS'ye dayalı ileri arama gerçekleştirebilir ve ardından bunu temsilcinin satranç gücünü geliştirmek için kullanabilir.

Bu yöntemin yardımıyla, AlphaGo Zero cehaletten bir Go ustasına dönüştü.

Trick 2: İki başlı canavar

AlphaGo Zero'nun sinir ağı "çift kafalı" bir mimaridir.

Bu ağın ilk 20 katmanı, ortak sinir ağı yapılarıdır. Sonra iki "kafa" vardır: Bir kafa ilk 20 katmanın çıktısını alır ve bir sonraki hareket olasılığını üretir, diğer kafa aynı verilere dayanarak mevcut durumun kazanma olasılığını verir.

Bu alışılmadık bir yapıdır. Neredeyse tüm uygulamalarda, sinir ağı yalnızca sabit bir çıktı verir. İki farklı çıktı sonucu varsa, nasıl öğrenmeliyiz?

Cevap basit. Lütfen sinir ağlarının özünün, karar vermeyi etkileyen bir dizi parametre de dahil olmak üzere bazı matematiksel işlevler olduğunu unutmayın. Sözde eğitim, sinir ağına doğru cevabı defalarca göstermek, ağın parametreleri güncellemesine izin vermek ve çıktıyı doğru cevaba yaklaştırmaktır.

Bu yüzden, tahmin yapmak için bir kafa kullandığımızda, sadece "gövde" ve "kafa 1" deki parametreleri güncellememiz gerekir. Başka bir kafa kullanırken, "Gövde" ve "Kafa 2" içindeki parametreleri güncelleyin.

DeepMind tek, iki başlı bir sinir ağını bu şekilde eğitiyor ve bunu MCTS aramalarına rehberlik etmek için kullanıyor. AlphaGo'nun iki ayrı sinir ağı kullanması gibi biraz. Bu numara teknik olarak Sert Parametre Paylaşımı ile Çok Görevli Öğrenme (Sabit Parametre Paylaşımı ile Çoklu Görev Öğrenimi) olarak adlandırılır.

3. Numara: Kalan ağ

AlphaGo Zero ayrıca önceki sürümden daha modern bir sinir ağı mimarisi kullanır: artık ağ.

Kalan ağ, AlphaGo'nun ilk sürümü üzerindeki çalışmaların tamamlanmaya yaklaştığı 2015 yılında Microsoft Research Asia'da Sun Jian liderliğindeki bir ekip tarafından geliştirildi.

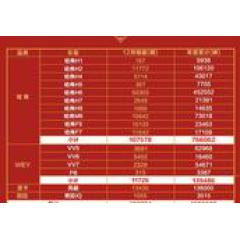

Artık ağ ve sıradan evrişimli sinir ağının karşılaştırılması

Evrişimli mimariyi artık ağ mimarisiyle değiştiren ve her bir sinir ağını "İki Başlı Canavar" sinir ağıyla değiştiren bu iki sinir ağı ile ilgili teknik, tüm ağın performansını ikiye katlayabilir. , Performans geliştirildi. Aşağıda gösterildiği gibi:

özet

Yukarıdaki üç numara, AlphaGo Zero'nun inanılmaz yetenekler sergilemesini sağlar.

AlphaGo'nun herhangi bir klasik veya en son takviye öğrenme konseptini kullanmadığını, Deep Q Learning olmadığını ve Asenkron Aktör-Eleştirmen Temsilcilerinin olmadığını belirtmek gerekir.

DeepMind, sinir ağı için veri üretmek için sadece bir simülasyon yöntemi kullanır ve ardından denetimli bir şekilde öğrenir.

Denny Britz bir keresinde şu sonuca varmıştı: İroni şudur ki, son birkaç yılda pekiştirmeli öğrenmedeki ana gelişmeler pekiştirmeli öğrenmeyi daha az pekiştirmeli öğrenmeye benzemekte, daha çok denetimli öğrenmeye benzemektedir.

El ele eğitim AlphaGo Zero

1. Sinir ağını başlatın

2. Sinir ağının kendi kendine oynamaya başlamasına izin verin ve her adım için yaklaşık 0,4 saniye süren 1600 MCTS simülasyonu gerçekleştirin

3. Oyun sayısı arttıkça, son 500.000 oyundan 2048 yerleştirme kararları ve buna karşılık gelen oyunların kazanç ve kayıpları örneklenir.

4. Sinir ağını birlikte eğitmek için MCTS'nin ileriye dönük araştırmasıyla oluşturulan pozisyon değerlendirmesini ve kazanma ve kaybetme sonuçlarını kullanın.

5. 3. ve 4. adımlar, mevcut sinir ağını ve daha önceki en iyi sürümü değerlendirmek için her 1000 yinelemede gerçekleştirilir. Yeni sürümün kazanma oranı% 55'e ulaşırsa, önceki sürümü kullanmak yerine yeni oyunlar oluşturmak için kullanmaya başlayın.

3 veya 4 adımı 700.000 kez tekrarlayın ve oyunda durmayın.Üç gün sonra, bir AlphaGo Zero da eğitebilirsiniz.

AI'nın geleceği için çıkarımlar

DeepMind'ın başarıları, yapay zeka araştırmalarının geleceği için pek çok aydınlanmaya sahip. Aşağıdakiler kilit noktalar:

ilk , Simülasyon tarafından oluşturulan kendi kendine oyun verileri, sinir ağı eğitimi için yeterince iyidir. Bu kanıtlıyor Simüle edilmiş kendi kendine eşleştirme verileri, yapay zeka temsilcilerini son derece karmaşık görevleri tamamlayarak insan performansını aşacak şekilde eğitebilir , İnsan uzmanların sağladığı veriler olmadan tamamen 0'dan başlayabilir.

İkincisi, temsilcinin birden çok alanda ilgili birkaç görevi gerçekleştirmeyi öğrenmesi için, "çift başlı" bir numara büyük bir yardım sağlayabilir. Bu, temsilcinin davranışının herhangi bir tek göreve aşırı uymasını engelliyor gibi görünüyor. DeepMind bu hileyi çok seviyor gibi görünüyor ve gelişmiş sürümünü birden çok farklı alanda birden çok görevi öğrenebilen bir aracı oluşturmak için kullanıyor.

DeepMind'in yapay zekası, labirentte yürümeyi öğrenmek için çok görevli bir takviye öğrenme çerçevesi kullanıyor

Pek çok robotik projesinde, özellikle simülasyon ortamında görevleri tamamlamak için uzuvları kullanmak üzere robotların eğitimi alanında, bu iki teknik iyi sonuçlar elde etti. Pieter Abbeel'in NIPS hakkındaki son konuşması birçok etkileyici yeni sonuç gösterdi, bu sonuçlar pek çok modern takviye öğrenme tekniğinin yanı sıra bu püf noktaları kullanıyor.

Aslında, robotun hareketi "çift başlı" için mükemmel bir kullanım senaryosudur.Örneğin, bir robota beyzbol oynamayı öğretmek için aslında iki tür hareket vardır, biri sopayı tutup sallamak, diğeri ise bir harekete vurmaktır. Nesneler. "Çift kafa" ile, iki hareketin eğitimi aynı anda tamamlanabilir, çünkü ikisi denge, dönme ve benzeri gibi bazı ortak becerileri içerir.

DeepMind, AlphaGo Zero eğitimi tekniğini robot hareketine uygular

- Bitiş -

Samimi işe alım

Qubit, editörleri / muhabirleri işe alıyor ve merkezi Pekin, Zhongguancun'da bulunuyor. Yetenekli ve hevesli öğrencilerin bize katılmasını dört gözle bekliyoruz! Ayrıntılar için, lütfen QbitAI diyalog arayüzünde "işe alım" kelimesiyle yanıt verin.

Qubit QbitAI · Toutiao İmzalama Yazarı

' ' Yapay zeka teknolojisi ve ürünlerindeki yeni eğilimleri takip edin

-

- Ofis siyasetini anlamakta zorluk mu yaşıyorsunuz? Otizmli insanlar için özel olarak tasarlanmış duygusal robotlar var

-

- Muhabir: Başarısızlık güveni etkiler mi? Kashuai: Ulusal futbolu birkaç günden kısa sürede değiştirin, Lippi listeyi okudu

-

- Great Wall Motors, arka arkaya üç yıl boyunca bir milyon satışı aştı. SUV'lar ve pikaplar hiç şüphesiz

-

- Şampiyonlar Ligi hakkında rastgele konuşma: Dortmund'un kaybı, Barcelona tarafından çalınan manşetler

-

- Bu Koreli Dragonsın 41 maçlık mağlubiyet serisinin büyüsünü kırabilir mi? Yeni koçun geçmişi gerçekten büyük!

-

- "Thai Messi" boğazını bir kılıçla mühürledi! Teknik direktör utanıyor, Taylandlı teknik direktör milli futbolu kaybetmenin gerçek nedenini belirtti.