İnovasyon Atölyesi'nden Wang Jiaping: Düşük seviyeli bilgisayar görüşü

Yan Meng bitirme düzenlemesi

Qubit Üretildi | Genel Hesap QbitAI

Son zamanlarda, DeeCamp İnovasyon Atölyesi'nin derin öğrenme eğitim kampı sırasında, AI Mühendislik İnovasyon Enstitüsü'nün dekan yardımcısı Wang Jiaping, "düşük seviyeli bilgisayar görüşü" üzerine bir konferans verdi.

Qubit, kursun tüm içeriğini şu şekilde düzenler:

Bugün sizinle düşük seviyeli bilgisayar görüşü hakkında konuşmak istiyorum.

Bu çağda, üst düzey görme büyük ilerleme kaydetti ve yüz tanıma ve otonom sürüş gibi alanlarda giderek daha fazla bahsedildi.

Öyleyse neden düşük düzey görme hakkında konuşmalıyım? Üst düzey görme görevinde, makine öğreniminin çok güçlü olduğunu biliyoruz, bazı veriler ve yeterli bilgi verildiği sürece onu öğrenebilir. Ancak verilerin nasıl geldiği ve verinin kendisinin ne tür sorunları olduğu konusunda daha fazla endişelenmemiz gerekiyor. Bunların hepsi düşük seviyeli görme ile ilgilidir. Düşük seviyeli görmeyi anlarsanız, üst düzey görme yaparken çok yardımcı olacaktır.

Bir örnek vereyim.

Uzun zaman önce OCR yaparken, görüntüdeki görüntüyü tanımamız gerekiyordu ve makine öğrenimi göreviyle elde edilen veriler sınırsız değildi, sadece bir kısmı kaplandı, bu da OCR gibi bazı istenmeyen veri değişiklikleri anlamına geliyor Aydınlatma değişiklikleri, kademeli değişiklikler ve ekrandaki bazı çarpıklıkların belirli kelimeyle hiçbir ilgisi yoktur.

Ancak bu değişiklikleri kaldırmazsanız, bunları makine öğrenimi modeline atmanız yeterlidir.Eğer yeterli veri varsa, model bu ilgisiz değişiklikleri ilgili değişikliklerden elbette ayırabilir, ancak aslında çok fazla veri yoktur. Düşük seviyeli görmeyi öğrenirseniz, bu varyasyonları önceden kaldırıp kaldıramayacağınızı ve bunları makine öğrenimine gönderip gönderemeyeceğinizi düşünebilirsiniz; bu, sonraki makine öğrenimini daha verimli hale getirir ve daha az veriye dayanır.

CV, sinyal toplama, işleme ve analizden son anlayışa kadar birçok yönü içerir ve makine öğrenimi, optik, bilgisayar grafikleri gibi birçok konuyla ilgilidir ve gerçek dünyayı anlamamızla ilgilidir, ancak sensörlerin sınırlamaları nedeniyle, biz Bu anlayış, üç boyutlu verileri tamamlamaktan ziyade genellikle iki boyutlu veya tek boyutlu projeksiyonlardan gelir.

Dolayısıyla bu mesele temelde tüm CV için, özellikle de 3D CV için en büyük zorluktur.

Öncelikle CV için bilgisayar ne görüyor?

Bu resim için üç boyutlu uzayın izdüşümü olmasına rağmen, üç boyutlu uzayın kendisi değildir, sadece bir tarafını görüyoruz. Birçok nesne engellenir ve pek çok bilgi kaybolur.

Bir görüntü için, her yönde alınan fotonların akışını ölçtük ve ayrıklaştırdık ve birçok değer içeren bir veri seti elde ettik. Her değer, sensör üzerindeki küçük bir alan tarafından alınan birim zaman başına ışık akısını temsil eder. Işık yoğunluğu ne kadar büyükse, değer o kadar büyüktür. Bu, bilgisayarın gördüğü görüntüdür.

Önce bir pikseldeki değerin nasıl geldiğinden bahsedelim. Kanal başına parlaklık veya parlaklık olabileceğinden bahsedilmelidir. Artık 3 kanal olan RGB'yi görüyoruz.

Kanal rengi temsil eder. Ve rengin birimi yoktur, çünkü renk fiziksel bir nicelik değildir, öznel bir niceliktir. Esasen, göz farklı bir spektrum gördüğünde sensörümüzün fotoreseptörde heyecanlandığı miktardır. Arkadaki gerçek fiziksel nicelik, spektrumdur, yani farklıdır. Enerjinin frekans bandı üzerindeki dağılımı.

İnsanların renkleri algılamasının nedeni, insan görsel sisteminin alınan spektrumu entegre etmek için bu üç ürün işlevini kullanması ve son olarak üç fotoreseptör hücresi tarafından elde edilen katsayıları oluşturması ve daha sonra RGB renk uzayıyla eşleştirilmesidir.

Renk öznel olduğu için farklı canlılar farklıdır.Bu, tüm ekosistemdeki canlıların konumu ile ilgilidir ve biyolojik evrimden kaynaklanır.

Renk mutlak değil.

Işık kaynağını doğrudan gözlemlemenin yanı sıra, çoğu renk, ışık kaynağının rengi ile nesnenin yüzeyinden yansıyan katsayı çarpılarak elde edilen renklerdir ve nihayetinde üst üste binen yansıma katsayısının rengi ile görülür. Bu, gördüğümüz şeyin nesnenin gerçek yansıma spektrumunun dağılımı değil, ışık kaynağı ile etkileşiminin sonucu olduğu anlamına gelir. Yani gerçekte farklı nesnelerin yansımaları çok farklıdır.

Çeşitli yansıma özelliklerini tanımlayan fiziksel nicelik BRDF olarak adlandırılır.

Birincisi, yansıma katsayısı, yüzeye ne kadar ışık yoğunluğu ulaştığı ve ne kadar ışık yoğunluğunun yansıtıldığı ve bu ışık yoğunluğu geliş açısı ve çıkış açısı ile ilişkilidir, küresel bir açıya girer ve küresel bir yüzeyden çıkar. Açı, dolayısıyla toplamda dört boyutlu bir fonksiyondur.

Bu grafik konusunda çok ağır bir çalışmadır. Bilgisayardaki gerçek dünyadaki nesnelerin görünümünü yeniden üretmek istediğimiz için, bu işlev nesnenin görünümünün neye benzediğini belirler. Eşleştirme yapıyoruz, stereo yapıyoruz, nesnelere farklı açılardan bakıyoruz ve karşılık gelen noktaları bulmaya çalışıyoruz.

Buradaki zorluk, bu fonksiyonun sabit olduğunu varsaymaktır; bu, bu belirli nokta için rengin, açıdan bakılmaksızın aynı olduğu anlamına gelir. Gerçek dünyada durum böyle değil.

Gerçek dünyada, bu BRDF sabit değildir. Renklere aynı noktada farklı bakış açılarından baksanız bile farklıdırlar.

İlk görüşte, sözde bir lambertian yüzey varsayıldı.

Yansıma, nesnenin pürüzlü yüzeyinden kaynaklanır ve ışık, çarptıktan sonra farklı yönlere yansır ve farklı yönlere yansır. Işık yoğunluğunun tüm yönlerdeki yansımasının tekdüze olduğunu varsayarsak, buna dağınık yansıma denir.

Tebeşir ve alçı buna çok yakındır. Yaygın yansıma ne anlama geliyor? İlk yıllarda stereo algoritması, farklı açılardan bakıldığında belirli bir noktanın aynı olduğunu varsayıyordu.Üç boyutlu uzaydaki konumunu anlamak için resimdeki özellik noktalarını farklı açılardan ona karşılık gelecek şekilde kullanabiliriz. Ancak asıl sorun speküler yansımadır.

Işık kaynağı, genellikle biraz daha ayna yönünde eşit olmayan bir şekilde yansır ve ardından ayna ışık kaynağı boyunca dağılmış bir speküler tepe oluşturur.

Bu aynasal tepe ince ise çok parlak bir nokta oluşturacaktır. En uç durumda, bir çarpma fonksiyonu olabilir, bu zamanda nesne bir aynaya benziyor. Bazen mat malzemeler gibi daha geniş olacaktır.

Bu çok fazla zorluk getirecek. Çoklu görünümde renk değişeceğinden, özellikle speküler çok güçlü olduğunda, stereo ve eşleştirme yapmayı zorlaştıracak ve birçok algoritma etkilenecektir.

Bu basit bir dermabrazyon algoritmasıdır. Yaklaşık üç veya dört satır kod elde edilebilir.

Mikrodermabrazyon algoritmasının etkisi hakkında ne düşünüyorsunuz? Yüzdeki kırışıklıklar giderilirken kaşların ve kılların kalıp kalmamasına bağlıdır. Mikrodermabrazyon algoritması esasen uzaydaki bazı ayrıntıları ortadan kaldırır, ancak bilgisayarlar için çizgileri, kırışıklıkları veya saçları ayırt etmek zordur.

Buradaki iki resimde, sol resimde görülen parlaklık değişiminin G ve B'si kaldırılmış ve parlaklık değişimini oluşturmak için sadece R kullanılmıştır. Elbette sadece parlaklık değiştirilerek rengi geride bırakır. Diğeri G.

Farklı ışık dalga boyları ciltte farklı dağıldığından, güçlü kırmızı saçılmalar cildin kırışıklıklarını bulanıklaştıracak ancak saçlar etkilenmeyecektir. Yeşil temelde çok fazla bulanıklık yapmadı ve ciltte her türlü kaba şey bıraktı.

Nikon fotoğraf makinelerinin portre çekmeye uygun olduğu söyleniyor, sebebi nedir? İnsan yapısı görüntüsünün üç ana renkten oluşan üç eğrisi vardır. İnsan görüşüne yaklaşmak için kamera, insanların görebileceği son görüntüyü oluşturur.Ayrıca üç benzer eğri vardır.RGB sistemi Nikon'un sensöründe yapıldığında, bileşen sistemi daha az yeşil ve mavi bileşen içerir. Sistem, yüksek boyutlu bileşenleri üç boyuta yansıttığında, arkasındaki ışık yolu farklıdır, ancak projeksiyondan sonraki renk aynıdır. Canon, daha yüksek enerji spektrumuna sahiptir. Bu nedenle Nikon portre çekerken kırmızı kanaldan daha fazla ayrıntı gelir, böylece cilt güzel görünür. Elbette bu fark çok büyük değil.

Spektrum hakkında konuştuktan sonra, şimdi her şeyin tek bir kanalda gerçekleştiğini varsayıyoruz.

Mevcut sensörlerin çoğu için, ışık geldikten sonra bir dizi işlemden geçer ve sonunda görüntüdeki pikselin değeri haline gelir.Burada birkaç adım vardır.

Bir mercekten geçtikten ve işlemden sonra bir pozlama var. Sensör gerçekten bir anlık görüntü almadığından, ışık yoğunluğunu ölçmek için aslında bir entegrasyon süresi gerekir. Daha sonra mod dönüştürücü aracılığıyla, ışık akısı analog miktarı bir veri miktarına dönüştürülür. Son olarak, bazı sonradan işlemler var.

Mümkün olduğunca çok detayı görebilmek için, aydınlık ve karanlık kısımlarda bir kısım olması gerekir. Ancak son görüntünün bazı kısımlarının doygun olduğunu ve net bir şekilde görülemediğini gördük.

Öyleyse vizyonun edinim sistemindeki çukurlar nelerdir?

Öncelikle, mercekten geçerken bazı ışık dalga boyları filtrelenecektir, çünkü çoğu sistem görmeyi anlamak için değil, fotoğraf çekmek için tasarlanmıştır. Daha iyi bir görüntü kalitesi elde etmek için, resim oluşturmak için yararlı olmayan bazı ışıklar filtrelenecektir. Mor ışık genellikle yansıtılır.

Bu, lense daha fazla ışığın girmesine izin veren ve fotoğraf kalitesini artırabilen genişletilmiş bir filmdir.

Çoğu CCD ve kamera aslında kızılötesi ışığa çok duyarlıdır Cep telefonuna uzaktan kumanda ile bakabiliriz ve çok parlaktır, bu nedenle neredeyse tüm lensler kızılötesi ışığı filtreleyecektir. Filtrelenmemişse neredeyse beyaz olacaktır.

Bu kısım, görmek istemediğimiz ultraviyole ve kızılötesini gidermek için bir filtre maskesi yaptı. Kalan görünür ışık mercekten geçer.

Ardından maruz kalma gelir.

Son olarak, sensör üzerinde okunan veriler, ışık akısı ile çarpılan pozlama süresine eşittir. Sensörün hassasiyeti sınırlı olduğundan, ışık girişi miktarı az olduğunda bir fotoğraf çekmek için nispeten uzun bir pozlama süresi gerekir, bu nedenle tam bir görüntü çerçevesi elde etmek için kare hızı, pozlama süresinin bir bölümünü aşmamalıdır.

Otomatik görüntü elde etme modülü, pozlama süresini artırır Pozlama süresi, kare hızının bir kısmına yükseltildiğinde, kare hızı düşer.

Buradaki ilk sorun kepenk.

Helikopterin pervanesinin burada düz olmadığını görebilirsiniz. Çünkü görüntülediğimizde görüntü üzerindeki pikseller aynı anda elde edilmiyor, üst piksel 0.0001 saniye, ikinci sıra 0.0002 saniye olabilir. Görüntünün tamamı taranarak elde edilir ve nesne yeterince hızlı hareket ettiğinde farklı satırlardan elde edilen bilgiler tutarsızdır, ancak tarama işlemi süreklidir, bu nedenle son görüntü böyle sürekli bir distorsiyon haline gelir.

İkincisi, hareket bulanıklığıdır.

Ayrıca hareketli nesneleri de çekin. Farklı piksellerden giren ışık miktarını ölçmek için bir entegrasyon süresi gereklidir. Bu kısa süre içinde çok sayıda anlık görüntü varsa, bunları bir araya topluyoruz. Nesne yeterince hızlı hareket ederse, 10 milisaniye bile görüntüde büyük bir fark yaratabilir. Maruz kalma anında, nesne zaten belirli bir mesafe katetmiştir, dolayısıyla nihai sonuç integraldir. Örneğin, sokak işaretlerini tanımlamak için, hareket bulanıklığı bunun için çok elverişsizdir.

Bu iki sorunu azaltmak için en iyi yol, pozlama süresini azaltmaktır, bu da görüntüleme işlemi sırasında daha az foton geleceği anlamına gelir. Sensörün hassasiyetinin değişmediğini varsayın. Farklı iso üzerinde farklı fotoğraflar çekildi.

Görüntüleme katsayısı önceki bölümde hesaplandığından, herhangi bir niceleme problemi söz konusu değildir. ISO ayarını yapmadan pozlamayı azaltırsanız, görüntü koyulaşacaktır. Pozlama süresi çok küçük olduğunda ve sensör katsayısı keskin bir şekilde ayarlandığında parazit görünecektir. Çünkü sensör doğal olarak termal gürültüye sahiptir. Yani maruz kalma süresi bir çelişkidir, eğer çok büyükse bulanıklaşır ve çok küçük olursa gürültüye neden olur.

CCD hakkında konuşalım, sensörde iki şey olacak.

Birincisi doygunluk. Işık doğrusaldır.Karanlık kısmı yakalamak için parlak kısım kesilir. Bu, parlaklık aralığını belirleyebileceğimiz, fazlalığı kesebileceğimiz ve ardından onu ölçebileceğimiz anlamına gelir.

Burada birkaç soru olacak.

Karanlık kısımların detaylarını almak için parlak kısımların detaylarını kaybedeceğiz. Vurguların ayrıntılarını korumak istiyorsanız, resmin tamamını doygun hale getirmemelisiniz. Parlaklık 10.000 kata bölünür ve en parlak olan kuantizasyon alanına sığabilir, ancak karanlık kısımların ayrıntıları kaybolmuştur.

Özünde, görüntü niceleme doğruluğu yeterli değildir ve çok fazla niceleme noktası yoktur. Kantifikasyon aralığını yapay olarak seçeceğiz. Ya parlaklık detayları ya da karanlık kısımlar kaldı. Doğrusal nicemlemede, bazen niceleme doğruluğu yeterli değildir, örneğin, gif görüntülerinin niceleme seviyesi genellikle yeterli değildir. Bazen geçiş yapabiliriz.

Bunların hepsi sensörlerimizin ve işleme devrelerimizin sınırlamalarından kaynaklanmaktadır. Genel görüntü 8 bittir. Bazı insanlar ham almak ister, bu da CCD'den ham şeyler elde etmek demektir. Bazı CCD'lerde ham, 10 bitlik veya 12 bitlik bir değişkendir, bu nedenle niceleme daha iyidir.

Son olarak, mod dönüştürücüde son değişikliği yapın.

Yukarıdakilerin tümü doğrusal değişikliklerdir. Bu adım, beyaz dengesi, renk düzeltme ve gama düzeltmesi gibi doğrusal olmayan bir değişikliktir.

Buradaki gama genellikle 1.2 veya 1.5 değeridir ve insan gözünün ışık yoğunluğuna tepkisine yaklaşabilir: insan gözünün tepkisi doğrusal değildir, bu da karanlık kısmın niceleme doğruluğunun parlak kısımdan daha yüksek olduğu anlamına gelir.

Cep telefonları veya SLR'ler ile elde edilen çoğu görüntüde doğrusal olmama durumu ne anlama geliyor?

Örneğin yüz tanıma yapmak istiyorsak aydınlatmayı kaldırmamız veya normalleştirmemiz gerekir. Piksel değerinin doğrusal olduğunu varsayın. Aslında değil, hepsi işlendi. Gerçekten normalleştirmek için, önce yoğunluk kurtarması yapın ve farklı parlaklıkta fotoğraflar çekerek bu işlevi tersine çevirin.

Monoton bir fonksiyon olduğu için, orijinal doğrusal uzay değeri ters olarak hesaplanabilir. Katı yöntem, radyometrik kalibrasyon adı verilen değeri doğrusallaştırmaktır. Bu, birçok görme görevinin ilk adımıdır, ancak çoğu göz ardı edilir.

Bu, elde ettiğimiz pikselin doğrusallaştırmadan sonraki değer olmasını sağlamak içindir. Doğrusal bir dönüşüm yaparsanız ve parlaklığı yıldan yıla arttırırsanız, elde ettiğiniz değer 2: 1 olmaz. Doğrusallaştırmadan sonra, oran tutarlı olabilir ve aydınlatma koşullarının neden olduğu varyasyon doğru bir şekilde kaldırılabilir.

Bu süreçte çok fazla bilgi kaybedebiliriz. Özellikle bir sahne doygun hale geldiğinde, farklı piksellerin değerleri aynıdır.

Bunu iyileştirmek için, ışık sensöre girmeden önce sahneyi yeniden yapılandırmak için nihayet sensörden elde edilen görüntüyü kullanan HDR adı verilen bir şey var. HDR aslında yüksek dinamik aralıklı bir görüntüdür ve maksimum değer ile minimum değer arasında büyük bir boşluk vardır.

Yeniden yapılandırma prensibi, fotoğraf çekerken yalnızca ayarlanan parlaklık aralığının bırakılması ve yalnızca bu bölümün nicelendirilmesidir. Ardından, bu sırayla her bir parlaklık aralığının ayrıntılarını elde etmek için pozlamayı değiştirmeye devam ediyoruz ve ardından görüntüleri bir araya yığıyoruz. Pozlama sırasında konumun değişmediğini varsayarsak, her piksel hizalanabilir.

Doygun olmayan tüm pikselleri seçeriz ve bir ortalama yaparız - bu önce doğrusallaştırmadan sonra değer üzerinde yapılmalıdır ve orijinal değer doğrusallaştırılır - üst üste geldikten sonra HDR görüntüsü elde edilir.Her kanaldaki değer Bir kayan nokta numarası, böylece büyük bir dinamik aralık ifade edilebilir.

Bununla birlikte, vizyonumuz tek başına değil, birçok piksele bakmak zorunda. Bu piksellerin sabit bir yapısı ve modeli vardır ve birçok görüntü görevinde yerel özellikler kullanılır.

Vision, görüntüdeki nesnenin parçasını temsil eder.Nesnenin özelliğini anlamasa da, özelliği kavramaya çalışır.Bu, görüntünün nerede olursa olsun, nesnenin konumu ve yönelimi ne olursa olsun tutarlı bir lokalizasyona sahip olduğu anlamına gelir, bu özel özellik Noktalar nesneyi takip eder.

Özelliği bulduktan sonra, slam veya stereo için çok kullanışlı olan özelliği kodlamaya gidin.

Kenar algılamaya dönüyoruz. Kenar algılama, görüntüde daha önemli süreksiz sınırlar bulmaktır.

Bir boyutta, görüntüde bazı küçük dalgalar elde etmek için Gauss işlevinin ikinci dereceden evrişimini kullanan bu küçük dalgalar, yerelleştirme özelliği olan görüntüyü takip edecektir. Bununla birlikte, bir model için, onu tanımlamak için iki sınır kullanılmalıdır. Sadece özelliğin konumunu değil, boyutunu da bilmemiz gerekiyor.

Bu fonksiyonun integral sinyali ve evrişim toplamı istediğim şey değil. Sinyalin boyutu, evrişim toplamının çekirdek boyutuyla aynı olduğunda, istediğimiz bir yerel minimum elde edebiliriz.

Bu nokta bize özelliğin yerini ve boyutunu söyleyebilir. Aslında, farklı boyutlardaki çeşitli çekirdekleri ters çevirerek, onu iki boyuta genişletiriz, yani tek boyutlu fonksiyon eksen boyunca döner.

İki boyutlu fonksiyonun kendisi Gauss toplamının ikinci türevidir. Bu işlev, farklı genişlikler arasında farklı değerler alabilir, böylece farklı katmanlar birbiriyle karşılaştırılır ve her yerde yerel minimum değerleri bulur. Son verilerde, her dairenin merkezi özelliğin nerede olduğunu ve her dairenin boyutu özelliğin ne kadar büyük olduğunu gösterir.

En önemli şey, bu görüntüyü hareket ettirir, uzaklaştırır ve döndürürsem, bu özellik noktaları takip edecek. Birden fazla kıvrılmış görüntü var. Bu özellik noktaları farklı katmanlarda bulunur. Yani minimal aramak x, y'ye bakmak değil, x, y, z'ye bakmak ve sonra projeksiyon yapmaktır.

Dolayısıyla, bu konumları iyi kavradığımızda, önce özelliğin konumunu belirlemeliyiz.Özellik noktasının konumu belirlendiğinde, bunun aynı işlevden geldiğini doğrulamalıyız, yani bir ölçek ölçümüz olmalı, sadece bir özellik noktasını bilmemeliyiz İçeriğin ne olduğunu da bilmemiz gerekiyor.

Algoritmaya göre özelliği bulduktan sonra, özelliğin içeriğini temsil etmek ve ölçeklemenin etkisine direnmek için bir vektör kullanılır. Bu özellikteki nesnenin mesafesinin değeri benzerdir. X, y'nin hareketi normalleştirildi. Z ekseni de normalleştirilmiştir.

Bu büyük miktar, 3B rekonstrüksiyonda kullanılır. Temel fikir, çizgi yönünü yazmak, gradyanı hesaplamak, içeriği tanımlamak için yönü kullanmak ve ardından açıklamak için 8 bit kullanmaktır. Kameranın görüntüleri farklı pozisyonlarda çekildiği için hızlı hareket olmazsa üst üste binmeler olur ancak çekildiklerinde hareket ettikleri için üst üste bindirilemez ve görüntüler arasındaki ilişkinin tek tek çözülmesi gerekir. Ve bir araya getirin.

Özellik noktasını yakaladıktan sonra, karşılık gelen noktayı arayın. Yazışmalarda birçok hata olabilir. Çözüm, karşılık gelen tüm ilişkileri yukarıdaki büyük denklemle birleştirmektir. Her noktada bir dönüşüm yapın. Bu değişiklik 3x3 bir matristir. 9'dan fazla denklem olduğu sürece matris çözülebilir.

Hatalı yazışma doğrusal sisteme dahil edilemez, aksi takdirde sonuç önyargılı olacaktır.Doğru yazışmanın hatadan çok daha büyük olduğunu varsayarsak, sadece birkaç karşılık bul. Çoğunlukla doğru ancak önyargılı olan t'yi çözün. Dönüşümle tutarlı olup olmadığı, karşılık gelen ilişkinin ters doğrulanması ve çok tutarsız olması halinde atılması.

Çekim yaparken aydınlatma parametreleri biraz farklı, detaylar aynı ve mutlak parlaklık biraz farklı. Bu artık bir vizyon meselesi değil, bir grafik sorunu. Bir Poisson görüntü yöntemi var, gradyan solda ve mutlak parlaklık kayboluyor. Noktalar arasındaki göreceli gradyan ilişkisi, Poisson denklemini çözmek için bağlanır ve görüntü çözülür. Çözüm tamamlandıktan sonra sınır ortadan kalkacaktır.

Mutlak parlaklığı terk edin, yeniden oluşturmak için gradyan parlaklığını kullanın.

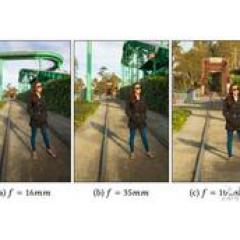

Peki, üç boyutlu uzayda izdüşüm nasıl gerçekleşir ve görüntü nasıl ortaya çıkar?

Gerçekte, her nesne her yöne ışık yayar ve bir film veya sensör üzerindeki her noktanın ışık yoğunluğu, hedef nesnenin tüm noktalarının ışık yoğunluğundan gelir. Görüntüleme için, sensör üzerindeki ışık nesnenin belirli bir noktasından gelir.

Odağı gerçek dünyaya çevirmek için küçük deliği bulabileceğiniz tek nokta olan diyafram açıklığında küçük bir delik bırakabilirsiniz. Bu, iğne deliği görüntüleme ve en klasik iğne deliği kamera modelidir.

Görüntülemenin nedeni, bu noktanın içeriğinin hedef nesnenin olabildiğince az noktasından gelmesini sağlamaktır.Delik ne kadar küçükse, ışık konisi o kadar küçük olur ve nokta, alıcı yüzeyde yalnızca küçük bir noktaya katkıda bulunur. Birden az piksel çok net bir görüntü olabilir.

Ancak delik küçük olduğunda, sensör üzerinde çok az ışık akışı olur ve görüntü karanlık olur. Teorik olarak, maruz kalma süresini süresiz olarak artırmak ve sürekli entegre etmek mümkündür, ancak bu pratik değildir.

Işığın yönünü değiştirebilir ve tek bir yerde toplarsanız, görüntü net olacak ve çok karanlık olmayacaktır. Bu yüzden insanlar, bir odak oluşturmak için noktayı optik eksenden uzaklaştırmak için lensi icat etti. Nesne mesafesi ve odak uzaklığı sabitlendiğinde, görüntü sabitlenir.

Ancak sensör düzdür ve yalnızca tek bir yöndeki pikselleri yakalayabilir. Gerçek nesne üç boyutludur ve bazı noktalar farklı optimal görüntüleme pozisyonlarına sahiptir. Bazı noktalar tam olarak sensöre düşecektir. Bu alan derinliğidir.

Görüntüleme alan derinliği içinde olduğu sürece daha nettir. Diğer noktaların bulanık olması gerekir, bir pikselden daha küçük oldukları sürece hala nettirler. Bazen uzaklık farkı nedeniyle gerçek odak biraz farklı olabilir, örneğin 0.1 mm.Görüntüdeki bulanıklığın boyutu diyafram açıklığı ile belirlenir.

Diyafram açıklığı küçük, bulanıklığın yarıçapı daha küçük olacak ve ön ve arka net olacak, ancak ışık miktarı az olacak. Diyafram büyük, lens büyük. Kameranın büyük olacağı anlamına gelir. Sensör geniştir, birim alanı geniştir ve daha fazla foton alır. Odak uzaklığı daha kısaysa, açılma açısı daha büyüktür, tıpkı gözetleme için geniş açılı bir kamera gibi, genellikle insanlar bu etkiyi istemez.

Daha geniş bir görüş açısı, radyal distorsiyona neden olacaktır. Radyal bozulmalardan biri lensin kusurlu olmasından, diğeri ise görüş alanından kaynaklanmaktadır, çok büyük olması, belirgin bir küresel etkiye neden olacaktır. Küresel yüzey düzleme eşlendiğinde her zaman bozulma vardır.

Distorsiyon modellenebilir ve geriye döndürülebilir. Ancak menzil tuhaf olacak, bu da bir şeyin kesileceği ve bazı piksellerin boşa gideceği anlamına geliyor.

Bir 3B sahnenin iki boyuta nasıl yansıtıldığını daha kolay açıklamak için, makine görüşü homojen koordinatlar adı verilen bir şey getirdi.

Bölünmeden sonra doğrusal bir sistem olmadığı için, onu yükseltiyoruz.Bunun avantajı, yükseltilen vektörün, son görüntülemede hesaplanan doğrusal bir şey haline gelecek şekilde aşağıdaki tüm dönüşümlerle formüle edilebilmesidir. Görüntü alanı noktasının konumu, sonunda bire bölünür.

Görüntü ne kadar uzaksa optik eksene o kadar yakın olur yani bu bölme önce yapılmaz, daha sonra görüntülendikten sonra yapılır.Doğrusal olmayan problem bir önceki hesaplama işleminde önlenebilir.

Matematikteki bu formüller, dört boyuttan üç boyuta yansıtılan bir matris çarpımı olan algısal matristir. Gerçek dünyada uzayda üç boyutlu bir nokta vardır ve dünya koordinatlarından görüntü koordinatlarına dönüşüm süreci vardır.

Örneğin, önce dünya koordinat sistemi kurulur ve tüm noktalar tanımlanır. Şu anda kamera belirli bir konuma yerleştirilebilir ve bunu açıklayacak bir matris olacaktır. Dünya koordinat sistemini kamera koordinat sistemine dönüştürün, ardından perspektif matrisini ve ardından kamera koordinat sistemini çarpın Görüntü koordinat sistemine dönüştürün.

Bu, 3B görüntülemenin temelidir.

Bu, büyük ölçekli 3B rekonstrüksiyonları ele almanın yoludur. Uzaydaki bir noktanın elde ettiği görüntü, bir uzay dönüşüm matrisi ile çarpılır. Artık kameranın ve noktanın pozisyonları bilinmemektedir.Aynı objenin fotoğrafı birkaç kamera ile çekilmekte ve noktanın obje ve kamera üzerindeki pozisyonu birlikte elde edilebilmektedir. Bu onun nesnel işlevidir.

Döndürme matrisinin zaten bilindiğini varsayarsak, uzaydaki tüm özellik noktalarına karşılık gelen öteleme ve perspektif bilindiğinden, noktanın görüntü üzerindeki doğru konumu bilinir.

Uzaydaki konumu tahmin etmek için bu hatayı en aza indirin. Kameranın yerini öğrenebilirsiniz. Bu çok büyük ölçekli. Milyonlarca noktanın konumlarını optimize etmek gerekiyor ve binlerce fotoğraf, binlerce farklı kameranın konumuna karşılık geliyor.Aynı zamanda kameraların konumları da optimize edilmeli ve nihayet en aza indirilmelidir.

Örneğin, belirli bir manzara noktasında turistler tarafından çekilen resimleri toplamak için İnternet'e gidin. Ortak optimizasyon yapın. Yerel özellik belirleme yapmak, her birinde bir grup özellik noktası olduğunu ve herhangi iki özellik noktasının uzamsal konumu hesaplamak için binlerce nokta oluşturabileceğini görecektir.

Eşzamanlı fotoğraflardaki üç boyutlu noktaların pozisyonları bir nokta bulutu oluşturabiliyorsa, nokta bulutu üç boyutlu sahnedeki noktaların konumunu tanımlamak için kullanılabilir. Fakat o sadece bir nokta bulutu olduğu için tam bir geometrik yüzey değildir.

Aynı zamanda, bu kadar çok görüntü için, her birinin nerede çekildiğini anlayabilirsiniz. Google'ın sokak görünümü böyledir. Bu nokta bulutları, nerede çekildiklerini ve piksel düzeyinde doğru olduğunu bulabilir. Bu, fotoğraflar ve fotoğraflar arasında rahatça hareket etmenize izin verecektir. Sadece bu üç boyutu yeniden oluşturun.

Burada kullanılan teknolojiyi hatırlayın. Her noktanın görüntülenmesi nereden geliyor? Lokal özelliğin bu tanımına göre iki nokta arasındaki uyuşmayı bulun ve dönüşümü gerçekleştirin.

Tüm değişiklikler, görüntü uzayında dönüştürülür. Buradaki farklı konumların paralaksı vardır ve çözüm, görüntü uzayının dönüşümü değil, üç boyutlu uzayın dönüşümüdür. Bunu çiftler halinde yapmak, son nokta bulutunun ve yeniden yapılandırılan nokta bulutunun bağlanamamasına neden olur. Çünkü iletim hataları biriktirecektir.

Mesafe çok uzaksa, geniş bir nesne yelpazesini yeniden inşa etmeliyiz. Fark, farklı görüntülerin üst üste binmesinin ne kadar büyük olduğu ile ilgilidir. Eğer büyükse, çizim de büyük olacaktır.

Her seferinde çok az örtüşme varsa, dönüşüm zincir boyunca biriktirilir. Bu, çok sayıda özellik noktasının birleştirilmesini gerektirir.

sonuç olarak

Üst düzey görme görevinde, görüntüleme bir kusurdur ve hangi verileri elde etmek istediğimiz değil, bir varsayım vardır. Elde edilen veriler aynı zamanda sorunlu mu? Bize imaj değişikliğinin nasıl ortaya çıktığını ve istediğimiz bu olup olmadığını anlatın. Önceden bilinebiliyorsa, önceden kaldırın, bu da veri kullanım oranını büyük ölçüde artırır. Yüksek seviyedeki veriler yeterli olmadığında, bir hata oluşur ve yakınsama elde edilemez, verilerin nasıl geldiğini görmemiz ve alt seviye vizyonun nasıl geldiğine geri dönmemiz gerekir. Makine öğrenimi vb. Yaparken, bazen algoritma parametrelerinizi ayarlamak için daha fazla bilgi ve daha iyi veri elde etmek o kadar yararlı değildir.Sensör sisteminizi sahneye, kamerayı nereye yerleştireceğinize ve hangi ışık kaynağına göre tasarlayın. Bu, üst düzey anlayış için çok önemlidir.

soru Zamanı:

1. Nokta bulutu oluşturulduktan sonraki adım nedir?

Temel fikir, size her noktanın konumunun mutlaka güvenilir olmadığını, doğrudan bağlantılı olduğunu söyleyen, bilginin iki yönüdür. Her noktanın etrafında birçok nokta var. Önce çevreyle bağlantı kurmak için bir grafik oluşturun, ancak yeniden yapılanmanın yasal bir manifold olduğunun garantisi yoktur. Şu anda, anormal kenarları ve noktaları kesmek için bir dizi geometrik işleme algoritması var.

Yeterli görüntü olduğunda, her noktanın normal vektörü bilinebilir.

Aynı noktayı alırsanız fotoğraflarda farklı ışığın parlaklığını bulabilir, çekim süresi ve yönüne göre ışık kaynağının konumunu tahmin edebilirsiniz. Normal vektör, sadece konum için değil, aynı zamanda normal vektör için de görüntü uzayında yeniden oluşturulur. Normal vektöre sahip olduğunuzda, grafiğin hangi kenarlarının bağlanamayacağını bilirsiniz ve yüzeyi daha iyi oluşturabilirsiniz.

2. Görme kalitesini iyileştirmek için sanal gerçeklikte daha fazla algoritmaya ihtiyaç var mı?

Bu bir vizyon meselesi değil, bir grafik meselesi.

Yüksek kalitede render edilmiş görüntüler elde etmek için, nesnenin malzemesinin iyi tanımlanması gerekir.Örneğin, BRDF resimleri bilgisayardaki fotoğraflar kadar gerçekçi hale getirebilir.

İkincisi hafif. Fotoğraf uygulamalarına ek olarak bilgisayar grafiklerinde de anlamlıdır. İlk günlerde gördüğüm şeylerin grafikleri çok yapaydı ve en büyük sorun nokta aydınlatmasıydı.

Gerçekte mutlak bir nokta ışık kaynağı yoktur ve ışık, küresel bir aydınlatma hesaplama ve aydınlatma sistemi olan bu nesneyi dolaylı olarak aydınlatacaktır. Tüm sahnenin aydınlatmasını tanımlamak için HDR görüntüleri kullanın, onu aydınlatmak için tek bir nokta değil, bir küre alanı oluşturun, böylece oluşturma kalitesi gerçek dünyaya daha yakın olacaktır. VR artık çok güçlü değil.

3. Yüzey yansımasının görece güçlü olduğu üç boyutlu uzay nasıl yeniden oluşturulur?

En temel yöntem, farklı bakış açılarına karşılık gelen noktaları bulmak ve uzaydaki konumu hesaplamaktır. Ancak karşılık gelen ilişki kurulamadığında, karşılık gelen ilişki bularak yeniden kurulamaz.

Burada, nesneye bir yan ışık yapmak için fotometrik stereo kullanıyoruz. Çok fazla yan ışığa vurarak, nesnenin yüzeyinin yansıtıldığına dair belirli bir varsayım varsa, her yüzeyin normal vektörü elde edilebilir. Uzaydaki her normal vektörün ne olduğunu bulmak için ışık kaynağının konumunu değiştirin.

Normal vektörle integral, nesnenin yüzeyini ve konumunu bulabilir. Bir başka algoritma seti, sahneyi parçalara ayırmaktır, her parça bir set elde edilebilir. Önce bir vektörle yapalım.

Örneğin, bazı nesnelerin yüzeyinde yansıyan ışık çok güçlü ve tuhaftır ve karşılığını bulamazsınız. Ardından resmi tek başına yapın ve görüş açısından bağımsız olarak yüzeydeki normal vektörü bulun. Orijinal yola geri dönebilir ve karşılık gelen yolu bulabiliriz, karşılık gelen olanı bulmak için RGB rengini değil, kullanım vektöründen oluşan özelliği bulabiliriz.

4. Makine öğreniminde RGB nasıl tanınır, normal vektörü içine atmak için fotometrik yöntem nasıl kullanılır?

Örneğin, evrişimli sinir ağı, aşağıdaki katmanlar aynıdır. Anahtar, ilk birkaç kattır. Önceki evrişim çekirdeğinde, 5 × 5 gri tonlamalı görüntüye ek olarak, yalnızca 5 × 5 evrişimli ağ vardır. Arka taraf RGB ise, üç tane var. Ancak vektör normalleştirilmiş bir birim vektör olduğundan, sadece 25 × * 5 yeterlidir.

Ben sadece her pikselde kaç tane boyut olduğu umurumda, her boyutun içeriğinin ne olduğu umrumda değil ama her boyutun değeri farklı. Esas olan hala görüntünün orijinal özelliklerini tarif etmektir, ancak biri RGB'nin düzenlemesi, diğeri ise normal vektörün düzenlemesidir. Örneğin, her noktada bir RGB çekirdeği, RGB ve D'ye ek olarak, daha iyi optimizasyon olmadan doğrudan CNN'ye atılabilir, ancak önceki evrişimin 5 × 5'inin her birine karşılık gelmesi için 5 × 5 ile değiştirilmesi gerekir. Tek kanal, bu uygulama yeterlidir.

Bazen aralığın farklı olduğu konusunda yine de dikkatli olmamız gerekir. Veriler doğrudan kaybolabilir veya normalleştirilebilir, ancak normalleştirme, tamamen bağlı bir ağdan öğrenmeyi kolaylaştırabilir, ancak ilk başta öğrenmek için onu sadece atmamalısınız. Modeli zaten bildiğiniz halde modeli öğrenmek için uğraşmayın. Hazırlanması gereken daha az veri olacak ve süreç daha basit olacaktır.

5. Normal vektör içeri atılabilir. Normal vektörü işaretlediğimizde koşulları kalibre etmek zorsa ne yapmalıyız?

Normal vektör, ışık kaynağı gibi hesaplanır. Işık kaynağının uzakta olduğunu varsayarsak, bir top koyabilir, topun normal vektörünü önceden bilebilir ve ışık kaynağının konumunu hesaplayabilirsiniz. Nokta ışık kaynağı yakınsa, dört top koyabilir, dört topun normal vektörünü önceden öğrenebilir, ışığın en parlak noktasından yönünü ve mesafesini hesaplayabilir, her normal vektörün ne olduğunu bilebilirsiniz.

Bitiş

Samimi işe alım

Qubit, editörleri / muhabirleri işe alıyor ve merkezi Pekin, Zhongguancun'da bulunuyor. Yetenekli ve hevesli öğrencilerin bize katılmasını dört gözle bekliyoruz! İlgili ayrıntılar için lütfen QbitAI diyalog arayüzünde "işe alım" kelimesini yanıtlayın.

-

- Tardelli, Luneng tarafından son kez reddedildi ve süper eski kızarmış hamur çubukları saniyeler içinde tatlı ve hamur işine dönüştü.Şanghay'ın derinliği nasıl olur?

-

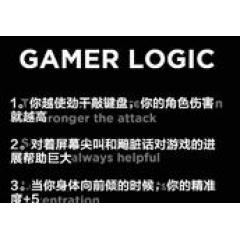

- Klavyeye ne kadar sert vurursanız, o kadar zor mu? Bu 8 Sao operasyonu ile oyun oynarken hiç kimse rakibiniz olamaz!

-

- Zhu Huarong ve Ma Huateng, Changan Automobile'in nasıl uçtuğunu görmek için güçlerini birleştiriyor mu?

-

- Playofflar için umutlar zayıf, Zhan Huang'ın hiç arzusu yok mu? Yapma! Bu 4 nokta hakkında çok endişeli!

-

- Shenhuanın 18 yaşındaki genci birçok kez hayal kırıklığına uğradı ve beklenmedik bir şekilde Wu Xiaohui + Gou Zhongwen tarafından biraz sert ve ölçülü bir şekilde övüldü

-

- Kralın ihtişamının en sefil kahramanı Tianmei, onu iki kez güçlendirdikten sonra kurtaramaz! Şimdi nihayet bir çırpıda sunağa bindim