Makine öğrenmiyor: NLP'de dikkat mekanizmasının uygulanması

Son yıllarda, derin öğrenme araştırmaları giderek daha derin hale geldi ve çeşitli alanlarda birçok atılım yapıldı. Dikkat mekanizmasına dayalı sinir ağları, son zamanlardaki sinir ağı araştırmalarında sıcak bir konu haline geldi. Son zamanlarda, dikkat mekanizmasına dayalı sinir ağlarına dayanan doğal dil işleme (NLP) alanında bazı makaleler öğrendim. Şimdi NLP'de dikkat üzerine odaklanacağım. Uygulamanın bir özetini yapmak ve herkesle paylaşmak.

1 Dikkat araştırma ilerlemesi

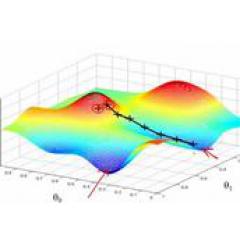

Dikkat mekanizması ilk olarak görsel imgeler alanında önerilmişti, son dokuz yılda önerilmiş olması gerekiyordu, ancak google zihin ekibi tarafından "Tekrarlayan Görsel Dikkat Modelleri" makalesi olarak değerlendirilmeli, bunlar RNN modelindedir. Dikkat mekanizması, görüntü sınıflandırması için kullanılır. Daha sonra, "Hizalamayı ve Çevirmeyi Ortak Öğrenerek Nöral Makine Çevirisi" adlı makalede, Bahdanau ve diğerleri, aynı anda makine çevirisi görevlerinde çeviri ve hizalama gerçekleştirmek için dikkat benzeri bir mekanizma kullandılar. Çalışmaları, dikkat mekanizmasının bir uygulamasını öneren ilk kişi olarak kabul edilir NLP alanına. Daha sonra dikkat mekanizmasına dayalı RNN modelinin benzer uzantıları çeşitli NLP görevlerine uygulanmaya başlandı. Son zamanlarda, dikkat mekanizmasının CNN'de nasıl kullanılacağı bir araştırma noktası haline geldi. Aşağıdaki şekil, dikkat araştırması ilerlemesinin genel eğilimini göstermektedir.

2 Tekrarlayan Görsel Dikkat Modelleri

NLP'de Dikkat'i tanıtmadan önce, kabaca görüntülerde dikkati kullanma fikrinden bahsetmek istiyorum. "Tekrarlayan Görsel Dikkat Modelleri" temsili makalesi için, araştırma motivasyonları aslında insan dikkat mekanizmasından esinlenmiştir. İnsanlar bir görüntüyü gözlemlerken aslında tüm görüntünün her pikseline tek seferde bakmazlar, çoğu dikkatlerini ihtiyaçlarına göre görüntünün belirli bir kısmına odaklar. Ve insanlar daha önce gözlemlenen görüntülerden gelecekte dikkatlerini nereye odaklamaları gerektiğini öğrenecekler. Aşağıdaki şekil, bu makalenin ana modelinin bir diyagramıdır.

Bu model, dikkat mekanizmasını (yani kırmızı daire içinde daire içine alınmış kısmı) geleneksel RNN'ye ekler ve dikkat yoluyla bir görüntünün işlenecek kısmını öğrenir. Mevcut durum her seferinde, dikkati çekmek için önceki durumdan öğrenecektir. Görüntünün tüm pikselleri yerine piksellerin dikkat bölümünü işlemek için l'yi ve mevcut giriş görüntüsünü konumlandırın. Bunun avantajı, işin karmaşıklığını azaltarak daha az pikselin işlenmesi gerekmesidir. Görseldeki dikkatin uygulanmasının insan dikkat mekanizmasına çok benzediği görülmektedir.Şimdi NLP'de kullanılan dikkati inceleyelim.

3 NLP'de Dikkat temelli RNN

3.1 Hizalamayı ve Çevirmeyi Ortak Öğrenerek Nöral Makine Çevirisi

Bu makale, NLP'deki dikkat mekanizmasını kullanan ilk çalışma olarak kabul edilmektedir. Dikkat mekanizmasını sinir ağı makine çevirisine (NMT) kullandılar. NMT aslında, kod çözücü modeline kodlayıcı olan tipik bir sekans modeli dizisidir.Geleneksel NMT iki RNN kullanır ve bir RNN kaynak dili kodlar. Kaynak dili sabit boyutlu bir ara vektör olarak kodlayın ve ardından bunu çözmek ve hedef dile çevirmek için bir RNN kullanın. Geleneksel model aşağıda gösterildiği gibidir:

Bu makale dikkat mekanizmasına dayalı bir NMT önermektedir. Model kabaca aşağıdaki gibidir:

Resimde, kod çözücüdeki tüm bağlantıları çizmedim, sadece ilk iki kelime çizildi ve son kelimeler aslında aynı. Dikkat temelli NMT'nin geleneğe dayandığı görülmektedir.Kaynak dilde her kelimenin öğrenmiş olduğu ifadeyi (geleneksel ifade sadece son kelimeden sonra öğrenilen ifadedir) ve çeviri için tahmin edilecek mevcut kelimeyi birbirine bağlamaktadır. Tasarladıkları dikkat ile bağlantı kurulur.Model eğitildikten sonra dikkat matrisine göre kaynak dil ve hedef dilin uyum matrisini elde edebiliriz. Spesifik makalenin dikkat tasarımı kısmı aşağıdaki gibidir:

Hedef dildeki her kelimeyi kaynak dilde birbirine bağlamak için bir algılayıcı formülü kullandıkları ve daha sonra dikkat matrisi olan olasılık dağılımını elde etmek için soft fonksiyonu aracılığıyla normalleştirdikleri görülebilir.

Sonuçlardan, geleneksel NMT (RNNsearch, dikkat NMT, RNNenc geleneksel NMT) ile karşılaştırıldığında, etki çok geliştirildi.Büyük özelliği, hizalamayı görselleştirebilmesi ve uzun cümleleri işlemede daha fazla avantaja sahip olmasıdır.

3.2 Dikkat Temelli Nöral Makine Çevirisine Etkili Yaklaşımlar

Bu makale, önceki makaleden sonra çok temsili bir makale. Çalışmaları, RNN'de dikkatin nasıl uzatılabileceğini anlatıyor. Bu makale, NLP'deki çeşitli dikkat temelli modellerin uygulanmasıyla başlayacak. Harika bir terfi için. Makalede, biri küresel mekanizma, diğeri yerel mekanizma olmak üzere iki dikkat mekanizması önerdiler.

Öncelikle, küresel mekanizmanın dikkatine bir bakalım.Aslında bu, önceki makalede önerilen dikkat ile aynı fikirdir.Tüm kelimeleri kaynak dilde işler.Aradaki fark, dikkat matrisinin değerini hesaplarken, o Birkaç basit genişletilmiş sürüm önerilmiştir.

Son deneylerinde, genel hesaplama yöntemi en iyi sonucu verir.

Önerilen yerel versiyona bir göz atalım. Ana fikir, dikkat hesaplamasının maliyetini azaltmaktır Dikkat hesaplanırken, yazar kaynak dil tarafındaki tüm kelimeleri dikkate almaz, ancak bir tahmin fonksiyonuna göre, önce mevcut kod çözme sırasında hizalanacak kaynak dil tarafının Pt konumunu tahmin edin ve ardından bağlamı kullanın Pencere, yalnızca penceredeki kelimeleri dikkate alın.

Yerel-m ve yerel-p olmak üzere iki tahmin yöntemi vardır: Son dikkat matrisi hesaplanırken, pt'nin konumu ile ilgili bir Gauss dağılımı orijinal bazda çarpılır. Yazarın deneysel sonuçları, yerel dikkatin küresel ilgiden daha iyi olduğudur.

Bence bu makalenin en büyük katkısı, öncelikle dikkat hesaplama yöntemini ve ayrıca yerel dikkat yöntemini nasıl genişletebileceğimizi anlatmaktır.

4 NLP'de dikkat temelli CNN

Daha sonra, Dikkat temelli RNN modeli NLP'de yaygın olarak kullanılmaya başlandı, sadece diziden diziye modeller değil, aynı zamanda bu modeller çeşitli sınıflandırma problemleri için de kullanılabilir. Peki, derin öğrenmede RNN kadar popüler olan evrişimli sinir ağı CNN de dikkat mekanizmasını kullanabilir mi? "ABCNN: Cümle Çiftlerini Modellemek için Dikkat Temelli Evrişimli Sinir Ağı" Bu makale CNN'de dikkatin daha önceki bir keşif çalışması olan CNN'de dikkati kullanmanın 3 yöntemini ortaya koymaktadır.

Geleneksel CNN, yukarıdaki şekilde gösterildiği gibi cümle çifti modelini oluşturur, her bir kanal üzerinden bir cümleyi işler, sonra cümle ifadesini öğrenir ve son olarak onu sınıflandırıcıya birlikte girer. Böyle bir model, girdi sınıflandırıcısından önce cümle çiftleri arasında birbiriyle ilişkili değildir.Yazarlar, bir dikkat mekanizması tasarlayarak farklı cnn kanallarının cümle çiftlerini bağlamak isterler.

Birinci yöntem ABCN0-1, evrişimden önce dikkati gerçekleştirmek, dikkat matrisi aracılığıyla karşılık gelen cümle çiftinin dikkat özelliği haritasını hesaplamak ve ardından bunu orijinal özellik haritası ile birlikte evrişimli katmana girmektir. Spesifik hesaplama yöntemi aşağıdaki gibidir.

İkinci yöntem ABCN-2, havuzlama sırasında dikkati gerçekleştirmek, evrişimli ifadeyi dikkatle yeniden ağırlıklandırmak ve ardından havuzlama yapmaktır. Prensip aşağıdaki gibidir.

Üçüncüsü, aşağıda gösterildiği gibi ilk iki yöntemi CNN'de birlikte kullanmaktır.

Bu makale, CNN'de dikkati kullanma fikrimizi sağlar. Ayrıca ilgiye dayalı birçok CNN işi var ve iyi sonuçlar elde edildi.

5 Özet

Son olarak bir özet yapın. Aslında NLP'de Dikkatin bir tür otomatik ağırlıklandırma olarak değerlendirilebileceğini düşünüyorum.Ağırlık ile bağlamak istediğiniz iki farklı modülü birbirine bağlayabilir. Mevcut temel hesaplama formülleri aşağıdaki gibidir:

Hedef modül mt ve kaynak modül ms'yi bir fonksiyon tasarlayarak bağlayın ve ardından olasılık dağılımını elde etmek için bir soft fonksiyon aracılığıyla normalize edin.

Şu anda NLP'de dikkat yaygın olarak kullanılmaktadır. Görevleri yerine getirirken sinir ağının hangi bölümlerine dikkat ettiğini söylemek için dikkat matrisini görselleştirebilmesi büyük bir avantaja sahiptir.

Bununla birlikte, NLP'deki dikkat mekanizması hala insan dikkat mekanizmasından farklıdır: Temel olarak işlenecek tüm nesneleri hesaplaması ve ağırlıklarını depolamak için ek bir matris kullanması gerekir ki bu da aslında yükü artırır. İnsan gibi dikkat etmek istemediğiniz kısımları görmezden gelmek yerine, sadece önem verdiğiniz kısımlarla ilgilenin.

Referanslar

Bahdanau, D., Cho, K. ve Bengio, Y. Nöral Makine Çevirisi, Hizalama ve Çevirmeyi Ortak Öğrenerek Iclr 2015115 (2014).

Luong, M. ve Manning, C. D. Dikkat Temelli Nöral Makine Çevirisine Etkili Yaklaşımlar. 1412-1421 (2015).

Rush, A. M. ve Weston, J. Soyut Cümle Özetleme için Sinirsel Dikkat Modeli EMNLP (2015).

Allamanis, M., Peng, H. and Sutton, C. A Convolutional Attention Network for Extreme Summarization of Source Code. Arxiv (2016).

Hermann, K. M. ve diğerleri Okumak ve Anlamak için Makinaları Öğretme arXiv 113 (2015).

Yin, W., Ebert, S. ve Schütze, H. Dikkat Temelli Evrişimli Sinir Ağı Makine Anlama için.7 (2016).

Kadlec, R., Schmid, M., Bajgar, O. and Kleindienst, J. Text Understanding with the Attention Sum Reader Network. ArXiv: 1603.01547v1 (2016).

Dhingra, B., Liu, H., Cohen, W. W. and Salakhutdinov, R.Gated-Attention Readers for Text Comprehension. (2016).

Vinyals, O. ve diğerleri. Yabancı Dil Olarak Dilbilgisi. ArXiv 110 (2015).

Wang, L., Cao, Z., De Melo, G. and Liu, Z. Multi-Level Attention CNNs aracılığıyla İlişki Sınıflandırması Acl 12981307 (2016).

Zhou, P. et al. İlişki Sınıflandırması için Dikkat Temelli Çift Yönlü Uzun Kısa Süreli Bellek Ağları. Proc. 54th Annu. Meet. Assoc. Comput. Linguist. (Volume 2 Short Pap. 207212 (2016).

Yang, Z. ve diğerleri, Belge Sınıflandırması için Hiyerarşik Dikkat Ağları. Naacl (2016).

Yin W, Schütze H, Xiang B, vd.Abcnn: Cümle çiftlerini modellemek için dikkat tabanlı evrişimli sinir ağı. ArXiv ön baskı arXiv: 1512.05193, 2015

Mnih V, Heess N, Graves A.Görsel dikkatin tekrarlayan modelleri // Sinirsel Bilgi İşleme Sistemlerindeki Gelişmeler.2014: 2204-2212.

-

- Dünyanın en büyük 50 icatından biri olan "engellemeyi engelleyen eser" olarak bilinen Batie vahşice yıkıldı