AAAI 2019 Gaussian Transformer: doğal dil çıkarımı için hafif bir yöntem

Bildiri Başlığı: Gaussian Transformer: A Lightweight Approach for Natural Language Inference

Yazarlar: Guo Maosheng, Zhang Yu, Liu Ting

Orijinal yazar: HIT SCIR doktora Guo Maosheng

Özet

Doğal Dil Çıkarımı (NLI) aktif bir araştırma alanıdır ve bu amaçla Tekrarlayan Sinir Ağları (RNN'ler), Konvolüsyonel Sinir Ağları (CNN'ler) ve Öz Dikkat Ağları'na (SAN'lar) dayanan birçok model önerilmiştir. Bu modeller iyi performans elde etmesine rağmen, RNN'leri temel alan modellerin paralel olarak eğitilmesi zordur.CNN'lere dayalı modellerin çok sayıda parametre tüketmesi gerekir ve öz-ilgiye dayalı modeller metindeki yerel bağımlılıkları yakalamaktan daha zayıftır. Bu sorunun üstesinden gelmek için, cümlelerin yerel yapısını daha iyi modellemek için öz-dikkat mekanizmasından önce bir Gauss'u tanıttık. Daha sonra, Gaussian Transformer adlı NLI görevi için döngülere veya evrişimlere dayanmayan verimli bir ağ yapısı önerdik. Yerel ve küresel bağımlılıkları modellemek için bir kodlama modülünden, çok adımlı çıkarımları toplamak için yüksek sıralı bir etkileşim modülünden ve hafif parametrelere sahip bir karşılaştırma modülünden oluşur. Deneysel sonuçlar, modelimizin SNLI ve MultiNLI veri setlerinde o sırada en yüksek sonuçları elde ederken, parametre sayısını ve eğitim süresini büyük ölçüde azalttığını göstermektedir. Ek olarak, HardNLI veri kümesinde yapılan deneyler, yöntemimizin Ek Açıklama eserlerinden daha az etkilendiğini göstermektedir.

1. Giriş

1.1 Göreve giriş

Metinsel Etkileşimi Tanıma (RTE) olarak da bilinen Doğal Dil Çıkarımı (NLI), metinler arasındaki anlamsal çıkarım ilişkisini inceler. Özellikle, iki cümle arasındaki çıkarım ilişkisini tanımlamaktır, örneğin , Çıkarım, çelişki, tarafsızlık. Resmi olarak, NLI bu metnin bir sınıflandırma problemidir.

1.2 Motivasyon

İşte Gauss Öz dikkatini önerme motivasyonumuza kısa bir giriş. Bir cümlede, mevcut sözcükle daha anlamsal olarak ilişkili olan sözcüklerin genellikle bu sözcük etrafında göründüğünü, ancak sıradan öz dikkatin bunu etkili bir şekilde yansıtmadığını gözlemledik. Şekil 1'de gösterildiği gibi, "Yeni bir satın aldım kitap Dün New York'ta yeni bir arkadaşla. ", Toplam üç" yeni "ortaya çıktı, ancak şu anki kelime kitabı için yalnızca ilk yeni anlamlı. Ama sıradan öz ilgi (kullanmadığında) Konum kodlama durumunda), bu üç "yeni", Şekil 1 (a) 'da gösterildiği gibi aynı ağırlıkta atanır. Bizim fikrimiz, bitişik kelimelere daha fazla ağırlık vermek için öz ilgiyi teşvik etmektir. Bu amaçla, orijinal ağırlığı, Şekil 1 (b) 'de gösterildiği gibi, yakın konuma göre dağıtılan bir Gaussian önceki olasılıkla çarpıyoruz ve daha etkili bir şekilde modellemek için Şekil 1 (c)' de gösterildiği gibi öz dikkatin ağırlık dağılımını değiştiriyoruz. Cümlenin yerel yapısı.

Şekil 1. Gausslu öz-ilgi örneği

Aslında, RNN'ler ve CNN'ler doğal olarak yakındaki kelimelere daha fazla ağırlık verebilirler.Örneğin, RNN'ler uzaktaki kelimeleri unutma eğilimindedir ve CNN'ler mevcut pencerede olmayan tüm kelimeleri görmezden gelir. Bu makalede, Transformer ağına Gauss öz dikkatini uyguladık ve bunu Doğal Dil Çıkarımı görevinde doğruladık.Deneyler, önerdiğimiz Gauss Transformatörünün Gauss öz dikkatine dayalı olduğunu gösteriyor. Etki, birçok güçlü temel yöntemden daha iyidir. Aynı zamanda, bu yöntem aynı zamanda orijinal Transformer'in paralel eğitiminin ve daha az parametrenin avantajlarını da korur.

2 Model tanıtımı

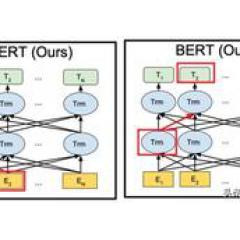

Uygulama açısından, Şekil 2'de gösterildiği gibi, Gauss öz dikkatini Transformer'da bir dizi basitleştirme yoluyla bir matris toplama işlemine dönüştürebiliriz (ayrıntılar için lütfen makalemizin orijinal metnine bakın), böylece hesaplama miktarından tasarruf edebiliriz. Ek olarak, orijinal Gauss dağılımını önceki olasılık olarak kullanmakla karşılaştırıldığında, kelimenin kendisine doğru bir şekilde dikkat edilmesinin, Şekil 3 (b) 'de gösterildiği gibi nihai deneysel sonuçları biraz iyileştirebileceğini bulduk.

Şekil 2. Dikkat örnekleri: (a) orijinal nokta-ürün dikkati; (b) (c) Gauss öz-ilgisinin iki uygulaması

Şekil 3. Önceki olasılıklara örnekler: (a) orijinal Gaussian önceliği; (b) Gaussianın önceki varyantı kendi kendine bastırılır

Şekil 4, modelimizin genel çerçevesini göstermektedir. Şekilde gösterildiği gibi, model aşağıdan yukarıya doğru kabaca dört bölüme ayrılmıştır: Gömme modülü, Kodlama modülü, Etkileşim modülü ve Karşılaştırma modülü.

Şekil 4. Gauss Transformatörünün genel çerçevesi

Gömme modülünün işlevi, doğal dil metnini makine işlemesi için uygun olan vektörleştirilmiş bir gösterime dönüştürmektir. Kelime ve karakter seviyesinde Gömme ve Konumsal Kodlama kullanıyoruz.

Kodlama modülü, cümlenin yerel yapısını daha iyi modellemek için daha önce tanıtılan Gauss öz dikkatini eklememiz dışında, orijinal Transformer'in Kodlayıcısına çok benzer. Ama aslında, cümlelerde uzun mesafeli bağımlılıklar vardır ve cümlelerin yerel yapısını modellemek yeterli değildir. Cümlenin genel bilgilerini yakalamak için M Kodlama modüllerini istifliyoruz. Bu yöntem, çok katmanlı CNNs ağına benzer, daha yüksek evrişimli katmanın alıcı alanı, alt katmanın evrişiminden daha büyüktür.

Etkileşim modülü, iki cümlenin etkileşimli bilgilerini yakalamak için kullanılır. Bu parça, Konumsal Maskeyi ve kod çözme parçasını kaldırmamız dışında, orijinal Transformer'in Kod Çözücü kısmına benzer. N Etkileşim modüllerini istifleyerek, üst düzey etkileşim bilgilerini yakalayabiliriz.

Karşılaştırma modülü esas olarak iki cümleyi cümlenin Kodlanması ve Etkileşimi perspektifinden karşılaştırmaktan sorumludur.Burada önceki modeldeki karmaşık yapıyı kullanmadığımız için birçok parametreyi kurtarıyoruz.

3 Deney ve analiz

3.1 Deneysel sonuçlar

İlk olarak, her modülün etkinliğini doğrularız.Şekil 5'te gösterildiği gibi, çok katmanlı bir Kodlama modülü ve çok katmanlı bir Etkileşim modülü kullanmanın etkisi, tek katmanlı bir model kullanmaktan daha iyidir, bu da yukarıda belirtilen genel bilgileri ve yüksek Birinci dereceden etkileşimin etkinliği. İkincisi, Gauss önceliğinin geçerliliğini doğrulamak istiyoruz. Tablo 1'de gösterildiği gibi, önceki Gaussian ve varyantlarının performansının Zipf öncesi ve orijinal Transformer gibi diğer yöntemlerden daha iyi olduğunu bulduk. Son olarak, SNLI, MultiNLI ve HardNLI test setlerinde diğer önceki yöntemlerle yatay bir karşılaştırma yaptık. Tablo 2, 3, 4, 5 ve 6'da gösterildiği gibi, yöntemimiz aynı veri turu için doğruluk, model parametre miktarı ve eğitim ve tahmin süresi açısından temel yöntemden daha iyidir.

Şekil 5. MultiNLI geliştirme setindeki doğruluk ısı haritası.

Tablo 1. MultiNLI geliştirme setindeki her Gauss trafosu varyantının doğruluğu

Tablo 2. Gauss Transformatörünün SNLI test setindeki diğer modellerle yatay karşılaştırması

Tablo 3. Gauss Transformatörünün MultiNLI test setindeki diğer modellerle yatay karşılaştırması

Tablo 4. SNLI veri setinde bir tur eğitmek veya tahmin etmek için gereken sürenin karşılaştırması

Tablo 5. Dış kaynaklar sunulduğunda her modelin performans karşılaştırması

Tablo 6. HardNLI ile ilgili karşılaştırma sonuçları

3.2 Analiz

S: Konumsal kodlama, kelimelerin konum bilgilerini yakalayabilen orijinal Transformer'da zaten mevcuttur.Neden Gaussian Prior kullanılıyor?

A: Konumsal Kodlama, modelin yalnızca kelimelerin konumunu algılama yeteneğine sahip olmasını sağlar ve Gaussian Prior, modele hangi kelimelerin daha önemli olduğunu, yani mevcut kelime için yakın kelimelerin uzak kelimelerden daha önemli olduğunu söyler.Bu a priori, insan gözleminden gelir.

S: Gaussian Transformer, zaman ve parametre miktarı açısından neden diğer yöntemlerden üstündür?

A: Gauss Transformatörünün döngü ve evrişim yapısı olmadığı için paralel olarak hesaplanabilir.Aynı zamanda modeli tasarlarken, önceki yöntemdeki karmaşık yapıyı (örneğin Karşılaştırma bloğundaki sadeleştirme) terk ederek modeli sadeleştirmeye çalışıyoruz. Hafif.

4. Sonuç

Doğal dil çıkarım görevleriyle ilgili önceki çalışmaların eksikliklerini hedefleyerek, Gauss öz dikkatine dayalı bir Gauss Transformatörü modeli öneriyoruz. Deneyler, önerilen modelin birkaç doğal dil çıkarım görevinde son teknoloji deneysel sonuçlara ulaştığını göstermektedir.

Bu konudan sorumlu editör: Zhang Weinan

Bu sayının editörü: Wu Yang

Orijinal metin WeChat Resmi Hesabı-Derin Öğrenme Doğal Dil İşleme (zenRRan) adresinde yayınlandı