ICLR 2020 | Sinirsel tanjant, sonsuz genişlikte bir sinir ağı modeli oluşturmak için 5 satır kod

Yazar Google'dan olan bu makale, "SİNİR TANGENTS: PYTHON'DA HIZLI VE KOLAY SONSUZ SİNİR AĞLARI" başlıklı ICLR 2020 makalesinin bir yorumudur. Derleme | Zhang Daqian

Düzenle | Kongun Sonu

Kağıt adresi: https://arxiv.org/pdf/1912.02803.pdf

Açık kaynak adresi: https://github.com/google/neural-tangents

1

Araştırma Geçmişi Derin öğrenme, doğal dil işleme, diyalog aracıları ve bağlantı bilimi gibi birçok alanda başarıyla uygulanmıştır. Bu öğrenme yöntemi, makine öğreniminin araştırma ortamını değiştirmiş ve araştırmacılara birçok ilginç ve önemli açılım getirmiştir. Cinsel sorular, örneğin: Derin bir sinir ağı (DNN) aşırı parametreleştirildiğinde neden bu kadar iyi genellenebilir? Derin bir ağın mimarisi, eğitimi ve performansı arasındaki ilişki nedir? Derin öğrenme modellerinden göze çarpan özellikler nasıl çıkarılır?

Son yıllarda, bu alandaki temel bir teorik ilerleme noktası, DNN'lerin genişliğinin artırılmasının daha düzenli davranışlara yol açacağı ve bu davranışların anlaşılmasını kolaylaştıracağıdır. Son zamanlarda elde edilen birçok sonuç, sonsuz genişliğe ulaşabilen DNN'lerin başka bir basit model kategorisinde toplandığı sürece Gauss süreci olarak adlandırıldığını göstermektedir.

Bu sınırlama altında, karmaşık fenomenler (Bayesci çıkarım veya evrişimli sinir ağlarının gradyan iniş dinamikleri gibi) basit doğrusal cebirsel denklemlere indirgenebilir. Bu sonsuz geniş bant ağlarının bazı fikirleri de sıklıkla sınırlı ağlara genişletilir. Bu nedenle, sonsuz geniş ağ sadece derin öğrenmeyi incelemek için bir boyut olarak kullanılamaz, aynı zamanda kendi başına çok faydalı bir modeldir.

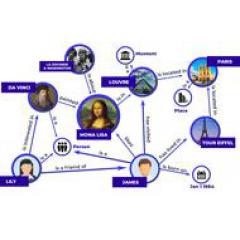

Sol: Şematik diyagram, derin bir sinir ağının sonsuz genişlik altında nasıl basit bir girdi / çıktı eşlemesi oluşturduğunu gösterir; sağda: sinir ağının genişliği arttıkça, ağın farklı rastgele örneklerdeki çıktı dağılımının Gauss dağılımı.

Ne yazık ki, sonlu bir ağın sonsuz genişlik sınırını türetmek çok fazla matematik bilgisi gerektirir ve çalışılan her mimari için ayrı ayrı hesaplanmalıdır. Sonsuz genişlik modeli türetildikten sonra, etkili ve ölçeklenebilir bir uygulama önermek için yüksek bir mühendislik yeteneği gerekir. Kısacası, sınırlı genişlikli bir modeli karşılık gelen sonsuz genişlikli bir ağa dönüştürme süreci birkaç ay sürebilir ve kendisi bir araştırma makalesinin konusu olabilir.

2 Sinir Tanjantı

Bu sorunu çözmek ve derin öğrenmenin teorik ilerlemesini hızlandırmak için, Google araştırmacıları, araştırmacıların sınırlı genişliğe sahip bir sinir ağı kadar kolay bir şekilde inşa etmelerine ve eğitmelerine olanak tanıyan yeni bir açık kaynaklı yazılım kitaplığı olan "Sinir Tanjantları" önerdiler. Sonsuz genişlikte sinir ağı. Özü şudur: Sinir Tanjantı, aynı anda sonlu ve sonsuz genişlikte sinir ağları oluşturabilen, kullanımı kolay bir sinir ağı kitaplığı sağlar.

Sinir teğetlerinin uygulanmasına bir örnek vermek gerekirse, bazı veriler üzerinde tamamen bağlı bir sinir ağını eğittiğinizi hayal edin. Genellikle sinir ağları rastgele başlatılır ve ardından gradyan inişi kullanılarak eğitilir. Bu sinir ağlarını başlatmak ve eğitmek entegre bir ağ elde edebilir.

Araştırmacılar ve uygulayıcılar, daha iyi performans elde etmek için genellikle entegrasyonun farklı bölümlerinin tahminlerinin ortalamasını alırlar. Ek olarak, belirsizlik, entegrasyonun farklı bölümleri tarafından tahmin edilen varyanstan tahmin edilebilir. Bu yöntemin dezavantajı, bir ağ topluluğunu eğitmenin çok fazla hesaplama bütçesi gerektirmesidir, bu nedenle bu yöntem nadiren kullanılır. Bununla birlikte, sinir ağı sonsuz genişlediğinde, topluluk Gauss süreci ile tanımlanır ve ortalama ve varyansı eğitim süreci boyunca hesaplanabilir.

3 Deneyler ve sonuçlar

Sinir teğetlerini kullanarak, bu sonsuz ağ entegrasyonlarını sadece beş satır kodla oluşturabilir ve eğitebilirsiniz! Eğitim süreci aşağıdaki gibidir, bu deney için etkileşimli işbirlikçi not defterini kullanmak için aşağıdaki adrese gidebilirsiniz:

https://colab.sandbox.google.com/github/google/neural-tangents/blob/master/notebooks/neural_tangents_cookbook.ipynb

Bu iki şekilde yazar, sonlu bir sinir ağı grubunun eğitimini, aynı yapının sonsuz genişlikteki bir topluluğu ile karşılaştırmaktadır. İlkinin ampirik ortalaması ve varyansı, iki açık siyah kesikli çizgi arasındaki siyah kesikli çizgiyle temsil edilir; ikincisinin kapalı form ortalaması ve varyansı, dolu renk alanındaki renkli çizgilerle temsil edilir. Bu iki şekilde, sonlu genişlikli ve sonsuz genişlikli ağların entegrasyonu çok yakındır ve hatta ayırt etmek zordur. Sol: Eğitim ilerledikçe, girdi verilerinden (yatay x ekseni) çıktı (dikey f ekseni). Doğru: Eğitim sırasında belirsiz faktörler nedeniyle eğitim ve test kaybı.

Sonsuz genişlikli ağ entegrasyonu basit bir kapalı form ifadesi ile kontrol edilmesine rağmen, sonlu genişlikli ağ entegrasyonuyla önemli bir tutarlılığa sahiptir. Ve sonsuz genişlikteki ağ entegrasyonu bir Gauss süreci olduğundan, doğal olarak kapalı bir belirsizlik tahmini formu (yukarıdaki şekilde renkli alan) sağlar. Bu belirsizlik tahminleri, tahmin edilen değişikliklerle yakından eşleşir: Sonlu genişlikteki bir ağın çok sayıda farklı kopyasını eğitirken gözlemlenen sonuçlar (kesikli çizgiler).

Yukarıdaki örnek, sonsuz genişlikteki sinir ağlarının eğitim dinamiklerini yakalama yeteneğini göstermektedir. Bununla birlikte, sinirsel teğetler kullanılarak oluşturulan bir ağ, herhangi bir soruna uygulanabilir, yani bu sorunları çözmek için geleneksel bir sinir ağı uygulanabilir.

Örneğin, aşağıdaki görüntü tanıma için üç farklı sonsuz genişlikteki sinir ağı mimarisini karşılaştırmak için CIFAR-10 veri setini kullanacaktır. Google araştırmacılarının, gradyan inişi ve tam Bayesci çıkarım (sonlu genişlikli ağ mekanizmasında zor bir görev) altında kapalı form sonsuz genişlikte artık ağlar gibi oldukça karmaşık modelleri değerlendirebileceğini belirtmek gerekir.

Sonsuz genişlikli ağın sonlu genişlikli sinir ağını taklit ettiği ve performans seviyesinin, evrişimli ağdan daha kötü olan tamamen bağlı bir ağınkine benzer olduğu ve evrişimli ağın performansının geniş artık ağınkinden daha kötü olduğu görülebilir.

Bununla birlikte, geleneksel eğitimin aksine, bu modellerin öğrenme dinamikleri kapalı bir biçimde işlenebilir, bu da araştırmacılara bu modellerin davranışları hakkında eşi görülmemiş bir anlayış sağlar.

ICLR 2020 makale serisinin yorumlanması

0 ICLR 2020 konferans haber raporu

Salgın ciddi, ICLR2020 sanal bir konferans düzenleyecek ve Afrika'nın ilk AI uluslararası zirvesi sırılsıklam olacak

Salgından etkilenen ICLR aniden çevrimiçi moda geçti. 2020 zirvenin değişim yılı mı olacak?

Popüler grafik makine öğrenimi, ICLR 2020'deki araştırma trendleri nelerdir?

1. Canlı yayın

Tekrar | Huawei Noah's Ark ICLR Full Score Paper: Reinforcement Learning'e Dayalı Nedensel Keşif

2, Oral

01. Sözlü | Yansıtılmış üretken makine çevirisi modeli: MGNMT

02. Oral | Negatif çeşitlilik cehaletini hafifletmeden önce Ekstra Gauss

03. Oral | Ek geçitleme işlemleri uygulayın, LSTM biraz değiştirildi, performans Transformer-XL ile karşılaştırılabilir

04. Oral | Paralel Monte Carlo araması, performans kaybı olmadan, doğrusal hızlanma ve "Eksik Eğlence" nin 1000 seviyesini cesurca aşma!

05. Sözlü | Meta yoğunlaştırılmış öğrenme, soğuk su dolu bir tencerede başlatıldı: yuan-Q öğrenmesinden çok daha iyi değil

06. Oral | Derin, eşdeğer bir kapsül ağı oluşturmak için grup evrişimini kullanın

07. Oral | Google, dağıtılmış pekiştirmeli öğrenme çerçevesi SEED'i başlattı, performans "patlayıcı" IMPALA, binlerce makineye genişletilebilir, ancak aynı zamanda çok ucuz

08. Oral | Reformer, verimli bir Transformatör

09. Oral | Değer fonksiyonu planlaması ve pekiştirme öğrenmeye dayalı kontrol mimarisi (canlı video)

10. Oral | Pekin Üniversitesi Turing Sınıfı tam puanlı makale: Hesaplama kısıtlamaları altında faydalı bilgilere dayalı bilgi teorisi

3. Gündem

01. Gündem | Bu kadar çok model parametresi varken, genelleme yeteneği neden bu kadar güçlü?

02. Gündem | Adalet ve hassasiyet aynı derecede önemlidir! CMU, algoritma adaletini sağlamak için öğrenmede adil bir temsil yöntemi önerir

03. Gündem | Zayıf kombinasyon genelleme yeteneği? Derin öğrenme füzyon kombinasyonu çözücüyü kullanmayı deneyin

04. Gündem | NAS'ı hızlandırın, aramayı yalnızca 0,1 saniyede tamamlayın

05. Gündem | Washington Üniversitesi: Görüntü sınıflandırmada ulaşılabilir saldırılara karşı savunma (video yorumlama)

06. Gündem | Grafik sinir ağına dayalı geleneksel, endüktif matris tamamlamanın ötesinde

07. Gündem | Çok ölçekli ifadeyi (video yorumlama) öğrenmek için ızgara hücrelerini kullanarak araştırma için Aydınlanma Ödülü aldı

4. Afiş

01. Afiş | Huawei Noah: Zekice düşünme, NAS ve "yüzleşme" kombinasyonu hızı 11 kat artırıyor

02. Poster | Evrişimin yanı sıra, çok başlı öz-ilgi herhangi bir evrişim işlemini ifade edebilir

03. Poster | NAS çok zor, arama sonuçları rastgele örnekleme ile karşılaştırılabilir! Huawei 6 öneri veriyor

04. Poster | Tsinghua, yorumlanabilirliği öğrenmek için "nöron yürütme ağacını" kullanarak NExT çerçevesini önerdi

05. Poster | Google'ın son araştırması: "Bileşik diverjans" nicel modelle genelleme yeteneğini sentezleyin

06. Poster | Google'ın en iyi NLP ön eğitim modeli BERT'e karşı zafer, açık kaynaktır, tek kartlı eğitim yalnızca 4 gün sürer

07. Poster | FSNet: Evrişim çekirdek özeti kullanılarak derin evrişimli sinir ağlarının sıkıştırılması

08. Poster | "Eşzamanlı Ortalama Öğretim" çerçevesi, denetimsiz öğrenim için daha sağlam sözde etiketler sağlar

09. Poster | Hızlı Sinir Ağı Uyarlanabilir Teknoloji

-

- Bengio ve diğer birçok bilim insanı ortaklaşa üretti: AI'nın güvenilir olmasını sağlamak için bir sistem nasıl tasarlanır?

-

- IJCAI'den uyarı! En iyi kulüpleri doldurmak gittikçe zorlaşıyor ve AI top kulüplerinin toplam işe alma oranı yıllardır düşüyor.

-

- ICLR 2020 | Pekin Üniversitesi Turing Sınıfı tam puan raporu: Hesaplama kısıtlamaları altında faydalı bilgilere dayalı bilgi teorisi

-

- Standart yok, işbirliği yok, üretim ilişkilerini değiştiren çok taraflı bir işbirliği | Federe Öğrenme IEEE Uluslararası Standardı yayımlanmak üzere