Makine öğrenmiyor: Evrişimli sinir ağı NLP modellemesi ve dinamik Havuzlama optimizasyonu

Makine www.jqbxx.com'u öğrenmiyor: Derin toplu makine öğrenimi, derin öğrenme algoritmaları ve teknik mücadele

Bugün DCNN (Dinamik Evrişimli Sinir Ağı) ağ modeli hakkında konuşacağız.Bu modelin inceliği Havuzlama yönteminde yatmaktadır ve bu yöntem Dinamik Havuzlama Yöntemler.

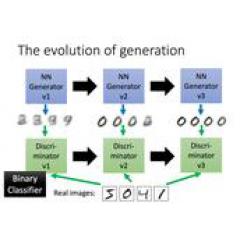

Aşağıdaki şekil, bu modelin cümlelerin anlamsal modelleme sürecidir.Alt katmanın bitişik kelime bilgisini birleştirdiği ve yavaş yavaş yukarı doğru ilettiği ve üst katmanın yeni Cümle bilgisini birleştirdiği, böylece cümle içinde çok uzak olan kelimelerin bile etkileşime girebildiği görülebilir. Davranış (veya bir tür anlamsal bağlantı). Sezgisel bir bakış açısıyla, bu model, kelimelerin kombinasyonu yoluyla (Havuzlama yoluyla) cümlelerde önemli anlamsal bilgileri çıkarabilir. Bir anlamda, hiyerarşik yapı özellik grafiği İşlev, ayrıştırma ağacına benzer.

DCNN, değişken uzunlukta girişi işleyebilir. Ağ iki tür katman içerir, yani Tek boyutlu evrişimli katman ile Dinamik k-max havuzlama katmanı (Dinamik k-max havuzlama) . Bunların arasında, dinamik k-max havuzlama, havuzlamayı maksimize etmenin daha genel bir şeklidir. Daha önce LeCun, CNN'in havuzlama işlemini doğrusal olmayan bir örnekleme yöntemi olarak tanımladı ve maksimum değeri bir grup sayı içinde döndürdü. Orijinal kelimeler aşağıdaki gibidir:

Maksimum havuzlama operatörü, bir dizi değerin maksimumunu döndüren doğrusal olmayan bir alt örnekleme fonksiyonudur (LuCun ve diğerleri, 1998).

Makalede k-max havuzlama yönteminin genelleştirilmesi şu şekilde yansıtılmaktadır:

- Havuzlamanın sonucu maksimum bir değer döndürmez, ancak orijinal girdinin bir alt dizisi olan maksimum değerlerin k grubunu döndürür;

- Havuzlamadaki k parametresi dinamik bir fonksiyon olabilir ve spesifik değer ağın girişine veya diğer parametrelerine bağlıdır;

Model yapısı ve ilkesi

DCNN'nin ağ yapısı aşağıdaki gibidir:

Ağdaki evrişimli katman adı verilen bir yöntem kullanır Geniş Evrişim Yol, ardından dinamik k-max havuzlama katmanı. Orta evrişimli katmanın çıktısı, yani Özellik Haritasının boyutu, giriş cümlesinin uzunluğuna göre değişecektir. Bu işlemlerin belirli ayrıntıları aşağıda açıklanmıştır:

1. Geniş evrişim

Geleneksel evrişim işlemi ile karşılaştırıldığında, geniş evrişimin Özellik Haritası çıktısının genişliği daha geniş olacaktır. Bunun nedeni, evrişim penceresinin tüm giriş değerlerini kapsamasına gerek olmaması veya giriş değerlerinin bir parçası olabilmesidir (bu düşünülebilir Giriş değerinin geri kalanı 0 olduğunda, 0 ile doldurulur). Aşağıda gösterildiği gibi:

Şekilde sağdaki şekil geniş evrişimin hesaplama sürecini göstermektedir İlk düğüm olan s1'i hesaplarken, evrişime katılan s1 düğümünün önünde giriş değeri 0 olan dört düğüm olduğu varsayılabilir (evrişim penceresi 5'tir). Dar anlamda evrişim çıktısının geniş evrişim çıktı sonucunun bir alt kümesi olduğu açıktır.

2. k-max havuzu

Bir k verildiğinde matematiksel bir biçimsel ifade vermek için

k değeri ve bir dizi pRp (burada pk), k-max havuzu, p dizisindeki ilk k maksimum değerleri seçer ve bu maksimum değerler, orijinal dizinin sırasını korur (aslında orijinal dizinin bir alt dizisi) ).

K-max havuzlamasının avantajı, yalnızca cümle içinde daha önemli bilgileri (birden fazla) çıkarması değil, aynı zamanda sipariş bilgilerini de (göreceli konum) tutmasıdır. Aynı zamanda, uygulamanın yalnızca son evrişimli katmanda k değerlerini çıkarması gerektiğinden, bu yöntem farklı uzunluklarda girişlere izin verir (girişin uzunluğu k'den büyük olmalıdır). Bununla birlikte, orta evrişimli katman için, havuzlama parametresi k sabit değildir ve spesifik seçim yöntemi aşağıda açıklanmaktadır.

3. Dinamik k-max havuzu

Dinamik k-max havuzlama işlemi, burada k iki parametrenin bir fonksiyonu, giriş cümle uzunluğu ve ağ derinliği aşağıdaki gibidir:

Nerede

l, mevcut evrişimli katman sayısını (yani, evrişimli katmanların sayısını) temsil eder, L, ağdaki toplam evrişimli katman sayısıdır; ktop, sabit bir değer olan en üst evrişimli katmanın havuzlanmasına karşılık gelen k değeridir. Örneğin, ağda üç evrişimli katman vardır, ktop = 3 ve giriş cümlesi uzunluğu 18'dir; daha sonra, havuzlama parametresi k1 = 12 için birinci evrişimli katman ve ikinci evrişimli katman için K2 = 6 ve k3 = ktop = 3 için.

Dinamik k-max havuzlamanın anlamı, sonraki evrişimli katmanların birliğini sağlamak için farklı uzunluklardaki cümlelerden karşılık gelen miktarda anlamsal özellik bilgisini çıkarmaktır.

4. Doğrusal olmayan karakteristik fonksiyon

Havuzlama katmanı ve bir sonraki evrişimli katman, bazı ağırlık parametreleri çarpılarak ve geleneksel CNN modeliyle aynı olan belirli bir önyargı parametresi eklenerek elde edilir.

5. Çoklu Özellik Haritaları

Geleneksel CNN gibi, çıkarılan özelliklerin çeşitliliğini sağlamak için birden fazla Özellik Haritası önerilecektir.

6. Katlama işlemi (Katlama)

Önceki geniş evrişim, d × s girdi matrisindedir

Hesaplama işlemi, d × s'deki her satırda gerçekleştirilir; burada d, kelime vektörünün boyutudur ve s, giriş cümlesindeki kelimelerin sayısıdır. ve Katlama İşlem, iki bitişik sıra arasındaki belirli bir bağlantıyı göz önünde bulundurmaktır.Yöntem de çok basittir, yani iki sıranın vektörlerini eklemek; bu işlem parametre sayısını artırmaz, ancak önceden dikkate alınır (son tamamen bağlı katmandan önce) Özellik matrisindeki satırlar arasında belirli bir ilişki.

Modelin özellikleri

- Sözcük sırası bilgisini ve cümledeki sözcükler arasındaki göreceli konumu koruyun;

- Geniş evrişimin sonucu, geleneksel evrişimin bir uzantısıdır ve bir anlamda, aynı zamanda n-gramın bir uzantısıdır;

- Model, sözdizimsel bağımlılık ağacı vb. Gibi herhangi bir ön bilgi gerektirmez ve model, cümlede birbirinden çok uzak olan kelimeler arasındaki anlamsal bilgiyi dikkate alır;

Deneysel bölüm

1. Model eğitimi ve parametreler

- Çıktı katmanı, sondan bir önceki katmanla tamamen bağlantılı bir kategori olasılık dağılımıdır (yani softmax);

- Maliyet işlevi çapraz entropidir ve eğitimin amacı maliyet işlevini en aza indirmektir;

- L2 düzenlenmesi;

- Optimizasyon yöntemi: mini-parti + gradyan tabanlı (Adagrad güncelleme kuralı, Duchi ve diğerleri, 2011 kullanılarak)

2. Deneysel sonuçlar

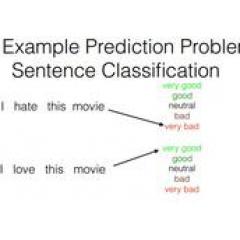

Deneyler, (1) film inceleme veri setinde duygu tanıma, (2) TREC soru sınıflandırması ve (3) Twitter veri setinde duygu tanıma olmak üzere üç veri seti üzerinde gerçekleştirildi. Sonuç aşağıdaki gibidir:

DCNN'nin performansının çok iyi olduğu, neredeyse geleneksel modelden daha düşük olmadığı görülebilir; dahası, DCNN'nin avantajı, önceden herhangi bir bilgi girişi gerektirmemesi ve çok karmaşık yapay özellikler oluşturması gerekmemesidir.

-

- Geçiştirmek? Ortalıkta dolanmak? Ayrık grafik kartına gerek yok APU daha uygundur, 2400 yuan yapılandırma ekranı