Google'ın PlaNet pekiştirmeli öğrenim ağı

Bu makale, orijinal başlığı olan AI Araştırma Enstitüsü tarafından derlenen teknik bir blogdur:

Google'ın yeni PlaNet pekiştirmeli öğrenim ağı hakkında bilmeniz gereken her şey

Yazar | Cecelia Shao

Tercüme | Şalgam sebzeleri ağaç dikiyor

Düzenle | Sos Tavası Armut, Pide

Orijinal bağlantı:

https://towardsdatascience.com/everything-you-need-to-know-about-googles-new-planet-reinforcement-learning-network-144c2ca3f284

Koşmadan önce yürümeyi öğrenin.

Günümüzde transfer öğrenimi, makine öğrenimi topluluğunda çok popüler.

Geçiş öğrenimi, Google, Salesforce, IBM ve Azure bulut hizmeti sağlayıcıları tarafından sağlanan barındırılan AutoML hizmetlerinin temelidir. Şu anda, Google'ın BERT ve ULMFIT'i de dahil olmak üzere en son NLP araştırmasında önemli bir role sahip.

Sebastian'ın blog gönderisinde yazdığı gibi (NLPnin ImageNet anı geldi):

Dünyaca ünlü olan bu çalışmalar, önceden eğitilmiş dil modelleri göstererek çeşitli NLP görevlerinde iyi performans elde etmek içindir. Bu yöntemler bir dönüm noktasını işaretler: önceden eğitilmiş ImageNet modellerinin bilgisayar görüşü üzerindeki etkisi gibi NLP üzerinde geniş bir etkiye sahip olabilirler.

Ayrıca, birden çok görevi yerine getirmek için alanlar arası aktarım öğrenmeyi kullanabilen sinir ağlarının örneklerini görmeye başlıyoruz. Paras Chopra, PyTorch'a dayalı iyi bir öğreticidir, metin açıklamalarına göre görüntüleri arayabilir, benzer görüntüler ve metinler arayabilir ve görüntünün altına bir başlık yazabilirsiniz.

Diğer makine öğrenimi yöntemleriyle karşılaştırıldığında, derin pekiştirmeli öğrenme, az miktarda verisi, öğrenme sürecindeki dengesizliği (Deepmind'ın RL ve sinir ağları hakkındaki makalesine bakın) ve performans gecikmesiyle bilinir. Pekiştirmeli öğrenmenin uygulamasının esas olarak oyunlar veya robotlar olduğunu ve bu senaryoların çok sayıda simülasyon verisi oluşturabildiğini gördük.

Aynı zamanda pek çok insan, pekiştirmeli öğrenmenin hala yapay zeka elde etmenin en uygun yolu olduğuna inanıyor. Bununla birlikte, pekiştirmeli öğrenme, farklı ortamlarda birçok göreve genişletilmekten dirençle karşılaşmaya devam ediyor - bu, zekanın temel bir özelliğidir.

Sonuçta öğrenmek kolay bir iş değil. Bu ortamlar, ilerleme, ödül veya başarı kavramına sahip olmayan veya aşırı derecede gecikmiş yüksek boyutlu algısal girdilere sahip olduğunda, bu pekiştirmeli öğrenme medyası, çevrelerinin etkili bir temsilini işlemeli ve elde etmelidir. En önemlisi, geçmiş deneyimleri yeni durumlarda özetlemek için bu bilgileri kullanmaları gerekir.

Şimdiye kadar, pekiştirmeli öğrenme teknolojisi araştırması esas olarak kişisel görevlerde ustalaşmaya odaklandı. Transfer öğreniminin evrenselliği elde etmek için pekiştirmeli öğrenmeye yardımcı olup olamayacağı sorusuyla çok ilgileniyorum. Bu nedenle, Google AI ekibi bu yılın başlarında Deep Planning Network'ü (PlaNet) yayınladığında çok heyecanlandım.

PlaNet'in arkasında

Bu projede, PlaNet temsilcisinin görevi, kutup dengesi hedefine ulaşmak için bir dizi eylem planlamak, sanal bir varlığa (insan veya çita) yürümeyi öğretmek veya kutuyu belirli bir konuma vurarak dönmesini sağlamaktır.

PlaNet aracılarının gerçekleştirmesi gereken altı göreve genel bakış. Ayrıntılı videoyu görüntülemek için orijinal metne tıklayın

Google AI blog gönderisinde tanıtılan PlaNet'te altı görev (ayrıca görevle ilgili zorluklar):

-

Kartpol Dengesi: Direk dengesinden başlayarak, temsilci, direği dik tutmak için hızlı bir şekilde tanımlamalıdır.

-

Cartpole Swingup: Sabit bir kamera olması durumunda, araba kameradan çıkarılabilir. Bu nedenle, aracı birden çok bilgi çerçevesi edinmeli ve hatırlamalıdır.

-

Parmak Döndürme: iki bağımsız nesneyi ve aralarındaki etkileşimi tahmin edin.

-

Cheetah Run: Doğru tahmin edilmesi zor olan araziyi içerir ve birden çok durumu tahmin edebilen bir model gerektirir.

-

Kupa Yakalama: Sadece top yakalandığında seyrek bir ödül sinyali verilir. Bu, kesin eylem dizilerini planlamak için çok doğru tahminler gerektirir.

-

Walker Walk: Simüle edilmiş robot yerde yatar ve sonra ayağa kalkıp yürümeyi öğrenir.

PlaNet'in şu görevler arasında bazı ortak hedeflere ulaşması gerekir:

-

Temsilcilerin olası tüm gelecekleri tahmin etmesi gerekir

-

Temsilcinin, son operasyonun sonucuna / ödülüne göre planı güncellemesi gerekir

-

Temsilcilerin birçok zaman adımında bilgileri tutması gerekir

Peki, Google AI ekibi bu hedeflere nasıl ulaştı?

PlaNet AI ve gerisi?

PlaNet AI, geleneksel pekiştirmeli öğrenme yöntemlerinden üç farklı şekilde farklılık gösterir:

-

Gizli dinamik model öğrenmeyi kullanın - PlaNet, gizli durumların gelecekteki gelişimini tahmin etmek için görüntüler yerine bir dizi gizli veya örtük durumdan öğrenir.

-

Model tabanlı planlama-PlaNet, stratejik bir ağ olmadan çalışır ve sürekli planlamaya dayalı kararlar alır.

-

Transfer öğrenimi - Google AI ekibi, altı farklı görevi çözmek için bir PlaNet aracısını eğitti.

Bu farklılıkların her birini inceleyelim ve model performansını nasıl etkilediklerini görelim.

# 1 Potansiyel Kinetik Model

Yazarın buradaki ana seçimi, kompakt gizli durumları veya çevreden gelen ham duyusal girdiyi kullanmaktır.

Kompakt bir gizli durum alanının kullanılması, artan zorluk anlamına gelir, çünkü temsilci yalnızca oyunu yenmeyi öğrenmekle kalmaz, aynı zamanda oyunun görsel kavramlarını anlamalıdır - bu da görüntülerin kodlanması ve kodunun çözülmesi için çok fazla hesaplama gerektirir.

Kompakt gizli durum uzayını kullanmanın temel yararı, aracının görüntü üretmeye gerek kalmadan nesnelerin konumu ve hızı gibi daha soyut temsilleri öğrenmesine izin vermesidir. Bu, gerçek planlamanın çok daha hızlı olduğu anlamına gelir çünkü temsilcinin görüntüler veya sahneler yerine yalnızca gelecekteki ödülleri tahmin etmesi gerekir.

Gizli dinamik modelleri artık yaygın olarak kullanılmaktadır çünkü araştırmacılar "gizli dinamik modelini aynı anda eğitmenin ve sağlanan ödülleri birleştirmenin, ödül sinyaliyle ilgili varyasyon faktörlerine duyarlı olan ve eğitim sırasında simüle edilmiş dış faktörlere duyarlı olmayan gizli yerleştirmeler üreteceğine inanmaktadır. . "

Gizli dinamik modeli öğrenmek - kodlayıcı ağı (gri yamuk) doğrudan giriş görüntüsünü kullanmaz, ancak görüntü bilgilerini gizli bir duruma (yeşil daire) sıkıştırır. Bu gizli durumlar daha sonra gelecekteki görüntüyü (mavi yamuk) ve ödülü (mavi dikdörtgen) tahmin etmek için kullanılır.

Orijinal metindeki "Etkili yerleşik takviye öğrenimi için derin otomatik kodlayıcıların kullanımı hakkında" başlıklı makaleyi görüntüleyebilirsiniz.

Otonom gömülü sistemlerde, gerçek dünyadaki eylemler ve öğrenme politikaları için gereken enerjiyi azaltmak genellikle kritiktir. Yüksek boyutlu görüntü temsillerinden eğitim takviye öğrenme aracıları çok zaman alıcı ve pahalı olabilir. Otomatik kodlayıcı, pikselli görüntüler gibi yüksek boyutlu verileri küçük gizli temsillere sıkıştırmak için kullanılan derin bir sinir ağıdır.

# 2 model tabanlı plan ve model içermez

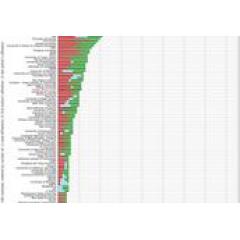

Jonathan Hui'nin tablosu, pekiştirmeli öğrenme yöntemlerinin vaadini gösteriyor

Model tabanlı pekiştirmeli öğrenme, temsilcilerin dünyanın genel davranışını anlamalarına izin vermeye çalışır. Bu, doğrudan gözlem yoluyla eylemlerin haritasını çıkarmak değil, temsilcilerin ileriyi planlamalarına ve uzun vadeli sonuçlarını "hayal ederek" eylemleri daha dikkatli seçmelerine izin vermektir. Model tabanlı yaklaşımın avantajı, örneklerde daha verimli olmasıdır - bu da her yeni görevi sıfırdan öğrenmeyeceği anlamına gelir.

Modelden bağımsız ve model tabanlı pekiştirmeli öğrenme arasındaki farkı görmenin bir yolu, maksimum ödül veya minimum maliyet (modelsiz = maksimum ödül ve model tabanlı = minimum maliyet) için optimize edip etmediğimizi görmektir.

Politika Gradyanlarının kullanımı gibi model içermeyen pekiştirmeli öğrenme teknikleri, sonunda doğru davranışı keşfederek ve onu stratejiye sızarak şiddetli çözümler olabilir. Politika Degradeleri, nihayetinde Politika Degradeleri parametresine son derece ödüllendirici bir eylem vermek için aslında olumlu geri bildirimi kabul etmeli ve sık sık kabul etmelidir.

İlginç bir not, görev türünün kullanmayı seçebileceğiniz yöntemi nasıl etkilediğidir. Andrej Kaparthy'nin "Derin Güçlendirme Öğrenimi: Pikselden Pong" başlıklı yazısında, Politika Gradyanlarının insanları yenebileceği oyunu / görevi şöyle anlattı:

"İnsanları kolayca yenebilecek pek çok oyun Politika Değişimleri vardır. Özellikle, hassas işlem, hızlı yanıt gerektiren ve uzun vadeli planlama gerektirmeyen sık ödül sinyalleri idealdir, çünkü ödüller ve eylemler arasındaki bu kısa vadeli korelasyonlar bu yöntemle kolayca elde edilebilir. "Dikkat edin" ve politikayı çok iyi uygulayabilirsiniz. Bunun gerçekleştiğini Pong temsilcimizde görebilirsiniz: topu bekleyen ve ardından hızlı bir şekilde geri tepen bir strateji geliştirmiştir. Kenarda yakalayın. Top hızla başlayıp hızlı hareket edebilir. Temsilci bu stratejiyi arka arkaya birkaç kez tekrar eder. Deep Q Learning'in bu şekilde insan kıyaslama performansını bozduğu birçok ATARI oyunu vardır - Pinball, Breakout, vb. "

# 3 Transfer öğrenimi

İlk eğitimden sonra, PlaNet temsilcisi yerçekimi ve dinamikler hakkında temel bir anlayışa sahip olur ve bu bilgiyi bir sonraki eğitimde kullanabilir. Bu nedenle, PlaNet'in verimliliği sıfırdan öğrenme yönteminden genellikle 50 kat daha yüksektir. Bu, temsilcinin, dizinin ilerleyişini çok yüksek bir doğrulukla tahmin edebilmesi için animasyonun yalnızca beş karesini (aslında 1/5 saniyelik bir çekim) görüntülemesi gerektiği anlamına gelir. Uygulama açısından bu, ekibin görev güvenilirliğine ulaşmak için altı ayrı model eğitmesine gerek olmadığı anlamına gelir.

Kağıttan: "PlaNet, çeşitli görüntü tabanlı kontrol görevlerini çözer. Performans açısından gelişmiş aracısız modellerle karşılaştırıldığında, ortalama verimlilik% 5000 artar. Bu öğrenme dinamikleri herhangi bir özel görevden bağımsız olabilir, bu nedenle Ortamdaki diğer görevlere geçebilir. "

Sadece 2.000 nesil olan D4PG'de PlaNet'in inanılmaz veri verimliliğine göz atın:

Kağıttan, PlaNet'in tüm görevlerde A3C'den önemli ölçüde daha iyi olduğu ve D4PG'ye yakın nihai performansa ulaştığı, çevre ile etkileşimin ortalama% 5000 azaldığı görülüyor.

Bu testlerin performansı ile toplanan veriler arasındaki grafik (PlaNet mavidir): Lei Feng Wang Lei Feng Wang Lei Feng Wang

Şekil 4, PlaNet'i diğer model algoritmalarıyla karşılaştıran PlaNet makalesinden alınmıştır.

Bu inanılmaz ve heyecan verici sonuçlar, artan veri verimliliği ve pekiştirmeli öğrenmenin evrenselliği için yeni bir çağ anlamına geliyor. Bu alana çok dikkat edin!

Bu makalenin ilgili bağlantılarını ve referanslarını görüntülemeye devam etmek ister misiniz?

Tıklamak Googleın PlaNet Reinforcement Learning Network] şunlara erişmek için:

https://ai.yanxishe.com/page/TextTranslation/1670

[Çevirmen alımı] CMU CS 11-747 İlkbahar 2019 NLP

Carnegie Mellon Üniversitesi'nden başka bir kursun resmi onayını aldığımız ve bu kursu çevirmek için gönüllüleri başarıyla organize ettiğimiz için çok mutluyum.Bu kurs: CMU CS 11-747 Sinir Ağı Doğal Dil İşleme Kursu (2019 Spring), şimdi açık kaynağın en son sürümü.

Çince-İngilizce iki dilli altyazılar Mart ayı başlarında resmen başlatıldı ve şimdi altıncı derse güncellendi!

Eğer ilgileniyorsanız, kurs grubunu görüntülemek için bağlantıya tıklayabilirsiniz:

https://ai.yanxishe.com/page/groupDetail/33

Aynı zamanda, kurs çevirisine kaydolmak istiyorsanız, lütfen altyazıları ekleyin Wechat: leiphonefansub, altyazılar sizi çeviriye başlamak için çevirmen grubuna götürecektir!

-

- Apple kredi kartı Apple Card'ın fiziksel olarak ilk teşhiri; Lei Jun, Xiaomi'nin ilk 5G cep telefonunu ortaya koyuyor; Zuckerberg Facebook'u bölmeyi reddediyor | Lei Feng Morning Post

-

- İngiliz kadın fiziksel ve zihinsel olarak istismara uğradı ve boşanmak istedi ve birikimlerini transfer etti, kocası onu 59 kez bıçaklayarak öldürdü ve onu sevdiğini iddia etti!

-

- 4 yaşındaki karışık ırklı sevimli bebek 4 dili anlıyor ve ebeveynlerinin eğitim konsepti kesinlikle harika!