Makine öğrenmiyor: DQN'den DDPG'ye pekiştirmeli öğrenme (4)

Makine www.jqbxx.com'u öğrenmiyor: Derin toplu makine öğrenimi, derin öğrenme algoritmaları ve teknik mücadele

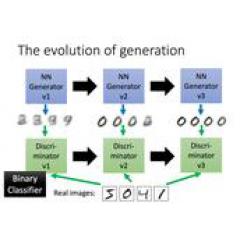

Derin takviye öğrenimi, son zamanlarda çok ilerleme kaydetti ve makine öğrenimi alanında çok fazla ilgi gördü. Geleneksel pekiştirmeli öğrenme, eylem alanının ve örnek alanın çok küçük ve genellikle ayrı olduğu durumlarla sınırlıdır. Bununla birlikte, daha karmaşık ve gerçek duruma daha yakın olan görevler genellikle geniş bir durum alanına ve sürekli bir eylem alanına sahiptir. Uçtan uca kontrolün gerçekleştirilmesi, aynı zamanda, görüntüler ve sesler gibi yüksek boyutlu veri girişlerini işleme yeteneğini de gerektirir. Birkaç yıl önce ortaya çıkmaya başlayan derin öğrenme, sadece yüksek boyutlu girdilerle baş edebilir.İkisi birleştirilebilirse, temsilci hem derin öğrenme anlama yeteneklerine hem de takviye öğrenme karar verme yeteneklerine sahip olacaktır. DeepMind'in DQN'si 2013 ve 2015'te, bu ikisinin başarılı bir kombinasyonunun başlangıcı olarak tanımlanabilir.Değer işlevini temsil etmek için derin bir ağ kullanır, takviye öğrenmede Q-Öğrenime dayalı derin ağ için hedef değerler sağlar ve yakınsamaya kadar ağı sürekli günceller. DQN iki temel teknoloji kullanır; biri örnekler arasındaki korelasyonu kırmak için kullanılan bir örnek havuz, diğeri ise daha iyi eğitim kararlılığı ve yakınsaması olan sabit bir hedef ağdır. DQN, yüksek boyutlu girdiyle başa çıkabilir, ancak yüksek boyutlu eylem çıktısı hakkında hiçbir şey yapamaz. Daha sonra, DeepMind tarafından da önerilen DDPG, yüksek boyutlu veya sürekli eylem alanlarına sahip durumları çözebilir. Eylemler oluşturmak için bir strateji ağı, eylemlerin kalitesini değerlendirmek ve DQN'nin başarılı deneyimlerinden öğrenmek için bir değer ağı içerir.Ayrıca örnek bir havuz ve sabit bir hedef ağ kullanır. Derin bir ağı birleştiren Aktör-Kritik bir yöntemdir. .

Bir, pekiştirmeli öğrenme

Temsilci, yukarıdaki şekilde gösterildiği gibi bir görevi tamamladığında, önce eylem A yoluyla çevreleyen ortamla etkileşime girer. Eylem A eylemi ve ortam altında, aracı yeni bir durum oluşturur ve ortam anında geri dönüş sağlar. Bu döngüde, aracı, çok sayıda veri oluşturmak için sürekli olarak çevre ile etkileşime girer. Takviye öğrenme algoritması, oluşturulan verileri kendi eylem stratejisini değiştirmek için kullanır, çevre ile etkileşime girer, yeni veriler üretir ve yeni verileri kendi davranışını daha da iyileştirmek için kullanır.Birkaç öğrenme yinelemesinden sonra, akıllı vücut nihayet ilgili görevi nasıl tamamlayacağını öğrenebilir. Optimal eylem (optimal strateji). Bu, pekiştirmeli öğrenme sürecidir.

Pekiştirmeli öğrenme, sürekli bir karar verme süreciyle karşı karşıyadır. Bu sorun çerçevesi, yukarıdaki şekilde gösterildiği gibi bir MDP sürecine, Markov karar sürecine dayanmaktadır. Temsilcinin karşılaştığı ortam bir X durum uzayına sahiptir ve aracının kendisinin de bir eylem alanı U vardır. Temsilci, durumun gözlem değeri O bazında kararlar alır. Çevresel dinamik model veya geçiş olasılığı, durumların nasıl dönüştürüldüğünü açıklar ve strateji, temsilcinin nasıl karar verdiğini açıklar.

Yukarıdaki şekilde gösterildiği gibi, pekiştirmeli öğrenme, stratejinin merkez mi yoksa değer fonksiyonunun optimal mi olduğuna, strateji optimizasyon yöntemlerine ve dinamik programlama yöntemlerine göre iki kategoriye ayrılabilir. Bunlar arasında, strateji optimizasyon yöntemleri evrimsel algoritmalara ve strateji gradyan yöntemlerine; dinamik programlama yöntemleri, strateji yineleme algoritmalarına ve değer yineleme algoritmalarına bölünmüştür. Strateji yineleme algoritması ve değer yineleme algoritması, genelleştirilmiş strateji yineleme yöntemi ile tek tip bir şekilde açıklanabilir. Ayrıca, pekiştirmeli öğrenme algoritmaları, stratejinin rastgele olup olmadığına göre deterministik strateji pekiştirmeli öğrenme ve rastgele strateji pekiştirmeli öğrenme olarak ikiye ayrılır. Geçiş olasılığının bilinip bilinmemesine göre model tabanlı pekiştirmeli öğrenme ve modelsiz pekiştirmeli öğrenme algoritmaları olarak ikiye ayrılabilir. Ek olarak, pekiştirmeli öğrenme algoritmasındaki ödül işlevi çok kritiktir.Ödül işlevinin bilinmesine göre, pekiştirmeli öğrenme ve ters pekiştirmeli öğrenme olarak ikiye ayrılabilir. Ters pekiştirmeli öğrenme, uzman gösterisine dayalı olarak ödül işlevini öğrenmektir.

İki, strateji gradyanı

Strateji gradyan yönteminde, strateji parametreleştirmesi, eylemle ilgili strateji fonksiyonunun gradyanının hesaplanması ve optimal stratejiye yaklaşmak için eylemin sürekli olarak ayarlanması olarak ifade edilir. Strateji gradyanı hesaplama formülü, ilgili bilim adamları tarafından türetilmiştir ve iki strateji gradyanı vardır, biri rastgele strateji gradyanı ve diğeri deterministik strateji gradyanıdır.

1. Stokastik politika eğimi:

2. Deterministik strateji gradyanı:

Kanıt, ilgili kağıtlara atıfta bulunabilir. Kısacası, strateji gradyanının sezgisel olarak anlaşılması, strateji fonksiyonunun parametrelerini ayarlamaktır, böylece verilen eylemler daha büyük bir Q değeri elde edebilir.

Actor-Critic yöntemi, çok önemli bir pekiştirme öğrenme algoritması olup, değer işlevine dayalı bir yöntemi ve strateji işlevine dayalı bir yöntemi birleştiren bir zaman serisi fark yöntemidir (TD yöntemi). Bunlar arasında, strateji işlevi eylemi veren aktördür; değer işlevi, aktör tarafından verilen eylemin kalitesini değerlendiren ve değer işlevi ve strateji işlevinin güncellenmesine rehberlik etmek için bir zamanlama farkı sinyali üreten değerlendiricidir (Kritik). Çerçevesi aşağıdaki gibidir:

Bu yöntem derin öğrenme ile birleştirilirse, değer işlevini ve strateji işlevini temsil etmek için iki derin ağ kullanılır. Daha sonra tanıtılan DDPG, böyle bir Actor-Critic mimarisine dayanan derin bir pekiştirmeli öğrenme yöntemidir.

Üç, DQN

DeepMind tarafından 2013 yılında önerilen DQN algoritmasının (DQN'nin geliştirilmiş bir versiyonu 2015 yılında önerilmiştir) derin öğrenme ve pekiştirmeli öğrenmenin ilk başarılı kombinasyonu olduğu söylenebilir. Derin öğrenmeyi pekiştirmeli öğrenmeye entegre etmek istiyorsanız, çözülmesi gereken bazı temel problemler vardır ve bunlardan ikisi aşağıdaki gibidir:

1. Derin öğrenme, çok sayıda etiketli veri örneği gerektirir; pekiştirmeli öğrenme, ajanın aktif olarak örnekleri aldığı yerdir, örnek boyutu seyrek ve gecikmiştir.

2. Derin öğrenme, her bir örneğin bağımsız ve özdeş olarak dağıtılmasını gerektirir ve pekiştirmeli öğrenme ile elde edilen bitişik örneklerin, birbirinden bağımsız değil, birbiriyle ilişkili olması gerekir.

İkisini birleştirmek istiyorsanız, yukarıdaki iki nokta da dahil olmak üzere sorunları çözmelisiniz.

Özellikle, DQN, Q değerini derin bir sinir ağına uydurmanın bir yöntemi olan klasik pekiştirmeli öğrenme algoritması Q-Learning'e dayanmaktadır. Q-Learning algoritması, derin ağın hedef değerini güncellemek için sağlar. Önce Q-Learning'in algoritma akış şemasına bakın:

Temsilci, politika dışı benimser, yani uygulama ve iyileştirme, yöntemlerle elde edilen aynı strateji değildir. Bu şekilde örnekleme ve çevrimiçi güncelleme yoluyla, Q işlevi her örnek toplandığında güncellenir. Güncelleme, zamanlama farkı formülüne dayanmaktadır. Güncellenmiş Q işlevi ile yeni stratejiyi edinin. Bu klasik pekiştirmeli öğrenme algoritmasının sınırlaması, yüksek boyutlu girdiyle baş edememesi ve geniş bir eylem alanına uygulanamaması, özellikle sürekli eylem çıktısına uygulanamamasıdır. DQN'nin yaptığı şey, uçtan uca uygulama için derin bir sinir ağı kullanmak ve yüksek boyutlu veri girişi için derin ağın işleme yeteneklerine tam anlamıyla yer vermektir. 2013 versiyonunun yapısı aşağıdaki gibidir:

2015 yılında geliştirilmiş bir sürüm yayınlandı:

İki temel teknoloji vardır:

1. Örnek havuzu (deneyim yanıtı): Toplanan örnekleri önce örnek havuzuna koyun ve ardından ağ eğitimi için örnek havuzundan rastgele bir örnek seçin. Bu işlem numuneler arasındaki ilişkiyi kırar ve onları birbirinden bağımsız kılar.

2. Sabit Q-hedef ağı: Ağ hedef değerini hesaplamak için mevcut Q değeri gereklidir ve bu Q değerini sağlamak için daha yavaş bir güncelleme ağı kullanılır. Bu, eğitimin istikrarını ve yakınsamasını geliştirir.

Dört, DDPG

DQN, değer işlevine dayalı bir yöntemdir.Değer işlevine dayalı yöntemin, geniş eylem alanıyla, özellikle de sürekli eylemle başa çıkmak zordur. Çünkü ağın bu kadar çok çıktıya sahip olması zordur ve bu kadar çok çıktı arasında en büyük Q değerini aramak zordur. DDPG, yukarıda bahsedilen Actor-Critic yöntemine dayanmaktadır Eylem çıktısı açısından, strateji işlevine ve doğrudan çıktı eylemlerine uymak için bir ağ kullanılır, bu da sürekli eylemlerin çıktıları ve geniş eylem alanları ile baş edebilir.

Acror-Critic yapısını tekrar gözden geçirelim. Aşağıda gösterildiği gibi:

Yapı iki ağ içerir, bir politika ağı (Aktör) ve bir değer ağı (Kritik). Strateji ağı eylemleri üretir ve değer ağı eylemleri yargılar. Her ikisinin de kendi güncelleme bilgileri vardır. Strateji ağı, gradyan hesaplama formülü ile güncellenir ve değer ağı, hedef değere göre güncellenir.

DDPG, DQN'nin başarılı deneyimini kullanır. Yani, örnek havuzu ve sabit hedef değer ağı olmak üzere iki teknoloji kullanılmaktadır. Yani, iki ağın her birinin daha yavaş değişen bir kopyası vardır ve daha yavaş değişen ağ, güncellenmiş bilgilerde gerekli olan bazı değerleri sağlar. DDPG'nin genel yapısı aşağıdaki gibidir:

DDPG yöntemi, derin öğrenme ve pekiştirmeli öğrenmenin başka bir başarılı kombinasyonudur ve derin pekiştirmeli öğrenmenin geliştirilmesinde çok önemli bir araştırma sonucudur. Yüksek boyutlu girdilerle başa çıkabilir, uçtan uca kontrolü gerçekleştirebilir ve sürekli eylemler çıkarabilir, böylece derin pekiştirmeli öğrenme yöntemi, geniş eylem alanları ve sürekli eylem alanlarıyla daha karmaşık durumlara uygulanabilir.

Referanslar:

Silver D, Lever G, Heess N, et al. Deterministic Policy Gradient

Algorithms // International Conference on Machine Learning.2014: 387-395.

Mnih V, Kavukcuoglu K, Silver D, et al. Aracılığıyla insan düzeyinde kontrol

derin pekiştirmeli öğrenme .. Nature, 2015, 518 (7540): 529.

Mnih V, Kavukcuoglu K, Silver D, et al.

Pekiştirmeli Öğrenme, Bilgisayar Bilimleri, 2013.

Lillicrap T P, Hunt J J, Pritzel A, ve diğerleri.Derin ile sürekli kontrol

pekiştirmeli öğrenme Bilgisayar Bilimleri, 2015, 8 (6): A187.

-

- Yeni ve eski Seagate sabit disklerinin görünümünü karşılaştırdığımda, önceki sabit disklerin daha güvenilir olduğunu düşünüyorum

-

- Makineler öğrenmez: Bir makale her türden derin öğrenme ağını anlar ve derin öğrenme de aynen bunun gibidir ...