Makineler öğrenmez: Bir makale her türden derin öğrenme ağını anlar ve derin öğrenme de aynen bunun gibidir ...

Makine www.jqbxx.com'u öğrenmiyor: Derin toplu makine öğrenimi, derin öğrenme algoritmaları ve teknik mücadele

Zaman zaman yeni sinir ağı mimarilerinin ortaya çıkmasıyla birlikte, tüm ağı izlemek zaten zor. Her türlü kısaltmayı (DCIGN, BiLSTM, DCGAN ...) aynı anda görürseniz, bu gerçekten insanları biraz bunalmış hissettiriyor.

Bu amaçla, Fjodor Van Veen çok sayıda mimari (esas olarak sinir ağları) içeren bir envanter makalesi yazdı ve açıklama için sezgisel bir diyagram çizdi.

Bu mimarileri düğüm grafikleri olarak çizmenin bir sorunu: Bu mimarilerin nasıl çalıştığını gerçekten göstermiyor. Örneğin, değişken otomatik kodlayıcı (VAE), otomatik kodlayıcı (AE) ile aynı görünebilir, ancak eğitim süreci oldukça farklıdır. Eğitimli ağın kullanım durumları arasındaki fark daha da büyüktür, çünkü VAE bir jeneratördür ve yeni örnekler almak için ona gürültü ekleyebilirsiniz; AE ise girdisini "hatırlamak" ile eşler "En yakın eğitim örneği. Bu nedenle vurgulanmalıdır: Bu genel bakıştaki farklı düğüm yapıları, bu yapıların iç işleyişini yansıtmaz.

Aslında tam bir liste yapmak imkansız çünkü sürekli yeni mimariler ortaya çıkıyor. Yayınlanmış olsalar bile onları bulmamız zor olabilir ve bazen bilinçsizce bazılarını görmezden geleceğiz. Dolayısıyla, bu liste size yapay zeka dünyasına ilişkin bazı bilgiler sunsa da, lütfen bu listenin kapsamlı olduğunu düşünmeyin; özellikle bu makale yazıldıktan çok sonra okursanız (Not: Orijinal makale 14 Eylül 2016'da yayınlandı).

Bu makaledeki resimlerde tasvir edilen mimari için yazar çok, çok kısa bir açıklama yazmıştır. Bu mimarilerden bazılarına aşina iseniz ancak diğerlerine aşina değilseniz, bu talimatları yararlı bulabilirsiniz.

İleri beslemeli sinir ağı (FF veya FFNN: İleri Beslemeli sinir ağları) çok basittir: bilgileri önden arkaya (girişten çıkışa) beslerler. Sinir ağları genellikle, katmanların girdi, gizli veya çıktı katmanları olabildiği hiyerarşik formlar olarak tanımlanır. Tek bir katmanda bağlantı yoktur ve genellikle iki bitişik katman tamamen bağlıdır (bir katmandaki her nöron diğer katmandaki her nörona bağlıdır). Bunlar arasında, en basit gerçek ağın mantık kapılarını modellemek için kullanılabilecek iki giriş birimi ve bir çıkış birimi olduğu söylenebilir. İnsanlar FFNN'yi eğitmek için genellikle geri yayılımı kullanırlar, böylece ağ eşleştirilmiş bir veri seti - "girdi içeriği" ve "çıktı almak istiyoruz" elde eder. Buna denetimli öğrenme denir ve bunun tersi yönteme denetimsiz öğrenme denir; burada yalnızca girdiyi vermemiz ve ağın boşlukları kendi kendine doldurmasına izin vermemiz gerekir. Geriye yayılmış hata genellikle girdi ve çıktı arasındaki farkın bir varyasyonudur (MSE veya sadece doğrusal fark gibi). Ağda yeterince gizli nöron varsa, teorik olarak her zaman girdi ve çıktı arasındaki ilişkiyi modelleyebilir. Aslında, kullanımlarının büyük sınırlamaları vardır, ancak genellikle yeni ağlar oluşturmak için diğer ağlarla birlikte kullanılırlar.

Radyal temel işlevi (RBF: Radyal temel işlevi) Ağ, etkinleştirme işlevi olarak radyal temel işlevi kullanan bir FFNN'dir. Başka hiçbir şey. Ancak bu, işe yaramaz olduğu anlamına gelmez, ancak diğer aktivasyon işlevlerine sahip çoğu FFNN'nin kendi özel adı yoktur. Bunun temel nedeni, insanların onu doğru zamanda icat etmesidir.

Hopfield Ağı (HN: Hopfield Ağı), her nöronun diğer her nörona bağlı olduğu bir ağdır; tüm düğümlerin tamamen işlevsel olduğu, tamamen dolaşık bir spagetti. Eğitimden önce her düğüm bir girdidir; eğitim sırasında her düğüm gizlenir; ondan sonra hepsi çıktıdır. Bu tür bir ağın eğitimi, nöronun değerini, ağırlığı hesaplamak istediğimiz moda ayarlamaktır. Ağırlık daha sonra değişmeyecektir. Bir veya daha fazla mod için eğitildikten sonra, bu ağ her zaman öğrenmiş olduğu bir moda yakınlaşacaktır, çünkü bu ağ yalnızca bu durumlarda kararlı olabilir. Lütfen bunun beklenen durumda olmadığını unutmayın (ne yazık ki sihirli bir kara kutu değil). Ağın toplam "enerjisi" veya "sıcaklığı" eğitim sırasında kademeli olarak azalacağından, her zaman parça parça stabilize olacaktır. Her nöronun bu sıcaklığa kadar uzatılabilen bir aktivasyon eşiği vardır ve eğer nöronun girişinin toplamı bu eşiği aşarsa, giriş nöronun iki durumdan (genellikle -1 veya 1, bazen 0 veya 1'den birini seçin). Ağın güncellenmesi eşzamanlı olarak yapılabilir, ancak nöronların tek tek güncellenmesi daha yaygındır. Tek tek güncellenirse, hangi birimlerin hangi sırayla güncellendiğini düzenlemek için adil bir rastgele sıra oluşturulur (adil rastgele, tüm (n) seçimlerin her n öğede tam olarak bir kez gerçekleştiği anlamına gelir. ). Bu şekilde, ağın ne zaman kararlılığa ulaştığını (yakınsama tamamlandı) anlayabilirsiniz: her birim, herhangi bir değişiklik olmaksızın güncellendiğinde, ağ kararlıdır (yani tavlanır). Bu ağlara genellikle ilişkisel bellek (ilişkisel bellek) adı verilir, çünkü girdiye en çok benzeyen duruma yakınlaşırlar; insanlar, bu ağa yarım masa sağlarsanız, benzer şekilde yarım masa gördüklerinde diğer yarısını hayal edebilirler. Ve gürültünün yarısı, o zaman ağ bir masaya yakınlaşabilir.

Markov zinciri (MC: Markov Zinciri) veya ayrık zamanlı Markov Zinciri (DTMC: ayrık zamanlı Markov Zinciri), BM ve HN'nin öncülüdür. Şu şekilde anlaşılabilir: Şu anda bulunduğum düğümden başlayarak, çevremdeki herhangi bir düğüme ulaşma olasılığı nedir? Bunlar hafızasızdır (yani, Markov Mülkiyeti), bu da elde ettiğiniz her durumun tamamen önceki duruma bağlı olduğu anlamına gelir. Sinir ağları olmamalarına rağmen, sinir ağlarına benzerler ve BM ve HN için teorik temel sağlarlar.

Boltzmann makinesi (BM: Boltzmann makineleri) HN'ye çok benzer, ancak bazı nöronlar giriş nöronları olarak işaretlenirken diğerleri hala "gizli" durumdadır. Bu giriş sinir ağları, tüm ağ güncellendiğinde çıkış nöronları haline gelecektir. Rastgele ağırlıklarla başlar ve sonra geri yayılım yoluyla öğrenir Son zamanlarda, bazı insanlar kontrast sapma yöntemini kullandılar (iki bilgi kazancı arasındaki gradyanı belirlemek için bir Markov zinciri kullanarak). HN ile karşılaştırıldığında, BM nöronları bazen ikili aktivasyon modellerine sahiptir, ancak diğer zamanlarda rastgele olurlar: bir birimin belirli bir durumda olma olasılığı. BM'nin eğitim ve çalıştırma süreci HN'ye çok benzer: önce giriş nöronları için belirli sabitlenmiş değerler ayarlayın ve ardından ağ serbesttir (harici kuvvet gerekmez). Özgür olduktan sonra, bu birimler herhangi bir değer alabilir ve sonra girdi ve gizli nöronlar arasında gidip geliriz. Sonunda doğru sıcaklıkta dengeye ulaşacaktır.

Kısıtlı Boltzmann makinesi (RBM: Sınırlandırılmış Boltzmann makineleri) BM'ye benzer (şaşırtıcı değil), bu nedenle HN'ye de benzer. BM ve RBM arasındaki en büyük fark, RBM'nin daha kısıtlı olmasıdır, bu nedenle daha iyi kullanılabilir. Her nöronu diğer her nörona bağlamazlar, ancak yalnızca her bir farklı nöron grubunu diğer gruplara bağlarlar, böylece giriş nöronları doğrudan diğer giriş nöronlarına bağlanmaz ve gizlenir. Nöronlar arasında da bir bağlantı yoktur. RBM, FFNN'ye benzer bir şekilde eğitilebilir, ancak bir fark vardır: Veriyi ileri iletmek ve hatayı geri yaymak yerine, verileri ileri iletir ve sonra verileri geri gönderir (ilk katmana geri). Bundan sonra, eğitim için ileri ve geri yayılımı kullanın.

Otomatik kodlayıcı (AE: Otomatik kodlayıcılar) FFNN'ye benzer, çünkü AE, temelde farklı bir mimariden çok FFNN'nin kullanılmayan bir kullanım durumuna benzer. Bir otomatik kodlayıcının arkasındaki temel fikir, bilgileri, dolayısıyla adını otomatik olarak kodlamaktır. Ağın tamamı kum saatine benzer bir şekle sahiptir - gizli katmanı giriş ve çıkış katmanlarından daha küçüktür. AE ayrıca orta katman etrafında simetriktir (katman sayısına göre tek veya çift, orta katman 1 veya 2 katmana sahiptir). En küçük katman her zaman ortadadır ve burada bilgi en çok sıkıştırılır (ağın dar noktası). Ortadaki tüm bölümlere kodlama bölümü, orta bölümün altındaki tüm bölümlere kod çözme bölümü ve orta bölüme kod adı verilir. Girdiyi besleyerek ve hatayı girdi ile çıktı arasındaki fark olarak ayarlayarak onları eğitmek için geri yayılım kullanılabilir. Ağırlık söz konusu olduğunda, AE simetrik olarak da oluşturulabilir, bu nedenle kodlama ağırlığı, kod çözme ağırlığı ile aynıdır.

Seyrek otomatik kodlayıcı (SAE: Seyrek otomatik kodlayıcılar) bir dereceye kadar AE'nin tersidir. Bir ağa bazı verileri daha az "boşlukta" veya düğümlerde temsil etmeyi öğretmek yerine, bilgileri daha fazla alanda kodlamaya çalışıyoruz. Böylece ağın ortada birleşip tekrar giriş boyutuna genişlemesi yerine, ortadaki içeriği doğrudan ortadan kaldırdık. Bu tür ağlar, veri kümesinden birçok küçük özelliği çıkarmak için kullanılabilir. Bir SAE'yi AE'ye benzer şekilde eğitirsek, hemen hemen tüm durumlarda yalnızca oldukça yararsız bir kimlik ağı elde edersiniz (girdi, herhangi bir dönüştürme veya ayrıştırma olmaksızın çıktıdır). Bu durumu önlemek için girişi geri besleme yapmıyoruz, fakat geri besleme girişi artı bir seyreklik sürücüsü. Bu seyrek sürücü, yalnızca belirli bir hatanın geri yayılacağı ve eğitileceği bir eşik filtresi biçiminde olabilir. Bu geçiş sırasında, diğer hatalar "alakasız" olacak ve 0 olarak ayarlanacaktır. . Bir bakıma, bu, tüm nöronların her zaman ateşlemediği (ve biyolojik rasyonellik için puanlar verdiği) sinir ağlarının çoğalmasına benzer.

Kodlayıcıdan değiştir (VAE: Varyasyonel otomatik kodlayıcılar) AE ile aynı mimariye sahiptir, ancak farklı bir şey "öğretilmiştir": giriş örneklerinin yaklaşık bir olasılık dağılımı. Bu biraz kökene geri dönüyor, çünkü bunlar BM ve RBM ile daha yakından ilişkili. Ancak olasılıksal çıkarım ve bağımsızlıkla başa çıkmak için Bayes matematiğine ve bu farklı temsili elde etmek için yeniden parametreleştirmeye güveniyorlar. Bu tür akıl yürütme ve bağımsız bileşenlerin anlaşılması sezgiseldir, ancak aşağı yukarı karmaşık matematiğe güvenirler. Temel, şu şekilde özetlenebilir: etki dikkate alınarak. Bir yerde bir şey olursa ve başka yerlerde başka şeyler olursa, bunlar ille de ilişkili değildir. İlişkili değillerse, hata yayma bunu dikkate almalıdır. Bu yararlı bir yöntemdir, çünkü sinir ağı büyük bir grafiktir (belirli bir açıdan), bu nedenle daha derin katmanlara giderken bazı düğümlerin diğer düğümler üzerindeki etkisini dışlamak yardımcı olacaktır. .

Otomatik kodlayıcıyı yok etme (DAE: otomatik kodlayıcıları denoising), yalnızca verileri değil aynı zamanda gürültüyü de (görüntüyü daha grenli yapmak gibi) içeren bir otomatik kodlayıcıdır. Ancak hatayı aynı şekilde hesaplıyoruz, böylece ağın çıktısı gürültüsüz orijinal girişle karşılaştırılıyor. Bu, ağın ayrıntıları öğrenmesine değil, daha geniş özellikleri öğrenmesine izin verir, çünkü daha küçük özellikleri öğrenmek genellikle "yanlış" olur çünkü daha küçük özellikler gürültüyle değişmeye devam eder.

Derin inanç ağı (DBN: derin inanç ağları) temelde RBM veya VAE'nin yığılmış bir mimarisidir. Gerçekler, bu ağların verimli bir şekilde istiflenip eğitilebileceğini ve her bir AE veya REM'nin yalnızca önceki ağı kodlaması gerektiğini kanıtladı. Bu teknik aynı zamanda açgözlü eğitim olarak da bilinir; burada açgözlülük, makul ancak muhtemelen optimal olmayan bir yanıt almak için yerel olarak en uygun çözümü elde etmeyi ifade eder. DBN, kontrast sapması veya geri yayılımın yanı sıra verileri sıradan RBM veya VAE gibi olasılıklı bir model olarak temsil etmeyi öğrenerek eğitilebilir. Denetimsiz öğrenme yoluyla eğitildikten veya (daha) kararlı bir duruma dönüştürüldükten sonra, model yeni veriler oluşturmak için kullanılabilir. Eğitim için kontrast sapması kullanırsanız, mevcut verileri sınıflandırabilir, çünkü nöronları farklı özellikler bulmayı öğrenmiştir.

Evrişimli Sinir Ağı (CNN: evrişimli sinir ağları) veya derin evrişimli sinir ağları (DCNN: derin evrişimli sinir ağları) diğer ağların çoğundan çok farklıdır. Esas olarak görüntü işleme için kullanılırlar, ancak ses gibi diğer giriş türlerine de uygulanabilir. CNN'nin tipik bir kullanım durumu, ağın girdi görüntülerini sınıflandırmasına izin vermektir, örneğin, girdi görüntüsünde bir kedi olduğunda "kedi" çıktı ve bir köpek olduğunda "köpek" çıktı. CNN genellikle amacı tüm eğitim verilerini bir kerede ayrıştırmak olmayan bir girdi "tarayıcısı" ile başlar. Örneğin, 200 × 200 piksellik bir görüntü girmek için 40.000 düğümlü bir katmana ihtiyacınız yoktur. Aslında, görüntünün 20 × 20 piksellik bir kısmından (genellikle sol üst köşeden) giriş yapmaya başlayabilmeniz için yalnızca 20 × 20'lik bir tarama giriş katmanı oluşturmanız gerekir; bu giriş tamamlandığında ( Eğitim için kullanılabilir), sonraki 20 × 20 pikseli girersiniz: tarayıcıyı 1 pikseli sağa hareket ettirin. İnsanların bir seferde 20 pikseli (tarayıcının genişliğini) hareket ettirmediklerini veya görüntüyü 20 × 20 bloklara ayırmadıklarını, bunun yerine tarayıcının görüntü üzerinde "gezinmesine" izin verdiklerini unutmayın. Daha sonra bu girdi verileri, tüm düğümlerin tüm düğümlere bağlı olmadığı sıradan katmanlardan farklı olan evrişimli katmanlara (evrişimli katmanlar) gönderilir. Her bir düğüm kendisini yalnızca komşularına bağlar (ne kadar yakın olduğu belirli uygulamaya bağlıdır, ancak genellikle birazdan fazla). Bu evrişimli katmanlar, ağ derinleştikçe ve derinleştikçe küçülme eğilimindedir ve bunların çoğu, girdiyle kolayca bölünebilen faktörlerdir (yani 20'den sonraki katman 10, ardından 5 olabilir). 2'nin yetkileri bu konuda sıklıkla kullanılır çünkü 32, 16, 8, 4, 2, 1 gibi tanımlarla tamamen bölünebilir. Bu evrişimli katmanlara ek olarak, genellikle bir havuz katmanına sahiptirler. Havuzlama, ayrıntıları filtrelemek için bir yöntemdir: ortak bir havuzlama tekniği, örneğin 2 × 2 piksel aldığımız ve daha sonra bu pikselleri maksimum kırmızı miktarına göre geçirdiğimiz maksimum havuzlamadır. CNN'yi sese uygulamak için, temelde ses dalgalarını girer ve ardından ses bölümünü tek tek yavaşça hareket ettirir. CNN'nin gerçek dünya uygulaması, son derece doğrusal olmayan soyutlama elde edebilen verileri daha fazla işlemek için genellikle sonunda bir FFNN'yi birbirine bağlar. Böyle bir ağa DCNN adı verilir, ancak ikisinin adları ve kısaltmaları genellikle karıştırılabilir.

Evrişimsiz Sinir Ağı Ters grafik ağları (IGN: ters grafik ağları) olarak da bilinen (DNN: Ters evrişimli sinir ağları), ters evrişimli bir sinir ağıdır. Örneğin, ağa bir "kedi" kelimesi girin ve ardından onu kedi benzeri bir görüntü oluşturması için eğitin (gerçek bir kedi resmiyle karşılaştırarak). Sıradan CNN gibi, DNN de FFNN ile birlikte kullanılabilir, ancak bu tür bir ağı kısaltmayacağız. Buna derin bir ters evrişim olmayan sinir ağı diyebiliriz, ancak FFNN'yi DNN'nin hem ön hem de arka uçlarına bağladığınızda, elde ettiğiniz mimarinin yeni bir adı olması gerektiğini de düşünebilirsiniz. Lütfen çoğu uygulamada, insanların ağa metin benzeri girdi göndermediğini, bunun yerine ikili sınıflandırma girdi vektörünü gönderdiklerini unutmayın. Örneğin, varsayalım < 0, 1 > Bir kedi, < 1, 0 > Bir köpek mi, < 1, 1 > Kediler ve köpekler. CNN'deki ortak havuz katmanının yerini, genellikle enterpolasyon ve ekstrapolasyon için önyargılı varsayımlar kullanan benzer ters işlemlerle değiştirilir (bir havuz katmanı maksimum havuzlamayı kullanıyorsa, Ters işlem, daha az özgüllükle yeni veriler üretir).

Derin Evrişimli Ters Grafik Ağı (DCIGN: Derin evrişimli ters grafik ağları) isimleri yanıltıcıdır, çünkü bunlar aslında VAE'dir, ancak kodlayıcı ve kod çözücü olarak sırasıyla CNN ve DNN vardır. Bu ağlar, kodlamadaki olasılıklar olarak özellikleri modellemeye çalışır, böylece kedi ve köpekleri ayrı ayrı gördüklerinde hem kedi hem de köpeklerle resim üretmeyi öğrenebilir. Benzer şekilde, ona kedi ve köpeklerin bir resmini girebilir ve ağdan, bunu daha önce hiç yapmamış olsanız bile, resimdeki köpeği kaldırmasını isteyebilirsiniz. Gösteriler, bu ağların, ışık kaynağının değiştirilmesi veya bir 3D hedefin dönüşü gibi model resimlerdeki karmaşık değişiklikleri de öğrenebileceğini göstermiştir. Bu ağlar genellikle geri yayılım yoluyla eğitilir.

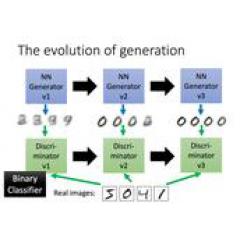

Üretken yüzleşme ağı (GAN: Üretken rakip ağlar) farklı ağ türlerinden türetilmiştir, bunlar ikizlerdir: iki ağ birlikte çalışır. GAN, herhangi iki tür ağı içerir (genellikle FF ve CNN olmasına rağmen), bir ağ içerik oluşturmak için, diğeri ise içeriği değerlendirmek için kullanılır. Ayrımcı ağ, ya eğitim verilerini alır ya da oluşturulan ağdan içerik alır. Yargı ağının veri kaynağını doğru bir şekilde tahmin edebilme derecesi, daha sonra oluşturulan ağın hatası olarak kullanılır. Bu bir rekabet yolu yaratır Ayırıcı, gerçek verileri üretilen verilerden ayırt etmede gittikçe daha iyi hale geliyor ve oluşturucu, ayırıcı için gittikçe daha öngörülemez hale geliyor. Bunun iyi çalışmasının nedenlerinden biri, oldukça karmaşık gürültü benzeri modellerin bile nihayetinde tahmin edilebilir olmasıdır, ancak giriş verilerine benzer oluşturulan içeriği ayırt etmeyi öğrenmenin daha zor olmasıdır. GAN'ı eğitmek oldukça zordur, çünkü yalnızca iki ağı eğitmeye ihtiyaç duymaz (her biri kendi sorunlarını çözer), iki ağın dinamikleri de iyi dengelenmelidir. Tahmin veya üretim diğerinden daha iyiyse, GAN yakınlaşmayacaktır çünkü içsel farklılıklar vardır.

Tekrarlayan sinir ağı (RNN: Tekrarlayan sinir ağları), geçici bağlantıları olan FFNN'lerdir: vatansız değildirler, zamanla değişirler ve yollar ile bağlantılar arasında bağlantıları vardır. Nöronlar sadece önceki katmanlardan bilgi almazlar, aynı zamanda kendi önceki geçişlerinden de bilgi alırlar. Bu, bilgiyi girdiğiniz ve ağı eğittiğiniz sıranın önemli olduğu anlamına gelir: "süt" ve ardından "tatlılar" girmek, "tatlılar" ve ardından "süt" girmekten farklı sonuçlar verebilir. RNN'nin önemli bir problemi, kullanılan aktivasyon fonksiyonuna bağlı olan gradyan kaybolması (veya patlama) problemidir.Tıpkı derinlik değişiklikleri ile çok derin bir FFNN'nin kaybolması gibi, bilgi zamanla yavaş yavaş kaybolur. Sezgisel olarak bu büyük bir sorun gibi görünmüyor, çünkü bunlar sadece ağırlıklardır, nöron durumları değil, zamanla değişen ağırlıklar geçmiş bilgilerin depolanmasından gelir. Ağırlık 0 veya 1.000.000 değerine ulaşırsa, önceki durum artık bilgilendirici değildir. RNN teoride birçok alanda kullanılabilir, çünkü çoğu veri formunda zaman çizelgesi değişikliği yoktur (yani ses ve videodan farklı olarak), bu nedenle zamana bağlı ağırlıklar diziden önceki şeyler için kullanılır, kaç saniye önce değil Ne oldu. Genel olarak döngüsel ağlar, otomatik tamamlama görevleri gibi bilgileri geliştirmek veya mükemmelleştirmek için daha iyi bir seçimdir.

Uzun kısa süreli hafıza ağı (LSTM: Uzun / kısa süreli bellek) kapılar ve açıkça tanımlanmış bellek birimleri getirerek gradyanların kaybolmasıyla (patlaması) mücadele etmeye çalışır. Bu fikir biyolojik kavramlardan çok devre şemalarından esinlenmiştir.Her nöronun bir bellek birimi ve üç kapısı vardır: girdi, çıktı, unutma (girdi, çıktı, unut). Bu kapıların işlevi, dolaşımlarını yasaklayarak veya izin vererek bilgi sağlamaktır. Giriş kapısı, birim tarafından üst katmandan ne kadar bilgi saklanacağını belirler. Çıktı katmanı diğer uçta da aynısını yapar ve sonraki katmanın hücrenin durumunu ne kadar anladığına karar verir. Unutulan kapı tuhaf bir şeye benziyor ama bazen unutulmak daha iyidir. Deneyler, LSTM'nin Shakespeare gibi yazmak veya senfoniler yaratmak gibi karmaşık dizileri öğrenebileceğini göstermiştir. Her kapının önceki nöronda bir ağırlığı olduğunu ve bu nedenle çalışması için daha fazla kaynak gerektirdiğini unutmayın.

Kapı döngüsü ünitesi (GRU: Geçitli Tekrarlayan Birimler), LSTM'nin hafif bir çeşididir. Bir geçitleri vardır ve kablolama biraz farklıdır: giriş, çıkış veya unutma geçidi yoktur, bir güncelleme geçitleri vardır. Güncelleme geçidi yalnızca önceki durumdan ne kadar bilginin tutulacağını belirlemekle kalmaz, aynı zamanda önceki katmandan ne kadar bilginin girmesine izin verileceğini de belirler. Kapı sıfırlama işlevi, LSTM'deki kapı unut işlevine çok benzer, ancak konum biraz farklıdır. GRU geçit fonksiyonları her zaman tüm durumları gönderir, bir çıkış geçitleri yoktur. Çoğu durumda, işlevleri LSTM'ye benzer. En büyük fark, GRU'nun daha hızlı ve daha kolay çalıştırılmasıdır (ancak aynı zamanda daha az anlamlı). Uygulamada, birbirleri arasında bir denge olabilir. Daha fazla ifade gücüne sahip geniş bir ağa ihtiyacınız olduğunda, performans kazanımlarını dikkate almak isteyebilirsiniz. Bazı durumlarda, ekstra ifade gücüne artık ihtiyaç duyulmayabilir ve GRU, LSTM'den daha iyidir.

Nöral Turing Makinesi (NTM: Nöral Turing makineleri), LSTM'nin bir soyutlaması ve sinir ağını kara kutuya alma girişimi olarak anlaşılabilir (kara kutuyu kaldırın, içeride neler olup bittiğini anlamamıza izin verin.) Yuanzhong'da, içindeki hafıza ayrılmıştır. Bu tür bir ağ, geleneksel dijital depolamanın etkinliğini sinir ağlarının kalıcılığı ve verimliliği ve ifade gücü ile birleştirmeye çalışır. Bu tür bir ağın amacı, sinir ağının doğrudan okuyup yazabildiği, içerik adresli bir bellek bankasına sahip olmaktır. NTM'deki "Turing" tam Turing'den gelir: okuduğu şeye bağlı olarak durumu okuma, yazma ve değiştirme yeteneği, genel bir Turing makinesinin ifade edebileceği her şeyi ifade edebileceği anlamına gelir.

Çift yönlü tekrarlayan sinir ağı (BiRNN: Çift yönlü tekrarlayan sinir ağları) , İki yönlü uzun kısa süreli bellek ağı (BiLSTM: çift yönlü uzun / kısa süreli bellek ağları) ve İki yönlü geçitli döngü birimi (BiGRU: çift yönlü kapılı tekrarlayan birimler), tek yönlü yapılarıyla aynı göründükleri için kelime dağarcığında gösterilmez. Aradaki fark, bu ağların sadece geçmişi değil, aynı zamanda geleceği de bağlamalarıdır. Örneğin, tek yönlü LSTM, balık kelimesini tek tek girerek balıkları tahmin etmek için eğitilir, burada döngü bağlantısı zaman içindeki son değeri hatırlar. Ve bir BiLSTM geriye doğru geçiş sırasındaki bir sonraki kelimeyi girerek geleceğe bilgi verir. Bu, ağı tahmin bilgisi yerine boşlukları doldurması için eğitir, yani görüntüdeki görüntünün sınırlarını genişletmez, ancak bir resimdeki boşlukları doldurabilir.

Derin artık ağ (DRN: Derin artık ağlar), girişi bir katmandan sonraki birkaç katmana (genellikle 2 ila 5 katman) geçirmek için ek bağlantılara sahip çok derin bir FFNN ağıdır. DRN, bazı girdileri (5 katmanlı bir ağ gibi) çıktılara eşlemek için çözümler keşfetmek değil, bazı girdileri bazı çıktılara + girdilere eşlemeyi öğrenmekle ilgilidir. Genel olarak, eski girdiyi sonraki katmanlar için yeni girdi olarak taşıyan çözüme bir kimlik işlevi ekler. Sonuçlar, 150'den fazla katmandan sonra, bu ağların geleneksel 2 ila 5 katmandan çok daha fazla olan öğrenme modunda çok iyi olduğunu gösteriyor. Bununla birlikte, bu ağların aslında sadece belirli bir zamana dayalı olmayan RNN'ler olduğunu kanıtlayan sonuçlar vardır ve bunlar her zaman kapıları olmayan LSTM'lerle karşılaştırılır.

Yankı durumu ağı (ESN: Yankı durumu ağları) başka bir farklı ağ türüdür. Diğer ağlardan farklıdır çünkü farklı nöronlar arasında rastgele bağlantıları vardır (yani katmanlar arasında düzgün bir şekilde bağlanmamışlardır) ve farklı şekillerde eğitilirler. Bu tür bir ağda, bilgi girişi yapmak ve hatayı diğer ağlar gibi geri yaymak yerine, önce girdiyi verir, ileri iter ve bir süre nöronu günceller ve sonra çıktıyı zamanla gözlemleriz. ESN'nin girdi ve çıktı katmanları bazı küçük kıvrımlara sahiptir, çünkü girdi katmanı ağı hazırlamak için kullanılır ve çıktı katmanı zamanla genişleyen aktivasyon modellerinin gözlemcisi olarak hareket eder. Eğitim sırasında sadece gözlemci ile gizli birim arasındaki bağlantı değişecektir.

Sıvı makine (LSM: Sıvı hal makineleri) ESN'ye çok benziyor. Aradaki fark, LSM'nin bir tür sinir ağları olmasıdır: sigmoid aktivasyon işlevi, bir eşik işlevi ile değiştirilir ve her nöron, aynı zamanda birikimli bir bellek hücresidir. Yani nöron güncellendiğinde, içindeki değer komşu değerlerin toplamına ayarlanmadığı gibi kendisine de eklenmez. Eşiğe ulaşıldığında, diğer nöronlara enerji verir. Bu, sivri uçlu bir model oluşturur - eşiğe aniden ulaşılana kadar hiçbir şey olmayacaktır.

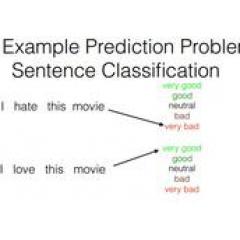

Vektör makineleri desteklemek (SVM: Support Vctor Machines) sınıflandırma problemlerine en iyi çözümü bulabilir. Geleneksel olarak, hangi görüntünün Garfield ve hangi görüntünün Snoopy olduğunu keşfetmek gibi yalnızca doğrusal olarak ayrılabilir verileri sınıflandırabilir ve başka çıktılara sahip olmak imkansızdır. Eğitim sürecinde SVM, tüm verileri (Garfield ve Snoopy) bir resim (2D) üzerine çizmek ve bu veri noktaları arasında nasıl çizgi çizileceğini bulmak olarak kabul edilebilir. Bu çizgi, verileri Garfield bir tarafta ve Snoopy diğer tarafta olacak şekilde böler. Bu çizgiyi ayarlamanın en iyi yolu, kenarın veri noktaları arasında olması ve çizginin her iki uca da maksimize edilmesidir. Yeni verilerin sınıflandırılması, bu grafikte bir nokta çizilerek ve daha sonra bu noktanın çizginin hangi tarafında bulunduğunu görerek yapılabilir. Çekirdek yöntemini kullanarak, n boyutlu verileri sınıflandırmaları öğretilebilir. Bu, Snoopy, Garfield, Simon'un kedisi ve hatta daha fazla çizgi film görüntüsünü sınıflandırabilmek için 3B haritada veri noktalarının çizilmesini gerektirir.

Sonunda tanıtıyoruz Kohonen ağı (KN, kendi kendini organize eden (özellik) harita olarak da bilinir (SOM / SOFM: kendi kendini organize eden (özellik) haritası)). KN, verileri denetimsiz olarak sınıflandırmak için rekabetçi öğrenmeyi kullanır. Ağa giriş bilgileri ve ardından ağ, hangi nöronun giriş bilgileriyle en iyi eşleştiğini değerlendirir. Bu nöronlar daha sonra girdiye daha iyi uyacak şekilde ayarlanır ve süreçteki komşu nöronları sürükler. Ne kadar komşu nöron hareket edebilir, en iyi eşleşen birimden ne kadar uzakta olduklarına bağlıdır.

-

- Tanabata Sevgililer Günü bir ayrılık festivaline mi dönüştü? AI büyük verileri, Qixi Festivali hakkındaki gerçeği ortaya koyuyor!

-

- Ağ diski güvenilir değil, sadece sabit diskler satın alabilirsiniz! Yeni Seagate 3T sabit diskini ortaya çıkarın