Makine öğrenmiyor: Bilgisayar Görme Serisi (3) ResNet ve DenseNet

Makine www.jqbxx.com'u öğrenmiyor: Derin toplu makine öğrenimi, derin öğrenme algoritmaları ve teknik mücadele

Beş, ResNet

Derin bir artık ağ olan ResNet, ilk 5'te% 3,6 hata oranına sahiptir. 2015 yılında ILSVRC'nin şampiyonudur. Ağ yapısı aşağıdaki gibidir:

Kalan ağın tasarım konsepti şu şekilde özetlenebilir:

- Basit tutun

- VGG tarzı

- En derin yok, sadece daha derin, şimdiye kadar 1k katmanını kırdı

Şimdi, ağdaki en kritik kalıntı yapıdan bahsedelim:

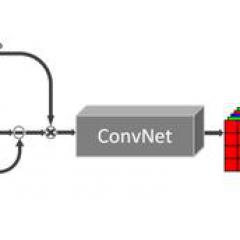

Yukarıdaki şekilde gösterildiği gibi, bu ağın önerisi esasen seviye görece derin olduğunda eğitilemeyeceği problemini çözmektir. Otoban Ağı fikrinden yararlanır ve girişin çıkışa doğrudan ulaşabilmesi için yanında bir kanal açar ve optimizasyon hedefi, orijinal uydurma çıkışı H (x) 'den çıkış ve H (x) -x girişi arasındaki farka değiştirilir, burada H (X), belirli bir katmanın orijinal beklenen eşleme çıktısıdır, x girdidir ve ok kısayol bağlantısı olarak adlandırılır.

Yazarın yorumu şudur:

- kimlik optimal olsaydı, ağırlıkları 0 olarak ayarlamak kolaydır;

- Optimal haritalama kimliğe yakınsa, küçük dalgalanmaları bulmak daha kolay

Kimlik optimal ise, istediğimiz ideal eşlemedir, o zaman F (x) 'in tüm parametrelerini doğrudan sıfıra ayarlayabiliriz; özdeşlik ve H (x) çok yakınsa, arta kalanını öğrenebiliriz. Bu farkı düzeltin.

Fakat derin artık ağ, ağın derinleşmesinden dolayı neden gradyan kaybolması veya gradyan patlaması sorununa neden olmuyor? Aşağıdaki makale, performansının neden üstün olduğunu analiz etmekte ve yeni bir artık birim önermekte ve aşağıdaki şekilde gösterildiği gibi çeşitli artık birimlerin performansını karşılaştırmaktadır:

Derin Artık Ağlarda Kimlik Eşlemeleri

Özetle, kalıntı yapının özelliğinden dolayı, girdi kayıptan türetildiğinde, türev terim ikiye ayrılacaktır ve doğrudan girdiye kaybolmayacak bir türev terim vardır, bu nedenle gradyan her zaman vardır.

Altı, DenseNet

Hepimizin bildiği gibi, son yıllarda, etkiyi iyileştirmek için evrişimli sinir ağlarının yönü ya derin (ağ derin olduğunda gradyan kaybolması sorununu çözen ResNet gibi) ya da geniş (GoogleNet'in Başlangıç gibi) ve yazar özellikten ve özellik aracılığıyla başlıyor Daha iyi sonuçlar ve daha az parametre elde etmek için nihai kullanım. Özet olarak, DenseNet aşağıdaki avantajlara sahiptir:

DenseNet, ağdaki katmanlar arasında maksimum bilgi iletimini sağlamak amacıyla tüm katmanları doğrudan birbirine bağlar. Geleneksel bir evrişimli sinir ağında, bir L katmanınız varsa, o zaman L bağlantıları olacaktır, ancak DenseNet'te, L (L + 1) / 2 bağlantıları olacaktır. Basitçe söylemek gerekirse, her katmanın girdisi önceki tüm katmanların çıktısından gelir. Aşağıda gösterildiği gibi: x

0

x0 girilir, H1 girdisi x0 (girdi), H2 girdisi x0 ve x1 (x1, H1in çıktısıdır)

Gradyan kaybolması sorunu, ağ derinliği daha derin olduğunda daha olasıdır. Bunun nedeni, giriş bilgilerinin ve gradyan bilgilerinin birçok katman arasında iletilmesidir.Şimdi bu tür yoğun bağlantı, her katmanın doğrudan girişi ve kaybı bağlamasına eşdeğerdir, bu nedenle Gradyanların kaybolmasını azaltabilir, böylece daha derin ağlar sorun olmaz. Ek olarak, yazar ayrıca bu yoğun bağlantının bir düzenlilik etkisine sahip olduğunu, dolayısıyla aşırı uydurma üzerinde belirli bir engelleyici etkiye sahip olduğunu gözlemledi.

Makale aşağıdaki şekilde ResNet ile karşılaştırılmıştır:

- ResNet: Xl = H (xl 1) + xl 1

Burada l, bir katmanı temsil eder, l katmanının çıktısını temsil eder ve Hl, doğrusal olmayan bir dönüşümü temsil eder. Dolayısıyla, ResNet için, katman l'in çıktısı, katman l-1'in çıktısı artı katman l-1 çıktısının doğrusal olmayan dönüşümüdür.

- DenseNet: xl = Hl ()

- 0 ila l-1 katmanlarının çıktı özelliği haritasının birleştirilmesi anlamına gelir. Birleştirme, tıpkı Başlangıç gibi kanalların birleşmesidir. Önceki ResNet, değerlerin eklenmesidir ve kanal sayısı değişmez.

Aşağıdaki şekil tüm ağ yapısını göstermektedir Bu yapı diyagramı, darboğaz katmanı ve geçiş katmanı işlemlerinin eklenmesi ile 3 Yoğun Blok içerir.Her yoğun bloğun 3x3 evrişimi 1x1 evrişim işlemi içerir. , Darboğaz katmanı olarak adlandırılan, amaç giriş özelliği haritalarının sayısını azaltmaktır, yalnızca boyutluluğu azaltmak ve hesaplama miktarını azaltmakla kalmaz, aynı zamanda her kanalın özelliklerini de entegre eder; Parametreleri daha da sıkıştırmak için yazar her iki yoğun blok arasına ekler 1 × 1 evrişim işlemi, bu Çeviri katmanının eklendiği ve bu katmanın 1 × 1 evrişiminin çıkış kanalının varsayılan olarak giriş kanalının yarısı olduğu anlamına gelir.

Referans

- Mükemmel giriş makalesi: LeNet-5'ten DenseNet'e

- LeNet-5: Belge tanımaya uygulanan gradyan tabanlı öğrenme

- AlexNet: Derin Evrişimli Sinir Ağları ile ImageNet Sınıflandırması

- VGGNet: Büyük Ölçekli Görüntü Tanıma için Çok Derin Evrişimli Ağlar

- VGGNet: Bilgisayarla Görü için Başlangıç Mimarisini Yeniden Düşünmek

- GoogleNet: Dönüşümlerle Daha Derine İnmek

- ResNet: Görüntü Tanıma için Derin Artık Öğrenme

-

- Hissi ve değeri birinci sınıftır! Red Fire Bull Ghost Hand'in prizma mekanik klavyesi üzerine derin araştırma