Seyrek geri bildirim görevlerini öğrenmek için merak kullanın

Leifeng.com AI Teknolojisi Yorumu: Yakın zamanda Unity, makine öğrenimi aracı araç setinin (ML-Agent araç seti v0.4) 0.4 sürümünü yayınladı. En göze çarpan yeni özellik, ek merak temelli içsel teşviklerin kullanılmasıdır. Eğitim. Bu yeni özelliğin açıklamada çözülmesi gereken birçok yönü olduğu için, yazar Arthur Juliani bunu açıklamak için bağımsız bir makale yazdı. Leifeng.com AI Technology Review bu makaleyi aşağıdaki gibi derledi.

Prensip olarak, ödülün olasılığı yüksek değilse veya dağıtım seyrekse, failin ortamı algılaması için artık daha etkili bir yol var. Bu temsilciler, sonuç hakkındaki merak derecesine göre bir ödül kullanarak bu tür ortamları keşfedebilirler. Bu yazıda yazar, bu yöntemin çalışma prensibini anlatmakta ve bu yöntemi kullanarak pratik bir görevin nasıl çözüleceğini, pekiştirmeli öğrenme yönteminin orijinal versiyonu ile karşılaştırarak bu yeni yöntemin üstünlüğünü göstererek göstermektedir. Seks.

Merak odaklı keşif

Takviye öğrenmeye gelince, ana öğrenme bilgisi ödüller şeklinde gelir: Her karar verildiğinde, temsilciye bir skaler değer verilir. Bu tür ödüller genellikle çevrenin kendisi tarafından üretilir ve ortamın yaratıcısı tarafından belirlenir. Ödül aralığı (-1.0, +1.0), +1.0 hedefe yakın ve -1.0, ajanın hayatının öldüğü anlamına gelir. Bu tür bir ödülün dışsal olduğu düşünülebilir, çünkü zeka dışında üretilir. Harici ödüller varsa, o zaman iç ödüller de olmalıdır. Dış ödüllerden farklı olarak, dahili ödüller ortam tarafından sağlanmamaktadır, ancak bazı standartlara göre temsilci tarafından üretilmektedir. Elbette, tüm iç teşvikler böyle değil. Sonunda, iç ödüller, temsilcinin davranışını değiştirmek ve gelecekte daha iyi dış teşvikler elde etmek gibi bazı hedeflere hizmet etmeyi umuyor ya da temsilci daha fazla dış çevreye maruz kalabilir. İnsanlarda ve diğer memelilerde, bu içsel ödüllerin peşinde koşmak genellikle içsel motivasyon olarak adlandırılır ve duygularımızla yakından bağlantılıdır.

Pekiştirmeli öğrenme alanındaki araştırmacılar, aracılara içsel ödüller sağlamak için iyi sistemler geliştirmek için çok fazla enerji harcadılar ve bu da onlara doğal ajanlarda bulduğumuza benzer motivasyonlar sağlıyor. Popüler bir yöntem, acenteye bir merak vermek ve onu etrafındaki dünyanın şaşkınlığına göre ödüllendirmektir. Küçük bir bebeğin dünyayı nasıl anladığını düşünmek istiyorsanız, belirli bir hedef peşinde koşmak değil, yeni deneyimler için oynamak ve keşfetmek - böylece çocuğun meraklı olduğunu söyleyebilirsiniz. Merak odaklı araştırmanın arkasındaki fikir, bu motivasyonu temsilcilerimize aşılamaktır. Temsilci ödüllendirilir ve kendisini şaşırtan bir duruma ulaşırsa, kendisini şaşırtan giderek daha fazla durum bulmak için çevreyi keşfetmek için yeni stratejiler öğrenecektir. Bu şekilde, ajan ayrıca labirentteki uzak hedef yerler veya kaynakların seyrek olması gibi harici ödüller bulmayı da umuyor.

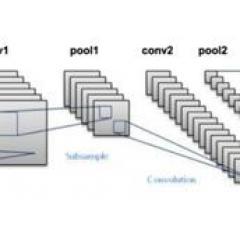

Yazar, Deepak Pathak ve meslektaşları tarafından geçen yıl yayınlanan yakın tarihli bir makalede belirli bir yöntem seçti. Merak odaklı keşif ve kendi kendini denetleyen tahmin olarak adlandırılır.Tüm ayrıntılarla ilgileniyorsanız, orijinal bağlantıyı açabilirsiniz. Makalede yazar, merak uyandıran fikirleri akıllıca ve genellenebilir bir şekilde formüle ediyor. Bu yöntem, iki bağımsız sinir ağını eğitmeyi önerir: bir ileri model ve bir ters model. Ters model, aracı tarafından alınan mevcut ve sonraki gözlem bilgilerini kabul etmek, bunları tek bir kodlayıcı kullanarak kodlamak ve sonucu iki gözlemin meydana gelmesi arasında gerçekleştirilen eylemi tahmin etmek için kullanmak üzere eğitilir. Daha sonra ileri model, kodlamanın mevcut gözlemini ve davranışını elde etmek ve kodlamanın bir sonraki gözlemini tahmin etmek için eğitilir. Öngörülen ve gerçek kodlama arasındaki fark, daha sonra içsel bir ödül olarak kullanılır ve aracıya verilir. Daha büyük farklılıklar, daha büyük sürprizler anlamına gelir ve bu da daha fazla iç ödül anlamına gelir.

Bu iki modeli aynı anda kullanarak, temsilcinin ödülü yalnızca temsilciyi şaşırtan şeyleri değil, aynı zamanda temsilcinin eylemleri yoluyla kontrolü kazandığı şeyleri de özellikle yakalar. Super Mario oyununda, yöntemleri herhangi bir dış ödül olmadan bir temsilci için ilerleme kaydedebilir. Aşağıda, yöntem tasarımlarının şematik bir diyagramı bulunmaktadır.

Piramit ortamı

Merakı test etmek için, sıradan hiçbir ortam bunu yapamaz. Machine Learning Agent Toolkit'in 0.3 sürümü aracılığıyla yayınlanan örnek ortamların çoğu, nispeten yoğun ödüller içerir ve meraktan veya diğer keşif geliştirme yöntemlerinden yararlanmayacaktır. Yeni keşfedilen merakı teste sokmak için yazar, piramit ortamı adı verilen yeni bir nadir ödül ortamı yarattı. İçinde yalnızca bir ödül var ve rastgele keşif, ajanın onunla karşılaşmasına nadiren izin veriyor. Bu ortamda, ajan, önceki bazı ortamlarda tanıdık mavi kübe benzer bir form benimser. Aracı, ileri veya geri, sonra sola veya sağa hareket edebilir ve küpün önündeki bir dizi ışın projeksiyonu aracılığıyla çevredeki dünyanın görüntüsüne erişebilir.

Ajan, dokuz odadan oluşan kapalı bir alana yerleştirilir. Bir oda rastgele yerleştirilmiş bir anahtar içerir ve diğer odalar rastgele yerleştirilmiş taşınmaz taş piramitler içerir. Temsilci anahtarla etkileşime girdiğinde, anahtar kırmızıdan yeşile döner. Bu renk değişimi ile ortam, belirli bir odada rastgele bir konumda hareketli tuğlalarla yeni bir piramit oluşturacaktır. Piramidin tepesinde altın bir tuğla var. Temsilci tuğlaya dokunduğunda +2 harici ödül alır. Buradaki zor kısım, yeni bir odaya yürüme, düğmeyi çevirme ve kuleyi devirme sürecinde hiçbir ara ödülün olmamasıdır. Temsilci, bu sıralamayı ara yardım almadan yürütmeyi öğrenmelidir.

Temsilci eğitim için Proksimal Politika Optimizasyonunun (PPO, Unity ortamındaki varsayılan güçlendirme öğrenme algoritması) orijinal sürümünü kullandığında, 200.000 adımlık egzersizden sonra bile performansı zayıftır, sonuç genellikle eşit değildir Rastgele oluşturulan sonuçlardan daha iyidir (ortalama ödül -1'dir). (Aşağıdaki şekil)

Aksine, PPO ve merak odaklı dahili ödüller ile eğitilmiş bir aracı, sorunları birden çok deneyde 200.000 adımda veya hatta zamanın yarısında çözebilir. (Aşağıdaki şekil)

Yazarlar ayrıca sadece içsel ödül sinyalleri ile eğitilmiş ajanlar üzerinde çalıştılar. Görevleri çözmeyi öğrenmemiş olsalar da, birden çok oda arasında hareket etmelerine izin veren daha ilginç bir nitel strateji öğrendiler; aksine, dışarıda Tek strateji ödül olarak, temsilci bir odada yalnızca küçük bir daire oluşturabilir. (Aşağıdaki şekil)

Yakın uç strateji optimizasyonu ve merak stratejisi

Temsilcinin çevrede eğitilmesine yardımcı olmak için merak stratejilerini kullanmak istiyorsanız, eğitimi etkinleştirmek çok basittir. İlk olarak, en son makine öğrenimi araç setini alın ve ardından aşağıdaki kodu hiperparametre belgesine ekleyin: use_curiosity: true. Daha sonra eskisi gibi çalışın. TensorBoard kullanıyorsanız, sonuçlarda birçok yeni metriğin izlendiğini görebilirsiniz. Bu süreç, ileri ve geri model kayıplarını ve her adımda biriktirilen doğal ödülleri içerir.

Temsilciye merak vermek tüm senaryolarda geçerli değildir. Özellikle ortam zaten çoğu eylemden sonra sıfır olmayan bir ödül alan Crawler ve Walker ortamları gibi yoğun bir ödül işlevi içeriyorsa, çok fazla gelişme göremeyebilirsiniz. Ortam yalnızca seyrek ödüller içeriyorsa, o zaman içsel ödüller eklemek, bu görevleri pekiştirmeli öğrenmeyi kullanarak çözülemeyenden çözmesi kolay hale getirebilir. Bu özellikle basit görevleri (kazanma / kaybetme veya tamamlama / başarısızlık gibi) ödüllendirdiğinde yararlıdır.

-

Merak özelliğini kullanırsanız, Unity ekibi de geri bildirimlerinizi duymayı umar. Doğrudan ml-agents@unity3d.com adresine bir e-posta gönderin veya Github'daki soru sütunundan bir mesaj bırakın ~ Eğitimde iyi şanslar!

blogs.unity3d.com, Leifeng.com AI teknolojisi inceleme derlemesi aracılığıyla

-

- Ürün satmadan kar edebilirsiniz Nokia, OPPO'ya kendi patentlerinden bazılarını kullanma yetkisi verdi!

-

- [Chongqing Flower Takdir Sezonu Açıldı] Jiulongpo bir "çiçek ve çiçek dünyası" oldu, erik rotasını kontrol edin

-

- Mücevher Kılıç Ustasından daha acımasız bir rutin, kral zaten kullanılıyor, tasarımcı: yaygın olarak kullanılırsa zayıflayacak

-

- Liu Lirong, Saipan'ın 1 milyardan fazla kumarda kaybettiğini ve Jinli'nin uzun vadeli kayıplar nedeniyle düştüğünü itiraf etti!