Başlangıç! Üçgen Canavar, EMNLP tarafından makalenin özünü okumak için kabul edildi: Çekişmeli öğrenmeye dayalı üretken diyalog modeline kısa bir giriş

Lei Feng.com'a göre: Yakın zamanda, Triangle Animal Technology AI Lab tarafından hazırlanan bir makale, dünyanın en iyi doğal dil işleme konferansı EMNLP tarafından yüksek puanlarla kabul edildi. Makalenin konusu: Üçgen Hayvan Araştırma Ekibi ve Harbin Teknoloji Enstitüsü tarafından GAN aracılığıyla Yaklaşık Gömme Katmanı ile Sinir Tepkisi Üretimi ITNLP laboratuvarları ile işbirliği içinde tamamlandı. Makalede, çekişmeli öğrenmeye dayalı sohbet yanıtı oluşturma modelini gerçekleştirmek için metin oluşturma sürecinde örnekleme işleminin neden olduğu hataların geri iletilemeyeceği asıl sorunu çözmeyi amaçlayan yeni bir diyalog metni karşıt nesil öğrenme çerçevesi önerilmiştir.

Aşağıda, Leifeng.com tarafından yayınlanması için yetkilendirilen Üçgen Canavar araştırma ekibi tarafından yazılan makalenin özüne bir giriş yer almaktadır:

Giriş

Son birkaç yılda Derin Öğrenme (DL), geçmişte atılımlara ulaşmanın zor olduğu düşünülen araştırma yönlerinin zorluğunu azaltan doğal dil işleme alanını sürekli olarak fethediyor.Bunlardan en çok konuşulan vakalar şüphesiz en popüler vakalardır. Sıradan Sıraya (S2S), İstatistiksel Makine Çevirisi (SMT) alanında sinir ağlarına dayalı yepyeni bir Sinir Makine Çevirisi (NMT) paradigmasına yol açan yıkıcı bir dönüm noktasıdır. Bu yeni paradigmanın etkisi, bu makalede tartışılacak olan Nesil tabanlı Sohbet Sistemi de dahil olmak üzere diğer ilgili alanlara bile yayıldı.

Genel olarak Otomatik Sohbet Sistemlerinin iki teknik yolla uygulanabileceğine inanılmaktadır: Birincisi, büyük ölçekli bir diyalog veri seti üzerine bir bilgi erişim sistemi kurmak ve etkili soru eşleştirme ve soru-cevapla ilgili niceleme modelleri kurarak eşleştirme sağlamaktır. Kullanıcı sorgularına verilen makul yanıtlar bu makalede tekrarlanmamıştır; başka bir teknik rota, sorgu ve büyük konuşma verilerinden yanıt arasındaki anlamsal ilişkiyi otomatik olarak öğrenmek için uçtan uca (Uçtan Uca) bir derin öğrenme modeli oluşturmaya çalışır. , Herhangi bir kullanıcı sorgusu için otomatik olarak bir yanıt oluşturma amacına ulaşmak için. Bilgiye ulaşmaya dayalı teknik rota mühendislik gerçekleştirmeye odaklanırsa, o zaman üretime dayalı teknik rota daha akademik görünür.

Üretken sohbet modelinin önerisinin NMT ile çok yakın bir ilişkisi vardır ve bu ilişki, derin öğrenmenin henüz bu kadar popüler hale gelmediği çağa kadar izlenebilir: Soru Cevaplama Sistemleri üzerine yapılan ilk araştırmada, insanlar zaten SMT'nin korelasyonunu düşünmüşlerdir. Model ve yöntem cevap tarama ve sıralama modülünde uygulanmış ve iyi sonuçlar alınmıştır. Bunun nedeni, bir soruya cevap bulma sürecinin özel bir çeviri süreci olarak değerlendirilebilmesidir.Bu özel çeviri sürecinde, soru ve cevap çeviri modelinin her iki ucunda yer almaktadır.Bu şekilde bir soru- Cevap çifti aslında SMT'nin işlemesi gereken paralel bir külliyata eşdeğerdir ve SMT'nin eğitim süreci aslında soru ve cevaptaki kelimelerin anlamsal ilişkisini oluşturma sürecine eşdeğerdir. NMT'nin büyük başarısından sonra, bu yeni paradigma doğal olarak otomatik sohbet yanıtlarına uygulandı, bu nedenle bu makalede tartışılacak ilk sezgisel düşünce ortaya çıktı: sohbet, özel bir tür olarak kabul edilebilir. Bilgiye dayalı soru ve cevap, cevapları bulmak için SMT kullanılabilirken ve NMT, SMT'nin gelişmiş bir formuyken, NMT modelinin otomatik olarak sohbet cevapları oluşturmak için kullanılması beklenir. Bugün, bu yeni otomatik sohbet modeli mimarisine Neural Response Generation (NRG) adını verdik.

NRG'nin karşılaştığı zorluklar

NRG modeli kullanılarak oluşturulan sohbet yanıtlarından bazılarının gerçekten konuyla ilgili sorgu ile eşleşebileceği ve hatta yüksek anlamsal alaka ve iyi okunabilirliğe sahip bireysel yanıtların bile üretilebileceği inkar edilemez. Korkarım hiç kimse NRG'nin NMT modelinin makine çevirisi alanındaki başarısını kopyaladığını düşünmez. Asıl sebep, bu uçtan uca modelin ürettiği cevapların çoğunun son derece yakınsak olması ve pratik değeri olmaması, yani insanların makineyle konuşmasının imkansız olmasıdır. Gelecekte, örneğin herhangi bir kullanıcı sorgusu için sonuç "Ben de düşünüyorum" veya "Ben de öyle düşünüyorum" olabilir. Modelin Çince veya İngilizce verileri üzerinden eğitilmiş olup olmadığına bakılmaksızın, bu fenomen çok açıktır.Model tarafından üretilen sonuçların çoğu herhangi bir sorguya zar zor yanıt verebildiğinden, oluşturulan sonucun bu görüntüsünü güvenli yanıt olarak adlandırdık .

Açıktır ki, çok sayıda güvenli yanıtın varlığı, otomatik sohbet sistemini sıkıcı hale getirecek ve kullanıcıların sistemle etkileşime girme hevesini kaybetmesine neden olacaktır.Bu nedenle, mevcut pratik sohbet sistemi hala bilgi alma modeline dayanmaktadır. Kısacası, NRG modeli gerçek üründe bir rol oynamak istiyorsa, güvenli yanıt oluşumundan kaçınmak çözülmesi gereken bir sorundur ve bu kaçınılmazdır.

Güvenli yanıt problemi, birçok faktörün birleşiminden kaynaklanıyor olabilir Bu makale, bu problemi sadece en sezgisel yönden kısaltmaktadır. Şu soruyu ele alalım: Aynı veri organizasyon formu, aynı model yapısı ve makul varsayımlar altında, NMT modeli neden bu kadar bariz bir güvenli çeviri sonucu problemi ile karşılaşmıyor? Şu anda, NMT modelinin iş akışını gözden geçirmek gerekir: NMT modeli iki bölümden oluşur, bir bölüm kaynak cümlenin anlamsal temsilinden sorumludur ve onu belirli bir boyutun anlamsal vektörüne sıkıştırmaktan sorumludur, böylece kodlayıcı olarak adlandırılabilir; diğer bölüm Kodlayıcı tarafından sağlanan anlamsal vektörü almaktan sorumlu olan ve anlamsal vektörün "rehberliği" altında, bir hedef cümle oluşturmak için kelimeleri tek tek seçin Bu bölüme genellikle kod çözücü denir. Özetle, kodlayıcı, giriş sinyalinin anlamsal temsilini sağlamaktan sorumludur ve kod çözücü, aslında başlangıç koşulu olarak anlamsal gösterime sahip bir dil modeli uygular.

Şekil 1 Klasik Sıradan Sıraya model

Bu şekilde, güvenli yanıtın en önemli noktalarından biri ortaya çıkmaya hazırdır: Makine çevirisi ve sohbetin eğitim verilerini karşılaştırırsanız, sohbet verisindeki cümlenin farklı konumlarındaki kelimelerin olasılık dağılımının çok açık bir uzun kuyruk özelliğine sahip olduğunu bulmak zor değildir. Genellikle cümlenin ilk birkaç kelimesinde özellikle belirgindir. Örneğin, sohbet yanıtlarının önemli bir kısmı "" ve "" ile başlayan cümlelerle başlar. Aksine, esas olarak veri kaynağı olarak normal metin kullanan SMT paralel korpusu için Başka bir deyişle, bu durumun meydana gelmesi, büyüklük sırasına göre azaltılabilir. Bu durumda, kelime olasılık dağılım modeli ilk olarak kod çözücü dil modeli tarafından öğrenilecek ve kelime ilişkilendirme modelinin sorgu ve yanıt arasındaki rolü, oluşturma işlemi sırasında ciddi şekilde engellenecektir. Sezgisel olarak, sorgunun anlambilimiyle bile Bir koşul olarak vektör, kod çözücü yine de yanıtın ilk kelimesi olarak en olası "I" yi seçecektir ve dil modelinin özelliklerinden dolayı, sonraki kelime büyük olasılıkla "aynı zamanda" olacaktır ... ve benzeri, güvenli bir yanıt O zamandan beri.

Sezgisel bir çözüm

NRG modeli tarafından üretilen güvenli yanıt sorununun beklenmedik ve makul olduğu söylenebilir, bu nedenle insanlar bu soruna sıkıca meydan okudular. Yaygın çözümler şunları içerir: dikkat mekanizmasını tanıtarak sorgudaki anahtar anlamsal bilgilerin güçlendirilmesi ve kod çözücüdeki dil modelinin etkisinin zayıflatılması Geniş anlamda, kullanıcı modellemesi veya dış bilginin tanıtılması da üretilen yanıtların çeşitliliğini artırabilir.

Ve modelin veya verinin yerel algısından sıyrılıp güvenli yanıt sorununu daha küresel bir perspektiften ele aldığımızda, çok sezgisel bir çözüm acele eder: Güvenli bir yanıt üreten S2S modeli yerel bir optimuma düşme olarak düşünülebilir. Çözüm ve ihtiyacımız olan şey, modelin yerel çözümden çıkıp daha optimize bir duruma girmesini sağlamak için modele bir rahatsızlık uygulamaktır.Daha sonra, en basit pozitif rahatsızlık, modele, bu şekilde oluşturulmuş olsa bile ürettiği güvenli yanıtın zayıf bir sonuç olduğunu bildirmektir. Sonuç kaybı daha azdır.

Sezgisel bir düşünce, üretken sohbet konusunda Generative Adversarial Networks'ün (GAN) dolambaçlı keşfini açtı.

Bilmek kolaydır

GAN'ı sohbet yanıtı oluşturmaya dahil etme fikri çok doğal görünüyor: Belirtilen sorgu için bir yanıt üretmekten sorumlu olan bir yanıt oluşturucu G oluşturmak için kodlayıcı-kod çözücü mimarisini ve üretilen sonucun ve gerçek yanıtın ne kadar büyük olduğuna karar vermekten sorumlu bir ayırıcı D'yi kullanın. Ve güvenli yanıt üretmenin yerel optimal durumunun dışına çıkarmak için ayırıcının çıkışına göre jeneratör G'yi ayarlayın.

Bununla birlikte, ters öğrenme yoluyla metin üretmeye çalıştığımızda, görüntü üretme GAN modelinde hiç karşılaşılmamış bir sorun önümüzde beliriyor, yani ayırıcı D eğitim hatasının üreteç G'ye (Backpropagation ). GAN tabanlı görüntü oluşturma modeli için, bu hatanın geri yayılması çok doğaldır, çünkü G'nin görüntü üreten tüm süreci sürekli ve farklı olabilir, bu nedenle D'nin eğitim hatası doğrudan D'nin çıktı katmanından iletilebilir. G.'nin giriş katmanı Metnin oluşturulması için, bir metin örneğinin oluşturulmasına çıktı katmanındaki G örnekleme süreci eşlik etmelidir.Bu örneklemenin prensibi, açgözlü maksimum olasılık veya ışın arama fikrini seçmek olursa olsun, aslında Kesikli operasyon, bu kılavuzsuz süreç, yolda aniden beliren, geri yayılmayı engelleyen ve G'nin yüzleşme eğitiminin ilerlemesini imkansız kılan bir uçurum gibidir.

Metin oluşturma sürecindeki örnekleme işlemi nedeniyle hatanın iletilemediği asıl sorunu çözmek ve böylelikle çelişkili öğrenmeye dayalı sohbet yanıtı oluşturma modelini gerçekleştirmek için, Üçgen Canavar araştırma ekibi, Yaklaşık Gömme Katmanı ile GAN Üzerinden Sinir Tepkisi Üretimi makalesinde bir makale önerdi. Yeni bir diyalog metni çelişkili üretken öğrenme çerçevesi, şu anda bu makale EMNLP 2017 tarafından kabul edilmiştir.

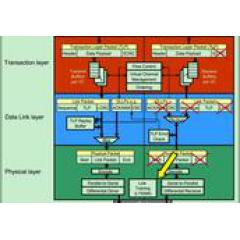

Şekil 2 GAN-AEL'e dayalı tartışmalı öğrenme çerçevesi

Şekil 2, makalede önerilen Yaklaşık Gömme Katmanı (GAN-AEL) ile GAN'ın temel çerçevesini göstermektedir. Yanıt oluşturma modeli G'nin ana gövdesini oluşturmak için GRU kullanıyoruz ve sorgu ile (gerçek veya model tarafından üretilen) yanıt arasındaki anlambilimin ilişkili olup olmadığını belirlemek için ayırıcı D'yi oluşturmak için CNN kullanıyoruz. Bir sorgu verildiğinde, model G, kodlama-kod çözme süreciyle sahte bir yanıt üretir.Bu sahte yanıt, sorgu ile birlikte olumsuz bir örnek oluşturacaktır.Aynı zamanda, sorgu, eğitim verilerinde gerçek yanıtla pozitif bir örnek oluşturacaktır. D cihazının eğitim amacı, yukarıdaki pozitif ve negatif numuneleri olabildiğince ayırt etmektir.

Yukarıda bahsedildiği gibi, metin oluşturmayı iyileştirmek için rakip öğrenmeyi tanıtmanın temel sorunu, ayırıcı hatalarının oluşturucuya doğru yayılmasını sağlamak için metin oluşturma sürecinde örneklemenin neden olduğu yönsüzlük sorununun nasıl çözüleceğidir. Bu makale, bu problemle yüzleşir ve jeneratör G için bir Yaklaşık Gömme Katmanı oluşturur (AEL resminde kırmızı dikdörtgende gösterildiği gibi ve detaylar resmin sağ kısmında verilmiştir) Bu katmanın işlevi, her örneklemeyi yaklaşık olarak belirlemektir. Süreçte, her bir oluşturma adımında, belirli kelimeleri elde etmek için daha fazla girişimde bulunulmaz, ancak kelimelerin olasılık dağılımına dayalı olarak bir örnekleme vektörü hesaplanır. Bu işlemin spesifik süreci, her bir oluşturma adımında, GRU tarafından gizli durum h_i çıktısına rastgele bir z_i ekledikten sonra, her bir kelimenin olasılık dağılımının tüm kelime haznesindeki olasılık dağılımının, tamamen bağlı katman ve softmax'tan sonra elde edilmesidir. Olasılık dağılımı, halihazırda örneklenmiş olan kelimenin (Şekil 2'de sağdaki yeşil kutuda gösterilmiştir) yaklaşık vektör gösterimini elde etmek için kelime haznesindeki tüm kelimelerin gömülmesini toplamak için bir ağırlık olarak kullanılır ve bunu bir sonraki nesil adım haline getirir. giriş. Aynı zamanda, bu yaklaşık vektör, D eğitimi için sahte yanıtın temsilini birleştirmek için de kullanılabilir. Örnekleme sonuçları için bu yaklaşık temsil işleminin sürekli ve türetilebilir olduğunu görmek zor değildir ve bu yaklaşık temsilin tanıtılması, G modelinin eğitim hedefini değiştirmez.

Bizim küçük adımımız

Oluşturucu ve ayırıcı arasında bir bağlantı ortamı olarak, AEL'nin kurulması, sohbet için yanıt oluşturma probleminde karşıt öğrenme çerçevesinin uygulanmasının rasyonelliğini sağlar. Bu mantıklılığı doğrulamak için, modelimizi mevcut ortak Çince ve İngilizce diyalog verileri üzerinde doğruladık ve sonuçlar aşağıdaki tabloda gösterilmektedir:

Tablodaki Seq2Seq, MMI-anti ve Adver-REGS, klasik kodlayıcı-kod çözücüyü, sırasıyla dil karşıtı model mekanizmasının girişiyle S2S'yi ve takviye öğrenmeye dayalı bir GAN modeli mimarisini temsil eder. Üretilen sonuçların anlamsal geçerliliği ve çeşitliliği açısından çeşitli modelleri karşılaştırmaya çalıştık.Bu makalede önerilen GAN-AEL'in anlamsal geçerliliği sağlarken yanıtı oluşturmayı önemli ölçüde geliştirdiği görülebilir. Çeşitlilik.

Modelin çeşitlilik açısından gelişimini görsel olarak göstermek için, aşağıdaki tabloda gösterildiği gibi gerçek üretilen sonuçların bazı örneklerini veriyoruz.

Modelimiz, modelin teorik ayrıntılarının, değerlendirme göstergelerinin ve temel yöntemlerin ayrıntılı bir tanımını verir İlgilenen okuyucular, yayınladığımız makalelere dikkat etmeye devam edebilir.

Sonuç

Derin öğrenme modeline dayalı uçtan uca otomatik sohbet sistemi üzerine araştırmayı başlatan iki sezgisel fikir, sohbet yanıtı oluşturmada çekişmeli öğrenmenin dolambaçlı keşfine yol açtı. En sıcak araştırma yönü ile birlikte mevcut en ilginç modelin herhangi bir araştırmacı için çok çekici olduğu doğrudur.Ancak, temel konularla doğrudan yüzleşmek ve bunları çözmenin yollarını bulmaya odaklanmak, neye ihtiyaç vardır? Bu pragmatik bir araştırmadır, herhangi bir aceleci zihniyet sonunda araştırma çalışmalarını sıkıcı sulamaya dönüştürebilir.

Makinenin otomatik olarak herhangi bir sorgu yanıtı oluşturmasına izin vermek son derece zor bir sorundur çünkü insan dili yeteneğine meydan okumaya çalışıyoruz. Zor bir soruna meydan okuma süreci, bir dağa tırmanmak gibidir. Önerilen herhangi bir yeni yöntem, mutlaka dağın tepesine giden yolu açtığımız anlamına gelmez. Bunun yerine, insanlara daha ileri gitmeleri için bir yürüyüş direği sağlar.

Referanslar

Ilya Sutskever, Oriol Vinyals ve Quoc V. Le. 2014. Sinir ağları ile öğrenmeyi sıraya koyma. 27. Uluslararası Sinir Bilgi İşleme Sistemleri Konferansı Bildirilerinde, NIPS'14, sayfalar 31043112, Cambridge, MA, ABD. MIT Basın.

Kyunghyun Cho, Bart van Merrienboer, Caglar Gulcehre, Dzmitry Bahdanau, Fethi Bougares, Holger Schwenk ve Yoshua Bengio. 2014. İstatistiksel makine çevirisi için kod çözücü - rnn kodlayıcı kullanarak ifade temsillerini öğrenme. 2014 Doğal Dilde Ampirik Yöntemler Konferansı Bildirilerinde İşleme (EMNLP), sayfalar 1724-1734, Doha, Katar. Hesaplamalı Dilbilim Derneği

Baotian Hu, Zhengdong Lu, Hang Li ve Qingcai Chen. 2014. Doğal dil cümlelerini eşleştirmek için evrişimli sinir ağı mimarileri. In Advances in Neural Information Processing Systems 27: Annual Conference on Neural Information Processing Systems 2014, sayfalar 20422050

Lifeng Shang, Zhengdong Lu ve Hang Li. 2015. Kısa metinli konuşma için nöral yanıtlama makinesi. 53. Yıllık Hesaplamalı Dilbilim Derneği ve 7. Uluslararası Doğal Dil İşleme Ortak Konferansı Bildirilerinde, sayfalar 1577-1586, Pekin, Çin Hesaplamalı Dilbilim Derneği.

Alessandro Sordoni, Michel Galley, Michael Auli, Chris Brockett, Yangfeng Ji, Margaret Mitchell, Jian-Yun Nie, Jianfeng Gao ve Bill Dolan. 2015. Bağlama duyarlı konuşma yanıtları oluşturma için bir sinir ağı yaklaşımı. NAACL HLT 2015'te, sayfalar 196205

Bowen Wu, Baoxun Wang ve Hui Xue. 2016. Chat-bot'larda konuşma alaka düzeyine yönelik sıralama yanıtları. COLING 2016'da, 26. Uluslararası Hesaplamalı Dilbilim Konferansı, Konferans Bildirileri: Teknik Bildiriler, 11-16 Aralık 2016, Osaka , Japonya, sayfalar 652662.

Delphine Bernhard ve Iryna Gurevych, Çeviriye Dayalı Cevap Bulmak İçin Sözcüksel Anlam Kaynaklarını Soru-Cevap Arşivleriyle Birleştirme

Jiwei Li, Michel Galley, Chris Brockett, Jianfeng Gao ve Bill Dolan. 2016a. Sinirsel konuşma modelleri için çeşitliliği destekleyen bir amaç işlevi. NAACL-HLT'nin Bildirileri, sayfa 110-119.

Jiwei Li, Michel Galley, Chris Brockett, Georgios P. Spithourakis, Jianfeng Gao ve William B. Dolan. 2016b. Kişiye dayalı bir sinirsel konuşma modeli. Hesaplamalı Dilbilim Derneği 54. Yıllık Toplantısı Bildirilerinde, ACL 2016, 7-12 Ağustos 2016, Berlin, Almanya.

Xing Chen, Wu Wei, Wu Yu, Liu Jie, Huang Yalou, Zhou Ming ve Ma Wei-Ying. 2017. Konu farkında nöral yanıt üretimi. Otuz Birinci AAAI Yapay Zeka Konferansı Bildirilerinde, 4-9 Şubat, 2017, San Francisco, California, ABD., Sayfalar 33513357.

Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville ve Yoshua Bengio. 2014. Üretken hasım ağları. Nöral bilgi işleme sistemlerindeki Gelişmelerde, sayfalar 2672-2680.

-

- 54. Altın At Ödüllerinin Önizlemesi: Zhou Dongyu ve Ma Sichun aynı sahnede ödüllerini sunacaklar Huang Bo film kralını tekrar kazanabilecek mi?