Kıdemli Microsoft Araştırmacısı Interleaved Group Convolution'a Dayalı Verimli DNN'yi Açıkladı | Milyonlarca Kişi AI'yı Öğreniyor

Dingdong ~ Refah tarafından vuruldun! Şu andan itibaren, "2020 AI Developer Ten Thousands Conference" için 299 bilet ücretsiz olarak verilecek! Kayıt sayfasına girin [2020 AI Geliştirici On Bin Kişi Konferansı (Çevrimiçi Canlı Biletler) -IT Eğitimi Canlı-CSDN Akademisi], "Şimdi kaydolun" u tıklayın, ödeme sırasında "AIP1410" indirim kodunu kullanın ve fiyat "0" yuan olacaktır !

Yazar | Wang Jingdong

Bitirme | Aspirin

Üretildi | Yapay Zeka Başlıkları (Genel Hesap Kimliği: AI_Thinker)

Evrişimli sinir ağları son yıllarda büyük bir hızla gelişti ve görüntü tanıma gibi görevler üzerindeki etkileri gittikçe daha iyi hale gelse de modelin karmaşıklığı artmaya devam ediyor. Daha derin ve daha karmaşık evrişimli sinir ağları çok fazla depolama ve hesaplama kaynağı gerektirir Bu nedenle, verimli evrişimli sinir ağları tasarlamak çok önemli ve temel bir sorundur ve evrişimin fazlalığını ortadan kaldırmak ana problemdir. Çözümlerden biri.

Evrişimi ortadan kaldırmanın fazlalığı nasıl ortadan kaldırılır? Microsoft Research Asia Görsel Hesaplama Grubu'nda kıdemli bir araştırmacı olan Dr. Wang Jingdong'u ICCV 2017 ve CVPR 2018'de yayınlanan aralıklı grup evrişimine dayalı yöntemi açıklamaya davet ettik.

Aşağıda, AI Technology Base Camp tarafından düzenlenen ve biraz silinmiş açık sınıfın içeriği yer almaktadır:

Derin öğrenmenin büyük başarısının nedeni

2006 yılında "Bilim" konulu bir makale - Yapay Sinir Ağları ile Veri Boyutunun Azaltılması, son on yılda derin öğrenmenin gelişimini teşvik etmek için çok önemli bir makaledir. Bu makale çıktığında makine öğrenimi alanında pek çok kişi bu işe dikkat ediyordu ancak bilgisayarla görme alanında çok iyi sonuçlar elde edemediği için bilgisayar görüşü alanındaki kişilerin ilgisini çekmedi.

Derin öğrenme yöntemi, 2012-ImageNet Classification with Deep Convolutional Neural Networks'deki bir makale nedeniyle bilgisayarla görme alanında gerçekten ilgi gördü. Bu makale, bilgisayar görüşü alanında çok önemli bir ImageNet yarışmasını kazanmak için derin bir evrişimli sinir ağı yöntemini kullanır. 2012'den önceki şampiyonlar, SVM (destek vektör makinesi) veya rastgele orman yöntemlerine dayanıyordu.

2012 yılında Hinton ve ekibi derin ağlar aracılığıyla büyük başarılar elde etti, bu başarı ne ölçüde? Geçen yılın sonucuyla kıyaslandığında yüzde ondan fazla artmış, bu çok etkileyici ve dikkat çekici bir gelişmedir. ImageNet yarışmasındaki başarı nedeniyle, bilgisayarla görme alanı derin öğrenme yöntemlerini kabul etmeye başladı.

Bu iki makaleyi karşılaştırdığımızda, hepimiz buna derin öğrenme desek de, fark aslında oldukça büyük. Özellikle, 2012'deki bu makale, "CNN" olarak kısaltılan "Derin Evrişimli Sinir Ağı" olarak adlandırıldı. CNN, 2012'de bu makalede yeni önerilmemiştir. 1990'larda Yann LeCun, CNN'i dijital tanımada kullanmış ve büyük bir başarı elde etmiş, ancak uzun süre herkes CNN'i ImageNet olarak kullanmamıştır. Bu makaleye kadar yarışma. Bugün herkes derin öğrenmenin bilgisayarla görme alanına hakim olduğunu görüyor.

Derin öğrenme 2012'de neden başarılı oldu? Aslında derin öğrenme veya CNN yöntemlerine ek olarak iki şey daha var, biri GPU ve diğeri ImageNet.

Bu ağ yapısı 2012 yılında Hinton ve öğrencileri tarafından önerildi. Aslında ağ yapısı sadece 8 katmandan oluşuyor ve o kadar derin görünmüyordu, ancak o sırada ağı eğitmek çok zordu. Eğitmek bir hafta sürdü ve diğerleri onu yeniden üretmek istedi. Sonuç o kadar kolay değil.

Bu makaleden sonra herkes sinir ağının ne kadar derin olursa performansın o kadar iyi olduğuna inanıyor. Bunda birkaç temsili çalışma var, sadece kısaca gözden geçirin.

Derin ağ yapısının iki geliştirme yönü

Daha derine inin

2014 VGG'de ağ yapısı çok basittir, katman katman istiflenir ve katmanlar birbirine çok benzer.

Aynı yıl Google "GoogLeNet" adlı bir ağ yapısına sahipti. Bu ağ yapısı VGG'den biraz daha karmaşık görünüyor. Bu ağ yapısı ilk ortaya çıktığında karmaşık görünüyordu ama bugün çok şubeli bir yapıya benziyor. Başlangıçta ortak kanaat, bu ağ yapısının manuel olarak ayarlandığı ve çok popüler olmadığı yönündeydi. GoogLeNet yapay olarak tasarlanmış bir ağ yapısı olmasına rağmen, aslında, uzun ve kısa çok şubeli yapılar dahil olmak üzere öğrenmeye değer şeyler vardır.

2015 yılında Highway adında bir ağ yapısı yayınlandı. Highway makalesi esas olarak 100 katmanlı bir ağı veya hatta 100 katmanlı bir ağı çok iyi eğitebileceğimizi söylüyor. Neden çok iyi eğitilebilir? SkipConnection aracılığıyla önden arka katmana hızlı bir şekilde bilgi aktarabilen bir bilgi akışı kavramı vardır ve ayrıca geri yayılırken arka gradyanı hızla öne geçirebilir. Burada bir sorun var, yani bu Bağlantıyı Atla, derin ağ eğitimini zorlaştıran ve hala gerçekten çözülmemiş bir geçit işlevi kullanıyor.

Aynı yıl Microsoft'tan meslektaşları "ResNet" adlı bir ağ icat ettiler.Bu ağ bir anlamda Highway'e benziyor. Benzerlik nerede? Ayrıca, bir katmanın çıktısından sonraki katmanın çıktısına doğrudan atlamak için Bağlantıyı Atla'yı kullanır. Otoban ile karşılaştırıldığında, geçit işlevini ortadan kaldırır, bunun nedeni, geçidin çok derin ağlarda özellikle iyi bir şey olmamasıdır. Bu tasarım sayesinde 100 katmanlı ağları çok iyi eğitebilir. Daha sonra 1000 katmanlı ağın da çok iyi eğitilebileceğini öğrendim ki bu inanılmaz.

2016 yılında GoogLeNet, Highway ve ResNet'in ortaya çıkmasının ardından, uzun ve kısa olan birden çok şubeye sahip olmanın çok önemli olduğunu gördük.Örneğin, çalışmalarımız derinlemesine kaynaşmış ağlar.Birden çok şubede, her dalın derinliği farklıdır. Bunun avantajı şudur ki, bu yapıya bir grafik olarak bakarsak, bu giriş noktasından o çıkış noktasına giden birden fazla yol olduğunu görürüz.Bazı yollar uzun, bazıları kısa.Bu anlamda, var olduğunu düşünüyoruz. Uzun ve kısa yollar derin sinir ağlarını eğitebilir.

Aynı yıl, derinlemesine kaynaşmış ağlarımıza çok benzeyen FractalNets adlı benzer bir çalışma bulduk.

Ağ yapısını çok iyi eğitmek, performansını çok iyi hale getirmek ve bilgi akışını çok iyi hale getirmek için Bağlantıyı Atla ve diğer formları eklemek umuduyla bu yol derinleştirildi. Derin ağı Skip Connection ile çok iyi eğitmemize rağmen, derinlik hala bazı problemleri beraberinde getiriyor, yani iyi performans göstermiyor, bu yüzden başka bir boyut var ve herkes daha geniş olmayı umuyor.

Ayrıca, büyük ağlar pratikte bazı sorunlarla karşılaşacaktır. Örneğin bir cep telefonuna konuşlandırılırken hesaplama miktarının çok büyük olmaması, modelin çok büyük olmaması ve performansın yine de çok iyi olması umulmaktadır, bu nedenle tanıma oranı çok yüksektir, ancak çok geniş ağ yapısı pratik uygulamalarda bazı zorluklarla karşılaşmaktadır.

Yapıyı basitleştirmenin birkaç yolu

Diğer bir yol, ağ yapısını basitleştirmek ve içerideki fazlalığı ortadan kaldırmaktır. Herkes mevcut derin sinir ağı yapısında güçlü bir fazlalık olduğunu düşündüğünden, fazlalığı ortadan kaldırmak son yıllarda çok değerli bulduğum bir alan çünkü pratikte çok faydalı.

Evrişim işlemi

CNN'deki evrişim işlemi aslında matris-vektör çarpımına karşılık gelir Herkesin yaptığı şey temelde evrişimdeki fazlalığı ortadan kaldırmaktır.

Evrişimi gözden geçirelim. Sağdaki resim: CNN'de birkaç kanal var.Her kanal aslında iki boyutlu bir dizidir.Her pozisyonun "yanıt değeri" dediğimiz bir değeri vardır. Gerçekte üç boyutlu bir diziye eşdeğer olan dört kanal vardır. Bunu (her pozisyonu) merkez olarak alın, küçük bir 3 × 3 blok, 3 × 34 kanal alın, sonra 3 × 3 × 4 çok fazla değer var ve sonra bu birçok değeri 3'e çekiyoruz × 3 × 4 = 36 boyutlu vektör. Evrişim bir evrişim çekirdeğine sahiptir Evrişim çekirdeği yatay bir miktara karşılık gelir Bu yatay miktar sütun vektörü ile çarpıldığında, yanıt değeri elde edilir.Bu ilk evrişim çekirdeğidir. İkinci değer, ikinci evrişim çekirdeği ile elde edilecek ve üçüncü ve dördüncü değerler benzer şekilde elde edilebilecek.

Özetlemek gerekirse, evrişim işlemi bir matris ve bir vektörün çarpımıdır.Matris birkaç evrişim çekirdeğine karşılık gelir ve vektör, çevreleyen karelerin yanıt değerine (ResponseValue) karşılık gelir.

Herkes matrisleri ve vektörleri çarpmanın çok fazla hesaplama gerektirdiğini bilir. Burada verdiğim örnek o kadar büyük değil ama bir düşünün, 100 giriş çıkış kanalı varsa, evrişim çekirdeği 3 × 3 × 100 ise 100 × 900 hesaplamaları bu hesaplama çok ağır. Büyük, bu nedenle işin çoğu artıklık (evrişim işlemi) sorununu çözmeye odaklanmıştır.

Düşük hassasiyetli çekirdekler (düşük hassasiyetli evrişimli çekirdek)

Artıklık sorununu çözmenin herhangi bir yolu var mı?

Evrişim çekirdeği genellikle bir kayan nokta sayısı olduğundan, bir kayan noktalı sayının hesaplama karmaşıklığı biraz daha büyüktür ve biraz daha fazla yer kaplar. En kolay numara nedir? Evrişim çekirdeğinin 1, -1 gibi ikili bir çekirdeğe dönüştürüldüğünü varsayarsak, 1, -1'i 1'e dönüştürmenin faydası nedir görelim? Bu vektör 1, -1 (yapar) orijinal çarpma işlemini toplama ve çıkarma olur, bu nedenle hesaplama miktarı çok azalır. Ayrıca model ve depolama hacmi de çok azaltılır.

Kayan nokta türünü bir tam sayı türüne dönüştürmek için benzer bir ilgili çalışma da vardır.Örneğin, önceki 32 bitlik kayan noktalı sayı 16 bitlik bir tam sayı türü haline gelir ve depolama kapasitesi de küçük olur veya model küçük olur. Evrişim çekirdeğinin ikilileştirilmesine veya tamsayıya dönüştürülmesine ek olarak, Yanıt ayrıca bir ikili sayıya veya bir tam sayıya dönüştürülebilir.

Başka bir araştırma türü daha niceldir. Örneğin, 2.91, 3.06 ve 3.21 gibi bu matrisi tek bir kategoride kümelemek, niceleme yerine 3'ü kullanmanın faydaları nelerdir? Her şeyden önce, depolama alanınız azalır, orijinal değeri saklamanıza gerek yoktur, sadece nicemlemeden sonra her merkezin indeks değerini saklamanız gerekir. Ek olarak, hesaplama miktarı da küçüldü.Çarpma sayısını azaltmanın bir yolunu bulabilirsiniz, böylece model boyutu küçülür.

Düşük sıralı çekirdekler (düşük sıralı evrişim çekirdeği)

Başka bir şekilde, matris büyükse ne yapmalıyım? Matrisi küçültün, pek çok kişi bunu yaptı, 100 (çıktı) kanal, ben onu 50 olarak değiştirdim, bu bir numara. Bir başka numara da çok sayıda giriş, 100 kanal ve 50 kanal olmasıdır.

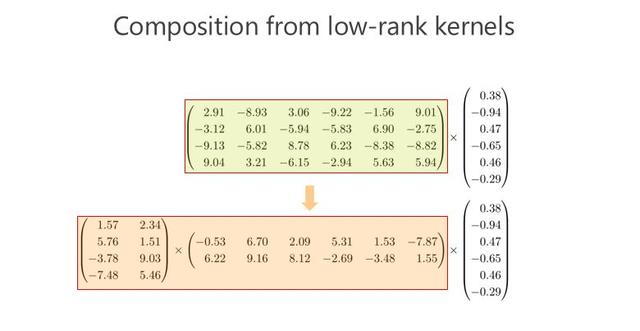

Düşük sıralı evrişim çekirdeklerinin kombinasyonu

Kanal sayısını azaltmak performansı düşürür mü? Yani birisi şunu yaptı: bu matrisi iki küçük matrise çarpın, eğer bu matris 100 × 100 ise, onu 100 × 10 ve 10 × 100 iki matrise dönüştürüyorum (çarpın Ortaya çıkan matris) ayrıca 100 × 100 matris haline gelir ve bu da orijinal 100 × 100 matrise yaklaşır. Şöyle düşünün, 100 × 100100 × 10 ve 10 × 100 oluyor Açıkçası model küçülüyor ve beşte bir oluyor. Ek olarak, hesaplama miktarı beşte bir oranında azaltılır.

Seyrek evrişim çekirdeği

Başka bir yol, matris ve vektörü nasıl daha hızlı ve model parametrelerini daha az çarpabiliriz? Bazı sayıları 0 olarak değiştirebilirsiniz, örneğin 2,910 olur, 3,060 olur ve 0 olduktan sonra seyrek matris olur. Bu seyrek matrisin depolama kapasitesi küçülür. Yeterince seyrek olursanız hesaplama miktarı olur Küçük, çünkü doğrudan 0 olduğu için çarpmaya gerek yok. Ayrıca bu diyagonal form gibi bir Yapılandırılmış seyrek (yapılandırılmış seyrek) vardır, matris ve vektör çarpımı çok iyi optimize edilebilir. Burada Yapılandırılmış seyreklik, daha sonra bahsedeceğim Grupçevrimine karşılık gelir.

Seyrek evrişim çekirdeklerinin kombinasyonu

Bakalım bu matris, çoklu seyrek matrislerle çarpılarak kestirilip kestirilemeyecek Bu, bugün hakkında konuşmak istediğim şeyin odak noktasıdır. Çalışmamız da bu noktada ilerliyor. Bu yönü yapmadan önce, küçük model ve düşük hesaplama karmaşıklığı hedefine ulaşmak için bir matrisin iki seyrek matrisle veya hatta birden fazla seyrek matrisle çarpılabileceğinin farkında değildi.

IGCV1'den IGCV3'e

IGCV1

Öncelikle geçen yıl ICCV 2017 konferansında serpiştirilmiş grup evrişimi yöntemi olan makalemizi size tanıtayım.

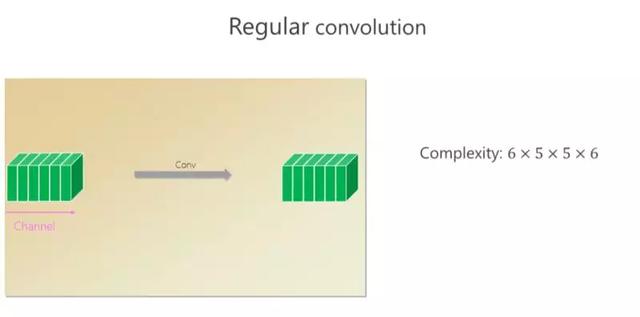

Bu evrişimde altı kanal vardır ve evrişim ile altı küçük kare (kanal) elde edilir.Uzamsal çekirdeğin boyutu 5 × 5 ise her konum için hesaplama miktarı 6 × 5 × 5 × 6.

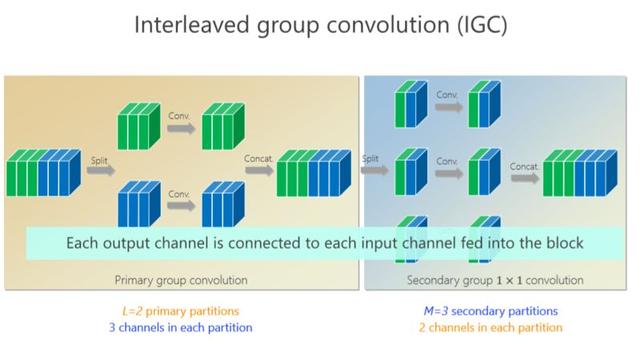

Az önce grup evrişimi biçimine karşılık gelen (yapılandırılmış) seyrek biçimden bahsettim Grup evrişimi ne anlama geliyor? 6 kanalı üst 3 kanala, alttaki 3 kanala böldüm ve ayrı ayrı çevirdim Evrişimi bitirdikten sonra bir araya getirdim ve sonunda 6 kanalı aldım. Hesaplama miktarına bakın, üst 3 × 5 × 5 × 3 ve alt kısım aynıdır.Toplam hesaplama karmaşıklığı önceki 6 × 5 × 5 × 6'nın yarısı kadar küçüktür, ancak sorun, parametre kullanımının yeterli olmamasıdır.

Çalışmalarımız grup evrişimine dayanıyor, biraz önce yukarıdaki üç kanalın bu üç kanalla ilgili olmadığını söylemiştim, bunları ilişkilendirmenin bir yolu var mı? Böylece ikinci bir grup evrişimi tanıttık. 6 kanalı yeniden düzenledik, buraya 1, 4 (birinci dal), buraya 2, 5 (ikinci dal) ve 3 , 6, buraya yerleştirilir (üçüncü dal), böylece her dal, iki yeni kanal, iki kanal ve iki kanal elde etmek için tekrar 1 × 1 evrişim yapacak ve bunları bir araya getirecektir. Serpiştirme yöntemiyle, her bir çıkış kanalının (yeşil kanal veya mavi kanal) önceki 6 kanala bağlı olmasını umuyoruz.

faydası nedir? Tamamlayıcı koşullar, ikinci grup konvolüsyon grubu aracılığıyla elde edilebilir veya herhangi bir çıkış (çıkış kanalı) ve herhangi bir giriş (giriş kanalı) bağlanabilir.

Burada katı bir tamamlayıcı koşul getirdik: Sezgisel olarak konuşursak, eğer birinci grupta iki kanal varsa ve aynı dala düşerse, ikinci grupta farklı dallara düşmeyi umuyorum. (Şube). İkinci grupta, örneğin, bir Daldaki bir dizi kanal, birinci grubun evrişiminde tüm Dallardan gelmelidir, buna tamamlayıcı koşul denir. Bu tamamlayıcı koşul ne getiriyor? Yol (herhangi bir giriş ve çıkış kanalı çifti arasındaki varlığı) getirecektir, bu da çarpım matrisinin yoğun bir matris olduğu anlamına gelir. Neden "katı" deniyor? Yani, herhangi bir girdi ve çıktı arasında bir yol vardır ve yalnızca bir yol vardır.

Sıkı yönergelerin uygulamaya konmasından sonra, parametrelerin miktarı küçüldü ve model küçüldü.Faydaları nelerdir? Burada bir sonuç veriyorum, L (birinci) grup evrişimdeki bölümlerin veya evrişimlerin sayısı, M ikinci gruptaki evrişim evrişimlerinin sayısı, S evrişim çekirdeğinin boyutu, Genellikle 1'den büyüktür. Böyle bir eşitsizlik neredeyse sabittir, bu eşitsizlik ne anlama geliyor? Sonuç şudur: ortak standart evrişim ile karşılaştırıldığında, ağ tasarım yöntemimiz aracılığıyla genişletilebilir. Ağın derinleşmesi ile karşılaştırıldığında ağın genişlemesi başka bir boyuttur Genişletmenin faydaları nelerdir? Sonucu daha iyi hale getirecek mi? Bazı deneyler yaptık.

Bu deney standart evrişim ile karşılaştırılmıştır. Sol alt köşedeki tabloya bakalım. Bu tablo parametre miktarıdır. Tasarladığımız ağ, standart (evrişim) parametre miktarının neredeyse yarısıdır. Sonra sağ alt köşedeki ağa bakın, hesaplamamız neredeyse yarısı. CIFAR-10 standart görüntü sınıflandırma veri setinde (yukarıdaki tablo), sonuçlarımız öncekinden daha iyidir. Hatta 20. katta ne kadar derin olursa o kadar iyi, bazı gelişmelerin o kadar belirgin olmadığını, ancak derin olduğunda 1.43'e ulaşabileceğini göreceğiz.

Daha sonra, CIFRA-100 ile aynı deneyi yaptık ve geliştirmemizin hala aynı olduğunu ve hatta bir öncekinden daha büyük olduğunu gördük, çünkü 100 kategoriyi 10 kategoriye ayırmak biraz daha zor, görev ne kadar zor olursa, bizim avantajımız Daha açık. Bu genişleme (performans), IGC uygulaması yoluyla gerçekten iyileştikten sonra, ağ yapısının genişletilmesi gerçekten de fayda sağlayacaktır.

Bunlar iki küçük veri setidir.Aslında, bilgisayar görüşü alanında, küçük veri setlerindeki sonuçlar problemi (tamamen) açıklayamaz, bu nedenle çok büyük bir veri seti yapılmalıdır. O zaman ImageNet veri setini de yaptık ve ResNet ile karşılaştırdık.Parametrelerin miktarı neredeyse beşte iki azaltıldı, hesaplama miktarı neredeyse yarı yarıya azaldı ve hata oranı azaldı. Bu, IGC'nin uygulanmasının model değişikliğine neden olduğunu kanıtlıyor Geniş, büyük ağ modellerinde çok iyi sonuçlar elde edin.

Muhtemelen bunu geçen yılın Ağustos veya Eylül ayında yapmaya başladık Ekim ayında Google'ın Xception adında bir işi olduğunu keşfettik.Bu onun yapı diyagramıdır.Bu form çok yakın (bizim yapımız) ve daha önce dediğimiz IGC yapısına çok benziyor. Aslında bu bizim özel bir durumumuz. O zaman, bu özel vakanın en iyi sonuca sahip olabileceğini düşündük, bu yüzden biraz doğrulama yaptık ve genel olarak yapımız daha iyi.

IGC'nin çeşitleri olabilir, mesela bu kanal bazında bir grup evrişimine çevirirsem ikincisi 1 × 1 olur, sonuca ne olur? Benzer bir deney yaptık ve yine de yöntemimizin en iyisi olduğunu gördük.

Bunu yaptığımızda, ağ yapısını son teknoloji yöntemle karşılaştırmayı umuyorduk.Çok iyi sonuçlar elde ettik.O zamanlar işimiz fazlalığı ortadan kaldırarak model performansını veya doğruluğunu artırmaktı.

IGCV2

Daha sonra, bu modeli cep telefonlarına yaymak için fazlalığı ortadan kaldırmanın faydalarını kullanmaya çalıştık. Bu sorunu daha derinlemesine anlamak için geçen yıl bu yönde ilerlemeye devam ettik ve fazlalığı daha da ortadan kaldırmayı umuyoruz.

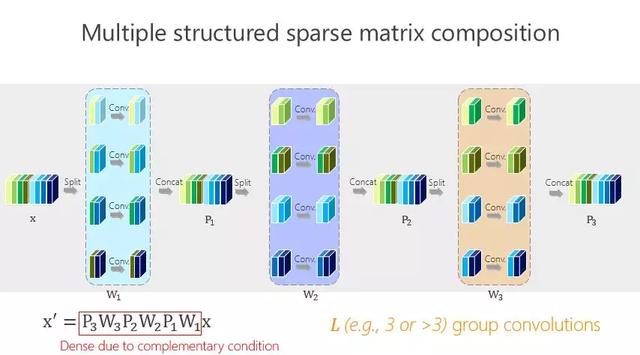

Bu daha basit veya daha basittir Önceki ağ yapısı, iki grubun evrişimi veya iki matrisin çarpımı ile elde edilir.Bunu daha fazla yapabilir miyiz? Yukarıdaki şekilde gösterildiği gibi aslında çok basit.

Bu yöntemin faydası çok basittir Parametrelerin miktarının olabildiğince küçük olması umulmaktadır, öyleyse parametrelerin miktarı olabildiğince küçük nasıl (yapılabilir)? Sözde denge koşullarını getirdik. L-11 × 1 grup konvolüsyonlarımız olmasına rağmen, L-11 × 1 grup konvolüsyonları arasında fark var mı? Kim daha önemli ve kim değil? Aslında bilmiyoruz. Ne yapacağını bilmiyor musun? Sadece aynısını yap. Aynı şekilde, yukarıdaki matematiksel sonuçları basit matematiksel türetme yoluyla elde edebiliriz.

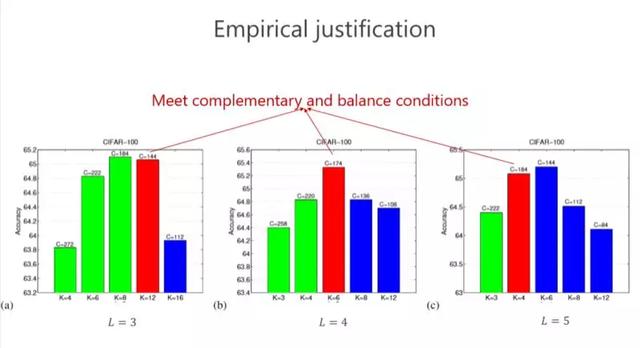

Şimdi tekrar doğrulayalım Tamamlayıcı koşullar ve denge koşullarından bahsettik. Bu en iyi sonuç mu? Yoksa yeterli bir avantaj var mı? Bazı deneyler yaptık ve kırmızı olan, koşullarımızı karşılayana karşılık geliyor ve bu durumda (L = 4) sonucun en iyisi olduğunu gördük. Her zaman en iyisi mi? Mutlaka değil, çünkü asıl sorun teorik analizden hala biraz uzak. Bununla birlikte, genellikle kırmızı olanların temelde en iyi olmadığını ve ikinci sırada yer aldığını gördük, bu da bu tasarımın en azından bize ağ yapısını tasarlamaya yardımcı olacak iyi yönergeler verdiğini gösteriyor. Bu her zaman en iyisi olmasa da, en iyisi ile hemen hemen aynıdır.

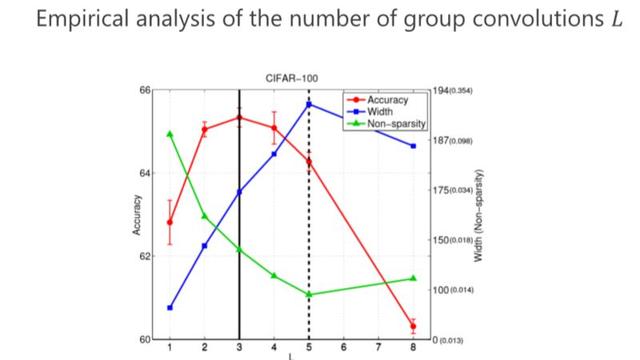

İkinci soru, kaç tane grup evrişimi tasarlamalıyız (ne kadar L'ye ayarlı)? Benzer şekilde, kriterimiz de en küçük parametre miktarı ile analiz edilir.Geçmişte bu iki gruplu bir evrişimdi. 3 veya 4 ile daha küçük bir parametre miktarına ulaşabiliriz, ancak aslında nihai sonuç, bunun optimal parametre miktarı olmadığıdır. Performans en iyisidir.

IGCV3

Daha sonra, katı tamamlayıcı koşullar takip edilirse, modelin yapısının çok seyrek ve çok geniş olduğunu ve sonucun mutlaka en iyi olmadığını gördük. Böylece Gevşek olduk. Gevşek ne anlama geliyor? Geçmişte, çıkış (çıkış kanalı) ile giriş (giriş kanalı) arasında tek bir yol vardı, çok basit bir şekilde değiştirdik, birden fazla yolumuz olabilir mi? Birden çok yol çok seyrek değildir Avantajı, her çıktının (çıkış kanalı) birden çok yoldaki girişten (giriş kanalı) bilgi alabilmesidir, bu yüzden Gevşek koşulunu tasarladık.

Aslında çok basittir, iki süper kanalın aynı anda yalnızca bir Dalda görünebileceğini ve Gevşek durumu elde etmek için aynı anda iki Dalda görünemeyeceğini tanımlıyoruz.

Daha sonra daha da ileri gittik ve yapılandırılmış seyrek ve düşük sırayı birlikte grupladık. Bunu ImageNet'te karşılaştırıyoruz ve aynı zamanda MobileV2 ile karşılaştırıyoruz.Küçük modelde, avantajımız giderek daha belirgindir. Karşılaştırma sonucu aşağıdaki şekilde gösterilmektedir.

Bugünün ana içeriği budur.Bu işi birçok öğrenci ve meslektaşımla yaptım. İlk beşi benim öğrencilerim. Ting Zhang şu anda Microsoft Araştırma'da çalışıyor, Bin Xiao meslektaşım ve Guojun Qi Amerika Birleşik Devletleri'nden. Profesör, bu makale üzerinde işbirliği yaptık.

-

- Tianhe Caddesi, insanların memnun kalacağı bir "kırmızı mülk" inşa etmek için her türlü çabayı göstermektedir

-

- Zorlu sorunlarla başa çıkmada "Dört Giriş" e yardımcı olun ve iş ve üretimin yeniden başlamasına hizmet edin! Liaocheng Tarım Bilimleri Akademisi iş başında

-

- Atılımlar yapın ve birinci sınıf için çabalayın Huancui Bölgesindeki tüm kasabalar zorlu, gerçek ve yeni hareketler gösterdi

-

- Öğretmenlerin ve öğrencilerin güvenliğini sağlayın! Shandong genelinde okul açılış koşullarının doğrulanması şu şekilde gerçekleştirilir

-

- Bahar geldiğinde cilt tekrar tekrar kaşıntılı, şiş ve ağrılı olacaktır.Kürdeşen kurtulmanın bir yolu var mı?

-

- Liantang'da, en güzel "yuva" gücünü sunmak için topluluğun "savaş salgını" ile yan yana dört kişilik bir aile