Derin öğrenme sıkıştı: teknik kusurlar hiç çözülemiyor ve algoritma alanında büyük bir ilerleme yok

Xinzhiyuan önerilir

Kaynak: Yun Toutiao

Xin Zhiyuan Rehberi Derin öğrenmenin bir sonraki durağı nedir? Geçen yıl, algoritma alanında büyük bir gelişme olmadı. Bu makalenin yazarı William Vorhies, DataScienceCentral'ın yayın direktörüdür. Data-Magnum'un başkanı ve baş veri bilimcisi ve EB5C'nin başkanı olarak görev yapmıştır. Bu alanda bir sonraki büyük atılımı gerçekleştirmesi beklenen birkaç önde gelen teknolojiyi araştırmıştır.

Sıkıştık ya da en azından bir darboğaz dönemindeyiz.

Algoritmalar, yongalar veya veri işlemede bir yıl boyunca en son ne zaman büyük ve önemli gelişmeler olmadığını kim hatırlıyor? Birkaç hafta önce Strata San Jose Konferansı'na katıldım, ancak gözle görülür yeni gelişmeler görmedim, o kadar sıra dışı bir durumdu ki.

Daha önce de bildirdiğim gibi, olgun bir aşamaya girmiş gibiyiz. Şimdi ana odak noktamız, tüm güçlü yeni teknolojilerin birlikte iyi çalışmasını sağlamak (birleşik platformlar) veya bu büyük ölçekli girişim yatırımlarından getiri elde etmektir.

Bu sorunu fark eden tek kişi ben değilim. Birkaç katılımcı ve katılımcının görüşleri benimkine çok benziyor. Bir gün birçok tanınmış araştırmacıdan araştırma notları aldım.Farklı gelişmiş analiz platformlarının göreceli faydalarını değerlendiriyorlar ve raporlamaya değer farklı hiçbir şeyin olmadığı sonucuna vardılar.

Neden sıkıştık? Nerede sıkışmış?

Şu anki durumumuz aslında çok da kötü değil. Geçtiğimiz iki veya üç yılda, ilerlememiz derin öğrenme ve pekiştirmeli öğrenme alanında oldu. Derin öğrenme bize konuşma, metin, görüntü ve videoyu işlemede mükemmel işlevler getirdi. Takviye öğrenme ile birleştiğinde, oyunlarda, sürücüsüz araba kalem robotlarında vb. Önemli ilerleme kaydettik.

Sohbet robotları aracılığıyla müşteri etkileşimlerini büyük ölçüde basitleştirmek, yeni kişisel kolaylık uygulamaları (kişisel asistanlar ve Alexa gibi) ve özel araçlarda ikincil otomasyon (adaptif gibi) gibi bu teknolojilere dayalı ticari patlayıcı geliştirmenin ilk aşamalarındayız. Seyir kontrolü, kazadan kaçınma freni ve şerit bakımı).

Tensorflow, Keras ve diğer derin öğrenme platformlarının kullanımı her zamankinden daha kolay ve GPU'lar sayesinde her zamankinden daha verimli.

Bununla birlikte, bilinen bir dizi eksiklik hiç çözülmedi.

Çok fazla etiketli eğitim verisine ihtiyacınız var.

Modelin eğitilmesi çok uzun veya çok fazla pahalı kaynak gerektirir, ancak yine de eğitilmesi imkansız olabilir.

Özellikle düğümlerin ve katmanların hiperparametreleri hala çok gizemlidir. Otomasyon ve hatta geniş çapta kabul gören genel kurallar hala çok uzaktadır.

Transfer öğrenimi yalnızca, bir mantıksal sistemden diğerine değil, karmaşıktan basite geçiş anlamına gelir.

Eminim daha fazla sorun vardır. Bu büyük eksiklikleri çözmekte sıkışıp kaldık.

Bizi hareketsiz kılan nedir?

Örnek olarak derin sinir ağını (DNN) ele alalım: Şu anda geleneksel görüş, ilerlemeye ve yatırım yapmaya devam edersek bu eksikliklerin üstesinden gelineceğine inanıyor. Örneğin, 1980'lerden 2000'lere kadar, DNN'yi nasıl çalıştıracağımızı biliyorduk, ancak buna karşılık gelen hiçbir donanım yoktu. Bu problemin üstesinden gelindiğinde, DNN yeni açık kaynak konseptleriyle birleştirildiğinde, bu yeni alandaki darboğazı kıracaktır.

Her tür araştırmanın kendi geliştirme ivmesi vardır, özellikle belirli bir yönde çok fazla zaman ve finansal kaynak yatırdığınızda, bu yönde ilerlemeye devam edeceksiniz. Yıllarca bu becerilerde uzmanlık geliştirmek için harcadıysanız, kursunuzu kolayca değiştiremezsiniz.

Doğru yönün ne olduğundan tam olarak emin olmasanız bile, yönü değiştirin

Bazen yeni yönün tam olarak ne olduğunu bilmesek bile yön değiştirmemiz gerekir. Son zamanlarda önde gelen Kanadalı ve Amerikalı AI araştırmacıları tam da bunu yaptı. Yanlış yönlendirildiklerini ve özü itibariyle yeniden başlamaları gerektiğini düşünüyorlar.

Geçen sonbaharda, Geoffrey Hinton bu anlayışı pratik eylemlerle yorumladı ve 1980'lerde DNN alanındaki öncü çalışmalarıyla ünlendi. Hinton şu anda Toronto Üniversitesi'nde emeritus bir profesör ve bir Google araştırmacısı ve şu anda DNN'nin temel yöntemi olan geri yayınlama konusunda "son derece şüpheli" olduğunu söyledi. Hinton, sonuç çıkarmak için insan beyninin tüm bu etiketli verilere ihtiyaç duymadığını gözlemledi ve "Benim amacım, geri yayımı bir kenara bırakın ve sıfırdan başlayın" dedi.

Bunu göz önünde bulundurarak, yeni yönleri kısaca inceleyelim. Bazıları çok güvenilir, bazıları gerçekçi değil, ancak hiçbiri bildiğimiz derin sinir ağları için artımlı iyileştirmeler değil.

Açıklamanın içeriği kasıtlı olarak kısadır ve şüphesiz tam bir anlayış için sizi daha fazla okumaya yönlendirecektir.

DNN'ye benzeyen ancak olmayan teknoloji

Hinton'un geri yayılım görüşünü destekleyen ve düğümlerin ve katmanların temel yapısının yararlı olduğuna ancak bağlantı ve hesaplama yönteminin büyük ölçüde değiştirilmesi gerektiğine inanan bir dizi çalışma var.

Kapsül Ağı (CapsNet)

Hinton'un yeni araştırma yönetimi CapsNet ile başlayalım. Bu, CNN'in görüntü sınıflandırmasıyla ilgilidir; basitçe söylemek gerekirse, sorun, evrişimli sinir ağının (CNN) nesnenin pozuna duyarlı olmamasıdır. Başka bir deyişle, aynı nesne tanınırsa, ancak konum, boyut, yön, deformasyon, hız, yansıtma, renk ve doku farklıysa, bu durumların her biri için eğitim verisi eklemeniz gerekir.

CNN'de bu, eğitim verilerinin büyük ölçüde artırılması ve / veya genelleştirilebilen maksimum havuz katmanının artırılmasıyla ele alınır, ancak gerçek bilgiler tamamen kaybolur.

Aşağıdaki açıklama, CapsNets'teki birçok mükemmel teknik açıklamadan birinden geliyor, bu da Hackernoon'dan geliyor.

Kapsül, bir dizi iç içe geçmiş sinir tabakasıdır. Yani normal bir sinir ağında, daha fazla katman eklemeye devam edersiniz. CapsNet'te, bir katmanın içine daha fazla katman ekleyeceksiniz. Veya başka bir deyişle, bir nöral katmanı başka bir nöral katmanın içine yerleştirin. Kapsüldeki nöronun durumu, görüntüdeki bir varlığın yukarıdaki özelliklerini yakalar. Kapsül, varlığın varlığını temsil eden bir vektör çıkarır. Vektörün yönü, varlığın niteliklerini temsil eder. Bu vektör, sinir ağındaki tüm olası ebeveynlere gönderilir. Tahmin vektörü, kendi ağırlığı ile ağırlık matrisi çarpılarak hesaplanır. Hangi ebeveyn düğümün en büyük skaler tahmin vektör ürününe sahip olduğu önemli değil, kapsül bağı artacak ve diğer ana düğümler kapsül bağını azaltacaktır. Bu anlaşma yoluyla yönlendirme yöntemi, maksimum havuzlama gibi mevcut mekanizmalardan daha üstündür.

CapsNet, gerekli eğitim setini büyük ölçüde azaltır ve erken testler, görüntü sınıflandırmada daha iyi performansa sahip olduğunu gösterir.

gcForest

Bu yılın Şubat ayında, Nanjing Üniversitesi Yeni Yazılım Teknolojisi Eyalet Anahtar Laboratuvarından Zhou Zhihua ve Feng Ji'nin araştırma sonuçlarını tanıttık ve gcForest adlı bir teknolojiyi gösterdiler. Araştırma kağıtları, gcForest'in hem metin sınıflandırmasında hem de görüntü sınıflandırmasında genellikle CNN ve RNN'den daha iyi performans gösterdiğini gösteriyor. Avantajları oldukça açık.

Eğitim verilerinin yalnızca küçük bir kısmı gereklidir.

GPU'suz sıradan masaüstü CPU cihazlarında çalışabilir.

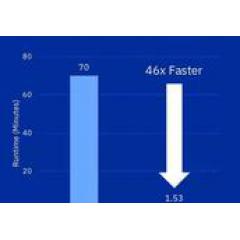

Eğitim aynı derecede hızlıdır ve çoğu durumda daha da hızlıdır, dağıtılmış işlemeye uygundur.

Çok daha az hiperparametre vardır ve varsayılan ayarlar altında iyi performans gösterir.

Tamamen opak derin sinir ağları yerine anlaşılması kolay rastgele ormanlara güvenin.

Kısacası, gcForest (çok taneli basamaklı orman) bir karar ağacı entegrasyon yöntemidir.Derin ağın kademeli yapısı korunur, ancak opak kenarlar ve düğüm nöronları tamamen rastgele ağaç ormanlarından oluşan rastgele bir orman grubu ile eşleştirilir. Değiştirin. GcForest hakkında daha fazla bilgi için lütfen orijinal makalemize katılın (https://www.datasciencecentral.com/profiles/blogs/off-the-beaten-path-using-deep-forests-to-outperform-cnns -ve-rnn).

Pyro ve Edward

Pyro ve Edward, derin öğrenme çerçevelerini olasılıklı programlamayla bütünleştiren iki yeni programlama dilidir. Pyro, Uber ve Google'ın bir başyapıtıdır ve Edward, Columbia Üniversitesi'nden doğmuştur ve Savunma İleri Araştırma Projeleri Ajansı'ndan (DARPA) fon almıştır. Sonuç olarak, çerçeve, derin öğrenme sistemlerinin tahminlerde veya kararlarda ne kadar emin olduklarını ölçmelerine olanak tanır.

Klasik tahmine dayalı analizde, günlük kaybını uygun bir işlev olarak kullanabilir ve bu sorunu çözmek için kendinden emin ancak yanlış tahminleri (yanlış pozitifler) cezalandırabiliriz. Şimdiye kadar derin öğrenme için kaçınılmaz bir sonuç yok. (Şimdiye kadar derin öğrenmenin bir sonucu yok.)

Örneğin, bunun kendi kendine giden arabalar veya uçaklar için geçerli olması beklenir, böylece kontrol sistemi büyük bir karar vermeden önce belirli bir güven duygusuna veya şüpheye sahip olur. Elbette bu, Uberin sürücüsüz araçlarının siz arabaya binmeden önce bilmesini istediğiniz şeydir.

Hem Pyro hem de Edward, gelişimin ilk aşamalarındadır.

Derin bir ağ yöntemi gibi görünmüyor

Çekirdekte alışılmadık algoritmalar kullanan platformlar geliştiren küçük şirketlerle sık sık karşılaşıyorum. Çoğu durumda, okuyucular için platform algoritmasının genel görünümünü açıklayabilmem için yeterli ayrıntılı bilgi sağlamak konusunda isteksiz olduklarını görüyorum. Bu gizlilik, onların kullanımını etkilemez, ancak bazı kıyaslama sayıları ve bazı ayrıntılar sağlamazlarsa, size dahili olarak ne olduğunu gerçekten söyleyemem.

Şu anda üzerinde çalıştığım en gelişmiş DNN dışı algoritmalar ve platformlar aşağıdaki gibidir:

Hiyerarşik Zaman Belleği (HTM)

Hiyerarşik zamansal bellek (HTM), beynin nöronlarını modellemek ve hesaplamalar yapmak için seyrek dağıtılmış gösterimi (SDR) kullanır. Skaler tahmindeki performansı (emtiaların gelecekteki değeri, enerji veya hisse senedi fiyatları) ve anormallik tespiti CNN ve RNN'den daha iyi.

Bu, Palm Pilot'un ünlü Jeff Hawkins'in (Jeff Hawkins) Numenta şirketinde çalışmasının bir sonucudur. Hawkins, beyin işlevi üzerine temel araştırmalara dayanan güçlü bir AI modeli bulmaya kararlıdır, DNN'deki katmanların ve düğümlerin yapısını kullanmaz.

HTM'nin özelliği, modellerin çok hızlı bir şekilde bulunabilmesi ve yalnızca 1.000 gözlem gerektirmesidir. Aksine, bir CNN veya RNN eğitimi yüzbinlerce hatta milyonlarca gözlem gerektirir.

Ek olarak, örüntü tanıma denetimsizdir ve sürekli değişen girdilere dayalı olarak kalıplardaki değişiklikleri gerçek zamanlı olarak tanıyabilir ve genellemeye genişletebilir. Bu nedenle, elde edilen sistem sadece çok hızlı eğitilmekle kalmaz, aynı zamanda kendi kendine öğrenme ve kendi kendine adaptasyon özelliklerine sahiptir ve veri değişiklikleri veya girişim bilgileri (gürültü) ile rahatsız edilmeyecektir.

Şubat makalemizde HTM ve Numenta'yı tanıttık, bu yüzden okumanızı tavsiye ederim (https://www.datasciencecentral.com/profiles/blogs/off-the-beaten-path-htm-based-strong-ai-beats- rnns-ve-cnns-at-pr).

Bahsetmeye değer bazı artımlı iyileştirmeler

Bu alanı gerçekten değiştiren teknolojilere odaklanmaya çalışıyoruz, ancak artımlı iyileştirmelerin en az iki örneğinden bahsetmeye değer. Bunlar açıkça hala tipik CNN ve RNN'dir (geri yayılma elemanlarıyla birlikte), ancak daha iyi çalışırlar.

Ağ budama için Google Cloud AutoML'yi kullanın

Google ve Nvidia'daki araştırmacılar, çıktıyı doğrudan etkilemeyen nöronları ortadan kaldırmak için ağ budaması adı verilen bir yöntem kullanıyor ve bu da sinir ağını daha küçük ve daha verimli hale getiriyor. Bu son ilerleme, Google'ın yeni AutoML platformundaki önemli performans iyileştirmelerinden kaynaklanmaktadır.

Transformatör

Transformer, orijinal olarak CNN, RNN ve LTSM'nin mükemmel olduğu alanda yararlı olan yeni bir yöntemdir: dil işleme (dilden dile çeviri gibi). Geçen yaz, Google Brain ve Toronto Üniversitesi'nden araştırmacılar, bu İngilizce / Almanca çeviri testi de dahil olmak üzere çok sayıda testte doğrulukta önemli gelişmeler gösteren Transformer'ı yayınladı.

RNN, sıralı işleme özelliklerine sahiptir, bu nedenle sıralı işlemden çok paralel işlemede iyi olan GPU'lar gibi modern hızlı bilgi işlem cihazlarının performansını tam anlamıyla sağlamak daha zordur. CNN'nin sıralı işleme özellikleri, RNN'den çok daha zayıftır, ancak CNN mimarisinde, girişin uzak kısmından gelen bilgileri birleştirmek için gereken adım sayısı yine de mesafe ile artar.

Doğruluktaki atılım, adımları küçük ve sabit bir adıma önemli ölçüde azaltan "öz-dikkat işlevinin" geliştirilmesinden gelir. Her adımda, kendi pozisyonlarına bakılmaksızın cümledeki tüm kelimeler arasındaki ilişkiyi doğrudan modellemek için öz-dikkat mekanizmasını kullanır.

Lütfen orijinal araştırma makalesini buradan okuyun (https://papers.nips.cc/paper/7181-attention-is-all-you-need.pdf).

Sonuç: Belki yön değiştirme zamanı

Göz ardı edilemeyecek bir gerçek, Çin'in yapay zekaya yoğun bir şekilde yatırım yaptığıdır; belirlenen hedef, birkaç yıl içinde Amerika Birleşik Devletleri'ni geçmek ve küresel bir yapay zeka lideri olmaktır.

Steve LeVine, Axios'un gelecekteki editörü ve Georgetown Üniversitesi'nde ders veriyor. Yazdığı bir makalede, Çin'in hızlı bir şekilde takip edebileceğine inanıyordu ama korkarım hiçbir zaman yetişemeyecek. Bunun nedeni, Amerika Birleşik Devletleri ve Kanada'daki araştırmacıların istedikleri zaman yön değiştirip sıfırdan başlayabilmeleridir. Kurumsal yönelimli Çinliler bunu asla yapamayacaklar. Aşağıdakiler Levinein makalesinden alınmıştır:

Seattle'daki Outreach.io'nun CEO'su Manny Medina, "Çin'de bu hayal edilemez," dedi. Facebook'tan Yann LeCun ve Toronto Vector Institute'tan Geoff Hinton gibi yapay zeka yıldızlarının "onay istemelerine gerek olmadığını, araştırmaya başlayıp ilerleyebileceklerini belirtti. "

Risk kapitalistlerinin dediği gibi, yön değiştirme zamanı gelmiş olabilir.

-

- Hanchuan Yaşlılar Kültür ve Spor Derneği, yaşlılara saygı duyma ve onları sevme gösterisi gerçekleştirmek için Glory Enstitüsüne gitti.

-

- Büyük ulusal gençleşmenin yeni yolculuğunda gençlerin çiçek açmasına izin verin Shenhu Kasabası, Dördüncü Mayıs Gençlik Günü anma etkinliklerini başlatıyor