Makine öğrenmiyor: Jingdong perakende ticaretinde BERT modelinin uygulama uygulaması

JD Perakende Veri Merkezi ve Tayvan Ortak Platformu Ekoloji Departmanı, Platform İş Merkezi, Moda ve Elektronik Eğlence ve diğer iş grupları - JD perakende işini güçlendirmek ve satıcı ve kullanıcı deneyimini geliştirmek için bilgi hesaplama platformu-emtia bilgi grafiğini birlikte kullanın

arka fonJD Retail, çevrimiçi ve çevrimdışı fiziksel ve sanal işlemler gibi çeşitli işlem senaryolarını kapsayan dünyanın en büyük perakendecilerinden biridir. Şu anda, günlük efektif emtia sayısı yaklaşık 3 milyar olup, ilgili günlükler ve içerik PB düzeyine ulaşmıştır. Bu muazzam miktardaki veriler arasında, doğal dil işleme ve bilgisayar vizyonunu içeren birçok uygulama vardır. Algoritmalar ve veriler tarafından yönlendirilen, çok senaryolu kullanıcı deneyimine ve işlem iyileştirmesine büyük iyileştirmeler getirir. Metin işleme görevlerinde BERT'nin mükemmel performansı nedeniyle Ayrıca, e-ticaret metin sınıflandırmasında, ürün başlıklarının sıralı etiketlemesinde ve diğer görevlerde BERT modelini araştırıyor ve ilgili pratik deneyimleri özetliyoruz.

BERT modeline girişBERT (Transformers'dan Bidirectional Encoder Representation from Transformers), Ekim 2018 sonunda Google tarafından yayınlanan, Transformer tabanlı derin iki yönlü kodlanmış metin temsil modelidir. Model ön eğitimi + görev ince ayarı aracılığıyla 11 temel NLP görevinde görüntülenir Olağanüstü performansının dışında, NLP alanında ve tüm makine öğrenimi endüstrisinde büyük bir yangın haline gelen bir model haline geldi. BERT'nin ortaya çıkışı, ön eğitim kelime vektör modeli çerçevesi ile aşağı akışa özgü NLP görevleri arasındaki ilişkiyi tamamen değiştirdi, aşağı akış NLP görevlerinin odağını yukarı akış metin dinamik temsiline kaydırdı ve kelime vektör modelinin genelleme yeteneğini ve dinamik ifade yeteneğini daha da artırarak elde etmek için Karakter seviyesi, kelime seviyesi, cümle seviyesi ve hatta cümleler arasındaki ilişkinin amacını tam olarak tanımlayın.

BERT'nin genel çerçevesi aşağıdaki gibidir: Şekil 1 Gösterilen: Model mimarisi, Bi-LSTM yerine çok katmanlı çift yönlü transformatör kodlamasına dayanmaktadır, bu da modelin daha derin katman sayısına ve daha iyi paralelliğe sahip olmasını sağlayabilir. Eğitim öncesi yöntemde, sırasıyla kelime ve cümle düzeyinde anlamsal ve sözdizimsel özellikleri yakalamak için iki kayıp işlevi, Maskelenmiş LM ve Sonraki Cümle Tahmini seçilir.

BERT'in giriş kısmı doğrusal bir dizidir (örneğin şekil 2 Gösterildiği gibi), iki cümle bir ayırıcıyla (SEP) ayrılır ve iki tanımlayıcı (CLS) başlangıcına ve sonuna eklenir. Her kelime için üç Gömme vardır:

Kelime Gömme: Kelimenin kendisinin gömülmesi;

Cümle Gömme: Eğitim verileri cümlelerden oluştuğu için her cümleye karşılık gelen cümle Gömme cümle içerisindeki her kelimeye verilir;

Konum Gömme: külliyattaki her sözcüğün karşılık gelen konum bilgisi.

Derlemeye karşılık gelen yukarıdaki üç Gömme türü, BERT girdisini oluşturmak için üst üste bindirilir.

Önceki ilgili modellerle karşılaştırıldığında, BERT'nin yeniliği, Yeni önceden eğitilmiş hedef işlevi ile Cümle düzeyindeki görevleri artırın. Birincisinde, girdideki bazı belirteçler rastgele maskelenir ve daha sonra ön eğitimde bunları tahmin ederek model, ön ve arka yönlerdeki bağlamı çıktı özellikleriyle birleştirebilir.ELMO temelinde, model katmanlarının sayısı sorununu çözer. "Kendini gör" in derinleşmesiyle ortaya çıkan "hedef sızıntısı" veya "kendini görme" sorunu; ikincisinde, cümleler tek başlarına mevcut değildir ve mevcut QA ve NLI görevleri gerektirir İki cümle arasındaki ilişkiyi anlamak için bu anlayış şekli geleneksel dil modelinin ötesine geçer. Cümle ilişkisini anlamak için, bir "Sonraki Cümle Tahmini" görevi önceden eğitilmiştir, yani bazı cümleleri rastgele değiştirir ve daha sonra bu cümlenin ilişki özelliklerini çıkarmak için önceki cümleyi IsNext / NotNext tahminini gerçekleştirmek için kullanır.

BERT eğitim öncesi model hazırlığıBERT modelini uygulamadan önce, Google tarafından yayınlanan mevcut modeli indirmeniz gerekir (Şekil 3) İndirme bağlantısı: https://github.com/google-research/bert. Veriler İngilizce ise, ilk BERT'yi kullanmanız önerilir. -Base, Uncased model, çok dilli veriler beşinci BERT-Base, Multilingual Cased (Yeni, önerilen) modelini kullanabilir ve Çin verileri son BERT-Base, Çin modelini kullanabilir.

Spam tespiti, Spam tespiti olarak da adlandırılır. E-ticaret alanında ürün incelemeleri, e-ticaret platformları üzerindeki en önemli verilerden biridir ve kullanıcıların ürün satın alması için önemli bir referans nesnedir. JD Retail'in altındaki "Yorumlar", "Soru-Cevap Topluluğu", "Jingmai" ve "JD Convenience Store" gibi birkaç büyük iş kolu, her gün tüketicilerin alışveriş deneyimini ciddi şekilde etkileyen çok sayıda gereksiz metin üretiyor. Sitedeki önemsiz metin türlerini sıraladıktan sonra, pornografik, politik, küfürlü, reklam dili, anlamsız kelimeler, eski şiirler, moda sözcükler vb. Gibi aşağıdaki önemsiz metin türlerini bulduk.

- Eski şiirler:

- Hikayeler, moda sözcükler:

Yukarıda bahsedilen önemsiz metin tanımayı bir metin sınıflandırma görevi olarak ele alıyoruz ve eğitimle elde edilen metin sınıflandırma modeli aracılığıyla günlük önemsiz metinlerin tespitini ve kesilmesini gerçekleştiriyoruz!

Yaklaşık 10.000 veri parçasını etiketledik, etiket 1 normal metni ve etiket 2 önemsiz metni temsil ediyor. Etiket1'in Etiket2'ye oranı yaklaşık 2: 1'dir. Bunların% 80'i eğitim verisi olarak kullanılır ve% 20'si test verisi olarak kullanılır.Aynı veri seti koşullarında, BERT ince ayar eğitimine dayalı model, FastText eğitimine dayalı modelle karşılaştırılır: sınıf 2'de tanıma (önemsiz metin) Hassasiyetten ödün vermeme öncülüğünde (hassasiyet =% 92), hatırlama oranı büyük ölçüde iyileştirildi (hatırlama:% 84 - > % 94). Bu nedenle, buna bağlı olarak, tip 1'in (normal metin) tanınmasında, doğruluk oranı da küçük bir geri çağırma oranı pahasına% 91 oranında artırılır. > % 97. Bu nedenle, BERT ön eğitim ve ince ayar eğitim yöntemine dayalı olarak, belli bir miktar veri olması koşuluyla, BERT eğitim modelinin öğrendiği faydalı bilgiler görevimize aktarılabilir ve iyi sonuçlar alınabilir.

FastText tabanlı algılama modelinin etkisi (sözcük bölümleme ve sözcük kaldırmayı durdurma gibi veri ön işleme):

Sekme 1. FastText'in yasaklanmış metin algılama

PrecisionRecallF11 (normal metin) 0.910.970.942 (önemsiz metin) 0.920.840.88

BERT algılama modeli etkisine (eğitim öncesi, ince ayar) dayalı olarak:

Tab2. BERT'ye göre yasaklanmış metin algılama

PrecisionRecallF11 (normal metin) 0.970.960.972 (önemsiz metin) 0.920.940.93

Kullanıcı topluluğu duyarlılık analizi modellemesiDuygu sınıflandırması, kullanıcının metinde ifade edilen potansiyel duygusal eğilimlerini kategorize etmek olarak anlaşılabilir. Metin duygularını sınıflandırmanın en basit yolu, metni üç kategoriye ayırmaktır: olumlu, olumsuz ve nötr. Bununla birlikte, kullanıcı duygularının algısını daha da geliştirmek için, genellikle olumlu olanı genel olumlu ve son derece olumluya ve olumsuzu genel olumsuz ve aşırı derecede olumsuza bölmek gibi daha ayrıntılı bölümler yaparız, bu da 5. duygu düzeyi. sınıflandırma. Duyguların basit bir Polarite bölünmesine ek olarak, "öfke", "üzüntü", "mutluluk" vb. Gibi daha ayrıntılı duygusal durumlar da tanıtılabilir.

Müşteri İncelemesi (Müşteri İncelemesi), satın alınan mal veya hizmetlerle ilgili kullanıcı deneyiminin bir ifadesidir ve e-ticaret platformlarında önemli bir kullanıcı geri bildirim biçimidir. İncelemelerin duygusal sınıflandırması, kullanıcı deneyimini anlamamıza, zamanında kullanıcı geri bildirimi sağlamamıza, ürün kalitesini izlememize, sipariş verme, satın alma ve tüketim kararlarında kullanıcılara yardımcı olma ve nihayetinde kullanıcı deneyimini ve JD perakende ekosistemini iyileştirmemize yardımcı olabilir. Bu nedenle, kullanıcı incelemelerini beş kategoriye ayırarak incelemeler için beş seviyeli bir duyarlılık sınıflandırma modeli oluşturduk: son derece olumlu, genel olarak olumlu, tarafsız, genel olarak olumsuz ve son derece olumsuz. Mevcut duyarlılık sınıflandırma modeli ana perakende kategorilerini kapsamaktadır ve desteklenen uygulama senaryoları arasında değerlendirme yıldız sınıflandırması, etiket oluşturma, ürün ölçüleri vb. Yer almaktadır (ayrıntılar için bkz. Şekil 8). Yeşil kutu ön büro etiketi ve mavi kutudur. Değerlendirme yıldız derecelendirmesi; kırmızı kutu, ürün ölçü girişidir (tam olarak kapsanmamıştır).

Duygu sınıflandırması için BERT (eğitim öncesi + ince ayar) kullanarak% 80'i eğitim seti ve% 20'si test seti olarak kullanılan yaklaşık 100.000 veri hazırladık.Son model etkisi Tablo 3'te gösterilmiştir:

Tab3. Sınıflandırma modelinin, BERT (Çin tabanlı) ile fasttext'in etkisine ilişkin yorum

Model F1BERT (Çin merkezli)% 90,7 FastText% 89,6

Tablo 3'ten BERT modelinin test setinin f1 değerinin daha güçlü bir genelleme becerisine sahip olan FastText'e kıyasla% 1,1 oranında önemli ölçüde iyileştirildiği görülmektedir. İstenmeyen yorum tespiti kadar iyi olmamasının nedeni, duygu sınıflandırma verilerinin miktarının büyük olması ve BERT tabanlı geçiş öğreniminin etkisinin artık o kadar önemli olmamasıdır.

Ürün kategorisi hata tahminiJD Retail'in verilerinde, bir ürünü listelerken, bir satıcının "ev aletleri", "cep telefonu" vb. Gibi ürünün ait olduğu kategoriyi seçmesi gerekir. Ancak, bazı satıcılar her bir ürünün belirli kategorisini bilmeyebilir. , Veya bir kategoriyi seçerken yanlış kullanım, ürünün yanlışlıkla başka kategorilerde listelenmesine neden olur. Bu, kullanıcının ürün seçimi, arama ve pazarlama promosyonu üzerinde olumsuz bir etkiye sahiptir. Bu nedenle, kategori ürün başlığına göre sınıflandırılabilir Öngörü çok önemlidir.

Ürün başlığına dayalı kategori tahmini, esasen bir metin sınıflandırma problemidir. Kategori tahmini, satıcı tarafından doldurulan ürün başlığına göre otomatik olarak gerçekleştirilir. Satıcı ürünü rafa koyduğunda kategori önerilebilir veya kategori, envanter verilerinde yanlış şekilde listelenebilir Tanımlayın ve düzeltin. Bununla birlikte, bazı kategoriler kötü bir şekilde ayırt edilir.Örneğin, "büyük mutfak aletleri" ve "küçük mutfak aletleri" arasında kesin bir sınır yoktur ve birçok kategori vardır, bu nedenle geleneksel metin sınıflandırma algoritmaları çok etkili değildir. bu iyi. Ayrıca, ürün başlıklarının çoğu kısadır ve kısa metin modelleme bilgisi gerektirir, bu da metin sınıflandırmasında büyük zorluklara neden olur. BERT modeli, metin sınıflandırmada, basit kullanımda ve bariz avantajlarda mükemmel etkilere sahiptir.

Deneme, Jingdong Retail'de yaklaşık 20 kategorinin yaklaşık 30.000 ürün başlığı verisine dayanmaktadır ve kategori tahmin sınıflandırması gerçekleştirilmektedir.% 80'i eğitim seti olarak ve% 20'si test seti olarak kullanılmıştır.Son model etkisi Tablo 4'te gösterilmiştir:

Sekme4. Kategori tahmin sınıflandırma modeli etkisi, BERT (Çince tabanlı) - xgboost

Model F1BERT (Çin merkezli)% 99,7 XGBoost% 96,8

Veri performansı sonuçlarından, aynı durumda BERT-Base'i kullanan Çin modeli, Xgboost'un doğruluğunu 3 puan artırır. Model farklılıklarına ek olarak, çıkarılan verilerin türü ve veri örneğinin büyüklüğü ile de ilgili olabilir.

Ürün uzun başlık sıra etiketiE-ticaret alanında, satışları artırmak ve arama isabet oranını artırmak için işletmeler genellikle birden çok ilgili ürün kelimesini yığar veya bir ürün başlığında gizlice ürün kelimelerini değiştirir. Bir yandan, ürün kelime yığınlaması, arama doğruluğu ve sahne tabanlı öneri gibi görevleri olumsuz etkileyecek ve ardından kullanıcı deneyimini etkileyecektir. Öte yandan, temel veriler (ürün bilgi grafiği gibi) oluşturulurken olumsuz bilgi üretilecektir, bu nedenle temel ürün kelimelerinin ürün başlıklarına göre tanımlanması gerekir. Örnekler aşağıdaki gibidir:

Ürün başlığı için temel ürün kelimesi görev hedefi, "MEIBAI mobil klavye OPPOr15 Android telefon için kullanılır vivox20 cep telefonu kabuğu Huawei fare klavye koruyucu kapak pembe + kablolu fare" başlığındaki telefon klavyesini özelleştirmektir. işaret.

3C elektronik parça kategorisinin yaklaşık 30.000 veri setine dayanarak, onu 7: 2: 1 oranına göre eğitim seti ve doğrulama setine ayırdık ve test setlerine train.csv, dev.csv, test.csv adı verildi. Verilerin deneysel sonuçları Tablo 5'te gösterilmektedir:

Tab5. Temel kelime çıkarma modeli etkisi, BERT (Çin merkezli)

PrecisionRecallF1BERT0.94620.95420.9502CRF0.79400.87860.8342

Belirli bir kategorideki deneyler, BERT ön eğitim modeli + ince ayara dayalı yöntemin gerçekten iyi sonuçlar verdiğini göstermektedir.

Özet ve görünümBu yazıda, BERT tabanlı eğitim öncesi model, JD Retail'in dizi etiketleme, sınıflandırma ve sıralama gibi çeşitli metin işleme görevlerine uygulanmıştır. Veri testi deneyi, algoritmanın çevrimiçi veriler üzerindeki iyi etkisini doğrulamaktadır. Ancak, uygulama alanı yukarıda belirtilen senaryolarla sınırlı değildir.Metin sınıflandırmasına dahil olan ürün tavsiye maddelerinin sonraki sınıflandırması ve sıra etiketlemede promosyon ihlallerinin tespiti ve ürün öznitelik doğrulaması da sırayla uygulanacaktır. Aynı zamanda akıllı yazma, otomatik özetleme, otomatik soru-cevap ve konuşma sistemleri gibi diğer önemli alanlara da açılmaya çalışacaktır.

Öte yandan, bu grup tarafından ele alınan gerçek sorunlar için, daha büyük ve daha doğru bir veri seti, modelin eğitimini desteklemek için veri çeşitliliğini daha iyi kapsayacak ve model tahmininin genelleme yeteneğini ve tanıma doğruluğunu daha da geliştirecektir.

Son olarak, modelin farklı uygulama arka plan parametrelerine göre uyarlanması potansiyel bir araştırma yönüdür.Makul bir parametre konfigürasyonu, oluşturulan veri ve model temelinde daha iyi deneysel sonuçlar elde edecektir.

ReferanslarJacob Devlin, Ming-Wei Chang, Kenton Lee ve Kristina Toutanova.2018. BERT: Dil Anlamak için Derin Çift Yönlü Transformatörlerin ön eğitimi. ArXiv: 1810.04805

Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Lukasz Kaiser ve Illia Polosukhin. 2017. İhtiyacınız olan tek şey dikkat. Nöral Bilgi İşleme Sistemlerindeki Gelişmelerde, sayfa 60006010.

Zong Chengqing, İstatistiksel Doğal Dil İşleme, İkinci Baskı, 2017

Wikipedia wiki, duygu analizi, https://en.wikipedia.org/wiki/Sentiment_analysis

Wikipedia wiki, Müşteri incelemesi, https://en.wikipedia.org/wiki/Customer_review

BERT kaynak kodu, https://github.com/google-research/bert

Joulin ve diğerleri Verimli Metin Sınıflandırması için Hileler Çantası, Hesaplamalı Dilbilim Derneği, 2017

Transfer: https://www.jiqizhixin.com/articles/2019-03-28-12

-

- Guangdong-Sichuan İşe Dönüş Özel Treni, başka yerlerden gelen 1.800'den fazla göçmen işçinin Guangdong'a girip ücretsiz olarak işe dönmesine yardımcı oluyor

-

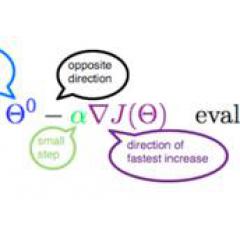

- Makineler öğrenmez: anlaşılması kolay! "Lise Matematiği" gradyan inişinin matematiksel ilkelerini anlar

-

- Bu iPhone6 sınırsız para için kullanılabilir mi? Birisi onu çok yüksek bir fiyata satın alıyor! Alipay bir gecede yanıt verdi