Rüyalardan ilham alan DeepMind, Transformer'ı sıkıştırmayı ve kitap düzeyinde PG-19 veri setini açık kaynak kodlu hale getirmeyi önerdi

Leifeng.com AI Teknolojisi Yorumu: DeepMind kısa süre önce yeni bir uzun menzilli bellek modeli olan Sıkıştırmalı Transformatör (Sıkıştırmalı Transformatör) önerdi. Bu model Transformer modeline göre ayarlandı. Sıkıştırılmış bir bellek modülü eklenerek, modelin bellek uzunluğu etkili bir şekilde artırıldı.

Öte yandan, DeepMind araştırmacıları, uzun menzilli belleğe dayalı muhakeme problemleri üzerine araştırmayı geliştirmek için, kitap düzeyinde bir dil veri seti PG-19 da geliştirdiler. Bu yeni ölçüt, mevcut uzun vadeli bellek ölçütünün iki katından daha fazlasıdır ve uzun menzilli dil modeli ölçütü WikiText-103'ün bağlamsal metninin 10 katından fazlasını içerir.

Makaleye bağlantı: https://arxiv.org/pdf/1911.05507.pdf

PG-19 açık kaynak bağlantısı: https://github.com/deepmind/pg19

Son yirmi yılda, yapay sinir ağları hafızada büyük adımlar attı.

Uzun Kısa Süreli Bellek (LSTM) olarak bilinen tekrarlayan sinir ağı (RNN), en eski ve en yaygın kullanılan bellek yapılarından biridir. LSTM, dijital vektörler biçiminde kompakt bir bellek tutar ve bu belleğe geçitli okuma, yazma ve unutma işlemleri aracılığıyla erişir ve bunları değiştirir. Başlangıçta, bir dizi bit mantık işleminin öğrenilmesi de dahil olmak üzere bir dizi kapsamlı görev üzerinde geliştirilmiştir. Ancak şimdi tüm dizi veri modellerinde yaygın olarak kullanılmaktadır.

LSTM'nin yanı sıra günümüzde kullanılan birçok RNN'nin büyük bir dezavantajı var, bu da kapasite sorunu. Bu yapıları tasarlamanın asıl amacı, her birimin hafızasının diğer birimleri etkileyebilmesi ve fen bölümünün ağırlığına sahip olmasıdır. Ancak bu, sistemin çok düşük hesaplama verimliliğine yol açar.Modeldeki öğrenilebilir parametrelerin sayısı, bellek boyutunun artmasıyla ikinci dereceden artacaktır.Örneğin, 64KB belleğe sahip bir LSTM, 8GB parametre üretecektir.

Bu bellek kapasitesi darboğazının nasıl atlanacağı ciddi bir sorun haline geldi.

DeepMind araştırmacıları, bu eksiklikleri gidermek için LSTM'yi genişletmek için daha büyük bir bellek matrisi kullanan, Diferensiyellenebilir Sinir Bilgisayarı (DNC) adlı yeni bir mimari önerdiler.

Bir şeylere baktığımızda, gözlerimiz görsel sahnedeki ilgili nesnelere odaklanacaktır. Örneğin arkadaşlarınızın ayakkabılarına dikkat etmek yerine yüz ifadelerine dikkat ederek daha fazla vakit geçirebilirsiniz.

DNC, bu bellek matrisinden verileri okumak için bir "dikkat işlemi" kullanan benzer bir yöntem kullanır.

DNC'de, bellek modeli geçmişteki belirli olayları / verileri işleyebilir. Bu dikkat işlemi sabit sayıda parametre gerektirir ve bellek boyutuyla hiçbir ilgisi yoktur, bu nedenle modelin bellek kapasitesini önemli ölçüde artırabilir.

DNC'nin gelişmesiyle birlikte, ek dikkat mekanizmalarına sahip tekrarlayan sinir ağları, çeviri ve soru cevaplama alanında büyük potansiyel göstermiştir. Bu modeller muhakeme için iki bellek yapısı kullanabilir; biri küçük ve kompakt bir LSTM bellek, diğeri ise büyük bir harici bellektir.

Ancak, son zamanlarda Google Google Brain araştırmacıları, LSTM'yi kaldırabilen ve yalnızca bilgileri iletmek için dikkatini kullanabilen bir Transformer modeli önerdiler.

Transformer başlangıçta makine çevirisi görevlerine uygulandı ve performansı tekrarlayan sinir ağlarından önemli ölçüde daha iyiydi.

Daha sonra, Transformer, soru cevaplama, metin özetleme, duygu analizi vb.Gibi diğer NLP görevlerinde yaygın olarak kullanıldı. Geçtiğimiz yıl Transformer sayesinde bu alanlarda çok büyük ilerlemeler kaydedildi.

Ancak bu modellerin hala bir dezavantajı var, yani tüm bilgileri depolayacaklar, böylece her adımda tüketilen hesaplama maliyeti ve depolama maliyeti çok büyük.

Belli ki beynimiz bunu yapmıyor, hayatımız boyunca aldığımız tüm bilgileri bir video kamera gibi saklamıyoruz. Bunun yerine, alaka düzeyi, sürpriz, risk ve tekrar sayısı gibi faktörlere göre tüm girdi uyarıcılarını seçer, filtreler ve bütünleştirir. Başka bir deyişle, geçmişi anlamamıza ve geleceği daha iyi tahmin etmemize yardımcı olmak için yaşam boyu deneyimimizi bir dizi parlak anıya sıkıştıracağız.

Bu, nasıl sıkıştırılacağı sorusudur.

Önceki bazı çalışmalar, seyrek erişim mekanizmasıyla hesaplamalı dikkat tüketimini sıkıştırmaya çalıştı. Ancak seyrek dikkat yöntemi, depolama sorununu çözemez ve genellikle etkin bir şekilde uygulanması için özelleştirilmiş bir seyrek çekirdek gerektirir.

1. Transformatörü Sıkıştırın

Leifeng.com AI Technology Review'e göre, DeepMind bu amaç için Sıkıştırılmış Transformatör modelini (sıkıştırılmış Transformatör) önerdi.

Basit bir ifadeyle, bu, geçmiş gizli etkinleştirmeleri (bellek) daha küçük bir sıkıştırılmış temsiller kümesiyle (sıkıştırılmış bellek) eşleyen basit bir Transformer çeşididir. Hafızada ve sıkıştırılmış hafızada, sıkıştırılmış Transformer, kısa süreli granüler hafızasını ve uzun vadeli kaba hafızasını sorgulamayı öğrenmek için aynı dikkat mekanizmasını kullanacaktır.

Sıkıştırılmış Transformatör, geçmiş aktivasyonların ince taneli bir belleğini korur ve ardından daha kaba sıkıştırılmış bir belleğe sıkıştırır. Yukarıdaki model üç katmana sahiptir, bir dizi uzunluğu ns = 3, bellek boyutu nm = 6, sıkıştırılmış bellek boyutu ncm = 6. Vurgulanan bellek sıkıştırılır ve her katman, onu bir sonraki sırada atmak yerine tek bir sıkıştırılmış belleğe sıkıştırmak için sıkıştırma işlevini fc kullanır. Bu örnekte, sıkıştırma oranı c = 3.

Yazar Jack Rae'ye göre, bu modelin ilham kaynağı, uykunun epizodik hafızamızı pekiştirebilmesidir. Hepimizin bildiği gibi, uyku hafızaya yardımcı olur, çünkü insanlar uyku sırasında uyanık anılarını sıkıştırıp pekiştirebilir, böylece hafızayı geliştirebilir.

Google tarafından önerilen TransformerXL modelinin uzun vadeli akıl yürütme için geçmiş aktivasyon hafızalarını koruduğunu biliyoruz. Ancak geçmiş etkinleştirmeler yeterince "eski" olduğunda (bellek boyutuna göre belirlenir), TransformerXL bu hatıraları atacaktır.

Aradaki fark, sıkıştırılmış Transformer'in bunları atmaması, ancak bir sıkıştırma işlevi ile sıkıştırılması ve ek bir sıkıştırma belleğinde (sıkıştırma belleği) depolanmasıdır. Bu sıkıştırma işlevi, ilgisiz anıları öğrenip filtreleyebilir, bazı önemli bilgileri daha uzun süre saklayabilir. Bu şekilde, TransformerXL modeli ile karşılaştırıldığında, açık bir şekilde daha uzun bir belleği tutabilir ve bu da uzun vadeli muhakeme görevlerine büyük fayda sağlayacaktır.

Yazara göre, bu model daha büyük bir evrenselliğe sahiptir. Yalnızca dil dizileri için değil, aynı zamanda yüksek frekanslı konuşma dalga biçimlerini modellemek için de kullanılabilir.Ayrıca, gelişmiş öğrenme aracıları, IMPALA vb. İçin bir bellek bileşeni olarak da işlev görebilir (tabii ki sıkıştırılabilir ve kullanılabilir Geçmiş gözlemler eklendi).

2. PG-19

Uzun vadeli çıkarımda sıkıştırılmış Transformatörün güçlü işlevini daha da doğrulamak için yazar, uzun bağlam dizisi modellemesini daha da desteklemek için Gutenberg Projesi'nden alınan metne dayalı yeni bir kitap düzeyinde dil modelleme karşılaştırması PG-19 önermektedir (uzun bağlam dizisi modelleme). Bu yeni ölçütün mevcut uzun süreli bellek ölçütünün iki katından fazla olduğunu ve uzun menzilli dil modeli ölçütü WikiText-103'ün bağlamsal metninin 10 katından fazlasını içerdiğini belirtmekte fayda var.

Kitaplar, uzun süreli bellek modellerinin geliştirilmesi için zengin bir arka plan sağlar. Yazar, 1919'dan önce yayınlanan (yani 100 yıl önce telif hakkı sorunlarından kaçınarak) yaklaşık 28.000 Project Gutenberg kitabının bir alt kümesini seçti. Önceki dil modelleme veri kümelerinin aksine, yazarlar nadiren metne ön işlem uygularlar. Örneğin, yararlı bilgileri filtrelemekten kaçınmak için verilerin kelime dağarcığını sınırlamaz veya sayıları gözden geçirmezler.

Veri seti 28752 kitap içerir ve toplam yaklaşık 11 GB'dir.

Bunların arasından 28602'si eğitim seti olarak, 50'si etkin set olarak ve 100'ü test seti olarak kullanılmıştır:

DeepMind daha sonra sıkıştırılmış Transformer ve TransformerXL'i en son PG-19 kitap veri setinde kıyasladı.Özel ayarlar için lütfen orijinal kağıda bakın. Sonuç aşağıda gösterilmiştir:

Sıkıştırılmış Transformatörün test karmaşıklığının 33.6, TransformerXL'inin ise 36.3 olduğu görülmektedir. Veri seti büyük olmasına rağmen, açıkçası hala zorlu bir alandır ve bu test sonucu, bu uzun menzilli dil modelleme kıyaslaması için ilk temel olarak kullanılabilir.

3. Sonunda

Birkaç günden, haftadan, hatta birkaç yıldan fazla süren bir aracı oluşturmak istiyorsanız, her adımda tüm orijinal giriş verilerini hesaplamak kesinlikle pratik değildir.

Bilgi işlem gücünün mevcut sürekli büyümesine rağmen, operasyonel temsil ve muhakeme oluşturmak için sıkıştırılmış ve seyrek bir bellek mimarisi geliştirmemiz gerekiyor.

Beklenebilecek şey, korelasyonu gün, ay ve yıl birimlerinde yakalayabilen bir modelin yakında çıkacak olmasıdır. Bu, uzun vadeli görevleri değerlendirmek için ilgili görevlere ve veri setlerine sahip olmamızı gerektirir. PG-19 açıkça bu yönde bir adımdır, çünkü "bütün bir kitap" zaten insanlar tarafından yaygın olarak kullanılan en uzun metin biçimidir.

Ve seçici dikkat ve diğer daha etkili sıkıştırma mekanizmaları, açıkça daha güçlü muhakeme araştırmalarını büyük ölçüde destekleyecektir.

Lei Feng.com raporları.

-

- Şu anda, Shantou'yu Hubei "savaşçılarına" yardımcı olmak üzere tam olarak desteklemek için N95 maskeleri ve gözlükleri gibi bir grup malzeme Hubei'ye gönderildi

-

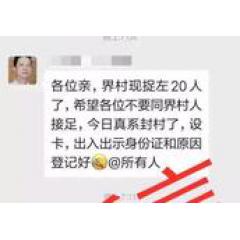

- Öğrenci enfeksiyonu nedeniyle tüm köy kapatılmalı mı? Foshan 2 insan yapımı dedikodu hat tarafından gözaltına alındı |

-

- İlkbaharda işe alım salgınla karşılaştığında mezunlar ne yapmalı? Merak etmeyin, süslü "temassız işe alım" sizi bekliyor

-

- Anhui Telecom'un "Devlet ve İnsan İletişimi" iTV Kırsal Salgın Önleme ve Kontrol Becerilerini Gösteriyor