Stanford Üniversitesi Chen Danqi ve diğerleri, makine okumasındaki en son gelişmeleri yorumluyor: yerel kalıp eşleştirmenin ötesinde

Lei Feng.com Yapay Zeka Teknolojisi İncelemesi: Kısa bir süre önce, Stanford Üniversitesi'nden Bilgisayar Bilimleri alanında doktora yapan Chen Danqi'nin 156 sayfalık "Sinirsel Okuma Anlama ve Ötesi" bitirme tezi, oldukça heyecan uyandıran "patlayıcı bir makale" oldu. Bu makale, kendisi ve aynı zamanda Christopher Manning altında çalışan sınıf arkadaşı Peng Qi tarafından yayınlanan bir makaledir.Stanford Üniversitesi'nden iki NLP uzmanı birlikte makine okumadaki son gelişmeleri araştırdı. Leifeng.com AI Technology Review aşağıdaki gibi derlenmiştir.

Merak ediyorum, Google Chrome'da hiç soru aradınız mı (örneğin, "Dünyada kaç ülke var")? Tarayıcı, sizi etkileyen bir dizi bağlantı yerine doğru yanıtlar verdi mi? Açıkçası, bu özellik çok güzel ve pratik, ancak yine de sınırlamalar var: biraz daha karmaşık sorular aradığınızda (örneğin, "Az önce yediğim Big Mac'in kalorilerini tüketmek için ne kadar bisiklete binmem gerekiyor?") Google Chrome, ihtiyacınız olan cevabı ilk iki bağlantıya bakarak bulsanız bile iyi bir cevap veremez.

Google Chrome'da yapılan aramadan yukarıda listelenen vakaların sonuçları

Günümüzün bilgi patlaması çağında, biz insanların her gün metinde (veya başka biçimlerde) üretilen aşırı miktardaki yeni bilgiyi sindirmemiz gerektiğinde, makinelerin büyük miktarda metni okumamıza ve soruları yanıtlamamıza yardımcı olmasına izin verme, doğal dili anlamanın en önemli alanıdır. Ve en pratik görevlerden biri. Bu makine okuma veya soru-cevap görevlerini çözmek, "Zaman Makinesi" filmindeki kütüphaneci gibi güçlü ve bilgili bir yapay zeka sistemi oluşturmak için önemli bir köşe taşı oluşturacaktır.

Son zamanlarda, Stanford Soru ve Cevap Veri Kümesi (SQuAD, veri kümesi görüntüleme adresi: https://rajpurkar.github.io/SQuAD-explorer/) ve TriviaQA (veri kümesi görüntüleme adresi: Triviaqa /) ve diğer büyük ölçekli soru ve cevap verileri, bu hedefe yönelik gelişimi büyük ölçüde hızlandırdı. Bu veri kümeleri, araştırmacıların veri içermeyen güçlü derin öğrenme modellerini eğitmesine olanak tanır. Wikipedia sayfalarından uygun yanıtlar bularak çok sayıda rastgele soruyu yanıtlayabilen algoritmalar gibi çok iyi sonuçlar elde edilmiştir (İlgili makale: "Wikipedia Okuma Açık Alanlı Soruları Yanıtlamak İçin ", ACL 2017, kağıt okuma adresi: https://cs.stanford.edu/~danqi/papers/acl2017.pdf), bu da insanların artık tüm zahmetli işleri kendi başlarına halletmelerine gerek kalmamasını sağlar .

SQuAD, 500'den fazla Wikipedia makalesinden toplanan 100.000'den fazla örnekten oluşmaktadır. Bu veri setinde, makaledeki her paragraf için ayrı bir soru listesi listelenmiştir ve bu soruların paragrafta birbirini izleyen birkaç kelime ile cevaplanması istenmiştir (Super Bowl 50 Wikipedia maddesine dayanan yukarıdaki örneğe bakınız). Yönteme ayrıca "çıkarılmış soru ve cevap" da denir.

Bununla birlikte, bu sonuçlar çok iyi görünse de, bu veri setlerinin de bariz eksiklikleri vardır ve bu eksiklikler, alanın daha da gelişmesini de sınırlayacaktır. Aslında araştırmacılar, bu veri kümeleri üzerinde eğitilen modellerin aslında çok karmaşık bir dil anlayışını öğrenmediğini, ancak temelde basit kalıp eşleştirme sezgisellerine dayandığını kanıtladılar.

Bu örnek Robin Jia ve Percy Liang'ın yazdığı bir makaleden alınmıştır. Eklenen kısa cümleler, modelin model eşleştirme yoluyla şehrin adını bulmayı öğrendiğini, soruyu ve cevabı gerçekten anlamadığını göstermektedir.

Bu blog yazısında, makine okumasının gelişimini daha da teşvik etmeyi umarak Stanford NLP Group tarafından toplanan en son iki veri setini tanıtacağız. Özellikle, bu veri setlerinin amacı, basit kalıp eşleştirmesi ile cevaplanamayan soruları cevaplamak için soru ve cevap görevlerine daha fazla "okuma" ve "akıl yürütme" eklemektir. Bunlardan biri, bir metin hakkında doğal diyalog için zengin bir arayüz sunarak sorunları diyalog perspektifinden çözen CoQA'dır. Başka bir veri seti de, cevabı belirli bir paragrafla sınırlamayan, ancak bu zorluğun üstesinden gelmek için cevabı elde etmek için birden çok belgede bir çıkarım yöntemi kullanan HotpotQA'dır. Bu yöntemi aşağıda ayrıntılı olarak tanıtacağız.

CoQA: Diyaloğa Dayalı Soru ve Cevap Veri Kümesi

CoQA nedir?

Mevcut soru cevaplama sistemlerinin çoğu, bir soruyu tek tek cevaplamakla sınırlıdır (yukarıda gösterilen SQuAD örneği gibi). Bu tür bir Soru-Cevap etkileşimi bazen insanlar arasında gerçekleşse de, bir dizi ilgili soru ve cevabı içeren bir diyaloga katılarak bilgi bulmak daha yaygındır. CoQA, özellikle bu sınırlamayı çözmek için geliştirilmiş, etkileşimli bir soru cevap veri setidir ve amacı, konuşmalı AI sistemlerinin geliştirilmesini teşvik etmektir. Veri setinde cevaplı 127.000 soru bulunmakta olup, bu soru ve cevaplar 7 farklı alanda metin pasajları ile ilgili 8.000 görüşmeden elde edilmektedir.

Yukarıda gösterildiği gibi, bir CoQA örneği, metin paragraflarından (bu örnekteki metin paragrafları, CNN haber makalelerinden toplanmıştır) ve paragrafın içeriği hakkındaki diyaloglardan oluşur. Bu diyalogda, her diyalog turu bir soru ve bir cevap içerir ve ilk sorudan sonraki her soru bir önceki diyaloğa (her soru) bağlıdır. SQuAD ve diğer birçok mevcut veri setinin aksine, CoQA'daki konuşma geçmişi birçok soruyu yanıtlamak için vazgeçilmezdir. Örneğin, daha önce ne söylendiğini bilmeden, ikinci soru Q2 (nerede?) Cevaplanamaz. Ayrıca, merkezi varlığın diyalog boyunca fiilen değiştiğini de belirtmek gerekir: Örneğin, Q4'teki "onun", S5'teki "he" ve S6'daki "onlar", farklı varlıklara atıfta bulunur. Bu aynı zamanda bu konuların anlaşılmasını daha zor hale getirir.

Diyalog bağlamında CoQA'nın sorunlarını anlamanın kilit noktasına ek olarak, başka birçok ilginç özelliğe sahiptir:

-

Önemli özelliklerden biri, CoQA'nın yanıtı SQUAD'in yaptığı gibi bir paragraftaki ardışık sözcüklerle sınırlamamasıdır. Pek çok sorunun bir paragrafta birbirini izleyen bir dizi sözcükle cevaplanamayacağına inanıyoruz, bu da diyaloğun doğallığını sınırlayacaktır. Örneğin, "Kaç tane?" Gibi bir soru için, makaledeki metin doğrudan açıklanmasa da, yanıt yalnızca "üç" olabilir. Aynı zamanda, veri setimizin güvenilir otomatik değerlendirmeyi desteklediğini ve insanlarla yüksek derecede tutarlılık sağlayabileceğini umuyoruz. Bu sorunu çözmek için, açıklayıcıdan önce metin aralığını vurgulamasını istiyoruz (cevabı desteklemek için temel ilke olarak, örnekte R1, R2 vb. Bakınız) ve ardından metin aralığını doğal bir cevap olarak düzenlemesini istiyoruz. Bu temel ilkeler eğitimde kullanılabilir (ancak testte kullanılamaz).

-

Mevcut QA veri setlerinin çoğu tek bir alana odaklanır ve bu da "mevcut modellerin genelleme yeteneğini test etmeyi" zorlaştırır. CoQA'nın bir diğer önemli özelliği de veri setinin çocuk hikayeleri, edebiyat, orta ve lise İngilizce testleri, haberler, Wikipedia, Reddit ve bilim dahil olmak üzere 7 farklı alandan toplanmasıdır. Aynı zamanda son iki alan Bölge dışı değerlendirme için kullanılır.

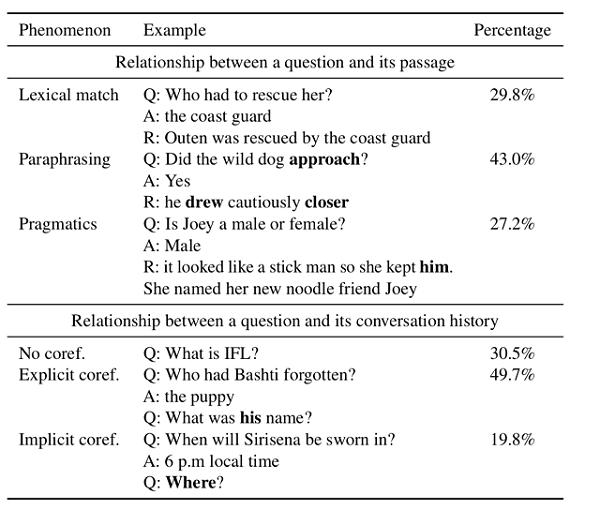

Bu veri setinin derinlemesine bir analizini yaptık. Aşağıdaki tabloda gösterildiği gibi, bu veri setinin çok sayıda dil fenomeni gösterdiğini gördük. Bunların arasında soruların yaklaşık% 27,2'si sağduyu ve ön varsayım gibi pragmatik muhakeme gerektirir. Örneğin, "Kedi gibi nazikçe yerleşir" ifadesi, "Karakteri gürültülü mü?" Sorusuna doğrudan cevap vermez, ancak dünya görüşü ile birleştirilen ifade bu soruyu yanıtlayabilir. Bununla birlikte, soruların yalnızca% 29,8'i basit kelime eşleştirme ile cevaplanabilir (yani, sorudaki kelimeleri doğrudan paragrafa eşleyerek).

Ek olarak, soruların yalnızca% 30,5'inin, konuşma geçmişiyle ortak referans ilişkisine güvenmeksizin soruları bağımsız olarak yanıtlayabildiğini de bulduk. Kalan soruların% 49,7'si "o", "kadın" ve "o" gibi açık ortak referans işaretleri içerirken, kalan% 19,8'lik sorular ("Nerede?" Gibi) dolaylı olarak bir varlığa atıfta bulunur Veya olay.

SQuAD 2.0'ın soru dağılımı ile karşılaştırıldığında, CoQA'daki soruların SQuAD'deki sorulardan çok daha kısa olduğunu (ortalama kelime oranı 5.5 / 10.1'dir), bu da CoQA veri setinin konuşma niteliğini yansıtır. Aynı zamanda, veri setimiz çok daha zengin sorular da sağlar: Temelde "ne" gibi sorular olan SQuAD sorularının neredeyse yarısının aksine, CoQA soruları birden fazla soru türüne dağıtılır. "Yaptı", "oldu", "eşittir" ve "yapıyor" gibi öneklerle gösterilen sektörler CoQA'da sık sık görünür, ancak SQUAD'de asla görünmez.

son ilerleme

Ağustos 2018'deki lansmanından bu yana, CoQA mücadelesi büyük ilgi gördü ve bu alandaki en rekabetçi ölçütlerden biri haline geldi. Aynı zamanda bizi şaşırtan şey, piyasaya sürülmesinden bu yana, özellikle Google'ın geçen yıl Kasım ayında BERT modelini piyasaya sürmesinden sonra kaydettiği birçok ilerleme oldu - bu model mevcut tüm sistemlerin performansını büyük ölçüde iyileştirdi.

Microsoft Research Asia'nın en gelişmiş kombinasyon sistemi "BERT + MMFT + ADA"% 87,5 alan içi F1 doğruluğu ve% 85,3 ekstra alan F1 doğruluğu elde etti. Bu doğruluk değerleri sadece insan performansına yakın değil, aynı zamanda 6 ay önce geliştirdiğimiz temel modelden 20 puan daha yüksek. Yakın gelecekte bu makalelerin ve açık kaynak sistemlerin yayınlanmasını dört gözle bekliyoruz.

HotpotQA: Çok dosyalı makine okuma

Uzun bir konuşma yoluyla belirli bir bağlamsal pasajı araştırmaya ek olarak, dünya hakkında gerçekleri bulmak için sıklıkla kendimizi birden fazla belge okumaya ihtiyaç duyarken buluyoruz.

Örneğin, "Yahoo! hangi eyalette kuruldu?" Veya "Stanford Üniversitesi veya Carnegie Mellon Üniversitesi'nin hangi okulunda daha fazla bilgisayar bilimi araştırmacısı var?" Veya "Devleri yakmak?" Gibi basit sorular bilmek isteyebilir. Kalori almam ne kadar sürer? "

İnternet, bu tür soruların çok sayıda cevabını kapsar, ancak bunlar her zaman kolay erişilebilir bir biçimde mevcut değildir ve hatta cevaplar tek bir yerde değildir. Örneğin, ilk soruyu yanıtlamak için bilgi kaynağı olarak Wikipedia'yı kullanırsak (Yahoo! hangi eyalette kuruldu?), Başlangıçta Yahoo! Kurucu ortakları Jerry Yang ve David Filo'nun sayfası veya kişisel bilgileri bu konudaki bilgilerden bahsetmedi (en azından bu makaleyi yazarken, ikisinin kişisel bilgileri bundan bahsetmiyordu).

Bu soruyu yanıtlamak için, insanların "Yahoo! Geçmiş" başlıklı aşağıdaki makaleyi görene kadar birden çok Wikipedia makalesine göz atmaları gerekir:

Bu soruya aşağıdaki akıl yürütme adımlarıyla cevap verebileceğimiz görülmektedir:

-

Bu makalenin ilk cümlesinin "Yahoo! 'Nun Stanford Üniversitesinde kuruldu" şeklinde olduğunu fark ettik.

-

Ardından, Wikipedia'da "Stanford Üniversitesi" ne bakabiliriz (bu durumda, sadece bağlantıya tıklarız) ve sonra Stanford Üniversitesi'nin adresini bulabiliriz.

-

Stanford Üniversitesi sayfası, "California" da bulunduğunu gösteriyor.

-

Son olarak, orijinal sorunun cevabını bulmak için bu iki gerçeği birleştirebiliriz: "Yahoo! California'da kuruldu."

Bu soruyu cevaplamak için iki becerinin vazgeçilmez olduğu unutulmamalıdır: (1) Sorumuza cevap vermek için hangi belgeleri veya destekleyici gerçekleri kullanacağımızı anlamak için bazı dedektiflik çalışmaları yapabilmek ve (2) Nihai cevap hakkında mantık yürütmek için birden fazla destekleyici veriyi kullanma yeteneği.

Makine okuma sistemleri için bunlar, sürekli büyüyen bilgi ve bilgi okyanusunu metin biçiminde sindirmemize etkili bir şekilde yardımcı olmak için edinmeleri gereken önemli yeteneklerdir. Ne yazık ki, mevcut veri kümeleri her zaman tek bir belgede yanıtlar bulmaya odaklandığından ve bu zorluğun üstesinden gelemediğinden, bu çabayı HotpotQA veri kümesini derleyerek gösterdik (makine okuma sistemi yukarıda belirtilenleri elde etsin) İki beceri).

HotpotQA nedir?

HotpotQA, yukarıda bahsettiğimiz özelliklere sahip yaklaşık 113.000 soru-cevap çifti grubu içeren büyük ölçekli bir soru-cevap veri kümesidir. Başka bir deyişle, bu sorular, Soru-Cevap sisteminin, oluşturulan cevapla ilgili bilgileri bulmak için çok sayıda metin belgesini filtrelemesini ve son cevabı çıkarmak için bulduğu çoklu destekleyici gerçekleri kullanmasını gerektirir (aşağıdaki örneğe bakın).

HotpotQA'daki soru örnekleri

Bu sorular ve cevaplar, bilim, astronomi, coğrafyadan eğlenceye, spora ve hukuk davalarına kadar çeşitli konuları kapsayan Wikipedia'nın tüm İngilizce versiyonundan toplanmıştır.

Bu soruları cevaplamak için çeşitli zorlu muhakeme yöntemlerine ihtiyaç vardır. Örneğin, Yahoo! Durumda, araştırmacının önce Yahoo! ile soruları yanıtlamak için gerekli bir varlık olan "Stanford Üniversitesi" arasındaki ilişkiyi çıkarması ve ardından "Stanford Üniversitesi'nin Kaliforniya'da olduğu" gerçeğini kullanması gerekir. Son cevaba gelin. Şematik olarak, akıl yürütme zincirinin tamamı aşağıdaki gibidir:

Burada, "Stanford Üniversitesi" ni bağlamda bir köprü varlığı olarak adlandırıyoruz çünkü bilinen varlık Yahoo! ile hedef cevabı "California" arasında köprü kuruyor. Aslında herkesin ilgisini çeken konuların birçoğunun bir dereceye kadar bu köprü oluşumunu ilgilendirdiğini gözlemledik.

Örneğin şu soru sorulduğunda: 2015 Diamond Head Classic maçında MVP'yi kazanan oyuncu hangi takım kazandı?

Bu soruda önce kendimize sorabiliriz: 2015 yılında Diamond Head Classic'te MVP kazanan oyuncu kim? Ardından, oyuncunun şu anda hangi takıma katıldığını öğrenin. Bu soruda, MVP oyuncusu (Buddy Hield) doğru cevabı bulmamız için bize rehberlik eden bir köprü varlık olarak hareket eder. Yahoo! Vakanın muhakeme yöntemi biraz farklıdır. Buradaki Buddy Hield, ilk sorunun cevabının bir parçasıdır, ancak "Stanford Üniversitesi" cevabın bir parçası değildir.

Ayrıca, "yanıtın köprü varlıklarıdır" gibi bazı ilginç soruları da kolayca düşünebilirsiniz, örneğin: Ed Harris'in başrol oynadığı hangi film bir Fransız romanına dayanıyor? (Cevap "Kar Ülkesi Treni" dir.)

Açıkçası, bu köprü soruları, Wikipedia'dan toplanan birçok gerçek hakkında akıl yürüterek herkesin cevaplamaya çalışabileceği tüm ilginç soruları tam olarak kapsayamayabilir. HotpotQA'da, daha çeşitli muhakeme becerilerini ve dil anlama yeteneklerini ifade etmek için yeni bir soru türü önerdik, bu: bir karşılaştırma sorusu (karşılaştırma sorusu).

Daha önce karşılaştırmalı bir sorudan bahsetmiştik: Hangi okulun Stanford Üniversitesi'nde veya Carnegie Mellon Üniversitesi'nde daha fazla bilgisayar bilimi araştırmacısı var?

Bu sorulara başarılı bir şekilde cevap verebilmek için, soru cevaplama sisteminin yalnızca ilgili destekleyici gerçekleri bulabilmesi değil (bu durumda, destekleyici gerçekler Stanford ve CMU'da kaç bilgisayar bilimi araştırmacısının olduğu), aynı zamanda her ikisiyle de başa çıkmak için anlamlı yollar kullanmalıdır Son cevabı bulmak için bir karşılaştırma yapın. Bununla birlikte, bu veri seti analizimize göre, mevcut soru cevap sisteminin ilgili destekleyici gerçekleri anlamlı bir şekilde karşılaştırması çok zordur, çünkü sayısal karşılaştırma, zaman karşılaştırması, sayma ve hatta Basit algoritma karşılaştırması.

Bununla birlikte, ilgili destekleyici gerçekleri bulmak kolay değildir ve daha da zorlayıcıdır. Karşılaştırmalı problemlerle ilgili gerçekleri bulmak genellikle daha kolay olsa da, varlık problemlerini köprülemek için çok önemlidir.

Belirli bir soruyu sorgulamak için bir anahtar kelime olarak kullanarak deneyler yapmak için geleneksel Bilgi Erişim (IR) yöntemini kullanıyoruz Bu yöntem tüm Wikipedia makalelerini (en alakalı makaleden en az ilgili makaleye kadar) sıralar. Sonuç olarak, soruyu doğru cevaplamak için gerekli olan iki aşama dışında ilk 10 sonuç türünde ortalama olarak yalnızca 1,1 doğru yanıt olduğunu bulduk (biz buna "altın aşama" diyoruz). Aşağıdaki şekilde altın aşamaların IR sıralamasında, daha yüksek dereceli aşamalar ve daha düşük dereceli aşamalar uzun kuyruklu bir dağılım göstermektedir.

Daha spesifik olarak, ilk 10 IR sonuçlarında, üst sıradaki paragrafların% 80'inden fazlası bulunabilir, ancak alt sıradaki paragrafların% 30'undan azı bulunur. Bir kişi, iki "altın destekleyici pasaj" bulmadan önce en üst sıradaki tüm makaleleri saf bir şekilde okursa, o zaman cevapladığı her soru için - okuduktan sonra bile ortalama 600 makale okuması gerekeceğini hesapladık. Makaleden sonra, algoritma bize iki "destekleyici altın paragrafı" bulup bulmadığımızı hala güvenilir bir şekilde söyleyemez!

Pratikte makine okuma problemi çok sayıda muhakeme adımı gerektirdiğinde, bu problemleri çözmek için yeni yöntemlere ihtiyaç vardır, çünkü bu yöndeki ilerleme, daha etkili bilgi erişim sistemlerinin geliştirilmesini büyük ölçüde teşvik edecektir.

Yorumlanabilir soru cevaplama sisteminin geliştirilmesi

İyi bir soru cevaplama sisteminin bir diğer önemli ve ideal özelliği yorumlanabilirliktir. Aslında, cevapları doğrulamaya yardımcı olabilecek açıklamalar veya gösterimler olmadan basitçe cevaplar gönderebilen bir soru-cevap sistemi temelde faydasızdır çünkü bu cevaplar çoğu zaman doğru gibi görünse bile kullanıcılar onlara güvenemez. Sistem tarafından verilen cevap. Ne yazık ki, bu aynı zamanda en gelişmiş soru cevap sistemlerinin çoğunda bir sorundur.

Bu nedenle, HotpotQA verilerini toplarken, açıklayıcılarımızdan da son cevaba ulaşmak için kullandıkları destekleyici cümleleri belirtmelerini ve bu cümleleri veri setinin bir parçası olarak yayınlamalarını istedik.

Veri kümesinden alınan aşağıdaki gerçek örnekte, yeşil cümle, cevabı desteklemek için destekleyici gerçek olarak hizmet eder (bu durumda birçok muhakeme adımı olmasına rağmen). Destekleyici gerçeklerle ilgili daha fazla (daha az yoğun) örnek için HotpotQA Data Explorer'a (Adres: https://hotpotqa.github.io/explorer.html) bakabilirsiniz.

Deneylerimizde, bu destekleyici gerçeklerin, insanların soru cevaplama sistemi tarafından verilen cevapları tespit etmesini kolaylaştırmakla kalmayıp, aynı zamanda model için daha güçlü bir denetim sağladığını gördük (önceki soru cevap veri setleri bu doğrultuda Süpervizyon eksikliği) ideal cevabı daha doğru bulmada sistemin performansını iyileştirmek için.

Son düşünceler

Kelimelerle kaydedilen insan bilgisinin artan zenginliği ve her zaman daha fazla insan bilgisinin dijitalleştirilmesiyle, bu konunun büyük bir değere sahip olduğuna inanıyoruz: bu bilgi, sorularımızı okumak, akıl yürütmek ve cevaplamak için otomatikleştirilebilir. Sistem, bu cevaplama sistemlerinin yorumlanabilirliği korunurken birleştirilir. Mevcut soru cevaplama sistemleri çoğu kez sadece çok sayıda paragrafa ve cümleye bakarak ve sonra "kara kutular" (çoğu kelime eşleme modelidir) kullanarak bir tur soruya cevap verir.Şimdi onları aşan soru cevaplama sistemleri geliştirme zamanı.

Bu amaçla, CoQA, belirli bir ortak bağlamda doğal konuşmalarda ortaya çıkan bir dizi soruyu ve birden fazla konuşma turunun gerekçelendirilmesini gerektiren zorlu soruları dikkate alır; Öte yandan, HotpotQA, çoklu belge muhakemesine odaklanır. Aynı zamanda araştırma topluluğunu, geniş bir külliyatta destekleyici bilgiler elde etmek için yeni yöntemler geliştirmeye teşvik eder.

Bu iki veri setinin soru cevaplama sistemlerinin önemli gelişimini destekleyeceğine inanıyoruz ve ayrıca bu sistemlerin tüm araştırma topluluğuna yeni anlayışlar getirmesini bekliyoruz.

Yoluyla: https://ai.stanford.edu/blog/beyond_local_pattern_matching/Lei Feng.com

-

- Guo Degang, Yue Yunpeng'in Reba grubunun CP'si olan "Nineteenth Generations of Ancestors" filminin yönetmenliğini yapan Lin Chiling de burada!

-

- Neredeyse ahlaksız olmak ne kadar güzel? Sadece onu gördüğümde bu cümlenin ne anlama geldiğini anladım.

-

- Yabancı kötü filmler de para kazanmak için Çin'e mi geliyor? Filmin 5 günde 3 milyon gişe soğuk su döküldü

-

- RSA algoritmasının mucidi vize sorunları nedeniyle toplantıya katılmamak zorunda kaldı! Stanford Üniversitesi bir bildiri yayınladı: "uyruk sorgulama" adaletsizliğe yol açacak

-

- 44 yılda, meteoroloji biliminin "tohumları" kök saldı ve sürekli filizlendi - Chongqing Damotan İlköğretim Okulu'nun Honglingjin Hava İstasyonuna girerek (2)

-

- Akıllı sürüş bir dönüm noktasına giriyor, endüstri, akademi ve araştırma liderleri tarafından nehri geçme yoluna bir göz atalım | 2019 AI + Akıllı Araba İnovasyon Zirvesi

-

- Douban'ın 2 puanlık filmi "Pure Mind" geri çekildi Reytingle ilgili bir sorun mu var yoksa film gerçek su mu?