LeCun'un derin öğrenmeye giriş dersi: uçağın icadından evrişimli sinir ağına

Kök derleme

Qubit Üretildi | Genel Hesap QbitAI

Derin öğrenme ile insan beyni arasındaki ilişki nedir? Bilgisayarlar çeşitli nesneleri nasıl tanır? Yapay bir beyni nasıl inşa ederiz?

Bunlar, derin öğrenmeye yeni başlayanların çözemeyeceği birkaç sorudur. Neyse ki, burada size açıklamaktan mutlu olan büyük bir inek var.

6 Şubat'ta UCLA (California Üniversitesi, Los Angeles) ve Saf Matematik ve Uygulamalı Matematik Enstitüsü (IPAM) tarafından düzenlenen bir forumda "Evrişimli Sinir Ağlarının Babası" Yann LeCun, güçlü bir Fransız aksanıyla konuştu. Matematik çemberindeki bilim adamları derin öğrenmeyi başlattı.

LeCun, uçan araçların icadında kuşların etkisiyle başladı ve yavaş yavaş derin öğrenmenin özüne doğru ilerledi ve çok acemi dostu olduğu söylenebilir.

Fırsatı kaçırmayın, neden gelip büyük tanrının kendisi tarafından öğretilen derin öğrenmeye yönelik bu giriş kılavuzunu izlemiyorsunuz?

Bir tabureyi hareket ettirin ve oturun!

Kübit ilk önce tüm videoyu taşıdı (Tabii ki, çiğ et), QbitAI'de izlemeye hoş geldiniz.

Tabii ki, dersin ana içeriği de düzenlenmiştir:

Bugün buradaki hepiniz matematik tanrılarısınız.

Ben ne matematikçi ne de Nobel Ödülü. Burada durmanın yeterli olmadığını düşünüyorum.

Eskiden mühendislik okumuştum, ama bazı şeyleri bombaladım ve sonra yazılıma geçtim (aksi takdirde dünyanın nasıl bir şey olduğunu söylemek zor olurdu).

Bugün size derin öğrenmeye kısa bir giriş yapacağım.

Ancak AI ile başlamıyoruz, ancak Uçağın insanlar tarafından icat edilmesinden itibaren .

Da Vinci uçağının çizimine göre yapılan ilk uçak, kuş şeklini tamamen kopyaladı. O zamanlar, dipte uçma prensibini hiç bilmiyordum, bu yüzden sadece doğadaki yaratıklardan ilham alıp kabak çekebildim.

İlk uçuşta yerden sadece 15 cm uzaklıkta, hala 20 cm idi ve uçak telefonu kapattı. Bu yüzden, Wright kardeşler tarafından uçak yapmak için kullanılan bir dizi yöntem olan daha sistematik bir yönteme hala ihtiyacımız var ve uçmak nihayet gerçek oluyor.

Genel olarak, teorik biliş ancak uygulama birikiminden sonra gelir.

Hepsi uçmakla ilgili.

Sonra soru geliyor.

Yapay zeka doğadan ilham alabilir mi?

Açıkçası, bu fikir çok eski. Önce biyolojik dünyanın ajanlarına bakalım.

İnsan beyninde neredeyse 85 milyar nöron vardır. Ve her nöronun binden yüz bine kadar değişen on binlerce sinapsı vardır. İnsan beyni çok verimlidir ve yalnızca 25 watt tüketir, ki bu bir bilgisayarın onda biri kadardır.

Beyni olan her hayvan öğrenebilir. Farklı hayvanlar farklı şekilde öğrenebilir ve bazıları daha basittir. Kendi kendilerine öğrenmek için özellikle iyi bir vizyona veya diğer ajanların öğretmesine ihtiyaç duymazlar.

Hayvan öğreniminin mekanizmasını bulmaya çalışıyoruz ve bunu makine öğrenimini eğitmek için kullanıyoruz.

Yavaş yavaş, 1940'tan başlayarak, akıllı makineler yapma fikri ortaya çıktı. Böylece Perceptron ortaya çıktı.

Bu bir bilgisayar değil, bilgisayar simülatörüdür. Giriş değeri voltajdır ve belirli bir eşiği aştığında açılır. Eşiğin altında kapalıdır. Ağırlıklar, tıpkı dönen bir düğme gibi çalıştırılabilir.

Şimdi üç satırlık Python kodu ile uygulayabilsek de o günlerde büyük bir bilgisayar olarak kabul ediliyordu.

Bu algılayıcı nasıl çalışır?

Prensip çok basit, önce bir sürü eğitim verisi toplamanız gerekiyor.

Örneğin, görev görüntü tanıma ise, girdi görüntünün her pikselidir. Her piksel 0, 1 ile temsil edildiğinde, bir dizi sayı oluşturulabilir.

Makineye bir resim verirsiniz, A harfi ve çıktı 1 olmalıdır. Ardından eğitim sırasında görüntüdeki pikselleri okuyun, nihai sonucu 1 olan piksellerin ağırlığını artırın, yani harf A olarak belirlenir ve nihai sonuçtan sapan piksellerin ağırlığını azaltın.

Matematiksel olarak sadece bir satır Python kodu gereklidir.

Aslında, bu yöntem sezgisel olarak düşünülse de, daha sonraki yıllarda bu sorunun, biyolojiden de esinlenerek birkaç denklem halinde özetlenebileceği keşfedildi.

İnsan beyninin nasıl öğrendiğine dönüyoruz.

Her nöron, sinyalleri iletmek için sinapslar aracılığıyla diğer nöronlara bağlanır.

Ancak matematiksel olarak bu kavram basitleştirilmiştir ve algılayıcıdaki ağırlıklar düğme olarak kabul edilir.

Belirli bir girdi için, parametreleri çıktı hatasına göre ayarlayın, çalışın ve amaç işlevinin değeri küçülüp küçülünceye kadar tekrarlayın (amaç işlevinin değeri, elde ettiğiniz çıktı ile istediğiniz çıktı arasındaki farkı temsil eder).

Buna gradyan iniş denir ve bu hala çok basit bir matematik problemidir.

Biraz daha karmaşık bir örnek için, arabalar, uçaklar ve sandalyeler gibi nesneleri tanımlamak için bir resim sınıflandırıcı yapmak istiyoruz.

Görünüşleri sürekli değişiyor, Bilgisayarın her tür nesneyi tanımasını nasıl sağlarız?

Bu, çok sayıda manuel ayar gerektirir. Sisteme bir arabanın resmini verin Sistem onu bir araba olarak tanırsa, kırmızı ışık yanacaktır. Kırmızı ışık yanmıyorsa, kırmızı ışığın parlaklığını artırmak için bu düğmeleri ayarlayın; Mavic'in resmine girin ve yeşil ışığın parlaklığını artırmak için düğmeleri ayarlayın.

Yeterli eğitim verisi girin ve makine daha önce hiç görmediği fotoğrafları tanıyana kadar düğmeyi ayarlamaya devam edin, ardından eğitim başarılı olur.

Kesinlikle soracaksınız, bu gizemli kutuda görüntüleri tanıyabilen nedir?

Bu cevap son birkaç on yılda değişiyor.

Geleneksel örüntü tanıma, ona bir resim vermek ve ardından bunu bir özellik çıkarıcıdan geçirmektir. Bu özellik çıkarıcı yapay olarak oluşturulmuştur, bu görüntülerin piksellerini bir sayı dizisine dönüştürür ve ardından bu görüntünün içeriğini almak için emmek ve özetlemek için basit bir algoritma kullanır. Bu yöntem, derin öğrenmenin ortaya çıkmasından önce kullanılıyordu.

Derin öğrenme, modülleri eğitilebilecek birkaç katmana ayırır. Tıpkı görsel sinyallerin iletimi gibi, bilgiyi çıkarmak için birden fazla adım gerekir.

Sormamız gereken bir sonraki soru, bu eğitilebilir modül kutularına ne koymalıyız?

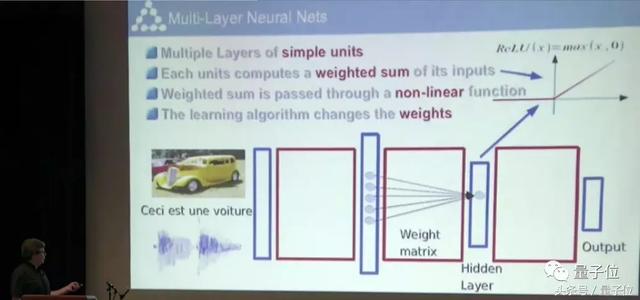

"Çok katmanlı" kavramı 1950'lerde ortaya atıldı ve 1980'lerde daha fazla insan onu kullandı.

Her katman basit birimlerden oluşur ve birimler, bir önceki katmanın girdisine dayalı olarak farklı ağırlıklandırma dereceleri ile elde edilir. Daha sonra değer eşiği aşarsa aşağı inmeye devam edecek, eşiğin altında ise alınmayacaktır.

Öyleyse, makineyi nasıl eğiteceğiz?

Bu aslında sapmayı sürekli olarak ayarlama sürecidir. Sorunun anahtarı, parametreleri hangi yönde ayarlayacağımız ve istediğimiz çıktıyı ne ölçüde elde edebileceğimizdir.

1980'de bu soruna bir çözüm vardı.

Bu şema, Zincir kuralı adı verilen karmaşık bir matematiksel kavramın pratik bir uygulamasıdır.

Bir ağınız olduğunda, sürekli bir işlevsel bloğa (İşlevsel blok) sahip olursunuz.

Her blok ya bir matris çarpımıdır ya da her giriş için doğrusal olmayan bir işlemdir. Sistemdeki ayrı bir bloğa bakalım.

Çıktı değerini basitçe hesaplayabilirsiniz. Örneğin, bu bir doğrusal matris çarpım modülüdür, parametre vektör ile çarpılır, böylece çıktı vektörünü elde edebilirsiniz. Bu iki bloğun farklı boyutları vardır.

Şimdi, her vektördeki herhangi bir elemanın ayarlanması için, kaybın hangi yönde değişeceğini bildiğimizi varsayalım.

Kayıp fonksiyonunun eğimi, aldığımız çıktı ile istediğimiz çıktı arasındaki farkı temsil eder. Hesaplama ile şekildeki yeşil vektör elde edilebilir ve yukarıdan aşağıya özyinelemeli formül hesaplanabilir Geri yayılım sayesinde maliyet ve tüm modüller ile ilgili gradyanlar elde edilebilir.

Mevcut birçok platform, siz ağı tanımlamak için bir program yazdıktan sonra otomatik olarak geri yayımı çalıştırabilir ve degradeleri hesaplayabilir.

Bu sorunlar çözüldükten sonra yapay bir beyin yapabilir miyiz?

Bilirsiniz, insan beyni her saniye 10 üzeri 17. kuvveti yapabilir ve nöron sayısı 10 üzeri 11. kuvvete ulaşır.

Yüksek hesaplama hızına sahip bir çipe bir göz atalım. Sağ alt köşedeki NVIDIA Titan-V Bu GPU, saniyede 10 ila 15'inci güç yapabilir, bu da insan beyninden 100 kat daha yavaş.

Yani herkes hesaplıyor, çipin hızını ikiye katlamak 18 ay sürse bile, insan beynimizle aynı seviyeye ulaşmamız ne kadar sürer? Çip makul bir boyut aralığında olacaksa, on yıllarca beklememiz gerektiğini düşünüyorum.

Ama asıl sorun bu değil. Temel sorun, onları nasıl programlayacağımızı, nasıl eğiteceğimizi ve eğitim ilkelerinin neler olduğunu bilmememizdir.

Bu GPU çok ucuz, sadece 3.000 dolar, ancak şimdi herkes madencilik için satın alıyor, bu yüzden artık mevcut değil.

Birçok kez, eğer kariyerimde bir fare gibi sağduyulu bir ajan kurabilirsem çok mutlu ve tatmin olacağımı söyledim. Şimdi karşılık gelen bilgi işlem gücüne sahip olabiliriz, ancak henüz temel ilkeleri çözemedik. Şimdi bu temel ilke sınırlıdır.

TAMAM, Şimdi dışarı atlayalım ve yaratıkların bize ilham verip veremeyeceğini görelim.

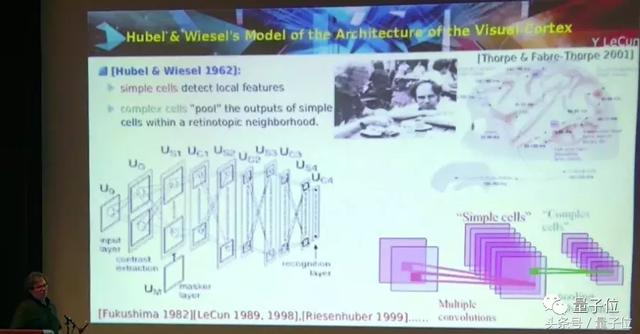

Hubel ve Wiesel'in 1962'deki biyolojik araştırma çalışmaları o kadar ünlü ki, herkesin bildiği gibi 1970'lerde Nobel Ödülü'nü kazandı. İşin kendisi 1960'larda yapıldı ve görsel sinyal iletiminin fizyolojik yapısı.

Basit hücreler konum bilgilerini algılar ve karmaşık hücreler, basit hücrelerin uyarıldığı bilgileri entegre eder.

Bu nedenle, özel bir motivasyonunuz varsa, biraz hareket edin, karmaşık hücreler harekete geçecektir.

Fukushima, 1982'de basit hücreler ile karmaşık hücreler arasındaki hiyerarşik ilişkiyi tanımlamak için bir hesaplama modeli yarattı. Bu, uygun bir öğrenme algoritmasının olmadığı 1980'lerde bir iştir. Bu nedenle diğer denetimsiz algoritmalar kullanılır.

Daha sonra, bu algoritmadan ilham aldım ve benzer bir yapıya sahip bir ağ kurdum ve eğitmek için geri yayılım algoritmasını kullandım. Evrişimli Sinir Ağı (CNN).

Aşağıda, evrişimli bir sinir ağının şematik bir diyagramı bulunmaktadır.

Görüntüdeki pikseller, CNN'deki birimleri etkinleştirir. Ama onlara nöron demeye cesaret edemem, aksi takdirde sinirbilimciler üzülür. Çünkü bu birimler nöronlara göre çok basit.

Her birim bir yama gibi görünür. Bu birimler eşikten daha yüksek olacak ve ardından açılacaktır. Düşükse kapatın.

Lazer işaretçinin gösterdiği yamanın bir katsayı olduğunu görebilirsiniz.

Soldaki, katsayı vektörünü giriş vektörüyle çarpan giriş yamasıdır. Girişin tamamını katsayı ile kaydırın ve ardından sonucu sağ tarafa kaydedebilirsiniz.

Eşleşebilirlerse, yüksek düzeyde etkinleştirilmiş bir sonuç alırsınız ve eşleşmezlerse etkin olmayan bir sonuç alırsınız.

Buna matematikte ayrık evrişim denir.

Katman katman evrişim çekirdek katsayısı işlemesinden sonra, nihai sonuç en sağdaki sıkıştırılmış bilgidir.

90'lı yılların ortalarında harika bir model yaptık. Yalnızca bir harfi tanımakla kalmaz, aynı zamanda birden çok harfi önce bölmeden de tanıyabilirsiniz. O zaman klasik matematiksel algoritma kullanılıyorsa önce bölünmesi gerekir.

Nesne görüntüden ayrılamadığında, modelimizin önemi ortaya çıkar.

Bu modeldeki her katman evrişimli olup, segmentasyon ve tanıma aynı anda gerçekleştirilir.

Bu o zamanlar genç olan ben, bir kameranın altına not koyup klavyeye tıkladım. Bu 1993'teydi (1992 idi).

Bu, New Jersey'deyken Bell Labs'ın telefon numarası ve artık kullanılmıyor.

Birkaç saniye içinde görüntü işlenebilir ve sayılar tanınabilir.

Çok fazla eğitim verisi yok, küçük ve farklı el yazıları bile bu şekilde tanınabilir ve etkisi çok iyi.

Bu programı uygun hızda çalıştırmak için özel bir donanım olan DSP 32C kullandık, hız 20 FLOPS'a ulaşabilir. Son olarak, kontrolleri tanıyabilen bir sistem oluşturmak için bunu kullandık. 1996 civarında piyasaya sürüldü ve kullanıldı.

1990'ların sonunda, bu sistem zaten kontrollerin yaklaşık% 10 ila% 20'sini işliyordu. Yeterince yaşlıysanız, belki çekiniz bu sistem tarafından okunmuştur.

Bu şekilde bakıldığında bu sistem oldukça başarılı. Ne yazık ki, 1990'ların ortalarında, makine öğrenimi çemberinde, herkesin sinir ağlarına olan hevesi ortadan kalktı.

Bunun büyük bir nedeni, bu sistemin yazılım sistemine dahil edilmesi için çok fazla bilgi işlem gücü gerektirmesidir. Bu şekilde koşmak mümkündür.

Bütün bunlar MATLAB, Microsoft sistemleri ve Linux ortaya çıkmadan önce oldu ve ATT ilgili donanım kaynaklarını açıklamadı. Büyük bilgisayarlar veya büyük veri kümeleri olmadan, herkes bunu yalnızca sezgi yoluyla yapabilir.

Aslında o zamanlar birçok şey çok metafizikti ve bunları matematiksel bir bakış açısıyla açıklayamadık.

Temel ilkeleri açıklayamazsanız, bir teori oluşturmanın bir yolu yoktur. Teori yoksa çok kafa karıştırıcıdır ve hiçbir makale yayınlanamaz.

Aslında bu yöntemler mevcuttur, ancak terk edilmişlerdir.

Ancak bazılarımız bu yöntemin eninde sonunda geri geleceğini biliyoruz. Çünkü bazı durumlarda bu yöntem daha iyidir.

Çünkü kendi kendilerine öğrendikleri için, sadece görüntüleri tanımakla kalmaz, dünyayı soyut olarak da temsil ederler. Şeylerin özünü bulabilir ve sonra farklı parçalar arasındaki bağlantıları bulabilir ve sonra bunları bir bütün halinde birleştirebilirler. Çok güçlü şeyler yaptıkları için daha fazla veriye de ihtiyaçları var.

1996 ve 2002 arasında, bu alandaki araştırmayı neredeyse bıraktım ve görüntü sıkıştırmaya geçtim.

Bunu 2003 yılında geri almaya başladım. İki kameralı bir araba yaptık ve insanların kontrol etmesine izin verdik, engel 2 metre uzaktayken engelden kaçınmak için sola veya sağa dönmesini kontrol ediyorduk. Ardından, direksiyon simidinin açısını tahmin etmek için iki kamera tarafından yakalanan görüntülere bakması için bir CNN eğitiyoruz.

Sadece 20 dakikalık eğitim verisine ihtiyacınız var, bu CNN kendi kendine sürebilir! Engellerle karşılaşıldığında, ondan kaçınmak için dönecektir.

Bu sistemden ilham alan DARPA, 1.5 milyon dolarlık bir proje olan LAGR'yi (Kara Araçlarına Uygulanan Öğrenme) düzenledi.

Bu robotun içinde doğal bir ortamda otomatik olarak hareket edebilen dört kamerası ve üç bilgisayarı olduğunu görebilirsiniz. Ekrandaki hangi alanların sorunsuz geçebileceğini bize söylemesi için bir CNN eğittik.

Bu işlev aynı zamanda geleneksel stereo görüntü görüntüleme teknolojisi kullanılarak da elde edilebilir. Bununla birlikte, stereo görüntüleme çok pahalıdır ve çalışma aralığı da çok sınırlıdır, yaklaşık 10 metre uzaklıktadır.

Bu, CNN'in bir kullanımıdır.

Kısa süre sonra bir alanın geçip geçemeyeceğini işaretleyemeyeceğimizi fark ettik.Daha ilginç olan, resimdeki belirli piksellerin hangi nesneye ait olduğunu görmek. (Nesne tanıma sınıflandırması).

Örneğin bunlar gökyüzü, ağaçlar, pencereler, yollar vb.

Bu, yolda bisiklete binen birinin birinci şahıs görüntüsüdür.Bu algoritmanın mükemmel olduğu söylenemez, buranın bir çöl olduğunu sanıyor.Aslında Manhattan'da çöl yok.

Ancak, yayalar gibi büyük hedefleri belirleme yeteneği iyidir ve normal bir bilgisayarda çalışsa bile, o zamanki en gelişmiş sistemden 100 kat daha hızlıdır. Bu algoritma, birçok insanı insansız sürüşe uygulayabileceğimizi düşünmeye teşvik etti.

2014 yılında iki şirket bu teknolojiyi hızla devraldı. Biri MobilEye, diğeri ise Nvidia.

2010'dan önce, bu çalışmalar basit bir şekilde yürütüldü ve sonra işler değişti.

2011'de derin öğrenme, konuşma tanımada önemli ilerleme kaydetti.

2012'nin sonunda, derin öğrenme ImageNet yarışmasında ün kazandı. ImageNet veri seti 1.000 nesnenin 1.3 milyon fotoğrafını içerir.Bu veri setinde geleneksel görüntü sınıflandırma algoritmalarıyla elde edilen en düşük hata oranı yaklaşık% 26'dır.

2012'de Toronto Üniversitesi tarafından yapılan büyük bir CNN, hata oranını% 15'e düşürdü. Bu kadar büyük bir CNN'yi GPU ile resmi olarak çalıştıran ilk ekip onlar.

Böylece, birdenbire tüm bilgisayar görme alanı bu teknolojiyi kullanmaya başladı. Bir teknolojiden diğerine bu kadar hızlı geçiş yapan bir araştırma alanı görmemiştim.

Aslında, 2011'de CVPR'ye bir makale de gönderdik. Bu makale zamanın en iyi rekorunu yendi, ancak reddedildi. Çünkü o zamanlar insanlar CNN'in bu kadar iyi sonuçlar alabileceğine inanmıyordu. Herkes bunu daha önce görmediği için, öznel olarak kuralları ihlal ettiğimizi düşünüyorlar vb.

Ancak 3 yıl sonra dünya tamamen tersine döndü. CNN kullanmazsanız makale kabul edilmeyecektir.

Ama bu iyi bir şey değil. Çünkü bu çeşitliliği öldürecek. Bunu herkesin o zamanlar ne kadar büyük bir devrim olduğunu bilmesini sağlamak için söyledim.

Bu ağlar, milyonlarca düğme, birim ve ağırlık ile son derece büyüktür. Ağın ilk katmanı, kenarlar, çizgiler vb. Gibi bazı temel motifleri algılar.

Bazı CNN'lerde 50 veya daha fazla katman bulunur. Neden bu kadar çok katmana ihtiyacımız var?

Sinir ağının çok katmanlı mimarisi, verilerin bileşimsel yapısına karşılık gelir.Farklı katmanlar, grafiklerin üst düzey özelliklerine daha yakın olan çizgiler ve kenarlar gibi düşük düzeyli özellikler ve daire, yay ve köşeler gibi orta düzey özellikler gibi farklı özellikleri algılar.

Bu dünyadaki her şey katmanlar halinde sunulur. Örneğin, metin harflerden, karakterlerden, sözcüklerden, tümcelerden, cümlelerden ve paragraflardan oluşur.

Einstein bir keresinde bu dünyadaki en inanılmaz şeyin her şeyin anlaşılabilir olması olduğunu söylemişti.

Dünyadaki en şaşırtıcı şey, dünyanın anlaşılabilir olmasıdır.

Geçtiğimiz birkaç yıl içinde, çok sayıda şirket bu teknolojilerin yerleşmesi ve ölçeklenmesi için çok çaba sarf etti.

Son araştırma ilerlemelerini listelemeye başlayın

Örneğin, ImageNet'in tamamındaki eğitimi 23.74 hata oranıyla 1 saatte tamamlamak için artık 256 CNN kullanıyoruz.

Bilgisayarla görü ile ilgili en modern araştırma olan Maske R-CNN, nesne bölümleme, anahtar nokta algılama, insan pozu yakalama vb. Seyrek ConvNet, 3D semantik segmentasyon için de kullanılabilir.

Ayrıca CNN, çeviri gibi görme ile ilgisi olmayan alanlarda da kullanılabilir. Bu, Facebook'un kullanıcıların kısa makaleleri çevirmesine yardımcı olması için kullanışlıdır.

Bugün paylaşımda bahsedilen materyallerin çoğu açık kaynaktır.

Evrişimli sinir ağları, makinelerin çevreyi vizyonla algılamasına yardımcı olabilecek insansız sürüş gibi birçok alanda uygulanabilir. Tıbbi görüntüleme, genetik, fizik vb. Çeşitli alanlarda uygulamaları bulunmakta ve hemen her gün yeni alanlar ortaya çıkmaktadır.

Derin öğrenme sadece algılamakla kalmaz, aynı zamanda akıl yürütebilir.

Örneğin, bir resme göre sorular sorabiliriz,

Aşağıdaki resimde sarı nesnelerden daha fazla kare var mı?

Bu soruyu cevaplayan bir insan ise, kare ve sarı cisimlerin sayısını ayrı ayrı saymanız ve ardından bu iki sayının boyutlarını karşılaştırmanız gerekir.

Sinir ağları için, kareleri ve sarı nesneleri sınıflandırmak için bir modüle, saymak için başka bir modüle ve boyutu karşılaştırmak ve cevabı vermek için başka bir modüle ihtiyaç vardır.

Bu sinir ağı dinamiktir ve girdiyle birlikte değişir ve girdi, sinir ağının mimarisini belirler.

Ek olarak, sinir ağlarını geliştirmek için bellek modüllerini kullanmak da ilginç bir araştırma yönüdür.

Konferansta, Bay Li Kun, son zamanlarda hayran olduğu farklılaştırılabilir programlamadan bahsetti. İlgilenen öğrenciler önceki makaleleri okuyabilir ve videoları kendi başlarına izleyebilir.

Son olarak, Öğretmen Li Kun bir noktayı vurguladı: Şu anda, makinelerin genel zekası veya sağduyuları yok.

- Bitiş -

Samimi işe alım

Qubit, editörleri / muhabirleri işe alıyor ve merkezi Pekin, Zhongguancun'da bulunuyor. Yetenekli ve hevesli öğrencilerin bize katılmasını dört gözle bekliyoruz! İlgili ayrıntılar için lütfen QbitAI diyalog arayüzünde "işe alım" kelimesini yanıtlayın.

Qubit QbitAI · Toutiao İmzalama Yazarı

' ' Yapay zeka teknolojisi ve ürünlerindeki yeni eğilimleri takip edin

-

- Lunengin geçen yıl Guizhoudaki yoksulluğu azaltması doğru değildi ve Cui Kangxi 3 puan istedi! Li Xiaopeng'in elinde fazla yiyecek olabilir mi?

-

- Çinli oyuncular yine ünlüler! PlayerUnknown's Battlegrounds'un Steam sürümündeki denizaşırı oyuncular bir kez daha Çin bölgesini kilitlemek istedi.

-

- Otomotiv endüstrisindeki "en güçlü beyni" inşa etmek Changan Automobile'ın küresel Ar-Ge merkezi resmi olarak açıldı

-

- Stillik çok mu konuşuyor? Rakipleri mühürlemeyi umuyoruz! Yang Xu tek bir kelimeyle yanıt verdi ve Tianhainin ilk çıkışının bir gizemi var

-

- DNF Post Bar çok sayıda oyuncu Ulusal Günde engellendi mi? İlgili personel: Çok fazla söylenti, geçici olarak kontrol