Basit ve anlaşılması kolay ------ Takviye öğrenme teorisi ve gerçek mücadele (1)

Bu makale dizisi, pekiştirmeli öğrenmenin temel kavramlarını anlaşılması kolay bir şekilde tanıtıyor.Dil popüler olmasına rağmen, içerik hala çok titiz. Makalede kullanılan birçok formül var ve matematiksel formüllerle baş ağrısı çeken okuyucular korkabilir, ancak okuyucular adım adım takip ederse, formüllerin türetilmesinin çok doğal olduğunu görecekler, bu da bu temel kavramların tam olarak anlaşılması için çok yararlı. Teoriye ek olarak, makale ayrıca her algoritmanın uygulama kodunu tanıtacak ve her bir anahtar kod satırına derinlemesine yanıtlar sağlayacaktır. Okuyucunun sadece teori ve algoritmayı anlamasına değil, aynı zamanda onu kodla nasıl uygulayacağını bilmesine izin verin. Teori ve pratiğin birleşimiyle, öğrenilen kavramların daha derin bir şekilde anlaşılması. Okuyucular yalnızca temel Python programlama bilgisine ihtiyaç duyar ve makaledeki her algoritmanın karşılık gelen bir Jupyter Notebook kodu vardır. (Makalenin kaynağı, Li Li'nin Github blogu)

içindekiler

Giriş

Markov Karar Süreci (MDP)

Çevre ile etkileşim

Hedefler ve ödüller

Dönüş

Markov nitelikleri

Markov Karar Süreçleri

Değer Fonksiyon

Optimal Değer Fonksiyonları

OpenAI Gym'e Giriş

Ortamı Çalıştır

Gözlemler

Alanlar

Giriş

Daha önce denetimli öğrenmeyi başlatmıştık Denetimli öğrenmenin özelliği, bizi "denetleyecek" ve bize doğru sonucun ne olduğunu söyleyecek bir "öğretmen" olmasıdır. Biz gençken, öğretmenler bize öğretmeye gelirdi, özünde, denetimli öğrenme bir tür bilgi aktarımıdır, ancak yeni bilgi keşfedilemez. Bir bütün olarak insanlık için, gerçek (hatta tek) bilgi kaynağı pratiktir - yani pekiştirmeli öğrenmedir. Örneğin, Shennong Baicao'yu tattığında, insanlar ilk başta hangi otların hastalıkları iyileştirebileceğini bilmiyordu, ancak deneyerek yeni bilgiler öğrenebiliyorlardı. Öğrenilen bilgi dil tarafından kaydedilir ve nesilden nesile aktarılır, böylece insan toplumu bir bütün olarak ilerlemeye devam edebilir. Denetimli öğrenmenin aksine, hiçbir "öğretmen" bizi "denetlemez". Örneğin, Go oynarken, kimse bize mevcut durumda en iyi hamlenin ne olduğunu söylemeyecek.Sadece oyun bittiğinde nihai sonucu bileceğiz. Hangi hareketin iyi ve hangi hareketin kötü olduğunu tekrar etmemiz (öğrenmemiz) gerekiyor. . Doğal dünya aynıdır Bize başkalarıyla işbirliği yapıp yapmamamız gerektiğini söylemeyecek, ancak en güçlü olanın hayatta kalması yoluyla, sonunda birbirimize yardım ettiğimiz bir toplumun daha rekabetçi olacağını "söyleyecektir". Önceki denetimli denetimsiz öğrenmeyle karşılaştırıldığında, büyük bir fark vardır: pekiştirmeli öğrenmedeki aracı Eylem yoluyla çevreyi etkileyebilir - yaptığımız her hareket durumu daha iyi veya daha kötü hale getirebilir.

Çözmek istediği temel sorun, bir durum verildiğinde onun değerini (Değerini) yargılamamız gerektiğidir. Değer ve Ödül, pekiştirmeli öğrenmenin en temel iki kavramıdır. Bir Temsilci için (pekiştirmeli öğrenmenin ana yapısı), Ödül anında, dahili olarak veya hatta doğal olarak alınır. Örneğin, aç bir durumda yemek için bir ödül olacaktır. Değer ertelenir ve hesaplanması ve dikkatle değerlendirilmesi gerekir. Örneğin, aç olduğunuzda yiyecek çalmanın bir ödülü vardır, ancak bu (belki) Değer açısından iyi bir Eylem değildir. neden olmasın? Örneğin insanlar öğrenmeyi denetlese de bilgeler bize bunun etik olmadığını ve iyi bir davranış olmadığını söylediler. Ama daha önce de söylediğimiz gibi, insan bilgisinin nihai kaynağı pekiştirmeli öğrenmedir Bilgeler nereden biliyorlardı? Bazı insanlar bunun Tanrı'dan veya insan doğasından geldiğini düşünür, örneğin "insanlar doğası gereği iyidir". Son bölümde felsefi konuları tartışacağız. Evrim açısından açıklanacak olursa, insan aslında bir "hayatta kalma" oyunu oynamaktadır, ahlaki değerleri takip eden ve takip etmeyen insanlar vardır.Doğa bize en uygun olanın hayatta kalmasıyla nihai sonucu söyleyecek ve nihayetinde bilgelerimiz öğrenecektir. Bu etik kodları "ben oldum" (aslında ben seçildim) ve bu kodlar nesilden nesile eğitim (denetimli öğrenme) yoluyla aktarıldı.

Takviye öğrenmenin en yaygın modeli-Markov Karar Süreci (MDP)

Markov Karar Süreci, pekiştirmeli öğrenmenin en yaygın modelidir. Bu modeli, pekiştirmeli öğrenmenin bazı temel kavramlarını tanıtmak için kullanıyoruz.

-

Çevre ile etkileşim

Pekiştirmeli öğrenmenin özü, çevre ile etkileşim yoluyla bir hedefe nasıl ulaşılacağını öğrenmektir. Öğrenme ve karar verme konusu Ajan olarak adlandırılır. Ajanın etkileşime girdiği nesne, büyük veya küçük olabilen Ortamdır.Kuyu üzerinde oturan ve gökyüzünü seyreden bir kurbağa için ortamı küçük kuyu; insanlar için tüm dünya ve hatta güneş sistemi araştırmamızın nesneleridir. Temsilci, çevre ile etkileşime girmeye devam edecek ve mevcut duruma göre eylemler seçecek ve ortam, temsilciye yeni bir durum ve ödül verecektir. Tüm etkileşim süreci aşağıdaki şekilde gösterilmektedir.

Şekil: Takviye öğrenmede Aracı ve çevre arasındaki etkileşim

Etmen ve çevre arasındaki etkileşimin zamanında t = 0,1, ... olduğu varsayılır. T zamanında, Ajan belirli bir StS durumundadır, burada SS, durum uzayı olan tüm olası durumlar kümesini temsil eder. At behaviorA (St) davranışını seçebilir, burada A (St), St. durumunda seçilebilen tüm davranışların kümesidir. At davranışı seçildikten sonra, ortam Temsilciye bir sonraki (t + 1) zamanda yeni bir St + 1 durumu ve Ödül Rt + 1RR verecektir.

Gerçek değerli bir ödül yeterli mi? İnsanlar için aynı anda hem iş hem de aile gibi birçok uğraş vardır. Tabii ki, en kolay yol, iki hedefin ağırlıklı toplamını gerçekleştirmektir ve bu ağırlık değişiyor gibi görünüyor, bu yüzden insanların tek bir amacı var mı ve diğer hedefler bunun dışsal bir tezahürü mü? Bu konuyu burada tartışmayacağız, ancak gerçek Görevler için genellikle yeterlidir. Örneğin, Go oynamak kazanmak veya kaybetmek demektir; Atari oynamak en yüksek puanı almak demektir.

Her t zamanında, Temsilci mevcut duruma göre At farklı davranışları seçecektir. Seçim yöntemi Politika olarak adlandırılır. Genel varsayım, bir olasılık dağılımına sahip olduğudur (belirli strateji, özel durumudur) t (At | St ), eğer bu stokastik süreç Durağan ise, o zaman stratejimiz genellikle zamandan bağımsızdır, yani t (At | St) = (At | St). Stratejiler iyi veya kötüdür ve Temsilcinin amacı en iyi stratejiyi öğrenmektir (var olup olmadığı da pekiştirmeli öğrenmenin teorik bir problemidir, ancak genellikle var olduğuna inanırız ve sistem bazı varsayımları yerine getirirse, optimal stratejinin var olduğunu kanıtlayabilecek bazı teoriler vardır. ).

-

Hedefler ve ödüller

Her t anında, ortam Temsilciye bir ÖdülRt verecek ve Temsilcinin amacı (Hedef) nihayet elde edilen tüm ödüllerin toplamını maksimize etmektir. Burada ima edilen anlam şudur: Amacımız kısa vadeli ödül değil, uzun vadeli ödül biriktirmektir. Normalde okulda çok çalışmak eninde sonunda karşılığını verir.Kısa vadede çalışmak aç ve bitkin olabilir ve dışarı çıkmak keyifli olabilir. Bu sözde "Ödül hipotezi" dir: hedef (Hedef) veya amaç (Amaç) dediğimiz şey, nihayetinde bir Ödül sinyalinin kümülatif değerini maksimize etmek olarak kabul edilebilir.

Yukarıda bahsedildiği gibi, Ajanın tüm hedeflerini (özellikle insanlar gibi karmaşık yaratıkları) tek bir değerle tanımlamak yeterli görünmüyor, Ajanı bazı özel görevlere koyalım ve yeterli olup olmadığını görelim. Örneğin, bir farenin Labirent'ten kaçmasına izin verirsek, bir çıkış bulamazsa ona -1'lik bir Ödül veririz, böylece öğrenme hedefi Maze'den mümkün olan en kısa sürede kaçmaktır. Örneğin, satranç oynarsanız, kazanırsanız, ona +1, kaybederseniz -1, kaybederseniz 0 verir. Diğer bir örnek ise süpürme robotudur, eğer çöp toplarsa ona +1 Ödül verin, o zaman amacı olabildiğince çok çöp toplamaktır.

Not: Tanımladığımız hedef, Temsilciye ne yapmasını beklediğimizi (Ne) söylemektir, nasıl yapacağını (Nasıl) söylemektir. Örneğin, satranç oynarken rakibin piyonunu ele geçirmek kazanma stratejisidir (nasıl yapılır) Rakibe ödül veremeyiz, aksi takdirde piyonu ele geçirme stratejisini öğrenebilir, çünkü bazen kazanmak için feda etmemiz gerektiğini biliyoruz. Kendi satranç taşınız.

-

Dönüş

Temsilcinin amacı, Ödülün uzun vadeli birikmiş değerini en üst düzeye çıkarmaktır. Bu birikmiş değeri resmi olarak-getiri olarak tanımlayalım. T süresinden sonraki ödülün Rt, Rt + 1, ... olduğunu varsayarsak, bu ödüllerin toplamının en büyük olmasını bekliyoruz. Ortam (muhtemelen) rastgele olduğundan ve temsilcinin stratejisi de (muhtemelen) rastgele olduğundan, temsilcinin amacı, Ödülün kümülatif toplamının beklenen değerini maksimize etmektir. Gt dönüşü şu şekilde tanımlanır:

Gt = Rt + 1 + Rt + 2 + Rt + 3 + ... + RT

T'nin son an olduğu yer. Bazı görevlerin başlangıç durumundan görevin son durumuna kadar bazı son durumları olacaktır, biz buna bölüm diyoruz. Örneğin satrançta oyunun başından oyunun sonuna (veya çekilişe) kadar buna bölüm denir. Oyunu yeniden başlatmak için satranç oynamak gibi yeni bir bölüm başlatırsak, Temsilcinin durumu başlangıç durumuna sıfırlanacak ve yeni oyunun bir öncekiyle hiçbir ilgisi olmayacaktır. Bölümün görevine ek olarak bitmeyen ve sonsuza kadar devam edecek başka bir görev daha var, yani T = .

Geleceğin belirsizliği nedeniyle, genellikle gelecekteki ödüllerde (İndirim) indirim yapıyoruz. Bu anlaşılması kolay Önünüzdeki ödül kesindir.Eğer alırsanız, gelecekte ödül için çok fazla belirsiz faktör vardır, bu nedenle indirim gerekir. Bu nedenle indirimli getiriyi şu şekilde tanımlayabiliriz:

Bunlar arasında , İndirim Oranı olarak adlandırılan bir 0101 parametresidir. Eğer

Markov nitelikleri

Pekiştirmeli öğrenmede, duruma göre hangi davranışı alacağına temsilci karar verir ve durum, çevreden gelen bir sinyaldir. Durum, Ajanın sensör ölçümlerinden (Duyusal Ölçümler) gelebilir veya bu orijinal ölçümlerin karmaşık işlenmesi olabilir. O anki sensör sinyali olabileceği gibi önceki sinyali de içerebilir. İdeal olarak, durum sinyalinin tüm geçmiş bilgileri sıkıştırmasını bekleriz, ilgili tüm bilgileri tutabilir ve ilgisiz bilgileri atmaya çalışabilir. Bu genellikle durumun sadece o andaki sinyali değil, aynı zamanda bazı önceki bilgileri de içermesini gerektirir.Tabii ki, tüm geçmiş bilgiler genellikle gerekli değildir. Bir durum sinyali tüm ilgili bilgileri içeriyorsa, buna Markov Özelliği denir. Örneğin, satrançta mevcut konum (tüm taşların konumları ve sonraki hamleyi kimin yaptığı dahil) tüm bilgileri içerir. Arabayı, sonra atı ya da atı ve sonra at arabasını gezdirmek ne olursa olsun aynı duruma geldiler. Bu nedenle, Markov özelliklerinin genellikle belirli "yol" ile ilgisi yoktur. Markov niteliklerini resmi olarak tanımlayalım.

Ortamın dinamiklerinin aşağıdaki rastgele süreçler olduğunu varsayıyoruz:

Diğer bir deyişle, geçmişteki tüm tarihsel bilgiler (S0, A0, R1, ..., St 1, At 1, Rt) durumunda, Ajan St durumunda olduktan sonra ortam geri bildiriminin yeni durumu ve At s 've ödül şöyledir: R'nin ortak olasılık dağılımı. Sistem Markov özelliğini karşılarsa, tüm geçmiş geçmiş bilgileri St.'de sıkıştırılır. Bu nedenle, St'nin durumu verildiğinde, geçmiş geçmişle ilgisi yoktur.Bu nedenle, Markov özelliğini karşılayan sistemin dinamik sistemi aşağıdaki formülle basitleştirilebilir. :

Ortam Markov özelliklerine sahipse, mevcut durum ve davranış göz önüne alındığında, bir sonraki durumu ve Ödülü (olasılık) tahmin etmek için yukarıdaki formülü kullanabiliriz. Bu formülü yinelemeli kullanarak, mevcut durumda beklenen getiriyi (tam olarak) hesaplayabiliriz.

Resim: Atari Broke oyunu

Örneğin, yukarıdaki Atari Broke oyununda oyun, topu geri sektirmek için alt bölmeyi kullanmak ve ardından üst ızgaraya dokunmaktır. Bir ızgaraya her dokunulduğunda, bir ödül (Ödül) olacaktır. Tüm ızgaralara dokunulursa veya bölme Topu almazsanız ve ekranın alt kısmına düşmesine izin verirseniz oyun biter. Oyuncunun amacı daha fazla puan elde etmektir.

Bu oyunun ortamını analiz edersek, mevcut çerçevenin görüntüsünü mevcut durum olarak alırsak, Markov'a mı ait? İşe yaramıyor, çünkü bir görüntü sadece bugünün bilgisine sahip, aynı olan iki durum görüntüsü olabilir ama top hızı farklı olabilir. Mevcut kareyi ve önceki kareyi, topun sabit bir hızda düz bir çizgide hareket ettiğini varsayarak (çarpışma olmadığında durum budur) mevcut durum olarak alabiliriz, bu durumda hız, topun iki kare içindeki konumuna göre hesaplanabilir. Bu şekilde, kabaca Markov özelliklerine sahip olduğu kabul edilebilir.

Markov Karar Süreçleri

Markov niteliklerini karşılayan pekiştirmeli öğrenmeye Markov karar süreci, durum uzayı ve davranış uzayı sınırlıysa, sonlu Markov karar süreci olarak adlandırılır. Bir Markov karar süreci tamamen ortamın mevcut durumuna göre belirlenir. Bu önemli formülü tekrar tekrar edelim:

Yukarıdaki formül ile çevre ile ilgili her türlü bilgiyi hesaplayabiliriz (yani ortam tamamen bu formül ile belirlenir). Örneğin, belirli bir karakteristik durum s ve davranış a'nın beklenen ödülünü aşağıdaki gibi hesaplayabiliriz:

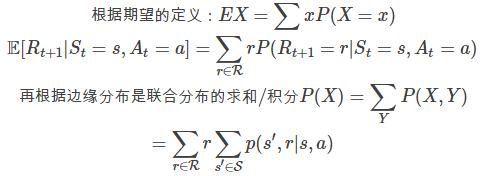

Yukarıdaki formül doğrudan beklenen tanımdan türetilmiştir, onu burada basitçe türeteceğiz ve benzer yerler daha sonra atlanacaktır.

Benzer şekilde, durum geçiş olasılığını da elde edebiliriz:

Ve mevcut s, mevcut a ve sonraki s koşulları verildiğinde beklenen ödül:

-

Değer Fonksiyon

Pek çok pekiştirmeli öğrenme yöntemi, durumun değer işlevini (veya Durum-Eylem çiftinin değer işlevini) bulmayı içerir. Bu işlev, aracının bu durumda ne kadar iyi olduğunu hesaplar (veya temsilci s durumunda olup a eylemini gerçekleştirir). Örneğin, satranç oynarken, iyi mi kötü mü belirli bir pozisyonda (Pozisyon) olup olmadığımızı düşüneceğiz ve ardından oyunu bu iyi duruma doğru gelişmesi veya kötü durumlardan kaçınması için yönlendirmek için Harekete geçeceğiz. Burada "İyi", temsilcinin bu durumdaki getirisinin beklenen değerini ifade eder. Elbette, bu beklenen değer, temsilcinin politikası ile yakından ilgilidir, bu nedenle değer işlevi, belirli bir politika kapsamındaki değer işlevini ifade eder.

stratejisinin sS durumundan, Eylem aA (s) ile olasılık (a | s) arasında bir eşleştirme olduğunu hatırlayın. Stratejinin değerini s durumunda, yani Ajanın s durumunda olduğu ve stratejisini kullandığı getirinin beklenen değerini v (s) olarak tanımlarız. Resmi tanımı şöyledir:

Burada E, ajan eylemde bulunmak için stratejisini kullandığında rastgele değişkenin beklenen değerini temsil eder. Bir terminal durum varsa, onun değer fonksiyonunu sıfır olarak tanımlarız. V fonksiyonuna stratejinin Durum Değer Fonksiyonu diyoruz.

Benzer şekilde, q (s, a) 'yı tanımlayabilir ve s durumunda Eylem a'nın değerini alabiliriz. Resmi tanımı şöyledir:

Q stratejisinin eylem değeri fonksiyonu olarak adlandırıyoruz.

Değer fonksiyonları v ve q deneyimden tahmin edilebilir (Deneyim). Örneğin, şu şekilde tahmin edebiliriz: Bir Temsilci stratejisini birçok kez simüle etmek için kullanırsa, bir değer ortalama alınarak tahmin edilebilir. Simülasyonların sayısı sonsuza eğilimliyse, bu yöntemle elde edilen tahmini değer v ^ (s) yakınsayacaktır. Gerçek v (s)). Bu, q (s, a) 'yı tahmin etmek için de kullanılabilen Monte Carlo yöntemidir. Durum uzayı çok büyükse, v (s) veya q (s, a) 'nın parametreleştirilmiş bir fonksiyon (model) v (s; w) veya q (s, a; w) olduğunu da varsayabiliriz, bu yaklaşık yöntemdir . Derin Güçlendirmeli Öğrenme olarak adlandırılan v (s; w) veya q (s, a; w) 'yi uygulamak için derin sinir ağlarını kullanabiliriz.

Değer işlevinin çok önemli bir özel etkisi, genellikle pekiştirmeli öğrenmede ve dinamik programlamada kullanılan belirli bir özyinelemeyi karşılamasıdır. Bu yinelemeli formül Bellman Denklemidir. Okurların aşağıdaki formülü anlayıp türetmelerini umuyorum (eğer bazı adımlar çıkarılamazsa, en azından ne söylediğini anlayabilir ve bu denklemi "tanıyabilir". Kitabı yüzlerce kez okuyun Kendi iyiliğim için, iki kez kopyalamanın yardımcı olacağını anlamıyorum).

Tekrar Bellman formülüne bakalım, özyinelemeli olarak tanımlanır-v (s), v (s defined) ile tanımlanır.Bazı basit problemler için, bu formüle dayalı denklemleri çözerek v'yi çözebiliriz.

Yukarıdaki formülü analiz etmek için yukarıdaki rakamı birleştiriyoruz. Mevcut durum s'dir. stratejisine göre, a eylemini gerçekleştirme olasılığımız (a | s) ve durum a ve eylem s koşulları altında, çevresel geri bildirim olasılığı r ve s'is p (r, s | s, a), tüm olası kombinasyonlar (a, r, s ') toplamına ihtiyacımız var, böylece

, Her yolun altında (her s, r, s kombinasyonu), Rt + 1, r'dir;

. Verilen bir yol durumunda, s, r, s'ler, r, s''ler sabittir, yani s 'de sabittir ve Markov özelliğine göre Gt + 1Gt + 1 yalnızca t + 1'e eşittir. St + 1 = sSt + 1 = s anındaki durum ilişkilidir, dolayısıyla ikinci terim olur

-

Optimal Değer Fonksiyonları

Bir takviye öğrenme görevini çözmek için, kabaca konuşursak, mümkün olduğunca çok uzun vadeli ödül elde etmek için bir strateji bulmaktır. Her şeyden önce, bir stratejinin başka bir stratejiden daha iyi olduğunu '(veya o kadar iyi) tanımlarız, ' olarak gösterilir. Biçimsel tanım sS, v (s) v (s) 'dir. Diğer tüm stratejilerden "daha iyi" olan (belki birden fazla) optimal $ \ pi_ olduğu kanıtlanabilir (buradan atlayın). Optimal strateji için değer işlevi, v_ {s) $ olarak belirtilen optimum değer işlevi olarak adlandırılır:

Benzer şekilde, davranış için bir optimal davranış değeri işlevi vardır:

$ q_ (s, a) ve v_ (s) $ aşağıdaki ilişkiye sahiptir:

Bu formülü şu şekilde yorumlayabiliriz: s ve a belirlendikten sonra St + 1 durumuna girecek ve Ödül Rt + 1 alacaktır Bu olasılıklı süreç, yani önünde bir E beklentisi var. Ancak bunun aracı ile hiçbir ilgisi yoktur ve temsilci t + 1'deki davranışla ilgilidir. Eğer optimal q (s, a) 'yı elde etmek istiyorsanız, o zaman v'yi hesaplamalıdır (t + 1'deki optimal stratejiye göre St + 1), yani v (St + 1).

Not: Yukarıdaki formüldeki rastgele değişken yalnızca, p (r, s | s, a) ortamı tarafından belirlenen Rt + 1Rt + 1'dir ve v (s) ve q (s, a) iki sabittir ( Verilen s, a).

OpenAI Gym'e Giriş

OpenAI Gym, pekiştirmeli öğrenme algoritmalarını geliştirmek ve karşılaştırmak için bir araçtır. Aracının gerçekleştirilmesinde herhangi bir kısıtlaması yoktur, bu nedenle Aracıyı uygulamak için TensorFlow veya başka herhangi bir aracı kullanabilirsiniz. Birleşik bir Ortam arayüzü sağlar. Bu arayüzü belirli bir takviye öğrenme görevini tanımlamak için kullanabilirsiniz.Ayrıca, birçok Atari oyunu gibi birçok ortak görev de sağlar.

Ortamı Çalıştır

İlk olarak, aşağıdaki şekilde gösterildiği gibi çok basit bir CartPole-v0 oyununu tanıtıyoruz.

Şekil: Çalışma zamanında CartPole-v0'ın ekran görüntüsü

Bu oyunda arabaya +1 veya -1 kuvvet (ivme) uygulayabilen küçük bir araba var.Arabada bir direk var. Amacımız arabanın pozisyonunun -2.4 ile 2.4 arasında ve direğin düşeye göre açısının olmasını şart koşmak. -15 ° ile 15 ° arası. Fiziksel bir bakış açısından, 4 durum değişkenine sahiptir, arabanın konumu, arabanın hızı, çubuğun açısı ve çubuğun açısal hızı. Uyguladığımız kuvvet arabanın hızını değiştirecek ve dolaylı olarak arabanın konumunu değiştirecektir. CartPole-v0 oyununu birkaç satır kodla çalıştırabiliriz:

Kod çok basittir: İlk olarak, bir CartPole-v0 Environment nesnesi env oluşturun ve başlangıç durumuna girmek için ortamı sıfırlayın. Ardından, mevcut oyun durumu ilk çizildiğinde (render), ardından bir Action env.action_space.sample rasgele seçilir ve ardından eylemi gerçekten "yürütmek" için env.step işlevi çağrılır.

Gözlemler

Gözlem, MDP'deki durumdur ve Çevre adımının 4 dönüş değeri vardır:

Gözlem, gözlemi temsil eden bir nesnedir.Farklı ortamlardan dönen nesneler farklıdır.

Ödül kayan tip, Ödülü temsil eder.

done bool type Görevin bitip bitmediğini gösterir. Bölüm görevleri için bir bitiş durumu olacaktır. Bitiş durumuna girdikten sonra adımı çağırmanın bir anlamı yoktur.Önce sıfırlamayı çağırmalısınız.

bilgi Hata ayıklama için bazı bilgiler

Bazı bilgileri aşağıdaki kodla yazdırabiliriz:

-

Alanlar

Ortam nesnesinde iki boşluk vardır: Durum Uzayı ve Hareket Alanı, tüm olası durumları ve davranışları tanımlar. Bazı CartPole-v0 Uzaylarını görüntüleyebiliriz:

Çıktıdan, Ayrık (2) 'nin bu görevin iki seçili Eylem (sola ve sağa hareket eden dağıtım araçları) olduğu anlamına geldiği, Kutu (4,) durumun 4 boyutlu bir vektörle temsil edildiği ve fiziksel anlamın aracın göreceli orijini olduğu anlamına gelir. Çubuğun düşeye göre konumu ve hızı, açısı ve açısal hızı. Değer aralığını aşağıdaki kod ile kontrol edebiliriz:

-

- "Kurdu Öldürmek: Açgözlü Kurt" un trajik sonu kabul edilemez ve Louis Koo, gişeyi desteklemek için oyunculuk becerilerini kullanıyor

-

- "Kurdu Öldürmek: Açgözlü Kurt" iyi bir gişede gösterildi, Gu Tianle'nin oyunculuk becerileri patladı ve trajedi şikayetlerle sona erdi.