Derin öğrenme için "Derin Analiz" GPU seçildi. RTX 20 serisi buna değer mi?

Xinzhiyuan Raporu

Derin öğrenme genellikle "simya" olarak alay edilir, ardından GPU derin öğrenme araştırmacıları için vazgeçilmez bir "simya fırını" dır.

Derin öğrenme, yüksek hesaplama gereksinimleri olan bir alandır. Hangi GPU'yu seçeceğiniz ve kaç GPU seçeceğiniz derin öğrenme deneyiminizi temelde belirleyecektir. GPU yoksa, denemenin tamamlanmasını beklemek aylar sürebilir veya deneme tüm gün çalışır ve yalnızca başarısızlığın sonuçlarını görür.

İyi ve güvenilir bir GPU ile simyacılar, derin ağın tasarımını ve parametrelerini hızla yineleyebilir, deneyleri aylar yerine günler, günler yerine saatler ve saatler yerine dakikalar içinde çalıştırabilir. Bu nedenle, bir GPU satın alırken doğru seçimi yapmak çok önemlidir.

Tim Dettmers'ın GPU seçimi

Peki sizin için doğru GPU'yu nasıl seçersiniz? Bu makalenin yazarı Tim Dettmers, İsviçre Lugano Üniversitesi'nden bilişim alanında yüksek lisans derecesine sahiptir ve derin öğrenmeyi hızlandırmak için kendi GPU kümelerini ve algoritmalarını geliştirmeye isteklidir. Bu makale, bu sorunu derinlemesine incelemekte ve en uygun seçimi yapmanıza yardımcı olacak öneriler sunmaktadır.

NVIDIA'nın bu hafta şok edici bir şekilde piyasaya sürdüğü GeForce RTX 20 serisi grafik kartı almaya değer mi? Kapasitesi ve maliyet performansı nedir? Bu makale ayrıca bir analiz de vermektedir.

Önce sonucu koyun: RTX 2080, en uygun maliyetli seçimdir. Elbette GTX 1080/1070 (+ Ti) kart hala çok iyi bir seçim.

Yazarın verdiği GPU önerileri aşağıdaki gibidir:

-

Genel olarak en iyi GPU: RTX 2080 Ti

-

Uygun maliyetli, ancak pahalı: RTX 2080, GTX 1080

-

Uygun maliyetli ve uygun fiyatlı: GTX 1070, GTX 1070 Ti, GTX 1060

-

Kullandığım veri seti > 250GB: RTX 2080 Ti veya RTX 2080

-

Fazla bütçem yok: GTX 1060 (6GB)

-

Yetersizim: GTX 1050 Ti (4GB) veya CPU (prototipleme) + AWS / TPU (eğitim)

-

Kaggle yarışmasına katıldım: prototip oluşturma için GTX 1060 (6GB), son eğitim için AWS; fastai kitaplığını kullanın

-

Bilgisayarla görme araştırmacısıyım: RTX 2080 Ti; 2019'da RTX Titan'a yükseltebilirim

-

Ben bir araştırmacıyım: RTX 2080 Ti veya GTX 10XX- > RTX Titan (mevcut modelinizin depolama gereksinimlerine bakın)

-

Bir GPU kümesi oluşturmak istiyorum: Bu çok karmaşık, bu makaleye başvurabilirsiniz

-

Derin öğrenmeye yeni başladım ve ciddiyim: GTX 1060 (6GB) veya ucuz GTX 1070 veya GTX 1070 Ti ile başlayabilirsiniz. Bir sonraki adımda ne yapmak istediğinize bağlıdır (bir girişime gidin, bir Kaggle yarışmasına katılın, araştırma yapın, derin öğrenme uygulayın), ardından orijinal GPU'yu satıp daha uygun bir tane satın alın

Kapsamlı karşılaştırma: NVIDIA, AMD, Intel, Google, Amazon

NVIDIA: mutlak kral

NVIDIA'nın standart kitaplığı, CUDA'da ilk derin öğrenme kitaplığını oluşturmayı çok kolaylaştırırken, AMD'nin OpenCL'si bu kadar güçlü bir standart kitaplığa sahip değildir. NVIDIA'nın güçlü topluluk desteğiyle birleşen bu öncü avantaj, CUDA topluluğunun boyutunu hızla genişletti. Bu, NVIDIA GPU kullanıyorsanız, sorunlarla karşılaştığınızda kolayca destek bulabileceğiniz anlamına gelir; kendi CUDA programınızı yazarsanız, destek ve tavsiye bulmanız da kolaydır ve çoğu derin öğrenme kitaplığının NVIDIA GPU için sağlandığını göreceksiniz. En iyi destek. NVIDIA GPU için bu çok güçlü bir avantajdır.

Öte yandan, NVIDIA artık CUDA'yı veri merkezinde yalnızca Tesla GPU'lara izin vermek için kullanma ve GTX veya RTX kartlarını kullanmama politikasına sahip. "Veri merkezi" nin anlamı belirsizdir, ancak bu, yasal konularla ilgili endişeler nedeniyle araştırma kurumlarının ve üniversitelerin genellikle pahalı ve verimsiz Tesla GPU'ları satın almaya zorlandığı anlamına gelir. Ancak Tesla kartın GTX ve RTX kartlara göre büyük bir avantajı yok ve fiyatı 10 kat daha yüksek.

Nvidia bu politikaları herhangi bir büyük engel olmadan uygulayabilir, bu da tekel gücünü gösterir - istediklerini yapabilirler ve biz bu şartları kabul etmeliyiz. Toplulukta ve destekte NVIDIA GPU'nun ana avantajını seçerseniz, onların keyfi merhametini de kabul etmeniz gerekir.

AMD: güçlü, ancak destek eksikliği

HIP, NVIDIA ve AMD GPU'ları ROCm aracılığıyla ortak bir programlama dili altında birleştirir ve GPU montaj koduna derlenmeden önce ilgili GPU dillerinde derlenir. Tüm GPU kodumuz HIP'de ise, bu önemli bir kilometre taşı olacaktır, ancak oldukça zordur çünkü TensorFlow ve PyTorch kod tabanlarının taşınması zordur. TensorFlow'un AMD GPU'ları için bir miktar desteği vardır ve tüm büyük ağlar AMD GPU'ları üzerinde çalışabilir, ancak yeni ağlar geliştirmek istiyorsanız, bazı ayrıntıları gözden kaçırabilirsiniz, bu da istediğiniz sonuçları elde etmenizi engelleyebilir. ROCm topluluğu çok büyük değildir, bu nedenle sorunları hızlı bir şekilde çözmek kolay değildir. Ek olarak, AMD'nin derin öğrenme geliştirme ve destek için fazla fonu yok gibi görünüyor, bu da geliştirme ivmesini yavaşlatıyor.

Ancak AMD GPU performansı, NVIDIA GPU performansından daha kötü değil ve yeni nesil AMD GPU Vega 20, Tensor Core benzeri bir bilgi işlem birimine sahip çok güçlü bir işlemci olacak.

Genel olarak, yalnızca GPU'nun sorunsuz çalışmasını isteyen sıradan kullanıcılar için hala AMD GPU'yu açıkça öneremiyorum. Daha deneyimli kullanıcılar pek çok sorunla karşılaşmamalıdır ve AMD GPU ve ROCm / HIP geliştiricilerinin desteklenmesi, Nvidianın uzun vadede herkesin yararına olacak tekeliyle mücadeleye yardımcı olacaktır. Bir GPU geliştiriciyseniz ve GPU hesaplamasına önemli katkılar yapmak istiyorsanız, AMD GPU'lar iyi bir uzun vadeli etki yaratmanın en iyi yolu olabilir. Diğerleri için NVIDIA GPU'lar daha güvenli bir seçimdir.

Intel: Hala çalışmam gerekiyor

Intel Xeon Phis ile kişisel deneyimim çok hayal kırıklığı yaratıyor ve bunların NVIDIA veya AMD grafik kartlarının gerçek rakipleri olduklarını düşünmüyorum: Xeon Phi kullanmaya karar verirseniz, sorunlarla karşılaştığınızda alabileceğiniz desteğin çok sınırlı olduğunu lütfen unutmayın. Segment CPU'dan daha yavaştır ve optimize edilmiş kod yazmak çok zordur.C ++ 11 özelliklerini tam olarak desteklemez, bazı önemli GPU tasarım desen derleyicilerini desteklemez ve BLAS rutininden bu yana diğer kitaplıklarla (NumPy ve SciPy gibi) zayıf uyumluluğa sahiptir. Karşılaşmadığım birçok aksilik var.

Intel Nervana Sinir Ağı İşlemcisini (NNP) dört gözle bekliyorum çünkü özellikleri çok güçlü, yeni algoritmalara izin veriyor ve sinir ağlarının kullanım şeklini yeniden tanımlayabilir. NNP'nin 2019'un üçüncü çeyreğinde / dördüncü çeyreğinde piyasaya sürülmesi planlanıyor.

Google: İsteğe bağlı işleme daha mı ucuz?

Google TPU, son derece uygun maliyetli, çok olgun bir bulut tabanlı ürün haline geldi. TPU'yu anlamanın en kolay yolu, onu bir arada paketlenmiş birden fazla GPU olarak düşünmektir. Tensor Core'u destekleyen V100 ve TPUv2'nin performans göstergelerine bakarsak, ResNet50 için bu iki sistemin performansının hemen hemen aynı olduğunu görürüz. Ancak, Google TPU daha uygun maliyetlidir.

Peki TPU, bulut tabanlı uygun maliyetli bir çözüm mü? Evet denilebilir ya da hayır denilebilir. İster kağıt üzerinde ister günlük kullanımda, TPU daha uygun maliyetli. Bununla birlikte, fastai ekibinin ve fastai kitaplığının en iyi uygulamalarını ve yönergelerini kullanırsanız, daha düşük bir fiyata daha hızlı yakınsama elde edebilirsiniz - en azından birimleri ve ağları kullanarak nesne tanıma için.

Aynı yazılımı kullanarak TPU daha uygun maliyetli olabilir, ancak bazı sorunlar vardır: (1) TPU fastai kitaplığında, yani PyTorch'ta kullanılamaz; (2) TPU algoritması esas olarak Google'ın dahili ekibine bağlıdır, (3) birleşik Yüksek seviyeli kitaplıklar TensorFlow için iyi standartlar uygulayabilir.

Bu üç nokta TPU'ya çarptı çünkü yeni derin öğrenme algoritmalarına ayak uydurmak için ayrı bir yazılım gerektiriyor. Google ekibinin bu görevleri tamamladığına inanıyorum, ancak belirli modeller için desteğin ne kadar iyi olduğu net değil. Örneğin, TPU'nun resmi GitHub deposunun yalnızca bir NLP modeli vardır ve geri kalanı bilgisayarla görme modelleridir. Tüm modeller evrişimi kullanır ve hiçbiri tekrarlayan sinir ağları değildir. Ancak, zamanla yazılım desteğinin hızla artması ve maliyetlerin daha da düşmesi TPU'yu cazip bir seçenek haline getirecek. Ancak şu anda TPU, ana derin öğrenme kaynaklarından ziyade bilgisayarla görü için en uygun ve diğer bilgi işlem kaynaklarına ek olarak görünüyor.

Amazon: güvenilir ama pahalı

Bu blog gönderisinin son güncellemesinden bu yana AWS birçok yeni GPU ekledi. Ancak fiyat hala biraz yüksek. Birdenbire ek hesaplamalara ihtiyacınız varsa, örneğin tüm GPU'lar araştırma belgesinin son tarihinden önce kullanımdaysa, AWS GPU bulut sunucuları çok yararlı bir çözüm olabilir

Ancak, uygun maliyetliyse, yalnızca birkaç ağ çalıştırdığınızdan ve eğitim çalıştırması için seçilen parametrelerin optimuma yakın olduğunu tam olarak bildiğinizden emin olmalısınız. Aksi takdirde, maliyet etkinliği büyük ölçüde azalacak ve özel bir GPU kadar kullanışlı olmayacaktır. Hızlı AWS GPU cazip bir şekilde sağlam olsa bile, gtx1070 ve üstü, çok fazla maliyet olmadan bir veya iki yıl boyunca iyi bilgi işlem performansı sağlayabilir.

Özetle, AWS GPU bulut sunucuları çok kullanışlıdır, ancak maliyet etkinliğini sağlamak için akıllıca ve dikkatli kullanılmaları gerekir. Bulut bilişimi daha sonra tartışacağız.

Bir GPU'yu diğerinden daha hızlı yapan nedir?

Bir GPU seçerken ilk sorunuz şu olabilir: Derin öğrenme için, GPU hesaplamayı hızlı hale getiren en önemli özellikler nelerdir? CUDA Core mu, saat hızı mı yoksa RAM boyutu mu?

İyi bir basitleştirme önerisi "bellek bant genişliğine dikkat edin" olsa da, artık bunu önermiyorum. Bunun nedeni, GPU donanım ve yazılımının yıllar içinde geliştirilmiş olması ve böylece GPU bant genişliğinin artık performansının en iyi göstergesi olmamasıdır. Tensor Core'un tüketici GPU'larına eklenmesi bu sorunu daha da karmaşık hale getiriyor. şimdi, Bant genişliği, FLOPS ve Tensor Core kombinasyonu, GPU performansının en iyi göstergesidir .

Anlayışınızı derinleştirmek ve akıllıca seçimler yapmak için, donanımın hangi bölümlerinin GPU'nun en önemli iki tensör işlemini hızlı bir şekilde gerçekleştirmesini sağladığını anlamak en iyisidir: Matris çarpımı ve evrişim .

Matris çarpımını düşünmenin basit ve etkili bir yolu, bant genişliğinin kısıtlanmış olmasıdır. LSTM ve çok sayıda matris çarpımı gerektiren diğer tekrarlayan ağları kullanmak istiyorsanız, bellek bant genişliği GPU'nun en önemli özelliğidir.

Benzer şekilde, evrişim hesaplama hızı kısıtlamalarına tabidir. Bu nedenle, ResNets ve diğer evrişimli mimariler için GPU TFLOP, performansının en iyi göstergesidir.

Tensor Çekirdekleri bu dengeyi biraz değiştirdi. Tensor Çekirdekleri, hesaplamaları hızlandırabilen, ancak bellek bant genişliğini artırmayan özel bilgi işlem birimleridir, bu nedenle evrişimli ağlar için en büyük fayda, Tensor Çekirdeklerinin% 30 ila% 100 hızlanabilmesidir.

Tensor Çekirdekleri yalnızca hesaplamaları hızlandırabilse de, 16 bitlik sayıların kullanıldığı hesaplamalara da izin verirler. Bu aynı zamanda matris çarpımının büyük bir avantajıdır, çünkü sayının boyutu 32 bit yerine sadece 16 bittir Aynı bellek bant genişliğine sahip bir matriste, sayıların sayısı iki kez iletilebilir. Genel olarak, Tensor Çekirdeklerini kullanan LSTM,% 20 ila% 60 oranında hızlandırılabilir.

Lütfen bu ivmenin Tensor Çekirdeklerinden gelmediğini, 16 bitlik hesaplamalar yapabilme yeteneğinden geldiğini unutmayın. AMD GPU'lardaki 16 bit algoritma, Tensor Çekirdekli NVIDIA kartlarındaki matris çarpma algoritması kadar hızlıdır.

Tensor Çekirdekleriyle ilgili büyük bir sorun, ağ genellikle 32 bit değerler kullandığından bazı yazılım desteği sorunlarına neden olabilecek 16 bit kayan nokta giriş verilerine ihtiyaç duymalarıdır. 16 bitlik giriş yoksa, Tensor Çekirdekleri işe yaramaz.

Bununla birlikte, bu sorunların yakında çözüleceğini düşünüyorum çünkü Tensor Çekirdekleri çok güçlü ve artık tüketici GPU'ları da Tensor Çekirdeklerini kullanıyor, bu yüzden daha fazla insan bunları kullanacak. 16 bit derin öğrenmenin devreye girmesiyle, GPU'nun belleğini aslında iki katına çıkardık çünkü aynı belleğe sahip GPU'da bulunan parametreler iki katına çıktı.

Genel olarak, en iyi pratik kural şudur: RNN kullanıyorsanız, bant genişliğine bağlıdır; evrişim kullanıyorsanız, FLOPS'a bakın; Ödeyebiliyorsanız, Tensor Çekirdeklerini düşünün (Gerekmedikçe Tesla kartı satın almayın)

GPU ve TPU için standartlaştırılmış ham performans verileri. Ne kadar yüksek olursa o kadar iyi. RTX 2080 Ti'nin hızı, GTX1080 Ti'nin yaklaşık iki katıdır: 0.75'e karşı 0.4.

Maliyet analizi

Maliyet performansı, bir GPU seçerken göz önünde bulundurulması gereken belki de en önemli gösterge kategorisidir. Bunun üzerine, bellek bit genişliği, hesaplama hızı ve Tensor çekirdeğini dikkate alan yeni bir maliyet performans analizi yaptım. Fiyat açısından Amazon ve eBay'deki fiyatlardan bahsediyorum ve referans ağırlık oranı 1: 1. Daha sonra Tensor Core olan ve olmayan LSTM ve CNN'in performans göstergelerine baktım. Ortalama performans puanı, bu endeks numaralarının standartlaştırılmış geometrik ortalamasından elde edilir ve uygun maliyetli rakamlar hesaplanır.Sonuçlar aşağıdaki gibidir:

Standardizasyondan sonra uygun maliyetli sonuç, bellek bant genişliği (RNN), hesaplama hızı (evrişimli ağ) ve Tensor Çekirdeklerinin kullanılıp kullanılmayacağı gibi faktörleri hesaba katar. Sayı ne kadar yüksekse o kadar iyidir. RTX2080'in fiyat / performans oranı Tesla V100'ün yaklaşık 5 katıdır.

Gerçek sert performans verileri henüz yayınlanmadığı için RTX 2080 ve RTX 2080 Ti numaralarının biraz sulu olabileceğini lütfen unutmayın. Performansı, bu donanım altındaki matris çarpımı ve evrişim çatı hattı modeline ve V100 ve Titan V'den Tensor Core kıyaslama numaralarına dayanarak tahmin ediyorum. Şu anda hiçbir donanım spesifikasyon numarası olmadığından, RTX 2070 hiç dahil edilmemiştir. RTX 2070'in maliyet etkinliği açısından diğer iki RTX serisi grafik kartını kolayca yenebileceğini, ancak şu anda veri desteği bulunmadığını unutmayın.

Ön verilerden, RTX 2080'in RTX 2080 Ti'den daha uygun maliyetli olduğunu gördük. RTX2080 ile karşılaştırıldığında, RTX 2080 Ti'nin Tensor çekirdeği ve bant genişliği yaklaşık% 40 arttı ve fiyatı% 50 arttı, ancak performans% 40 artmadı. LSTM ve diğer RNN'ler için, GTX 10 serisinden RTX 20 serisine performans artışı, esas olarak Tensor çekirdeğinin kendisi değil, 16 bit kayan nokta hesaplamaları desteğinden kaynaklanmaktadır. Evrişimli ağın performansının teorik olarak Tensor çekirdeği ile doğrusal olarak artması gerekmesine rağmen, bunu performans verilerinden görmedik.

Bu, evrişimli mimarinin diğer bölümlerinin Tensor çekirdeği ile performans iyileştirmeleri sağlayamadığını ve bu parçaların aynı zamanda genel bilgi işlem gereksinimlerinin büyük bir bölümünü oluşturduğunu göstermektedir. Bu nedenle, RTX 2080, GTX 10 serisine göre performans iyileştirmeleri (GDDR6 + Tensor çekirdek) elde etmek için gereken tüm işlevlere sahip olduğu ve ayrıca RTX 2080 Ti'den daha ucuz olduğu için daha uygun maliyetlidir.

Ayrıca okuyuculara bu analizde bazı sorunlar olduğu ve bu verilerin yorumlanmasında dikkatli olunması gerektiği hatırlatılır:

(1) Uygun maliyetli ancak daha yavaş bir hesaplama hızına sahip bir grafik kartı satın alırsanız, bilgisayarda artık bir noktada daha fazla GPU alanı olmayabilir ve bu da kaynak israfına neden olur. Bu nedenle, bu grafik pahalı GPU'lara eğilimlidir. Bu sapmayı önlemek için orijinal performans çizelgesi de değerlendirilmelidir.

(2) Bu maliyet performans çizelgesi, okuyucuların 16 bitlik hesaplamaları ve Tensor çekirdeklerini olabildiğince çok kullanacağını varsayar. Başka bir deyişle, 32 bit bilgi işlem için RTX grafik kartları çok uygun maliyetlidir.

(3) Kripto para piyasasındaki düşüş nedeniyle çok sayıda RTX 20 serisi grafik kartının ertelendiğine dair söylentiler var. Bu nedenle, GTX 1080 ve GTX 1070 gibi popüler madencilik GPU'larının fiyatı hızla düşebilir ve fiyat / performans oranları hızla artabilir, bu da RTX 20 serisini fiyat / performans açısından daha az avantajlı hale getirir. Öte yandan, çok sayıda RTX 20 serisi grafik kartının fiyatı, rekabet güçlerini sağlamak için sabit kalacak. Bu grafik kartlarının gelecekteki beklentilerini tahmin etmek zordur.

(4) Daha önce de belirtildiği gibi, şu anda RTX grafik kartlarında kesin ve tarafsız bir performans verisi bulunmadığından tüm bu rakamlar çok ciddiye alınamaz.

Bu kadar çok ekran kartı arasından doğru seçimi yapmanın kolay olmadığı görülüyor. Bununla birlikte, okuyucular tüm bu konulara dengeli bir şekilde bakarlarsa, aslında kendi en iyi seçimlerini yapabilirler.

Bulutta derin öğrenme

Google Cloud'da AWS ve TPU'daki GPU örnekleri, derin öğrenme için uygun seçeneklerdir. TPU biraz daha ucuz olsa da AWS GPU'ların çok yönlülüğünden ve esnekliğinden yoksundur. TPU, hedef tanıma modellerini eğitmek için ilk tercih olabilir. Ancak diğer iş yükü türleri için AWS GPU'lar daha güvenli bir seçim olabilir. Bulut örneklerini dağıtmanın avantajı, istediğiniz zaman GPU ve TPU arasında geçiş yapabilmeniz ve hatta bunları aynı anda kullanabilmenizdir.

Ancak, lütfen bu senaryodaki fırsat maliyeti sorununa dikkat edin: okuyucu AWS bulut sunucuları kullanarak iş akışını başarıyla tamamlama becerilerini öğrenirse kişisel GPU'larla çalışma zamanını kaybedecek ve TPU kullanma becerilerini edinemeyecektir. Kişisel bir GPU kullanıyorsanız, bulut aracılığıyla daha fazla GPU / TPU'ya genişletemezsiniz. TPU kullanıyorsanız TensorFlow'u kullanamazsınız ve AWS platformuna geçmek kolay bir iş değildir. Sorunsuz bir bulut iş akışının öğrenme maliyeti çok yüksektir. TPU veya AWS GPU'yu seçerseniz, bu maliyeti dikkatlice tartmalısınız.

Diğer bir soru da bulut hizmetlerinin ne zaman kullanılacağıdır. Okuyucular derin öğrenmeyi öğrenmek istiyorsa veya prototipler tasarlamaya ihtiyaç duyuyorlarsa, kişisel bir GPU kullanmak en iyi seçim olabilir çünkü bulut örnekleri pahalı olabilir. Ancak, iyi bir derin ağ yapılandırması bulduğunuzda ve modeli eğitmek için yalnızca bulut örnekleriyle veri paralelliği kullanmak istediğinizde, bulut hizmetlerini kullanmak güvenilir bir yoldur. Başka bir deyişle, küçük bir GPU prototipleme için yeterlidir ve ayrıca deneylerin ölçeğini genişletmek ve daha karmaşık hesaplamalar elde etmek için bulut bilişimin güçlü işlevlerine güvenebilirsiniz.

Yeterli paranız yoksa, bulut bilişim örneklerini kullanmak da iyi bir çözüm olabilir, ancak sorun şu ki, yalnızca küçük bir prototiplemeye ihtiyacınız olduğunda, yine de yalnızca zamanında çok fazla bilgi işlem gücü satın alabilir, bu da maliyetlere ve işlem gücüne neden olur. atık. Bu durumda, insanlar CPU üzerinde prototip oluşturmak ve ardından GPU / TPU örneği üzerinde hızlı eğitim gerçekleştirmek isteyebilir. Bu optimal bir iş akışı değildir, çünkü CPU üzerinde prototip oluşturmak çok zahmetli olabilir, ancak gerçekten uygun maliyetli bir çözümdür.

sonuç olarak

Bu makalede okuyucular, kendileri için hangi GPU'nun doğru olduğunu anlayabilmelidir. Genel olarak, bir GPU seçerken iki ana strateji olduğunu düşünüyorum: Hızlı yükseltmeler için RTX 20 serisi GPU'ları kullanın ya da önce ucuz GTX 10 serisi GPU'ları kullanın ve RTX Titan piyasaya sürüldükten sonra yükseltme yapın. Performans önemli değilse veya Kaggle veri yarışmaları, başlangıçlar, prototip oluşturma veya öğrenme derin öğrenme gibi yüksek performans gerekli değilse, nispeten ucuz GTX 10 serisi GPU da iyi bir seçimdir. GTX 10 serisi GPU'yu seçerseniz, lütfen GPU bellek boyutunun gereksinimlerinizi karşılayabileceğinden emin olun.

Peki derin öğrenme için GPU nasıl seçilir? Önerilerim aşağıdaki gibidir:

timdettmers.com/2014/09/21/how-to-build-and-use-a-multi-gpu-system-for-deep-learning/

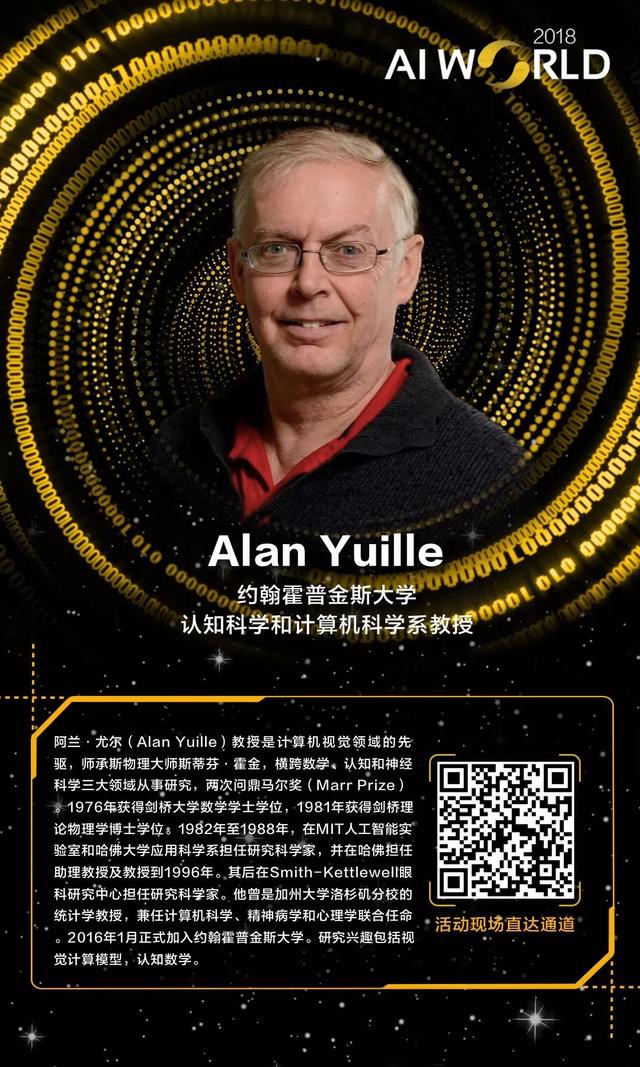

Xinzhiyuan AI WORLD 2018 Geri Sayım 27 gün

Biletler satışta!

Xinzhiyuan, AI WORLD 2018 konferansını 20 Eylül'de Pekin'deki Ulusal Kongre Merkezi'nde gerçekleştirecek ve makine öğrenimi vaftiz babası, CMU profesörü Tom Mitchell, Mikes Tekmark, Zhou Zhihua, Tao Dacheng, Chen Yiran ve diğer AI liderlerini makine zekasına dikkat etmeye davet edecek. Ve insan kaderi.

Konferans resmi web sitesi:

-

Aktivite hattı bileti satın alma bağlantısı:

-

Etkinlik satırı bilet alımı için QR kodu:

-

- Yetkili açıklama Jiangxi Eyaletinin sosyal güvenliği, Bahar Şenliği boyunca genellikle istikrarlı ve düzenlidir.

-

- Çin Süper Lig Önizlemesi: Pekin Derbisinin "sıcaklığı" sahnelendi, Jianye planlanandan önce küme düşme savaşına başladı

-

- Nvidia GPU, profesyonel madencilik makinesi tarafından ezildi, Huang Renxun, kripto para işinin kesildiğini açıkladı!

-

- Shanxi'deki mezar soygunu olayına karışan 19 kişi polis tarafından aranıyor Herhangi bir ipucunuz varsa, lütfen hemen polisi arayın!

-

- İnsanlık karşı koymak için ayağa kalkıyor! OpenAI, Waterloo tarafından mağlup edildi ve Dota2 en üst seviye nakavt turu yenildi!

-

- Yüzölçümü Hainan'ın sadece beşte biri kadar olan bu küçük Güneydoğu Asya ülkesi Dubai'den daha mı zengin?