Oyun teorisindeki bu üç yeni eğilim, derin takviyeli öğrenmeyi derinden etkiliyor

Yazar | Jesus Rodriguez

Derleme | Arman Pepi

Düzeltme | Cong Mo ve Camel

Editör | Tang Li

Oyun teorisi, modern yapay zeka (AI) çözümlerinde hayati bir rol oynuyor ve derin pekiştirmeli öğrenme (DRL), oyun teorisini aktif olarak benimseyen birinci sınıf vatandaş.

Tek aracılı programlardan karmaşık çok aracılı derin pekiştirmeli öğrenme ortamlarına kadar, oyun teorisinin ilkeleri, AI programlarının tüm yaşam döngüsü boyunca çalışır. Buna karşılık, DRL'nin hızlı evrimi, insanların oyun teorisi araştırmalarına olan ilgisini de yeniden canlandırdı. Dikkat .

Şu anda, çoğu DRL modeli aslında hala Nash dengesi veya sıfır toplamlı oyunlar gibi geleneksel oyun teorisi seviyesindedir. Bununla birlikte, DRL'nin gelişmesiyle birlikte, geleneksel oyun teorisi yöntemleri yavaş yavaş eksikliklerini gösterirken, aynı zamanda bazı yeni oyun teorisi yöntemleri yapay zeka programlarına dahil edildi.

Bu nedenle, bizim için derin pekiştirmeli öğrenme modelini daha da optimize etmek istiyorsak, dikkate değer bir yön olan yeni oyun teorisi yöntemlerini dahil etmeyi düşünün.

Aşağıdaki üçü, DRL'yi derinden etkileyen tam olarak "yeni" oyun teorisi yöntemleridir ve modelinizde kullanılabilir. Çok Modelin performansını artırın.

1. Ortalama Saha Oyunları (Ortalama Saha Oyunları)

Oyun teorisi ailesinde, Ortalama Alan Oyunu (MFG) hala nispeten yeni bir alandır.

Ortalama saha oyunu teorisi 2006'da doğdu. Bu teori, biri Minyi Huang, Roland Malhame ve Peter Gaines Montreal'den, diğeri ise Paris'teki Jean-Michel Lasry ve Fields Madalyası kazananları olmak üzere iki takım tarafından bağımsız olarak önerildi. Pierre-Louis Lions.

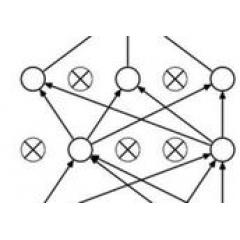

Kavramsal olarak, ortalama saha oyunu teorisi, büyük bir "rasyonel oyun partileri" grubu altında farklılaştırılmış oyunları incelemek için kullanılan yöntem ve tekniklerin bir kombinasyonudur. Bu temsilciler yalnızca kendi devletlerini (servet, sermaye gibi) tercih etmekle kalmaz, aynı zamanda Dikkat Diğer ajanların tüm örnek dağılımındaki konumu. Ortalama alan oyun teorisi, bu sistemler için genelleştirilmiş Nash dengesini inceler.

Ortalama bir tarla oyununun klasik örneği, bir balık sürüsünün aynı yönde yüzmesi veya ortak bir şekilde yüzmesi için nasıl eğitileceğidir.

Bu fenomeni teori ile açıklamak zordur, ancak özü aslında balığın en yakın balık okulunun davranışına göre tepki vermesidir. Daha spesifik olmak gerekirse, her balık diğer balıkların davranışlarını önemsemez, ancak Dikkat Bir bütün olarak yakınlarda hareket eden bir balık sürüsünün davranışı.

Bu prensibi ifade etmek için matematiksel bir denklem kullanırsak, bir yandan balığın çevredeki balık okuluna verdiği tepkiyi tanımlamak için Hamilton-Jacobi-Bellman denklemini kullanabiliriz, diğer yandan tüm balık okulunu belirleyen tüm eylemleri ifade etmek için Fokker-Planck-Kolmogoroy denklemini kullanabiliriz. Balık davranışı koleksiyonu.

Ortalama alan oyunu teorisi bu iki denklemin birleşimidir.

Derin takviyeli öğrenme perspektifinden, ortalama saha oyunu teorisi, çok çeşitli ortamlarda çok sayıda ajanın performansının incelenmesinde önemli bir rol oynar.

Deneyler ve teoriler, mevcut DRL yönteminin "sonsuz sayıda aracıya yakın olduğu ve operasyon için kesin olmayan olasılık modelleri varsayıldığı" bir ortamda gerçekçi kullanılabilirliğe sahip olmadığını doğrulamıştır.

Ancak MFG, bu tür bir DRL ortamını simüle etmenin ilginç bir yoludur ve denemeye değer.

Prowler adlı bir başlangıç şirketi, kısa süre önce büyük bir çok-ajanlı (DRL) ortamda ortalama saha oyunu teorisinin (MFG) performansı üzerine araştırma yaptı.

2. Stokastik oyunlar

Rastgele oyun 1950'lere kadar uzanmaktadır ve Nobel Ödülü sahibi Lloyd Shapley tarafından ortaya atılmıştır.

Teorik olarak, rastgele oyunun kuralı, sonlu sayıda oyuncunun sonlu bir durum uzayında oynamasına izin vermektir.Her oyuncu, her durum uzayında sınırlı sayıda davranıştan bir davranış seçer.Bu davranışların kombinasyonu sonucu belirleyecektir. Oyuncu tarafından elde edilen ödül ve bir sonraki durum uzayının olasılık dağılımı.

Rastgele oyunun klasik örneği, filozofun akşam yemeği problemidir: n + 1 filozoflar (n, 1'den büyük veya eşittir), yuvarlak masanın ortasında bir kase pirinçle yuvarlak bir masa etrafında otururlar. Her iki filozof arasına, ikisinin kullanması için yan yana bir çubuk yerleştirilir. Masa yuvarlak olduğu için filozoflar kadar yemek çubukları da var. Filozofun kaseden yiyecek alabilmesi için her iki taraftan aynı anda birer yemek çubuğu alması gerekir, bu nedenle bir filozof yemek yerken iki komşusu aynı anda yemek yiyemez. Bir filozofun hayatı o kadar basittir ki, sadece yemek yemeyi ve düşünmeyi gerektirir ve hayatta kalmak için filozofun sürekli düşünmesi ve yemesi gerekir. Bu oyunun görevi, tüm filozofların hayatta kalmasını sağlayan bir sistem tasarlamaktır.

DRL, çok oyunculu oyun problemlerini çözmek için şimdiden rastgele oyun teorisi uygulamaya başladı. Birçok çok oyunculu oyunda, yapay zeka aracı ekiplerinin olumlu sonuçları en üst düzeye çıkarmak için diğer aracılarla nasıl işbirliği yapacağını ve rekabet edeceğini değerlendirmesi gerekir.

Bu soruna genellikle keşif-sömürü ikilemi denir. DRL aracısında rastgele bir oyun dinamik mekanizması oluşturmak, DRL aracısının keşif ve kullanım yeteneklerinin gelişimini etkili bir şekilde dengeleyebilir. DeepMind, Quake III oyununda ustalaşmak için yapay zeka eğitimi çalışmasına rastgele oyun teorisinden bazı kavramları dahil etti.

3. Evrim Oyunları (Evrim Oyunları)

Evrimsel Oyun Teorisi (EGT), Darwin'in evrim teorisinden esinlenmiştir.

EGT'nin kökeni 19'a kadar izlenebilir. 73 O zamanlar, John Maynard Smith ve George R. Price, evrimsel rekabeti resmileştirmek ve farklı rekabet stratejilerinin sonuçlarını tahmin etmek için matematiksel standartlar oluşturmak için "strateji" analizini kullandılar.

Kavramsal olarak EGT, evrimsel senaryolarda oyun teorisinin bir uygulamasıdır. Bu oyunda, bir grup ajan, tekrarlanan seçimin evrimsel süreci boyunca çeşitlendirilmiş stratejilerle etkileşime girmeye devam eder ve böylece kararlı bir çözüm yaratır.

Arkasındaki fikir şudur: Çoğu davranış, gruptaki birden çok ajan arasındaki etkileşimi içerir ve ajanlardan birinin başarılı olup olmadığı, benimsediği stratejinin diğer ajanların stratejileriyle nasıl etkileşime girdiğine bağlıdır.

Klasik oyun teorisi Dikkat Statik stratejiler üzerinde durulur, yani katılımcılar tarafından benimsenen stratejiler zamanla değişmez Evrimsel oyunlar klasik oyun teorisinden farklıdır. Dikkat Strateji zaman içinde nasıl gelişir ve hangi dinamik strateji evrimsel süreçte en başarılı olanıdır.

EGT'nin klasik örneği, paylaşılabilir kaynaklar için kartallar ve güvercinler arasındaki rekabeti simüle eden Howk Dove Game'dir. Oyundaki her yarışmacı aşağıdaki iki stratejiden birini takip eder:

-

kartal: İçgüdüsel olarak güçlü, saldırganlık dolu, ciddi şekilde yaralanmadığı sürece asla geri çekilmeyecek.

-

güvercin: Güçlü bir saldırı ile karşı karşıya kaldığında hemen kaçacak.

Varsayalım:

1) Aynı saldırgan saldırıya sahip iki kartal dövüşüyorsa, ikisi arasında kaçınılmaz olarak çatışmalar meydana gelir ve her ikisi de muhtemelen yaralanır;

2) Çatışmanın bedeli, herkesin belirli bir derecede zarar görmesidir.Bu kaybı temsil etmek için sabit bir C kullanın;

3) Kartal, güvercinle karşılaşırsa, güvercin hemen kaçar ve kartal kaynakları işgal eder;

4) İki güvercin karşılaştığında, kaynakları adil bir şekilde paylaşacaklar. Kartal-güvercin oyununun karşılık gelen geliri aşağıdaki matris ile özetlenebilir:

EGT, DRL ortamı için özel olarak tasarlanmış gibi görünüyor.

Çok aracılı DRL ortamında, aracılar birbirleriyle etkileşim süreci sırasında stratejilerini periyodik olarak ayarlayacaktır. EGT, bu etkileşimleri verimli bir şekilde simüle etmenin bir yoludur. Son zamanlarda OpenAI, saklambaç oyunları oynarken böyle dinamik bir eğitimden geçmiş bir temsilcinin performansını gösterdi (https: // openai .com / blog / acil araç kullanımı /).

https: // directiondatascience aracılığıyla .com / yeni-oyun-teorisi-yenilikleri-etkileyen-güçlendirme-öğrenme-247 79 f7e82b1

-

- Kayıt "Yolda Makine Öğrenimi ve Gizlilik Koruması" | Pekin Posta ve Telekomünikasyon Üniversitesi'ne AI TIME

-

- Şimdiye kadarki en bilimsel ticaret yöntemlerinden biri olan ünlü Wall Street tüccarlarının "huni pozisyonu" ticaret yöntemi çok pratik ve tek adımda yapılabiliyor.

-

- Hasta hissetmek? Adam et tezgahından 30 kilo sosis alıp kaçtı, yakalandığında boynunun bir kısmı hala vardı ...

-

- 3 yılda 100.000 anapara ve 5 milyon kazandım, sırf ölüm yüzünden: 3 yin yemiyorum 1 yang al, 3 yang yemiyorum 1 yin sat, neredeyse tüm artanları yiyor

-

- A hissesi için en yalancı olmayan altın göstergesi: Ana çaba tamamlandığında, bu 5 özellik belirleyici olan "hacim" de görünecektir.

-

- Çin borsasındaki en karlı kişi: "En alt hacim en yüksek hacmi aşıyor" - hisse senedi fiyatı yükselmeden önceki son sinyal, başarı oranı şaşırtıcı derecede yüksek

-

- Yıldızlar göz kamaştırıcı ve hayaller kurmak için eş merkezli, Douyin büyük kahveleri Guiyang'daki vahşi dalgalara yardım ediyor