ICCV 2017 gündem maddesi yorumlaması: yayaların yeniden tanımlanmasının doğruluğu nasıl artırılır

Leifeng.com AI teknolojisi inceleme basını, bu makalenin yazarı Sun Yifan, bu makale ilk olarak Zhihu sütununda yaya yeniden tanımlama yayınlandı, Leifeng.com AI teknolojisi incelemesini yeniden basma yetkisi verildi.

Makale bağlantısı: arXiv: 1703.05693 (https://arxiv.org/abs/1703.05693)

Kod bağlantısı: syfafterzy / SVDNet-for-Pedestrian-Retrieval (https://github.com/syfafterzy/SVDNet-for-Pedestrian-Retrieval)

1. Arka Plan Giriş

Son yıllarda, yaya yeniden tanımlama sorunu (Person-reID) ile ilgili araştırmalar giderek artmıştır. Yüz tanıma ile karşılaştırıldığında, görüntü toplarken yayaların aktif işbirliğini gerektirmez ve güvenlik ve diğer alanlarda büyük uygulama potansiyeline sahiptir. Derin öğrenmeye dayalı yaya yeniden tanıma yöntemleri son yıllarda hızlı bir ilerleme kaydetmiştir.Genel veri kümelerinin çoğunda, derin öğrenme özellikleri manuel tasarım özelliklerini aşmıştır. Bu makalenin çalışması esas olarak, yaya tanımanın doğruluğunu iyileştirmek için derin özelliklerin nasıl daha iyi öğrenileceği etrafında dönüyor. Bununla birlikte, bu makale yayaların yeniden tanımanın benzersiz sorunlarını gerçekten analiz etmiyor ve optimize etmiyor.Yazar, bu yöntemin küçük veri kümeleri sorunu için genel bir öneme sahip olduğuna ve yöntemin CNN özelliklerinin fiziksel anlamını geliştirmek için kullanıldığına inanıyor. Bazı ilginç düşünceler.

İki, Motivasyon

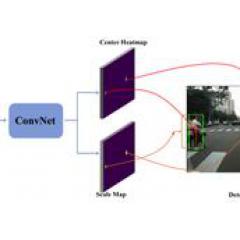

Dikkat edilmesi gereken ilk şey, SVDNet'in CNN ağırlık vektörünün bu kadar basit bir yorumuna dayandığıdır: CNN'nin girdisinin I, çıktının O ve ağırlık matrisinin W olduğunu varsayalım, o zaman O = W '* I işlemi yapıyor Doğrusal izdüşüm ve W'de bulunan ağırlık vektörü, bir projeksiyon temel vektörleri kümesidir. Yeniden kimlik probleminde yayaların özelliklerini çıkarmak için derin bir evrişimli sinir ağını (CNN) eğitirken, diğer tüm tipik derin öğrenme eğitimlerinde olduğu gibi, genellikle öğrenilen ağırlık vektörleri "düzensizdir". Bozukluk, ağın aynı katmanındaki ağırlık vektörlerinin genellikle güçlü bir korelasyona sahip olduğu gerçeğinde yansıtılır (doğrusal bağımlı olmadıklarını unutmayın). Bu tür bir korelasyon, özellik ifadesi için gereksiz ve hatta çok zararlı fazlalığa neden olabilir. Örneğin, aşağıdaki şekilde, ağ tarafından özellikleri ayıklamak için kullanılan özellik katmanının üç ağırlık vektörü içerdiğini varsayalım. Kırmızı ve pembe ile temsil edilen ağırlık vektörleri geometrik olarak daha yakınken mavinin ağırlık vektörü nispeten uzaktadır. O zaman, bir yaya görüntüsü olduğunda Ağa girdikten sonra, sonunda 3 boyutlu bir özellik oluşturmak için bu 3 ağırlık vektörüne yansıtılacak ve kırmızı ve pembe üzerindeki projeksiyon sonuçları çok yakın olacak. Bu, mavi üzerindeki izdüşümün sonucunu önemsiz kılar ve muhtemelen bazı yanlış yargılara neden olur.

Bu nedenle, özellik ifade katmanı için (bu katmanın çıktısı yaya görüntüsünün özelliği olarak kullanılır) ağırlık vektörünün ortogonal olmasını umuyoruz. Derin öğrenmedeki ortogonal kısıtlamalar hakkında biraz daha konuşalım. Aslında, son yıllarda derin öğrenmede ortogonal kısıtlamalar nadir değildir. Örneğin, ICLR2016'nın Temsilleri İlişkilendirerek Derin Ağlarda Aşırı Uyumu Azaltması (arXiv: 1511.06068) ve aynı ICCV2017 çalışması arXiv: 1511.06068. Ek olarak, beyazlatılmış ağ ve ICML 2017'nin genelleştirilmiş beyazlatılmış ağı gibi, derin öğrenmede ortogonalizasyonun olası faydalarından yararlanabileceği de düşünülebilir. Ancak, bu çalışmaların hepsinin, farklı boyutlardaki değişkenlerin birbirinden bağımsız olmasını umarak, özelliğin farklı boyutlarının değerlerini bir değişken olarak ele aldığını belirtmek gerekir. SVDNet çalışması, ağırlık vektörlerinin ortogonal olmasını umarak bu yaklaşımı önler. Makalede, titiz değerlendirmelerin dışında, bu iki yaklaşım arasındaki fark açıklanmıyor. Yazar, bunun aslında ustaca olduğuna inanıyor. Derin öğrenme eğitim metodu ile sınırlandırılan, özelliklere ortogonal kısıtlamalar uygulandığında, özelliğin kovaryans matrisi ancak bir minibatch'te elde edilebilir ve matrisin diyagonal bir matris olması gerekir.Bu yaklaşımın kendisi çaresizdir. SVDNet yaklaşımı bu güçlüğü ortadan kaldırır Aslında, her ağırlık vektörünün karşılık gelen özelliğin karşılık gelen boyutunda bir örnek veya ajan olduğu fikrini kullanır. Bu yorum son zamanlarda yapılan birçok çalışmaya da yansımıştır.

3. Eğitim yöntemi RRI

-CNN eğitiminde ağırlık vektörüne ortogonal kısıtlamalar nasıl uygulanır?

Önce nasıl yapılacağını, sonra nedenini açıklayayım.

Yöntem çok basittir, Restraint and Relaxation Iteration (RRI) adı verilen 3 adıma bölünmüştür:

1. Dekorasyon ilişkisi - her eğitim modeli yakınsadıktan sonra, özellik ifade katmanının ağırlık matrisi W, tekil değer ayrıştırmasına, yani W = USV'ye tabi tutulur ve daha sonra orijinal W'nin yerine US kullanılır. Bu zamanda, W, bir Ortogonal matris (her ağırlık vektörü birbirine ortogonaldir) ve yeni ağırlık vektörü, orijinal ağırlık matrisinin WW 'öz vektörüdür. Böyle bir ilintisizleştirmeden sonra, başlangıçta yakınsayan model orijinal yerel optimal çözümden sapar ve eğitim setindeki sınıflandırma kaybı daha büyük hale gelir.

2. Adım 1'de W'yi güncellemeden kısıtlayın ve ağ yeniden birleşene kadar diğer katman parametrelerini öğrenin. Bu durumda, ağın optimal olmayan bir çözüme yaklaşacağı unutulmamalıdır: çünkü sınırlı bir W katmanına sahiptir. Bu nedenle bir sonraki adımda bu kısıtlamayı kaldırıp eğitime devam edeceğiz.

3. Gevşeme eğitimi (Gevşeme) - 2. adımdan sonra, sabit W limitini iptal edin. Bu sırada ağ, eğitim örneklerini yerleştirme hedefine daha iyi bir çözüm bulacaktır: lütfen bunun yalnızca uydurma için olduğunu unutmayın Eğitim örneklerinin hedefi. Deneylerimiz, bu model eğitim setinde kullanıldığında (yepyeni bir kimlik dahil) genelleme yeteneğinin nispeten zayıf olduğunu bulmuştur.

3. adımdan sonra, W'deki ağırlık vektörü yeniden ilişkilendirilir. Bu nedenle, sonunda birleşecek olan RRI'yi oluşturmak için bu 3 adımı yineliyoruz.

4. RRI'da ne oldu?

RRI'de, her Kısıtlama aşamasından sonra ağırlık vektörü ilişkisiz hale getirilir, W ortogonal bir matris haline gelir ve ReID'nin doğruluğu iyileştirilir; ve her Gevşeme aşamasından sonra ağırlık vektörü tekrar ilişkilendirilir ve ReID'nin doğruluğu Durgunluk biraz daha azaldı (önceki Kısıtlama ile karşılaştırıldığında). Bununla birlikte, Gevşeme aşamasını karşılaştırdığımızda, W ortogonalitesinin S (W) geliştiğini ve Reid'in doğruluğunun, ikisi neredeyse aynı anda yakınsama durumuna ulaşana kadar arttığını görebiliriz. Aşağıya bakınız:

Yukarıdaki resim bu makaledeki en önemli ve ilginç resim olup, SVDNet yönteminin "ne olduğunu bilmek ve nedenini bilmek" anlamında ilkesini kanıtlamaktadır. Şekildeki S (W) - W'nin dikliğini ölçmek için kullanılan değişkenin tanımı bu makalede açıklanmamıştır, çok basit ve sezgiseldir ve ilgilenen öğrenciler makaleyi görüntüleyebilirler. İlginç olan kısım, yoğun eğitim aşamasında reID'nin performansının iyileştirilmesidir; gevşeme eğitimi aşamasında reID'nin performansı azalır. Bu, insani öğrenme yasamıza benziyor: gevşeme, gergin olduğunda ilerleme ve birikim için alternatif gevşeme kombinasyonunu savunuyoruz.

Beş, performans

SVDNet yönteminin performansı, 2017'nin başında son teknolojiye yaklaştı. Ayrıca, yöntemin saflığı için, SVDNet "ayna" dışında herhangi bir görüntü geliştirmesi kullanmaz ve girdi görüntüsü de temel modelin varsayılan boyutunu kullanır. Spesifik performans karşılaştırması için makaleye bakın, burada yalnızca pazar 1501 veri setindeki karşılaştırma bulunmaktadır.

Yaygın olarak kullanılan bazı ön işleme ve veri geliştirmeyi benimsedikten sonra, SVDNet seviyesi daha da geliştirildi. Örneğin, market-1501'de, 256 istenilen boyutta bir görüntü boyutu kullandıktan sonra, yeniden ağa bağlanmış SVDNet, yaklaşık% 84 + sıra 1 doğruluğu ve% 65 + mAP elde edebilir. Rastgele mahsul verileriyle daha fazla geliştirmeden sonra,% 88 R-1 doğruluğu ve% 68 mAP elde edilebilir. DukeMTMC-reID veri setinde, SVDNet'in performansı nispeten daha dikkat çekicidir.

Ayrıca SVDNet'in kafenin eski antik ağ yapısında da çok iyi performans gösterdiğini belirtmekte fayda var. Bu özelliğin diğer yöntemlerde elde edilmesi genellikle zordur (elbette bilgi damıtma gibi yöntemler de elde edilebilir).

Altı, eğlencenin anahtarı

W'yi ilişkisizleştirmek için neden SVD kullanılıyor?

SVD'nin W'yi ilişkisiz hale getirmek için neden kullanıldığına gelince, makale basitçe bazı ispatlar yapıyor: EigenLayer'dan önce h özelliği verildiğinde x1 ve x2'den herhangi iki örnek doğrusal projeksiyondan sonra mesafelerini inceleyin, W (= USV ') ve US, doğrusal izdüşüm katmanının ağırlık matrisi olarak kullanılır.Her iki durumda da, numuneler arasındaki mesafe kesinlikle korunur. Diğer ilintisizleştirme yöntemleriyle, numuneler arasındaki mesafe değişir ve deneysel doğrulama, "ilişkisizleştirme işlemi" sonrasında reid performansını düşürür. Ayrıntılı deney ve kesinti için makaleye bakın.

Makalede yukarıda bahsedilen mesafe garantili korelasyonun ispat formülü çok açıktır, ancak, bir yolu "ispatlamaktan" çok "düşünmek" çok daha zordur. Yazarın yaklaşımı aslında sezgisel bir yorumdan geldi: CNN'nin her doğrusal katmanı, girdiyi yeni bir özellik alanına yansıtır. Eğitim süreci sırasında, CNN çok ayırt edici bir projeksiyon temel vektörü, yani W'deki her bir ağırlık öğrendi. vektör. Ve bir düşünce: CNN bize bir dizi ağırlık vektörünün çok iyi olduğunu, ancak CNN'nin biraz tutarsız ve tekrarlı olduğunu söylerse, CNN bize bu ağırlık vektörleri kümesi tarafından temsil edilen projeksiyon temel vektörlerinin eşdeğer olduğunu açıkça söyleyebilir mi? Öz nedir (ortogonal temel)?

Uç bir örnek olarak, belirli bir katmanda 3 ağırlık vektörü olduğunu ve bunların 2 boyutlu olduğunu varsayalım, v1 = (0,1), v2 = (0,1), v3 = (1,0), Açıkçası, bu ağırlık vektörünün sonucu mantıksız, çünkü sadece 2 ağırlık vektörüne ihtiyaç duymak yeterli olmalı.Sonra soru şu ki, CNN iki projeksiyon yönünün (0, 1) ve (1, 0) sonucunun olup olmadığını düşünüyor. Eşit derecede önemli mi? V1 ve v3'ü saklayıp v2'yi doğrudan kaybedebilir miyiz? Durumun böyle olmadığını sezgisel olarak hissediyoruz. CNN bize (0,1) üzerindeki projeksiyon sonucunun daha önemli olduğunu söylemeye çalışır.SVDNet'teki ilintisizleştirme yöntemi CNN tarafından öğrenilen projeksiyon vektörünü ortogonal kümeye dönüştürmektir. Temel olarak ve CNN tarafından öğrenilen bilginin özü yöntemine tamamen saygı duyuyor ve benimsiyor.

SVD'yi PCA ile değiştirmek daha mı iyi?

SVD korelasyonuyla ilgili olarak, makale ön inceleme sonuçlarını aldıktan sonra bir eleştirmen tarafından ortaya atılan ilginç bir tartışma daha var ve bu soru da birçok okuyucu tarafından gündeme getirildi: yani, PCA W üzerinde yapılırsa, Ortogonal bir matris elde edilebilir ve diğer veri işleme yerlerinde genellikle deneyim şudur: PCA her zaman SVD'den daha iyidir. Öyleyse, W üzerinde PCA yapmak mümkün mü? PCA için W kullanmak daha mı iyi? Bunun harika bir soru olduğunu düşünüyorum.

Her şeyden önce, QR ayrıştırması ve metinde karşılaştırılan diğer yöntemler gibi, ağırlık vektörünü ilişkilendirmek için PCA kullanmak tamamen mümkündür. Ayrıca, PCA ilintisizliği, SVDNet'in performansını sürekli olarak iyileştirmek için RRI'ye gömülebilir. Yazar, çürütücü bir deney yaptı ve SVD'yi PCA ile değiştirdi ve performans, SVDNet yönteminden sadece biraz daha düşüktü. Bununla birlikte, PCA ve SVD'nin matematiksel anlamlarının çok farklı olmasına rağmen, belirli işlemlerde çok benzer olduklarını not etmelisiniz: PCA'nın bir tane daha 0-ortalama işlemi vardır. Aslında, ağırlık vektörünün kendisi sıfır ortalamaya çok yakındır Bu nedenle, iki yöntem son etkide nispeten yakındır, ki bu aslında çok doğaldır.

Bununla birlikte, yazar SVDNet'in ilintisizleştirme işleminde sadece SVD kullanımının katı ve matematiksel olarak anlamlı olduğunu, ancak PCA'nın böyle olmadığını belirtmek ister. İlk olarak, makaledeki formüle bakın: W'yi US ile değiştirmek, ağırlık matrisini değiştirdikten sonra herhangi iki örnek arasındaki mesafenin değişmemesini sağlamaktır, böylece CNN'nin orijinal ayırt etme kabiliyeti çok katıdır. Daha da önemlisi, PCA ve SVD, ilintisizleştirme sırasında tamamen farklı matematiksel anlamlara sahiptir. Aşağıdaki şemaya bakın:

CNN'nin 2X2 ağırlık matrisi öğrendiğini varsayalım, yani 2 ağırlık vektörü W1 ve W2 var. Şimdi, W matrisini işlemek için SVD ve PCA kullanıyoruz.SVD, solda gösterilen iki yeşil ortogonal vektör S1 ve S2'yi alacak.S1 yönündeki izdüşüm sonucu, nispeten büyük bir ağırlık katsayısı ile çarpılacaktır; PCA, sağda gösterilen iki kırmızı ortogonal vektörü alacaktır (aslında, P1'in vektör uzunluğu 0 olacaktır, yani, P1 yönündeki projeksiyon sonucu önemsizdir). Bu şemada, PCA'nın mantıksız olduğu açıktır: CNN, siyah W1 ve W2'yi önemli yansıtma yönleri olarak kabul ederse, sezgisel olarak da S1 (veya P1) yönündeki projeksiyon sonucunun çok olacağını hissedebiliriz. önemli. Ayrıca, PCA, P1 ve P2 aldığında, gerçekte W1 ve W2'yi iki vektör olarak ele almaz. PCA aslında W1 ve W2'yi iki noktanın koordinatları olarak görür ve iki noktanın en çok yayıldığı yönü bulur (P2 > P1), bu matematiksel anlam eksikliğidir.

Yedi, başka bir sezgisel yorumlama

Bu makale CNN ağırlıklı vektörün uzamsal izdüşüm yorumuna ek olarak, makaledeki alan kısıtlamaları nedeniyle gösterilemeyen bir yorumu da ima etmektedir, yani ağırlık vektörü aslında öznitelikleri oluşturmak için kullanılan bir şablondur. Örnek olarak kafeni alın.FC7'nin çıktısını özellik olarak kullandığımızda, aslında benzerlik için FC6'nın özelliklerini FC7'nin 4096 şablonuyla karşılaştırıyoruz (vektör iç çarpım işlemi) ve son olarak 4096 benzer değerleri kullanıyoruz. özelliği. Bu anlamda, SVDNet'in özellikleri elde etmek için şablonu zenginleştirdiği düşünülebilir. Yosinski tarafından 2015 yılında ICML Visualizing and Understanding Convolutional Networks'de sağlanan derin özellik görselleştirme aracını kullanarak, belirtilen nöronun girişini maksimum aktivasyonla görselleştirebilir ve bu potansiyel şablonların gerçek yüzünü sezgisel olarak nasıl hissedebiliriz.

Yukarıdaki şekilde, ilk satır, 5 yüksek düzeyde ilişkili ağırlık vektörü tarafından temsil edilen nöronlara karşılık gelen şablon görüntülerini gösterir ve ikinci satır, normal eğitim yönteminde seçilen 5 ilişkisiz ağırlık vektörünü gösterir. Temsili nörona karşılık gelen şablon görüntü Üçüncü çizgi, SVDNet eğitim yönteminden sonra herhangi 5 ağırlık vektörüne karşılık gelen şablon görüntüdür. Sezgisel bir his şudur: temel yöntemde, çok sayıda oldukça benzer şablon görüntüsü ima edilir, ancak SVDNet'ten sonra tüm şablonlar farklılaşır, bu nedenle özellikler daha bol olur.

8. Diğer görsel görevlerde tanıtım

Bu noktada, herkes SVDNet'in analizi ve optimizasyonu yayaların doğal özelliklerine göre özel olarak uyarlamadığı konusunda hemfikir olmalıdır. Yukarıdaki şekilden, SVDNet tarafından eğitilen nöronların daha fazla olduğunu sezgisel olarak hissedebiliriz, bu da aşırı uyumu azaltma etkisini elde etti. Bu mekanizmanın diğer görsel görevler üzerinde de bir etkisi olabilir. Hala araştırıyoruz. Mevcut deneysel sonuçlara göre, SVDNet'in sınıflandırma görevleri üzerinde belirli bir iyileştirme etkisi vardır. Referans olarak resnet-20 kullanan Cifar-10 sınıflandırma görevinde, rank-1 doğruluğu% 91.8'den% 93.5'e yükseldi.

-

- Yüksek kaliteli + uzun bacaklar? Süper model Liu Wen seksi yatak fotoğraflarını ortaya çıkardı ve Yang Mi, psychedelic gişe rekorları kıran bir filmde izledi

-

- "Şüpheli drag yarışı" ile suçlanan Şangay yükseltilmiş aracında üç araba çarpıştı.Polis: zayiat yok, sebep soruşturma altında