Grafiksel sinir ağı makine çeviri prensibi: LSTM, seq2seq'den Zero-Shot'a

200.000, bu, Xinzhiyuan'ın bugün ulaştığı toplam kullanıcı sayısı. Akıllı evrene yolculuk sırasında, Xinzhiyuan ile seyahat eden her arkadaşınıza teşekkür edin. Dikkatiniz ve desteğiniz "Xinzhiyuan" yıldız gemisinin tükenmez yakıtıdır.

Bu makale, makine öğrenimi çeviri motorunun çalışma prensibini açıklamaya ve Google çeviri algoritmasının işleyişini açıklamaya çalışmaktadır.

Günümüzde, makine çeviri sistemleri farklı bir yöntem kullanıyor: metne kurallar atamak için büyük miktarda metni analiz ediyorlar

Google Translate motoru daha kısa bir cümleyi çevirmeye çalışırsa, çok fazla değişken nedeniyle bunu yapamayacaktır. İdeal durum, bilgisayara gramer kurallarını öğretmek ve sonra cümleleri kurallara göre çevirmesine izin vermektir. Maalesef o kadar basit değil.

Yabancı dil öğrenmekten muzdaripseniz, kuralların her zaman birçok istisnası olduğunu bilmelisiniz. Tüm bu kuralları ve bunların özel durumlarını ve program için özel durumlarını açıklamaya çalıştığımızda, çevirinin kalitesi garanti edilemez.

Günümüzde, makine çeviri sistemleri farklı bir yöntem kullanıyor: Metne kurallar atamak için büyük miktarda metni analiz ediyorlar.

Makine çevirisinin "kara kutusunda" ne olduğuna bir göz atalım. Derin sinir ağları, çok karmaşık görevlerde (konuşma / görsel nesne tanıma) mükemmel sonuçlar elde edebilir, ancak esnekliklerine rağmen, yalnızca girdinin ve hedefin sabit bir boyuta sahip olduğu görevler için kullanılabilirler.

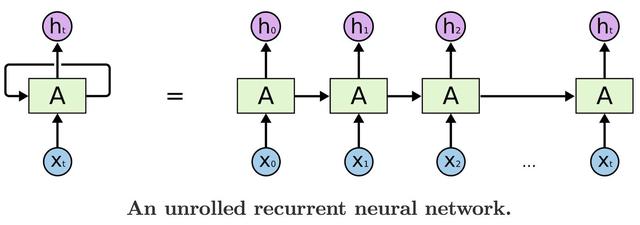

Tekrarlayan sinir ağı

Bu, LSTM'lerin (Uzun Kısa Süreli Bellek ağları) devreye girdiği yerdir. LSTM'ler, önceden bilemeyeceğimiz diziler konusunda bize yardımcı olabilir.

LSTM'ler, uzun vadeli bağımlılığı öğrenebilen özel bir tekrarlayan sinir ağıdır (RNN). Tüm RNN'ler bir dizi tekrarlanan modül gibi görünür.

Bu nedenle, LSTM verileri modülden modüle aktarır, örneğin, Ht üretmek için, sadece Xt'yi değil, aynı zamanda X değerine sahip önceki tüm girişleri de kullanıyoruz. LSTM'nin yapısı ve matematiksel modeli hakkında daha fazla bilgi edinmek için "LSTM Ağını Anlamak" bölümünü okuyabilirsiniz.

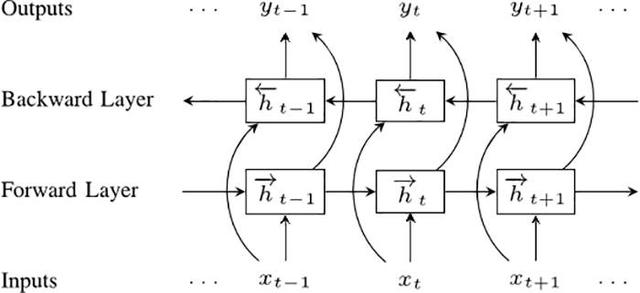

Çift yönlü RNN

Bir sonraki adım, çift yönlü tekrarlayan sinir ağlarıdır (BRNN'ler). BRNN'nin yaptığı şey, normal bir RNN'nin nöronlarını iki yöne bölmektir. Bir yön pozitif zaman veya ileri durumlar. Diğer yön, negatif zaman veya geri durumlardır. Bu iki durumun çıkışı, ters yön durumunun girişine bağlı değildir.

BRNN'nin neden basit RNN'den daha iyi olabileceğini anlamak için 9 kelimelik bir cümleniz olduğunu ve 5. kelimeyi tahmin etmek istediğimizi hayal edebilirsiniz. Sadece ilk 4 kelimeyi bilsin ve ilk 4 kelimeyi ve son 4 kelimeyi bilsin - tabii ki ikinci durumda kalite daha iyi olacak.

sekans modeline sekans

Daha sonra, sekans modelinden bahsedebiliriz (ayrıca seq2seq olarak da adlandırılır). Temel seq2seq modeli iki RNN'den oluşur: girişi işleyen bir kodlayıcı ağı ve çıkışı oluşturan bir kod çözücü ağı.

Yakında, bu makine tercümanı doğacak!

Ancak yine de bir sorun var. Google Translate şu anda 103 dili desteklemektedir. Her dil için 103x102 farklı model sağlayacak mıyız? Elbette, bu modellerin kalitesi, dilin popülerliğine ve ağı eğitmek için gereken dosya sayısına bağlı olarak değişecektir. Daha mantıklı bir yol, bir sinir ağının herhangi bir dili girdi olarak almasına ve onu herhangi bir dile dönüştürmesine izin vermektir.

Zero-Shot Çeviri

Bu fikir 2016 sonunda Google mühendisleri tarafından hayata geçirildi. Bu sinir ağının mimarisi az önce bahsettiğimiz seq2seq modeline dayanmaktadır.

Tek fark, kodlayıcı ile kod çözücü arasında katmanlar arasında artık bağlantılara sahip olan ve doğruluğu ve hızı belirli bir dereceye kadar ayarlayabilen 8 LSTM-RNN katmanının olmasıdır.

Bu yöntemin temel önemi, Google algoritmasının artık büyük bir koleksiyon yerine her dil çifti için yalnızca bir sistem kullanmasıdır.

Sistem, giriş cümlesinin başında, cümleyi çevirmeye çalıştığınız dili belirten bir "simge" gerektirir.

Bu, çevirinin kalitesini artırır ve hatta sistemin daha önce görmediği iki dil arasında çeviri yapabilir Bu yönteme Sıfır Atış Çevirisi denir.

BLEU

Google'ın çeviri algoritmasındaki iyileştirmelerden ve daha iyi sonuçlardan bahsettiğimizde, bir çevirinin diğerinden daha iyi olduğunu doğru bir şekilde nasıl değerlendirebiliriz?

Yaygın olarak kullanılan bazı cümleler için, referans için profesyonel çevirmenlerimiz var.

Bu sorunu kısmen çözmenin birçok yolu vardır, ancak en popüler ve etkili gösterge BLEU'dur (iki dilli değerlendirme yetersizliği). Makine çevirisi için iki alternatifimiz olduğunu hayal edin:

Alternatif 1: Statsbot, şirketlerin çeşitli analitik platformlardan gelen verileri doğal dil aracılığıyla yakından izlemesini kolaylaştırır.

Alternatif 2: Statsbot, işletmelerin metriklerini farklı analitik platformlardan doğru şekilde analiz etmek için doğal dili kullanır.

Aynı anlama sahip olsalar da kalite ve yapı bakımından farklılık gösterirler.

İki insan çevirisinin sonuçlarına bir göz atalım:

Referans 1: Statsbot, şirketlerin verilerini farklı analitik platformlardan doğal dil aracılığıyla yakından izlemelerine yardımcı olur.

Referans 2: Statsbot, şirketlerin doğal dil kullanarak çeşitli analiz platformlarından gelen verileri dikkatlice izlemelerine olanak tanır.

Açıkçası, Alternatif 1 daha iyidir, Alternatif 2 ile karşılaştırıldığında daha fazla kelime ve kelime öbeği paylaşır. Bu, BLEU yönteminin temel fikridir. Alternatif n-gram'ı referans çevirisinin n-gramıyla karşılaştırabilir ve eşleşmelerin sayısını hesaplayabiliriz (konumuna bakılmaksızın). Yalnızca n-gram doğruluğunu kullanıyoruz çünkü birden fazla referans olduğunda geri çağırma oranını hesaplamak zor ve sonuç n-gram puanlarının geometrik ortalaması olacaktır.

Artık makine öğrenimi çeviri motorlarının karmaşıklığını biliyorsunuz. Google Translate'i bir sonraki kullanışınızda, size en iyi sonuçları vermeden önce milyonlarca belgeyi analiz ettiğini hayal etmeyi unutmayın.

Derleme Kaynak: https: //blog.statsbot.co/machine-learning-translation-96f0ed8f19e4 nsukey = VImjuDSmJU5s7XG% 2BcVgu5QIzrc0KecpUzpUdvUXxifDycOG5DXilsiMxZ4Tvs9ja9XQJ6EKe0fBnYzJwuvbqQw3MaRxVOHkwmW9xkA75dDpNwJM4VEBiPYXLER34D0txiOrVl2pS3flSlaIh9pq72G9ZPolOBX6io% 2BdJtOk% 2Fki51k1r5W82uKRxKNYWGHtjs?

İş ayrıntılarını görüntülemek için orijinal metni okumak için tıklayın ve katılmanızı dört gözle bekleyin ~

-

- Luneng'in ilk koşucusu neden Magath tarafından bu kadar seviliyor? Askıya alma, Xiao Jin'in koşmasını durduramaz