Videoyu anlamak ve yeniden üretmek zor mu? FAIR şampiyon algoritmasının açık kaynak kodu PySlowFast'ın ayrıntılı açıklaması

Yazar | Kyomi

Editör | Camel

Son yıllarda video anlama araştırmalarında, Facebook AI Research birçok harika çalışmaya katkıda bulundu. Video ekibi sadece CVPR, ICCV vb. toplantı Birkaç video araştırma çalışması yayınladı ve ayrıca büyük veri kümelerinde birinci oldu ve 2019 CVPR Davranış Tespiti Yarışmasını kazandı. Şimdi ekibi, ICCV seminerinde video tanıma algılama kodu kitaplığını açık kaynaklı hale getirdi: PySlowFast ve aynı zamanda önceden eğitilmiş bir model kitaplığı yayınladı. Ekip, video anlama alanındaki araştırmaları desteklemeyi hedeflerken, aynı zamanda en yeni çalışmalarını kod tabanına gerçek zamanlı olarak eklediklerini söyledi.

https://alexander-kirillov.github.io/tutorials/visual-recognition-iccv19

Video ve eylem anlayışı günümüzün en sıcak araştırma yönlerinden biri haline geldi.Ancak, açık kaynak topluluğunda kısa, verimli ve kırılması kolay bir video anlama kod tabanı bulmak kolay değil. şey.

Daha da önemlisi, bugünün en son teknolojisini (devlet- nın-nin - -art) 'ın derin öğrenme modeli (videonun omurgasını anlama) her zaman araştırmacılar için bir baş ağrısı olmuştur. Video anlama modeli genellikle düzinelerce GFlop alır ve birkaç günlük eğitim gerektirir. Bir modeli yeniden üretmek için tekrarlanan deneyler gerekir. Her detay doğrudur. Bu genellikle çok fazla zaman ve kaynak tüketir ve bu da birçok araştırmacının cesaretini kırar.

2019'da Facebook AI Research (FAIR), CVPR üzerine bir dizi araştırma çalışması yayınladı ve CVPR 2019 Davranış Tespit Yarışması'nı kazandı.

FAIR, ICCV 2019'da bir video anlama kod kitaplığı başlattı: PySlowFast.

PySlowfast, PyTorch'a dayalı bir kod kitaplığıdır ve araştırmacıların video sınıflandırmasını ve eylem algılama algoritmalarını basitten son teknolojiye kolayca yeniden üretmesine olanak tanır.

Sadece bu değil, PySlowFast kod tabanı, araştırmacıların modelleri tekrar tekrar eğitme sıkıntısından kurtarmasına ve FAIR'in en son performans modellerini doğrudan kullanmasına olanak tanıyan çok sayıda ön eğitim modelini de açık kaynak haline getiriyor.

Açık kaynaktan beri, PySlowFast bir kez daha GitHub trend listesinde ilk ona girdi.

Semineri tarafından sağlanan öğreticilere ve açık kaynak kod tabanına ilişkin bilgilere göre, PySlowFast yalnızca temel bir video anlayış modeli sağlamakla kalmaz, aynı zamanda günümüzün en son video anlama algoritmalarının yeniden üretimini de sağlar.

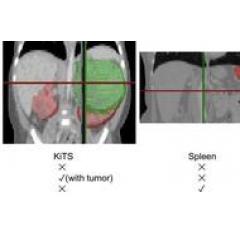

Algoritması yalnızca video sınıflandırmasını (video sınıflandırması) değil, aynı zamanda eylem algılama (Eylem Sınıflandırması) algoritmasını da içerir. Açık kaynak topluluğundaki çeşitli video tanıma kitaplıklarının eşit olmayan performansıyla karşılaştırıldığında, PySlowFast kullanarak günümüzün en yeni modellerini kolayca yeniden üretebilirsiniz.

Video tanıma (Kinetik)

Davranış Algılama (AVA)

(Tablo 1: PySlowFast'ın video sınıflandırma veritabanı Kinetics 400 üzerindeki performansı) (Alıntı: https: // github .com /facebookresearch/SlowFast/blob/master/MODEL_ZOO.md)

PySlowFast yalnızca video sınıflandırması için değil, aynı zamanda videoyu anlamak için de kullanılabilir ve 2019 CVPR ActivityNet Challenge Winner'ı kazanan bir video algılama modeli sağlar.

PySlowFast ayrıca, çok modlu video anlama ve basit düzenleme yoluyla videonun kendi kendini denetleyen öğrenimi gibi görevleri desteklemek için bir arabirim de ayırır. FAIR araştırma ekibine göre, PySlowFast, ekibini ve sektörün en son algoritmalarını gerçek zamanlı olarak güncellemek için aktif bir şekilde korunacak. Aynı zamanda, eğitim öncesi modeli açık kaynaklı olacak ve kod tabanını video anlama alanında temel bir kriter haline getirecek.

Yazar, eğitime referansla PySlowFast kod tabanını kısaca denedi. Kurulumu tamamladıktan sonra geçiş indir MODEL_ZOO tarafından sağlanan ön eğitim modeli ve ilgili yapılandırma dosyaları, aşağıdaki kodu çalıştırın, (Test) modelinin performansını farklı video veritabanlarında test edebilirsiniz:

python araçları / run_net.py \ --cfg configs / Kinetics / C2D_8x8_R50.yaml \ DATA.PATH_TO_DATA_DIR veri kümenize_ giden_ yol \ NUM_GPUS 2 \Yazar, kod tabanı aracılığıyla en yeni yüksek performanslı modelleri kolayca yeniden üretebilir.Aynı zamanda, basit modifikasyonlarla kendi modelimi uygulamaya çalışıyorum ve en son performansı elde etmek için eğitim için birden fazla GPU kullanıyorum.

Yazar daha karmaşık görevleri denemedi, ilgilenen okuyucular doğrudan Github sayfasına giderek şunları öğrenebilir:

https: // github .com / facebookresearch / SlowFast

-

- Tushen genellikle diferansiyel denklemler, GNN'nin becerilerini sürekli derinlik alanında göstermesi nasıl sağlanır?