AAAI 2020 | Shanghai Jiaotong Üniversitesi: Görüntü sorgusuna dayalı video alma, kod açık kaynak kodludur

Yazar | Xu Ruicong

Editör | Camel

Bu makale, Şangay Jiaotong Üniversitesi BCMI Laboratuvarı'nın AAAI 2020'deki çalışmasını tanıtmaktadır. Etkinlik Görüntüden Videoya Erişim için Teklif Temelli Bir Yaklaşım.

Makaleye bağlantı: https://arxiv.org/pdf/1911.10531.pdf

Kod bağlantısı: https: // github .com / bcmi / Çapraz modal alma

İnternet çağında teknolojinin hızlı gelişimi, resimler, metinler ve videolar gibi multimedya patlamasını teşvik etti. Günümüz toplumu, tek modlu erişim gereksinimlerini giderek daha fazla karşılayamamaktadır ve çok sayıda çapraz modal geri alma uygulaması sürekli olarak geliştirilmektedir. Bunlar arasında, görüntü sorgusuna dayalı video alımı, örneğin slaytları kullanarak araştırma önemi ve değeri olan bir tür uygulamadır. aramak İlgili video dersleri, resimlerle ilgili video filmler önerin, haber videolarını almak için fotoğrafları kullanın vb. Bununla birlikte, resimler ve videolar arasındaki farklı veri dağılımı ve tutarsız anlamsal bilgiler nedeniyle, bu kaçınılmaz olarak geleneksel tek modlu geri alma yönteminin modlar arası erişim görevleri için uygun olmamasına yol açacaktır. Verilerin dahili bağlantılarını nasıl madencilik yapılacağı, çok modlu bilgi özelliklerinin birleşik bir eşlemesinin nasıl kurulacağı ve erişim hızının nasıl sağlanacağı, modlar arası erişim için büyük zorluklardır.

Çapraz modal erişim görevlerinde, resimlerin öznitelik çıkarımı olgunlaşmıştır ve derin modellere dayalı yöntemlerin çok sayıda sınıflandırma görevinde iyi sonuçlar verdiği doğrulanmıştır. Görüntü özelliği çıkarımından farklı olarak, videonun karmaşık içeriği ve yapısal özellikleri nedeniyle video özelliği çıkarımının araştırma çalışması sürekli olarak araştırılmaktadır. Geleneksel erişim yöntemi, videodaki her karenin bilgisini çıkarabilir ve ifade edebilir ve resimden videoya geri alma işi, resimden video karesine geri alma işi olarak kabul edilebilir. Bununla birlikte, videoyu ifade etmenin geleneksel yolu, kaçınılmaz olarak, video ifadesindeki ana bilgi içeriğiyle ilgili olmayan fazlalık arka plan parçalarına yol açacaktır ve bu, sonraki erişim çalışması için belirli zorluklara neden olacaktır.

Yukarıdaki problemleri çözmek için, zamanlama bilgisine dayalı derin ağlar kapsamlı bir şekilde incelenmiştir. Hem zamansal hem de uzamsal boyutlardan özellikleri aynı anda öğrenerek, tekrarlayan sinir ağları (RNN) ve 3D evrişimli ağlar (3D CNN) video alanında yaygın olarak kullanılmaktadır. 3D CNN modelinin bir uzantısı olarak, R-C3D modeli, sürekli video davranışı algılama görevlerine uygulanır. R-C3D modeli, önce bir C3D modeli aracılığıyla özellikleri çıkarır, ardından aday aktif sekans segmentlerini çıkarmak için bölgesel aday ağı (RPN) kullanır ve son olarak sınıflandırma alt ağındaki aktif sekans segment sınırlarının sınıflandırmasını ve regresyonunu gerçekleştirir.

Bu görevin ihtiyaçlarına yanıt olarak, modlar arası erişim görevleri için üstün bir video aktif bölge bölümü temsil yöntemi elde etmek için aday aktif bölge segment özelliklerini oluşturmak ve gürültülü arka plan bilgi segmentlerini daha da filtrelemek için yenilikçi bir şekilde R-C3D modelini kullanıyoruz. .

APIVR: Karşıt öğrenmeye dayalı çapraz modal erişim yöntemi

Bu makale esas olarak görüntü sorgulamasına dayalı video alma görevini amaçlamaktadır ve karşıt öğrenme yöntemi olan APIVR yöntemine dayalı bir çapraz modal geri alma yöntemi önermektedir.

Öncelikle, video verilerinin temsil yöntemi için, zamanlama tabanlı teklif tabanlı özellikleri çıkarmak için yeni bir davranış sınıflandırma modeli olan R-C3D'yi kullanıyoruz ve videoyu etkinlik bilgi paketleri biçiminde ifade ediyoruz.

Ardından, görüntüden videoya paket alma görevi için, grafik tabanlı çoklu örnek öğrenme modülünü (Graph Multi-Instance Learning), geri alma sürecinde video bilgi paketinin varlığını çözmek için modlar arası geri alma çerçevesine yenilikçi bir şekilde entegre ettik. Bilgi fazlalığı sorunu.

Bu makalede önerilen çapraz modal geri alma çerçevesi, resimlerin ve video paketlerinin önce üç katmanlı tamamen bağlı bir ağ aracılığıyla birleşik bir özellik alanına eşleştirildiği ve daha sonra geometrik projeksiyona dayalı üç öğenin (Geometri farkında) olduğu rakip öğrenme yaklaşımına dayanmaktadır. Grup kaybı işlevi, anlamsal sınıflandırma kaybı işlevi ve rakip kayıp işlevi, özelliklerin öğrenilmesini birlikte ayarlar ve haritalama alanındaki resimler ve videolar arasındaki modal farkı optimize eder. Modelin genel çerçevesi şekilde gösterilmiştir. APIVR yönteminin modülleri aşağıda ayrıntılı olarak tanıtılacaktır.

(1) Eşleme alanı

Giriş resmini q ve giriş video paketini olarak gösteriyoruz. Çapraz modal erişim görevlerinde videoların ve görüntülerin farklı istatistiksel özelliklere ve veri dağılımlarına sahip olduğu düşünüldüğünde. Video ve görüntü özelliklerini ortak bir özellik alanına yansıtmak için sırasıyla iki haritalama işlevi kullanıyoruz. Eşleme işlevi şu şekilde tanımlanır:

Tam bağlantılı katmanın haritalamanın ifade kabiliyetini sağlamak için zengin parametrelere sahip olduğu göz önüne alındığında, bu makale uzamsal haritalamayı gerçekleştirmek için üç katmanlı tam bağlı katmanı benimser. Haritalama alanında öğrenilen video ve görüntü özelliklerine göre APIVR yöntemi, videonun göze çarpan bilgilerini öğrenmek için önce grafik tabanlı çok örnekli bir model kullanır ve ardından haritalama alanındaki görüntü ve video özelliklerini ayarlamak için üç tür kayıp işlevi kullanır.

(2) Grafik tabanlı çoklu örnek modülü (GMIL)

Bu çerçevede, videonun mümkün olduğu kadar tüm olası aktivite bilgilerini içermesini sağlamak için R-C3D modelini kullanmamıza rağmen, video paketinin ifadesi, kaçınılmaz olarak, aktivite bilgileriyle hiçbir ilgisi olmayan fazlalık bilgiler içerir. Bu gürültülü aktivite bilgilerini genel video etiketlerine göre kullanırsak, anlamsal öğrenmenin kalitesi büyük ölçüde azalacaktır.

Aslında bu sorunu çok örnekli bir öğrenme problemine dönüştürdük, yani her video örnek bir paket olarak görülüyor ve her video paketindeki aktivite bilgileri örnek olarak kabul ediliyor. Çoklu örnek problemi, göze çarpan örnekler seçerek genel bilgileri daha iyi ifade edebilen kendi kendine dikkat mekanizmasına dayanmaktadır. Aynı zamanda, evrişimli yapının grafiğini çizeceğiz Birleştirmek Çoklu-örnek çerçevede, her paketteki grafik yapısı bilgileri daha da optimize edilebilir.

Son olarak, genel videonun özellik ifadesi olarak video paketindeki etkinlik bilgilerinin ağırlıklı değerini elde ederiz. Video paketindeki farklı aktivite bilgilerine farklı ağırlık değerleri atayarak, net örnekleri daha iyi hedefleyebilir ve ayırt edilebilir video özelliği ifadeleri elde edebiliriz.

(3) Geometrik projeksiyona dayalı üçlü kayıp işlevi (Geometri duyarlı)

Bu yöntem, farklı modalitelerdeki benzer eğitim örneklerinin anlamsal alaka düzeyine sahip olmasını sağlamak için eşleme alanındaki özellik vektörlerini eğitmek için üçlü bir kayıp işlevi kullanır. Bir grup eğitim örneği video-görüntü çifti için, her resmin bir örnek olmasına izin verin, ilgili video olumlu bir örnektir ve diğer video türleri olumsuz örneklerdir, ardından üçlü kayıp işlevini şu şekilde elde ederiz:

Bunlar arasında m, pozitif ve negatif örnekler arasındaki mesafeyi sınırlamak için kullanılır ve d (x, y), x ve y arasındaki mesafeyi temsil eder. Görevimizde, görüntü ile video arasındaki veri yapısındaki farklılık, geleneksel benzerlik ölçüm yöntemini doğrudan kullanılamaz hale getirmektedir.Bu nedenle, bu yöntem, görüntü noktası ile video alt uzayındaki ortogonal projeksiyonu arasındaki Öklid farkını kullanır. Mesafe, görüntü ile video arasındaki benzerliği açıklayarak videonun yapısal bilgisinin kaybolmamasını sağlar.

Videodaki fazlalık bilgiler, görüntünün video alt uzayını gösteren projeksiyon doğruluğunu engelleyeceğinden, tam video ifadesinin yerine seçilen video etkinliği bilgilerini kullanmayı öneriyoruz.

(4) Anlamsal sınıflandırma kaybı işlevi

Her modeldeki eğitim örneklerinin anlamsal ayrımını sağlamak için, modaldeki eğitim örneklerini farklı kategorilerden ayırmak için bir anlamsal sınıflandırıcı da kullanıyoruz. Mod farklılıklarını en aza indirmek için aynı sınıflandırıcıyı resimlere ve videolara uyguladık. Bununla birlikte, sınıflandırıcı bir videoya uygulandığında, videodaki aktivite bilgilerinde gürültü sorunu vardır.

Bu nedenle sınıflandırıcı tanımımız, önerdiğimiz grafik tabanlı çoklu örnek modülüne dayanacaktır.Video ifadesi çoklu örnek modülü tarafından öğrenildikten sonra, daha temiz bir bilgi ifadesi oluşturulabilir. Bir dizi video-görüntü çifti verildiğinde, anlamsal sınıflandırma kaybı işlevi şu şekilde yazılır:

(5) Yüzleşme kaybı işlevi

Yukarıda sunulan üçlü kayıp fonksiyonunun ve anlamsal kayıp fonksiyonunun amacı, anlamsal ayırt edilebilirliğin özellik ifadesini öğrenmektir.Özellik ifadesinin modal tutarlılığını daha da sağlamak için, modaliteleri ayırt etmek için bir modal sınıflandırıcı tasarlıyoruz. Haritalama alanında modaliteleri belirleme sürecini ve özellik öğrenme sürecini antagonize ederek, görüntü ve video ifadesi arasındaki fark daha da azaltılır.

Bu yöntemde modal sınıflandırıcı, iki görüntü ve video modunu birbirinden ayırmak için iki sınıflandırıcı tarafından uygulanır. Uzamsal özellik öğrenme haritalama sürecinde, haritalama alanında öğrenilen görüntü ve video özelliklerinin mod farklılıklarını ortadan kaldırabileceğini ve yalnızca anlamsal tutarlılığı koruyabileceğini, böylece modal sınıflandırıcının modal sınıflandırma sırasında karıştırılacağını umuyoruz. , Çatışmacı bir şekilde öğrenmek.

Aynı zamanda, video ifadesinde, temiz aktivite bilgisinin daha anlamlı bir özellik dağılımına sahip olduğu ve gürültü arka planının özellik alanı boyunca dağılacağı göz önüne alındığında. Bu nedenle, modal sınıflandırıcıyı videonun ağırlıklı gösterimine uygularız. Anlamsal sınıflandırma kaybı işlevine benzer şekilde, aldığımız son yüzleşme kaybı işlevi şudur:

Bunlar arasında video için tahmin olasılık modeli de var. Karşıt öğrenme, modaliteleri belirleme süreci ile özellik öğrenme süreci arasındaki etkileşim olduğundan, modaliteleri belirleme sürecinde, modal sınıflandırıcının parametrelerini ayarlayarak karşıt kayıp fonksiyonunu en aza indiriyoruz.

Tam tersine, haritalama alanında özellik öğrenme sürecinde, tamamen bağlı katmanın parametrelerini ve grafik tabanlı çok eşgörünümlü modülün parametrelerini ayarlayarak yüzleşme kaybı fonksiyonunu maksimize ediyoruz. Dönüşümlü olarak farklı modaliteleri ayırt ediyor ve mini-max eğitim yöntemiyle haritalama alanındaki özellik ifadelerini öğreniyoruz. Eğitim hedefleri aşağıdaki gibidir:

Deneysel sonuçlar

Herkese açık üç veri seti üzerinde karşılaştırmalı deneyler yaptık.Bazı genel yöntemlerle karşılaştırıldığında, deneysel sonuçlar modelimizin önemli avantajlara ve çok yönlülüğe sahip olduğunu göstermektedir. Aynı zamanda, her modülün kantitatif analizini yaptık ve deneysel sonuçlar aşağıdaki gibidir:

Bunların arasında, özellikle, APIVR yönteminde üçlü kayıp, yüzleşme kaybı ve anlamsal sınıflandırma kaybının ortadan kaldırılmasını temsil etmek için APIVR (TL hariç), APIVR (AL hariç) ve APIVR'yi (CL olmadan) belirledik. Üç durumda, üç tür kayıp işlevinin etkilerini ve katkılarını daha fazla inceleyin. Üçlü kayıp fonksiyonundaki geometrik izdüşüm benzerliğine dayalı yöntemin etkisini doğrulamak için, nokta ve düzlem projeksiyonları arasındaki mesafeyi değiştirmek için vektörler arasındaki Öklid mesafesini kullanıyoruz ve bu duruma APIVR (GA'sız) adını veriyoruz.

Ek olarak, önerilen grafik tabanlı çoklu örnek modülümüzün (GMIL) etkinliğini doğrulamak için GMIL modülünü bir MIL modülü ile değiştirdik ve bu durumu temsil etmek için APIVR (Grafiksiz) kullandık. Aynı zamanda, videodaki her bir etkinlik bilgisi özelliğine GMIL modülü tarafından öğrenilen ağırlık değerinin yerini alan ve APIVR (GMIL'siz) olarak adlandırılan tek tip bir ağırlık değeri de atıyoruz.

Deneysel sonuçlardan, anlamsal sınıflandırma kaybının performans üzerinde ters kayıp ve üçlü kayıptan daha büyük bir etkiye sahip olduğu görülebilmektedir, bu da anlamsal sınıflandırıcıların model çerçevemizdeki önemini kanıtlamaktadır. Geometrik projeksiyona dayalı üçlü kayıp yerine geleneksel üçlü kayıp kullanıldığında, APIVR'nin (GA'sız) performansı azalacaktır, bu da video etkinliği bilgilerinin yapısal bilgilerinin ve geometrik özelliklerinin benzerlik öğrenimi için korunduğunu gösterir. Yardımcı olur.

Ek olarak, APIVR (GMIL'siz) sonuçlarının tam APIVR yönteminden daha kötü olduğunu fark edebiliriz, bu da önerilen GMIL modülümüzün daha etkili olabileceğini kanıtlar. Dikkat Aktivite bilgilerini temizleyin ve geri alma işlemi için iyi. Son olarak, APIVR'nin (Grafiksiz) performansının, grafik evrişim katmanını MIL modülüne yerleştirmenin avantajını gösteren tam APIVR yöntemi kadar iyi olmadığını gözlemleyebiliriz.

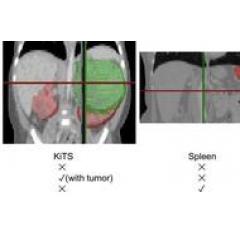

GMIL modülümüzün yararlı video etkinliği bilgilerini seçmedeki etkinliğini daha fazla doğrulamak için, aşağıdaki gibi bir görsel erişim efekti çizelgesi sunuyoruz:

Bunlar arasında yukarıdaki resim sorgu resminin "sörf" kategorisine ait olduğunu, aşağıdaki resim de sorgu resminin "topa vurma" kategorisine ait olduğunu göstermektedir. Her sorgu görüntüsü için alınan ilk 2 videoyu listeleriz. Alınan her video için, GMIL modülü tarafından öğrenilen en yüksek ağırlığa sahip bir resim sekansı ve en düşük ağırlıklı diğer iki resim sekansı göstereceğiz.

Açıkçası, en yüksek ağırlığa sahip resmin sorgu resmindeki ilgili aktivite içeriğini daha iyi yakalayabildiğini, diğer iki resim dizisinin çok fazla arka plan içeriği olsa bile daha düşük bir korelasyona sahip olduğunu görebiliriz. Bu, önerilen GMIL modülümüzün temiz video bilgilerini belirlemede büyük bir avantaja sahip olduğunu göstermektedir.

sonuç olarak

Bu yazıda, video aktivite alanı segmentinin ifadesine dayalı çapraz modal geri alma yöntemi öneriyoruz.Özellikle, video aktivite alanı segmentine dayalı görüntü özellikleri ve video özellikleri, geometrik projeksiyona dayalı üçlü bir kayıp fonksiyonuna yansıtılıyor, Anlamsal sınıflandırma kaybı işlevi ve karşıt kayıp işlevi, özellik alanında birlikte ayarlanır.

Video paketi bilgilerinin gürültü problemini çözmek için grafik tabanlı çok örnekli öğrenme modülünü yenilikçi bir şekilde çapraz modal geri alma çerçevesine entegre ediyoruz ve geometrik projeksiyona dayalı benzerlik ölçüm yöntemini kullanıyoruz. Deney, davranış ve olaylara dayalı olarak üç veri seti üzerinde gerçekleştirildi ve deneysel sonuçlar da yöntemimizin diğer yöntemlere göre üstün olduğunu kanıtladı.

AAAI 2020 hakkında daha fazla bilgi, Değişim grubu "" ve gruba katılmanın yolu: AI Yanxishe 2 asistanını (AIyanxishe2) ekleyin, "AAAI" not edin ve gruba katılmaya davet edin.

-

- Today Paper | 3B hareket tahmini; kendi kendine öğrenen robot; sağlam anlamsal bölümleme; evrişimli sinir ağı; karışık Gauss süreci, vb.

-

- Microsoft ve Pekin Üniversitesi ortaklaşa "mızrak ve kalkan" ın gerçekçi versiyonunu yorumlamak için yüzü değiştiren bir yapay zeka ve yüz sahteciliği dedektörü önerdi.

-

- Today Paper | Tıbbi görüntülerde derin öğrenme; meta-pekiştirmeli öğrenme; derin sinir ağlarının kayıpsız sıkıştırılması vb.

-

- Kayıt | Tsinghua-Chinese Academy of Engineering Knowledge Intelligence Joint Research Center Annual Conference and AI 2000AI TIME10

-

- Videoyu anlamak ve yeniden üretmek zor mu? FAIR şampiyon algoritmasının açık kaynak kodu PySlowFast'ın ayrıntılı açıklaması

-

- AAAI 2020 | Nanjing Üniversitesi: Farklı çeviriler oluşturmak için çok başlı dikkat mekanizmasını kullanma