ICLR 2020 | Bu kadar çok model parametresi varken, genelleme yeteneği neden bu kadar güçlü?

Yazar | Liu Jinlong

Editör | Camel

Liu Jinlong, 2015 yılında Peking Üniversitesi'nden teorik fizik alanında doktora derecesi ile mezun oldu ve şu anda Kuaishou Technology Y-Tech AI Lab'da derin öğrenme araştırmacısı olarak çalışıyor. Yüz işaretlerinin, yüz oluşturma ve diğer teknolojilerin geliştirilmesinden sorumludur.

Bu makale, ICLR2020 spot ışığı temsili olarak seçilen "Sinir Ağlarının Neden Parametrelerin GSNR'si Aracılığıyla İyi Genelleştirdiğini Anlamak" adlı en son çalışmamdan birini tanıtıyor.

1

Derin öğrenmenin genelleme yeteneği

Derin öğrenme birçok alanda büyük başarı elde etti, ancak derin öğrenmenin arkasındaki temel teori aslında göreceli olarak geride kalıyor. Önemli konulardan biri de derin öğrenme modellerinin genelleştirilmesidir. Bu çalışmada, bu sorunu anlamak için yeni bir bakış açısı ortaya koyduk.

Klasik makine öğrenimi genelleme teorisine göre, model parametrelerinin miktarı ne kadar büyükse, modelin uydurma yeteneği o kadar güçlüdür, ancak genelleme daha kötü olacaktır. Bununla birlikte, bu tür bir ödünleşim fenomeni derin öğrenmede gözlemlenmemiştir.Genellikle derin öğrenme modelleri, genellikle eğitim verilerinden çok daha fazla olan büyük miktarda parametrelere sahiptir.Klasik genelleme teorisine göre, bu tür modeller çok genelleştirilmelidir. fark. Uygulamada, gerçek veriler üzerinde eğitilen derin öğrenme modelleri genellikle iyi bir genelleme performansına sahiptir.Modelin parametrelerini artırmak, genellemeyi daha kötü yapmayacaktır. Bu fenomen, makine öğreniminin klasik genelleme teorisi ile açıklanamaz.

2

GSNR ne kadar büyükse, genelleme performansı o kadar iyidir

Bu yazıda, derin öğrenmenin genelleme yeteneğinin, onu eğitmek için kullandığımız gradyan iniş optimizasyon yöntemiyle yakından ilişkili olduğuna inanıyoruz.

İlk olarak, gradyan iniş yöntemi eğitim sürecinin genelleme performansını karakterize eden, tek adımlı genelleme oranı (OSGR) olarak adlandırılan bir miktar öneriyoruz.

Bu miktar, test kümesi \ Delta L'deki kayıp düşüşünün beklenen değerinin, bir yinelemede \ Delta L eğitim kümesindeki kayıp düşüşüne oranını yansıtır. Eğitim seti D ve test seti D 'boyutunun hem n olduğunu ve aynı Z ^ n dağılımına uyduğunu varsayıyoruz. Genel olarak konuşursak, istatistiksel olarak konuşursak, test setinin kayıp düşüş oranı, eğitim setinin kayıp düşüş oranından daha azdır. OSGR, 1'den az olmalıdır. Tüm eğitimin sonunda, test setinin toplam kaybı, eğitim setinin genel kaybından daha az olacaktır. genelleme boşluğu. OSGR, tüm eğitim süreci boyunca her zaman büyükse (1'e yakın), son genelleme boşluğu küçük olacak ve buna göre modelin son genelleme performansı çok iyi olacaktır. Bu nedenle, OSGR, gradyan iniş yöntemi sırasında modelin genelleme performansını karakterize edebilen iyi bir niceliktir.

İkinci olarak, Gradient Signal to Noise Ratio (GSNR) adlı bir parametre tanımlıyoruz. Gradyan iniş sürecinde gradyan ortalaması ile gradyan varyansı arasındaki oranı yansıtır. Bu ortalama ve varyansın, tüm örneklerdeki her bir parametrenin gradyanını tek tek hesaplama ve son olarak her bir parametrenin ayrı ayrı hesaplanması gradyanına atıfta bulunulduğunu unutmayın. Örneklem boyutunun ortalaması ve varyansı. Örneğin, \ theta_j parametresi için gradyan sinyal-gürültü oranı şu şekilde tanımlanır:

Yukarıdaki \ tilde g ve \ rho, sırasıyla tüm örneklerde hesaplanan gradyan ortalamasını ve gradyan varyansını temsil eder. Niteliksel olarak GSNR, farklı örnekler için kayıp fonksiyonunun gradyanının tutarlılığını yansıtır. Tüm örneklerin gradyanları tam olarak aynıysa ve 0 değilse, gradyan ortalaması 0 değildir ve varyans 0'dır ve karşılık gelen GSNR sonsuzdur.

Genel gradyan iniş yöntemi için, doğrudan tüm örneklerin ortalamasını alırız ve bu ortalamayı parametre yineleme yönü olarak kullanırız. Bu makale ilk kez, gradyan ortalamasına ek olarak, tüm örneklemlerin gradyan dağılımının ağın nihai genelleme performansı ile yakından ilişkili olduğunu önermektedir.

İki varsayımda bulunduk: 1. Öğrenme oranı yeterince küçük. 2. Eğitim setinin ortalama gradyanı ve test setinin ortalama gradyanı aynı dağılıma uyar (buradaki dağılım eğitim setimizin ve test setimizin aynı Z ^ n dağılımına uyduğu anlamına gelir). Bu iki varsayım aracılığıyla, OSGR ile GSNR arasında bir ilişki olduğu sonucuna varabiliriz.

Bu ilişki, eğitim sürecinde GSNR ne kadar büyükse, OSGR'nin 1'e o kadar yakın olduğunu ve nihai modelin genelleme performansının o kadar iyi olduğunu göstermektedir. Başka bir deyişle, gradyan iniş eğitim süreci sırasında farklı eğitim örneklerinin gradyanları ne kadar tutarlı olursa, nihai modelin genelleme performansı o kadar iyi olur. Spesifik türetme süreci için makaleye başvurabilirsiniz.

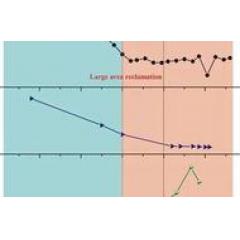

Kullandığımız hipotez 2'nin genellikle sadece erken eğitim aşamasında oluşturulduğunu belirtmekte fayda var.Eğitimin son aşamasında, aşırı uyumun meydana gelmesi nedeniyle, eğitim setinin ortalama gradyanı ve test seti artık aynı dağılıma uymuyor. Ancak bundan türetilen 19 veya 22 (makaleye bakın), bunları gerçek eğitim sürecinde doğrulayabiliriz.

Yukarıdaki resim, mnist üzerine bir deneydir. İlk eğitim döneminde, test verilerinin 19 formül ile iyi bir uyum içinde olabileceği görülebilir. Bununla birlikte, eğitim ilerledikçe, Denklem 19'un sol ve sağ tarafları artık eşit değildir, çünkü türetmemizde kullanılan hipotez 2 artık geçerli değildir. Yine de, Denklem 19'un sol ve sağ tarafları arasında hala güçlü bir pozitif korelasyon vardır. Bu pozitif korelasyon geçerli olduğu sürece, bizim sonucumuz (GSNR ne kadar büyükse, OSGR ne kadar büyükse, nihai genelleme o kadar iyi) hala geçerlidir. Cifar ve oyuncak model üzerinde yapılan deneyler de aynı sonuca varıyor.

3

Derin öğrenme modeli eğitim süreci sırasında, GSNR bir ilk yükselişe sahip olacak ve bunun arkasındaki neden

Şimdiye kadar, analiz ve deneyler yoluyla bir sonuç elde ettik: gradyan iniş yönteminin eğitim sürecinde, GSNR ne kadar büyükse, OSGR o kadar büyük ve nihai genelleme o kadar iyi. Ancak bunun derin öğrenmeyle hiçbir ilgisi yoktur Bu sonuç, gradyan inişi ile eğitilmiş herhangi bir model için geçerlidir.

Makalenin sonraki bölümlerinde bir fenomen bulduk: Doğrusal regresyon gibi sığ modeller için GSNR eğitim sürecinde her zaman düşecektir. Bunun nedeni, model yakınsama sürecinde, GSNR molekülünün gradyanının ortalama değerinin gittikçe küçülmesidir. Ancak derin öğrenme için, eğitimin başlangıcında GSNR'de her zaman hızlı bir artış gözlemleyebiliriz.Artan sonra, derin öğrenme modelinin GSNR'si yakınsama ile yavaş yavaş azalacaktır. Bu fenomen, gradyan iniş yöntemi eğitim sürecinde derin öğrenme modelini yapar, GSNR her zaman büyük bir seviyeyi korur. Önceki sonuçlarımıza göre, GSNR ne kadar büyükse, nihai modelin genelleme performansı o kadar iyi olur. Bu, derin öğrenmenin büyük miktarda model parametresine rağmen neden hala iyi genelleme performansına sahip olduğunu açıklar.

Daha sonra, derin öğrenme modelinin GSNR'sinin ilk eğitim aşamasındaki hızlı yükselişinin, özellik öğrenme yeteneği ile yakından ilişkili olduğunu analiz ettik. Bu noktayı göstermek için deneysel ve analitik yöntemler kullandık.

Deneysel olarak, bu modeli iki katmanlı bir MLP modeli aracılığıyla eğitiyoruz, sırasıyla ilk katman parametrelerini dondurup açıyoruz. Açıktır ki, birinci katman parametrelerinin dondurulması durumunda, model doğrusal regresyona eşdeğerdir. Bu iki durumda, modelin ikinci katmanının ortalama GSNR'sini ayrı ayrı saydık ve donma durumunda GSNR'nin her zaman düştüğünü ve açılma durumunda GSNR'de önemli bir artış olacağını gördük.

Analizimiz, açıldığında, modelin ilk katmanının parametrelerinin daha iyi özellikler öğrenebileceğine ve bu özelliklerle çarpılan modelin ikinci katmanının ağırlığının gradyanının farklı örneklerde daha iyi tutarlılığa sahip olacağına inanıyor. Seks. Yani, çoğu numune aynı anda bu ağırlığı artırma veya azaltma eğilimindedir ve bu ağırlığın karşılık gelen GSNR'si daha büyük olacaktır.

Analitik analiz, tamamen bağlı bir ağ durumunda, türetme yoluyla ilginç bir mekanizmayı açıkladık.Bu mekanizma, modelin birçok parametresinin (GSNR molekülü) ortalama gradyanının model eğitiminin erken aşamasında artma eğiliminde olmasını sağlar. Detaylar için makaleye bakabilirsiniz.

4 özet

1. Çeşitli varsayımlar altında, gradyan iniş yöntemi için eğitim sırasında GSNR ne kadar büyükse, nihai modelin genelleme performansının o kadar iyi olduğunu kanıtladık.

2. Derin öğrenme modelleri için, eğitimin başlangıcında GSNR'de hızlı bir artış olacaktır, bu da derin öğrenmenin iyi bir genelleme performansına sahip olmasını sağlar. Derin öğrenme modellerinin özellik öğrenme yeteneği ile yakından ilgilidir ve bunu deneyler ve analitik analizler yoluyla gösterdik.

Makalenin adresi: https://openreview.net/forum?id=HyevIJStwH

-

- Today Paper | 3B hareket tahmini; kendi kendine öğrenen robot; sağlam anlamsal bölümleme; evrişimli sinir ağı; karışık Gauss süreci, vb.

-

- Microsoft ve Pekin Üniversitesi ortaklaşa "mızrak ve kalkan" ın gerçekçi versiyonunu yorumlamak için yüzü değiştiren bir yapay zeka ve yüz sahteciliği dedektörü önerdi.

-

- Today Paper | Tıbbi görüntülerde derin öğrenme; meta-pekiştirmeli öğrenme; derin sinir ağlarının kayıpsız sıkıştırılması vb.

-

- Kayıt | Tsinghua-Chinese Academy of Engineering Knowledge Intelligence Joint Research Center Annual Conference and AI 2000AI TIME10

-

- Videoyu anlamak ve yeniden üretmek zor mu? FAIR şampiyon algoritmasının açık kaynak kodu PySlowFast'ın ayrıntılı açıklaması