Kapsamlı pekiştirmeli öğrenmede yeni eğilimler: Google, pekiştirmeli öğrenim aracılarına merakı nasıl katıyor

Bu makale, AI Araştırma Enstitüsü tarafından derlenen, orijinal başlığı olan teknik bir blogdur:

Derin Öğrenme Araştırmasındaki Yenilikler: Google, Takviye Edici Öğrenim Aracılarına Nasıl Merak Oluşturur?

Yazar | Jesus Rodriguez

Tercüme | Sos Yelpazesi Armut, Pu Jiatian, will_L_Q, Hayal Kırıklığı, J. X.L. Chan

Düzeltme | Pide İnceleme | Johnson Lee'nin Maaş Artışı Sıralama | Daimi Balık Kralı

Orijinal bağlantı:

https://towardsdatascience.com/whats-new-in-deep-learning-research-how-google-builds-curiosity-into-reinforcement-learning-32d77af719e8

Keşif-kullanım ikilemi, pekiştirmeli öğrenme algoritmalarını düzenlemenin itici güçlerinden biridir. Temsilcinin çevreyi keşfetmesi gereken kapsam ile belirli işlemleri nasıl gerçekleştireceği ve ödülleri nasıl değerlendireceği ile nasıl dengelenmeli? Pekiştirmeli öğrenme bağlamında, keşfetme ve geliştirme, ödül modelinde merakı engelleyen karşıt güçler olarak görülmektedir. Bununla birlikte, tıpkı insan bilişinde olduğu gibi, pekiştirici öğrenme ajanlarının merakı doğru bilgiden gelir, öyleyse ajanı cezalandırmadan merakı nasıl canlandırabiliriz? Bu, takviye öğrenme aracılarında merak uyandırmak için bir yöntem sunan Google Research tarafından yakın zamanda yayınlanan bir araştırma makalesinin konusudur.

Pek çok takviye öğrenme algoritması, yoğun bir ödül kümesinin temsilci davranışıyla ilişkilendirilebileceğini varsayan yapılandırılmış bir ödül modeline dayanır. Bununla birlikte, gerçek dünyadaki birçok ortam, takviye öğrenme mekanizmalarına kolayca adapte edilemeyen seyrek ödül mekanizmalarına dayanmaktadır. Pekiştirici öğrenme temsilcisinin kütüphane ortamında belirli bir kitabın sahnesini bulması gerektiğini düşünürsek. Temsilci sürekli olarak arama yapabilir, ancak kitaplar hiçbir yerde bulunamaz ve belirli eylemler için net bir ödül yoktur. Seyrek ödül ortamı, pekiştirici öğrenme aracıları için çok zordur çünkü açık ödüller olmadan çevreyi sürekli olarak keşfetmek zorundadırlar. Bu ortamlarda, pekiştirme öğrenme aracısının "merakı", uygun ödül işlevini elde etmek için esastır. Başka bir deyişle, pekiştirmeli bir öğrenme ortamında ödül seyrekliği ile merak arasında doğrudan bir ilişki vardır.

Merak düello erteleme

Merak, pekiştirmeli öğrenmede her zaman aktif bir araştırma alanı olmuştur. Pekiştirmeli öğrenmedeki çoğu merak formülü, geleceğin "sürprizini" veya öngörülemezliğini en üst düzeye çıkarmayı amaçlar. Bu yöntem, sinirbilimin merak teorisinden esinlenmiştir, ancak pekiştirmeli öğrenme modellerinde görece verimsiz olduğu gösterilmiştir. Verimsizliğin temel nedeni, hedef görevle ilgisi olmayan merakı en üst düzeye çıkarmanın doğrudan ilişkili olmaması ve dolayısıyla ertelemeye yol açmasıdır. Bu can sıkıcı gerçeği aşağıda açıklayayım?

Örnek olarak bir ortamı ele alalım, bu ortamda pekiştirme öğrenme aracısı üç boyutlu bir labirente yerleştirilir. Labirentte büyük bir ödül verecek değerli bir hedef var. Şimdi temsilciye bir TV uzaktan kumandası veriliyor ve kanal değiştirebiliyor. Her kanal rastgele bir görüntü gösterir (bir dizi sabit görüntüden seçilir). Sürprizlerin merak formülünü optimize etmek mutlu olacaktır çünkü kanal değiştirmenin sonuçları tahmin edilemez. Temsilci her zaman TV'nin önünde kalacak ve hedef görevi çözmeye çalışmayacaktır.

Bu ikilem açıktır: Pekiştirmeli öğrenme modelleri, yalnızca nihai hedef için yararlılarsa, merakı en üst düzeye çıkarmalıdır. Bununla birlikte, hangi keşif adımlarının hedef görevle ilgili olduğunu ve hangilerinin olmadığını nasıl bileceğiz? Google, Episodic Curiosity adlı bir yöntem önererek bu zorluğa yanıt verdi.

Durumsal merak

Google'ın pekiştirmeli öğrenme alanındaki yeniliği, çaba kavramını tanıtarak merak ve erteleme arasındaki sürtüşmeyi çözmektir. Özünde, bağlamsal bellek yöntemi, yalnızca belirli bir çaba gerektiren gözlem verilerini ödüllendiren bir yöntemdir ve "kendine düşkün davranıştan" kaçınmayı önerir. TV labirenti (labirent-tv) örneğimize göre, kanal değiştirdikten sonra tüm programlar sonunda hafızada bitecektir. Bu nedenle, TV şovlarının herhangi bir çekiciliği olmayacak, çünkü ekrandaki şovların sırası rastgele ve tahmin edilemez ve tüm bu şovlar zaten depoda! Bir bağlam depolama aracısı bunu belirlemek için geçmişi kontrol edecek Mevcut gözlemle benzer gözlemler görmüş olsun, bu durumda herhangi bir ödül almayacaktır. TV'de birkaç kez tekrarlanan yayınlardan sonra, sahne depolama aracısı anlık memnuniyetle ilgilenmeyecek, ancak ek ödüller için TV dışındaki dünyayı keşfetmelidir. Kulağa akıllı geliyor mu?

Epizodik bellek yöntemi, merakı resimlerin erişilebilirliğiyle birleştirir. Ajan, bölümün başında boş bir depolamayla başlar ve yeniliğini belirlemek için her adımda depolamadaki gözlem sonucuyla mevcut gözlem sonucunu karşılaştırır. Mevcut gözlem gerçekten yeniyse - o zaman hafızadaki gözlemden eşikten daha fazla adım atılmışsa - o zaman aracı kendisini ödüllendirecek ve mevcut gözlemi bağlam deposuna ekleyecektir. Bu işlem bölümün sonuna kadar devam eder ve bu noktada depolama alanı silinir.

Durumsal Meraktan Bir Sinir Ağı Mimarisi

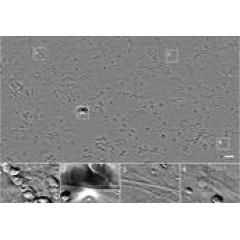

Takviye öğrenme aracısında epizodik bellek işlevini uygulamak için Google, aşağıdaki şekilde gösterildiği gibi iki sinir ağını bir epizodik bellek tamponu ve bir ödül tahmin modülü ile birleştiren bir mimariye güvenir:

Epizodik bellek mimarisinin çeşitli bileşenlerine bakalım:

-

Gömme ve karşılaştırıcı ağlar: Bu iki ağın amacı, başka bir girdi gözlemi verildiğinde belirli bir gözlemin erişilebilirliğini tahmin etmektir. Spesifik olarak, iki ağ, lojistik regresyon kaybıyla eğitilmiş bir sınıflandırıcı olan R-Network adlı bir mimariye dayanmaktadır: Birinden diğerine iki gözlem olasılığı k adımda karşılaştırılırsa Düşük, bu durumda tahmin edilen değeri 0'a yakındır, aksine olasılık çok yüksek olduğunda değeri 1'e yakındır.

-

Durumsal bellek tamponu: Durumsal bellek tamponu, belirli gözlemlere dayalı değerlendirme için mevcut durumda geçmiş gözlemlerin gömülmelerini depolar.

-

Ödül tahmin modülü: Bu modülün amacı bellekte ulaşılabilir gözlemler olup olmadığını kontrol etmek ve yoksa kontrol etmektir. Esasen, mevcut durumdan sadece birkaç eylem alarak, bu modülün kontrolü, bellekte hiçbir gözlem yapılmamasını sağlar ve böylece merakı teşvik eder.

Olaylı bellek eylemde

Google, epizodik bellek güçlendirme öğrenme modellerini bir dizi görsel ortamda (ViZDoom ve DMLab gibi) test etti ve sonuçlar mükemmel. Bu ortamlarda, aracının görevi, bir labirentte hedefleri aramak veya iyi içerik toplamak ve kötü nesnelerden kaçınmak gibi çeşitli sorunlarla uğraşmaktır. DMLab ortamı, ajana lazer bilim kurguya benzer nesneler sağlar. DMLab üzerinde önceki çalışmadaki standart ayar, aracıyı tüm görevler için aygıtlarla donatmaktır. Temsilci belirli görevler için aygıtlara ihtiyaç duymuyorsa, ücretsiz olarak kullanılabilir. Ödüllerin seyrekliği, bu ortamları çoğu geleneksel pekiştirmeli öğrenme yöntemleri için çok zor hale getirir. Labirentte yüksek ödüllü öğeleri aramakla görevliyken, duvarları işaretlemek için zaman harcamayı tercih eder, çünkü çok sayıda "sürpriz" ödül üretecektir.

Aynı ortamda, epizodik bellek ajanı, ödüllerle merakı en üst düzeye çıkarmaya çalışacak şekilde labirentte etkili bir şekilde dolaşabilir.

Aşağıdaki animasyon, epizodik bellek aracısının, bellekte keşfedilen konumların bir tamponunu (mavi) korurken, ödül (kırmızı) yerine pozitif ödülleri (yeşil) nasıl teşvik ettiğini göstermektedir.

Epizodik bellek yöntemi, gördüğüm en yaratıcı yöntemlerden biridir ve öğrenen kişinin merakını artırabilir. AI sistemlerinde pekiştirmeli öğrenme gittikçe daha yaygın hale geldikçe, epizodik bellek gibi yöntemler bu mimarilerin önemli bir parçası haline gelmelidir.

Bu makalenin ilgili bağlantılarını ve referanslarını görüntülemeye devam etmek ister misiniz?

[Derin Güçlendirmeli Öğrenimde Yeni Eğilimler: Google, Güçlendirmeli Eğitim Aracılarına Nasıl Merak Getiriyor] 'u tıklayın veya şu adrese basın: Lei Feng Wang Lei Feng Wang Lei Feng Wang

https://ai.yanxishe.com/page/TextTranslation/1231

Makine öğrenimi çılgınlığı

Sınırlı bir süre için ücretsiz \ 18 klasik kitap \ Stanford klasik ders kitapları + makaleler

Almak için bağlantıya tıklayın:

https://ai.yanxishe.com/page/resourceDetail/574

-

- Çok fazla eseri yoktu ama her biri bir klasik. 35 yıllık çıkışında hiç skandalı olmadı ve Chen Daoming öğretmenini aradı!

-

- Hu Ge'nin televizyon endüstrisindeki gücü ve karakteriyle, aktör Tony Leung ile karşılaştırılabilir mi?

-

- AI iş arama sezonu bu hafta incelemesi: Momenta / Tucson / Megvii / Malong sizi teklifi trenle almaya davet ediyor

-

- Bu klasik filmlerdeki büyüleyici çekimler, kaşlarını çatarak, gülümsemeyle ve geriye dönüp bakarken harika zamanlar!