Stanford Üniversitesi Ma Tengyu: Mevcut derin öğrenme algoritmalarını anlayamıyor musunuz? Sonra anlaşılır bir

Yazar | Kongun Sonu

Düzenle | Deve

Mezun Tsinghua Üniversitesi Yao Ban, Ph.D., Profesör Sanjeev Arora'nın vesayeti altında Princeton Üniversitesi'nden mezun olan Ma Tengyu, AI akademisinde yükselen bir yıldız olarak şimdi dünyanın zirvesinde toplantı Dergilerde 20 yüksek kaliteli makale yayınladı ve 2018 ACM Doktora Tezi Ödülü gibi birçok ağır akademik ödül kazandı.

Birkaç gün önce Pekin Zhiyuan Yapay Zeka Araştırma Enstitüsü'nün ev sahipliği yaptığı denizaşırı akademisyenler raporu toplantısında, Ma Tengyu, yalnızca derin öğrenme yöntemlerinin anlayışını paylaşmak için "açık bir düzenleyici tasarlayan" son araştırma çalışmasına dayanan kuru bir rapor getirdi. Ayrıca kendi araştırmama göre deneyim Birçok araştırma metodolojisi ve görüşü paylaşıldı.

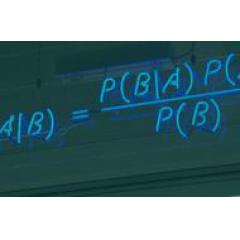

Derin öğrenmeyi anlamak için kullanılan yaygın yöntemin örtük düzenlileştirme olduğuna dikkat çekti, ancak araştırmalarında açık düzenlemenin daha iyi bir seçim olabileceğini buldular.

Aynı zamanda bilgisayar bilimi ile fizik ve biyoloji gibi geleneksel bilimler arasındaki farkın sürekli olarak yeni algoritmaların tasarlanabilmesi olduğunu vurguladı. "olmasına rağmen Biz Mevcut derin öğrenme algoritmalarını anlayamıyorum ama Biz Tasarlanabilir Biz Hem anlaşılır hem de etkili olan yeni algoritmalar. "

Biz devamındaki Ma Tengyunun raporuna bakın:

1. Parametreli derin öğrenme modeli neden gerçekleştirilebilir? Genelleme ?

Derin öğrenme, Ma Tengyu'nun araştırma grubunun önemli bir araştırma yönüdür. Ana araştırma fikirleri, derin öğrenme modellerinin performansını bazı matematiksel veya teorik analizlerle teknik bir bakış açısıyla iyileştirmektir.

Metodoloji perspektifinden, derin öğrenmenin şu anda çok fazla çekirdek Buradaki zorluk, büyük ölçekli verilere olan ihtiyaçta yatıyor. Genelleme Ve veri hacminin ölçeği o kadar abartılmalı ki, akademinin bu kadar çok veri toplamasının zor olduğunu düşünüyor ve çoğu zaman bunu sadece endüstri yapabilir.

Bu nedenle, bir derin öğrenme modelinin verilere olan bağımlılığını azaltmasını istiyorsanız, derin öğrenme modeline ulaşmak için daha az veriyi nasıl kullanacağınızı anlamanız gerekir. Genelleme .

Öyleyse, aşırı parametreleştirilmiş derin öğrenme modeli neden Genelleme Ne?

Bunun nedeni, mevcut derin öğrenme modelinin bir çekirdek Aradaki fark, veri sayısı parametre sayısını çok aştığında modelin önceki geleneksel görüşte yatmaktadır. Genelleme ; Derinlemesine iken Xi dönemi Görüş, başarılı bir modelin sahip olması gereken tam tersidir. Daha Parametreler, daha az veri hacmi. Şimdi derin öğrenme modelinin uygulanması gerekiyor Genelleme , Gerekli parametreler veri miktarından fazladır.

Ancak derin öğrenme çağında, modelin Genelleme Bunların hepsini açıklamak çok zor çünkü birçok geleneksel görüş artık geçerli değil. Ama hala geçerli olan geleneksel bir görüş var: Occam's Razor, bu da düşük karmaşıklık modellerinin de mümkün olduğu anlamına geliyor. Genelleme Çok iyi.

Ancak bu tür bir "düşük karmaşıklık" ın tanımlanması aslında zordur, bu nedenle çekirdek Soru nasıl doğru Model karmaşıklığını tanımlayın ve Biz Ölçmek ve bulmak için hangi yöntemler kullanılabilir? doğru Tanımın karmaşıklığı. Bu, bazı teorik araştırmalarla çözmeyi umdukları bir sorundur.

Yaygın yöntem örtük düzenleme yöntemidir.Bu yöntemin analizi iki yöne odaklanabilir: birincisi, algoritma düşük karmaşıklıktaki çözümleri tercih eder; ikincisi, düşük karmaşıklık modeli Genelleme Çok iyi. Bu iki yönü analiz ederek, mevcut algoritmaları anlayabilir ve aynı zamanda karmaşıklığı ölçmenin yeni yöntemlerini keşfedebilirsiniz - çünkü algoritma tercihlerinin karmaşıklığı temelde doğru Karmaşıklık ölçüm yöntemi.

Ma Tengyu, ekibi tarafından yapılan bazı çalışmaları örnek alarak bazı bulguları açıkladı:

-

Birincisi, model eğitimi ve yakınsama açısından öğrenme oranı çok önemlidir. Örneğin, son NeurIPS makalesinde, büyük bir öğrenme hızı kullanan iki katmanlı bir sinir ağının yalnızca doğrusal işlevleri temsil edebileceği kanıtlandı.Bu nedenle, çok karmaşık bir model kullanılsa bile, yalnızca Modeli beklenenden daha basit hale getiren bazı çok basit çözümleri temsil eder Bu aslında derin öğrenmede gürültünün düzenlenmesi.

-

İkinci olarak, başlatma yöntemi, modelin karmaşıklığı üzerinde aynı etkiye sahiptir. Örneğin, Chizat Bach 2019'da büyük bir başlatma durumunun en küçük sinirsel teğet nükleer norm çözümünü elde etmenin daha kolay olduğunu kanıtlayan bir makale yayınladı. Kendi çalışmalarından bazıları, küçük başlatmaların, en küçük L1 çözümü veya nükleer norm çözümü gibi nükleer devletlerden daha ilginç olan daha "zengin" devletler elde etme eğiliminde olduğunu kanıtlıyor. Woodworth ve diğerleri tarafından yapılan bir çalışma, temel olarak, daha küçük başlatılmış bir modelin bir L2 çözümü yerine minimum bir L1 çözümüne yakınlaşacağını göstermektedir.

Bu iş çekirdek Buradaki fikir, farklı algoritmaların farklı tercihleri olduğu ve farklı tercihlerin farklı karmaşıklık ölçütlerine sahip olacağı, öğrenme oranlarının tercihleri olacağı ve başlatma durumlarının da tercihleri olacağı yönündedir.

2. Derin öğrenmeyi anlamanın tek yolu örtük / algoritmik düzenleme mi?

bu durumda İstemek Derin öğrenmeyi anlamak için, örtük / algoritmik düzenlileştirmeyi anlamanın tek yolu bu mu?

Bu bağlamda, Ma Tengyu, klasik metodu gözden geçirmenin, açık düzenlileştirme metodunu anlamanın gerekli olduğuna inanmaktadır. Açık düzenlileştirme yönteminin gerçekten herkese layık olduğunu söyledi Dikkat Ve kısa vadede daha etkili bir yöntem olabilir.

Gereksinimleri karşılamak için örtük / algoritmik düzenleme yöntemi, algoritmanın düzenli hale getirilmesi gerekir ve algoritma, karmaşıklık düzeyi düşük çözümler elde etme eğilimindedir. Bununla birlikte, algoritma düzenleyiciliğiyle ilgili birçok makalede, "algoritmaların düşük karmaşıklıktaki çözümler elde etme eğiliminde olduğunu" açıklarken bir darboğazla karşılaştıklarını ve "düşük karmaşıklıklı çözümler Genelleme "Daha iyi olmak" nispeten basittir.

Bu nedenle, açık düzenlilik yöntemleri, derin öğrenmeyi anlamak için daha iyi bir seçim olabilir.

Bu klasik makine öğrenimi paradigmasında odak noktası Dikkat Modeli daha iyi hale getirebilecek karmaşıklığın araştırılmasıdır Genelleme verim. "Algoritmalar düşük karmaşıklıktaki çözümler bulma eğilimindedir" şeklindeki araştırma darboğazına gelince, her şey şansla ilgili.

Açık düzenlileştirme yönteminin dezavantajı, algoritmayı değiştirme ihtiyacıdır, çünkü düzenlileştirme karmaşıklığı kaçınılmaz olarak algoritmayı değiştirecektir. Bununla birlikte, avantajı yalnızca mevcut algoritmaları anlamak değil, aynı zamanda bazı yeni karmaşıklık ölçüleri veya düzenleyiciler tasarlamak, bazı yeni algoritmalar tasarlamak ve optimizasyonu istatistiksel verilerden ayırmaktır.

Son zamanlarda makine öğrenimi alanında sıcak bir konunun "Çift İniş" fenomeni olduğuna dikkat çekti, bu da test hatasının tek bir damla değil, çift damla olduğu anlamına geliyor. Yakın zamanda yapılan bir çalışmada, algoritma düzenlendikten sonra çifte düşüş olmayabileceğini göstermeye çalıştılar.

2019'da Nagarajan ve diğerleri tarafından bir NeurIPS en iyi makale ödülü, tek tip yakınsamanın derin öğrenmede meydana gelen olguyu açıklayamadığını gösterdi. Bu noktayı açıklamak için bir karşı örnek verdiler: Bu karşı örnek çok ikna edici olsa da, sadece mevcut algoritmanın kurulmasına karşı bir örnektir. Yani, algoritma düzenlileştirmeye eklendikten sonra, bu karşı örnekler muhtemelen artık geçerli olmayacaktır.

Optimizasyon ve istatistiksel verilerin ayrılıp ayrılmadığı nasıl kontrol edilir?

Yöntem, model düzenlendikten sonra, hangi algoritma kullanılırsa kullanılsın, objektif fonksiyonun aynı şeyi başarabilmesidir. Genelleme Optimizasyon ve istatistiksel verilerin ayrıldığını gösteren yetenek.

Ma Tengyu, açık düzenlileştirme yöntemlerinin örtük düzenlileştirme yöntemlerinin yerine kullanılabileceğini kanıtladıklarını ve tamamen değiştirilemeyeceklerine rağmen, bu yönde ilerlediğine inandığını söyledi.

3. Mevcut derin öğrenme algoritmalarını anlayamıyor musunuz? O zaman anlaşılır bir tane tasarlayın!

YZ topluluğunun mevcut genel algısında, derin öğrenmenin iç mekanizması anlaşılamıyor ve esasen bilimsel bir sorun haline geldi. Bu bağlamda Ma Tengyu, bilgisayar bilimi ile fizik ve biyoloji gibi geleneksel bilimler arasındaki farkın yeni algoritmaların sürekli olarak tasarlanabileceğine dikkat çekti.

Bilimsel araştırma içeriği Daha Dünyada meydana gelen veya var olan nesnel fenomen nedir (kara delikler gibi) ve bilgisayar biliminde, araştırmacılar yayınlananları inceleyemezler, ancak herhangi bir İstemek Bir şeyler araştırın.

Temyiz etti: " Biz Mevcut derin öğrenme algoritmalarını anlayamıyorum ama Biz Tasarlanabilir Biz Hem anlaşılır hem de etkili olan yeni algoritmalar. Bilgisayar bilimi alanındaki araştırmacıların araştırmalarını daha aktif hale getirebileceklerini düşünüyorum. "

Raporda Ma Tengyu, son araştırma çalışması olan AI teknolojisine dayanan açık düzenlileştirmenin belirli araştırma örneklerini de paylaştı. yorum Yap içinde Buraya Dr. Ma'nın PPT'sinin ilgili içeriği ektedir:

-

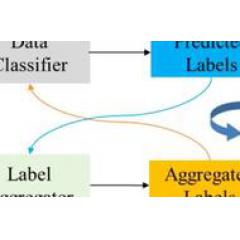

- AAAI 2020 | Çin Bilimler Akademisi Bulut Teknolojisi: Sınıflandırma performansını iyileştirmek için birden çok zayıf etiket kullanan çift görünümlü sınıflandırma

-

- Today Paper | Haber öneri sistemi; çok kanallı kodlama; bilgi ile zenginleştirilmiş ön eğitim modeli vb.

-

- Temsili öğrenmenin yedi araştırma ilerlemesine genel bakış, grafik sinir ağları, yorumlanabilir yapay zeka, makine öğrenimi ve robotik

-

- AAAI 2020 | Bilgisayar Teknolojisi Enstitüsü'nden WeChat AI: Eğitim hedeflerini iyileştirin ve otoregresif olmayan modellerin (açık kaynaklı) çeviri kalitesini iyileştirin

-

- ICLR 2020 | 15.000 sinir ağını eğitin, NAS'ı hızlandırın ve aramayı yalnızca 0,1 saniyede tamamlayın

-

- AAAI 2021 konferansının yeni başkanı olarak, Profesör Yang Qiang'ın düşündüğü "makine öğreniminin sınır sorunları" nelerdir?

-

- AAAI 2020 | Kuaishou: Görüntü estetiğinin değerlendirmesini yeniden inceleyin ve vurguların odağını bulun