NAS çok zordur, arama sonuçları rastgele örnekleme ile karşılaştırılabilir! Huawei ICLR 2020 belgesi 6 öneri veriyor

Yazar dwilimeth

Editör Jia Wei

Bu makale, sütun hakkındaki bilgilerimden alınmıştır: AutoML makalesi

ICLR 2020 konferansı 26 Nisan'da Etiyopya'da (Addis Ababa) Afrika'da yapılacak. Bu konferansta 687 bildiri kabul edilen (48 sözlü bildiri, 107 spot bildiri ve 531 poster bildirisi) olmak üzere toplam 2594 bildiri sunuldu ve kabul orani% 26,5 oldu. Bu makale, Paris Polytechnic ve Huawei'nin Noah's Ark Laboratuvarı'ndan Antoine Yang, Pedro M Esperanca ve Fabio Maria Carlucc tarafından yazılan ve ICLR 2020'de yayınlanan "NAS değerlendirmesi sinir bozucu derecede zor" makalesini tanıtıyor.

Makaleye bağlantı: https://openreview.net/forum?id=HygrdpVKvr

Kod bağlantısı: https://github.com/antoyang/NAS-Benchmark

Bugün, bir ICLR 2020 makalesi sunacağım "NAS değerlendirmesi sinir bozucu derecede zor". Yazarlar, École Polytechnique Paris'ten Antoine Yang, Pedro M Esperanc¸a ve Fabio Maria Carlucc ve Huawei'nin Noah's Ark Laboratuvarı.

Sinirsel Mimari Aramanın (NAS) son yıllarda hızla geliştiğine işaret ederek başlayan makale, hangi algoritmanın en iyi, hangi arama yönteminin en iyi olduğu konusunda bir sonuca varılamadı. Aynı parametre ayarları altında farklı kağıtlar arasında adil karşılaştırmalar yapmak zordur. Bazı kağıtlar ek numaralar, manuel olarak ayarlanmış parametreler ve dikkatlice tasarlanmış fazladan yerleştirmeye sahip olabilir, böylece belirli bir veri setinin doğruluğu daha yüksek görünür.

Yazar, açık kaynak kodlu 8 NAS yöntemi buldu ve bunları 5 farklı veri setinde karşılaştırdı. 8 NAS yöntemi DARTS, StacNAS, PDARTS, MANAS, CNAS, NSGANET, ENAS, NAO'dur. 5 veri seti Cifar 10, Cifar 100, Sport 8, MIT 67, Flowers 102'dir. Beş veri seti seçildi çünkü makaledeki sonuçların çoğu Cifar 10'a dayanıyor ve Cifar 10'a fazla uyduğuna dair bir şüphe var.

Bazı yöntemler, iyi arama stratejilerinden ziyade iyi bir arama alanının manuel olarak tasarlanması, eğitim ve ayarlamadan kaynaklanıyor olabilir.

Yazar, bu sorunu önlemek için bu 8 yöntemin arama uzayında rastgele ağ yapısını örneklemiş, aynı eğitim parametrelerini izlemiş ve bu 8 yöntemle karşılaştırmıştır. Yazarın açık kaynak koduna başvurabilirsiniz. Detaylar ondan keşfedilebilir.

Özellikle, yazarın deneyi üç adıma bölünmüştür:

1. Bu 8 yöntemin arama alanından ağ yapısını rastgele elde edin ve ardından veri seti üzerinde çalışın (eğitim sırasında aynı rastgele sayı tohumunu kullanın).

2. 8 yapıyı araştırmak için bu 8 yöntemin kodlarını kullanın ve daha sonra bunları veri setinde eğitin (rastgele sayı tohumu arama sırasında farklıdır, ancak eğitim sırasında rastgele sayı tohumu aynıdır).

3. Rastgele örneklenen yapıyı, aranan yapı ve test setindeki performans farkı ile karşılaştırın.

Yazarın deneyinin sonucu şu şekildedir:

Makalenin başlığından da anlaşılacağı gibi, sonuç sinir bozucu derecede zor.

1. Rastgele örnekleme ile elde edilen sonuçlarla karşılaştırıldığında, her yöntemin gelişimi çok azdır. Bazı durumlarda, arama sonuçları rastgele örnekleme ile elde edilenlerden daha da kötüdür, bu da arama yönteminin yakınsamadığını gösterir.

2. Bazı yöntemlerin doğruluğu çok fazla değişmez, bu da arama alanının çok küçük olduğunu ve bu küçük arama alanında elde edilen zayıf yapının nispeten iyi olduğunu gösterir. Yani, iyi bir arama alanı büyük bir rol oynar, bir arama algoritması ise küçük bir rol oynar.

3. Cifar 10'da, bazı yöntemler (PDARTS, MANAS, DARTS, StacNAS) çok yakın performans gösterdi ve hepsi oldukça iyiydi; ancak diğer veri kümelerinde, bu yöntemlerin performansının varyansı büyük olacak ve bu da parametrelerin Cifar 10 yukarıda özel olarak ayarlanmıştır ve genelleme performansı iyi değildir.

Şekil-2, Cifar 10'da farklı yöntemlerin performans ve arama maliyetini (GPU-günler) göstermektedir. Tablo-1, bu 8 yöntemle elde edilen yapının 5 veri seti üzerinde göreli olarak rastgele gelişmesini göstermektedir. Hemen hemen her algoritmanın rastgele arama kadar iyi olmadığı görülebilir.

1. Farklı eğitim parametrelerini karşılaştırın

Yazar, yukarıdaki sonuçlara dayanarak, her arama alanında, nihai doğruluk açısından, farklı ağ yapılarından daha büyük bir rol oynamak için ne tür eğitim parametrelerinin kullanıldığını tahmin eder. Yazar, varsayımı doğrulamak için aşağıdaki deneyi kullandı:

1. Cifar 10 veri kümesinde, DARTS arama alanını kullanın ve 8 farklı yapıyı rastgele örnekleyin;

2. Eğitim için farklı eğitim parametreleri kullanın;

3. Test setindeki modeller arasındaki performans farklılıklarını karşılaştırın.

Farklı eğitim parametreleri şunlara işaret eder: Temel ve DARTS benzer süper parametreleri kullanır, tüm numaralar kullanılmaz ve 600 dönem eğitilir. Sözde "hileler", bu makalede Xnas tarafından kullanılan hilelere atıfta bulunur: Yardımcı Kuleler, DropPath, Kesme, AutoAugment, 1500 devire uzatılan eğitim, kanal sayısını artıran.

Sonuç aşağıdaki şekilde gösterilmiştir: DARTS arama uzayında rastgele örnekleme ile elde edilen yapı artı Xnas tarafından bu makalede kullanılan tüm hileler 0,69 artabilir, bu da Xnas'ın 0,25 gerisindedir. Bu şekilde bakıldığında, birçok yeni makale son teknoloji ürünü sonuçlara ulaşmış olsa da, bunun iyi bir arama stratejisine bağlı olması gerekmez.

2. DARTS'ın arama alanını inceleyin

1. Rastgele örneklemenin sonuçlarıyla karşılaştırın

Yazar, eğitim için DARTS arama alanından yeterli sayıda yapıyı (200'den fazla) rastgele örnekledi ve farklı yapılar arasındaki varyansın ne kadar büyük olduğunu görmek istedi.

Sonuçlar aşağıdaki şekilde gösterilmektedir: Ortalama performans 97.03 ± 0.23, en kötü 96.18 ve en iyisi 97.56'dır. Yazar, aynı parametreler altında birçok yöntemle elde edilen sonuçların bu standart sapma aralığında olduğuna dikkat çekti.

Ek olarak, aşağıdaki şekilde gösterildiği gibi yazar, ağ yapısındaki hücre sayısının nihai doğruluk üzerinde büyük bir etkiye sahip olduğunu ve hücrelerin el emeği ile seçilen hiperparametreler olduğunu buldu.

2. Aday operasyonların etkisi

Yazar, DARTS'ın arama alanından (DARTS ayrıca genişletilmiş dönş. Gibi karmaşık işlemleri de içerir) çok daha küçük bazı basit dönş, havuzlama, hiçbiri, atlama bağlantı işlemlerini içeren küçük bir arama alanı tasarladı. Teoride arama Sonuç da daha kötü.

Nihai sonuç aşağıdaki şekilde gösterilmektedir: Değişiklikten sonra küçük arama alanının orijinal DARTS'tan 0.18 daha düşük olduğu ve daha da kötü olmadığı görülmektedir. Yazar, böylelikle çok sayıda karmaşık hesaplamanın eklenmesinin iyi bir arama alanının anahtar unsuru olmadığına işaret etti.

3. Rastgele sayı tohumlarının etkisi

Yazar önce rastgele 32 farklı ağ yapısını örneklemiş ve daha sonra eğitim için iki farklı rastgele sayı tohumu kullanmıştır.Sonuçlar aşağıdaki şekilde gösterilmiştir: Tohumlar değiştirildikten sonra farklı modellerin performansı oldukça zayıftır. Bu, rastgele sayı tohumlarının etkisinin hala oldukça büyük olduğunu gösterir, bu nedenle kağıt sonuçları bildirdiğinde, farklı tohumlar ile birden fazla çalışma çalıştırdıktan sonra ortalama sonuçları rapor etmelidir.

Üç, özet

Yazarın vardığı sonuç şudur:

1. Bazı veri iyileştirmeleri, daha fazla çağ eğitimi ve diğer numaralar nihai sonucu büyük ölçüde etkileyecektir. Bu nedenle, kağıt sonuçları bildirdiğinde, performansı artırmak için çeşitli hileler eklemenin yanı sıra, bu hileler olmadan çıplak sonuçları da rapor etmelisiniz;

2. Çeşitli makaleler, arama alanındaki birden çok yapıyı rastgele örnekleyerek elde edilen sonuçları karşılaştırmalıdır. Bu noktayla ilgili tartışmalar, xie saining ile görüntü tanıma için rastgele kablolu sinir ağlarını keşfetme makalesinde de bulunabilir. Bunun kontrollü rastgele arama deneyinden farklı olduğu unutulmamalıdır;

3. Çeşitli belgeler, belirli bir veri kümesinin gereğinden fazla uymasını önlemek için birden çok veri kümesinde sonuç vermelidir;

4. Çeşitli makaleler, çeşitli yapısal parametreler (DARTS'taki hücre sayısı gibi) ve eğitim parametreleri hakkında sıkı kontrol deneyleri vermelidir;

5. Tekrarlanabilirlik Çeşitli kağıtlar için en iyi sonuçları ve en iyi yapıyı rapor etmenin yanı sıra, kullanılan tohumlar, kodlar ve ayrıntılı parametre konfigürasyonları da verilmelidir. Doğrulamak için birden çok deney yapmak en iyisidir;

6. Ayarlama parametrelerinin maliyeti de NAS'ta dikkate alınmalıdır.

Bu makaleyi okuduktan sonra güçlü bir "açık akım" hissettim.

ICLR Bölge Başkanı bu makale hakkında "doğru yönü işaret ederek" yorum yaptı

"Genel olarak, bu makalenin NAS topluluğuna önemli bir katkı olduğuna kesinlikle inanıyorum. Bazıları tarafından" sadece "bazı deneyler yürütüyor olarak görülebilir, ancak gösterdiği deneyler çok bilgilendirici ve topluluğu etkileyecek ve ona rehberlik edecek doğru yön. "

(Kısacası, bu makalenin NAS topluluğuna önemli bir katkısı olduğuna kesinlikle inanıyorum. Bazıları tarafından "sadece" bazı deneyler yapmak olarak görülebilir, ancak bu deneyler çok faydalıdır ve topluluğu etkileyecek ve toplumu doğru yönde yönlendirecektir. Çok yararlı.)

ICLR 2020 yazı dizisinin yorumlanması:

1. Bildiriler

Popüler grafik makine öğrenimi, ICLR 2020'deki araştırma trendleri nelerdir?

2, Oral

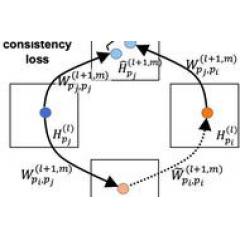

01. Sözlü | Yansıtılmış üretken makine çevirisi modeli: MGNMT

02. Oral | Negatif çeşitlilik cehaletini hafifletmeden önce Ekstra Gauss

03. Oral | Ek geçitleme işlemleri uygulayın, LSTM biraz değiştirildi, performans Transformer-XL ile karşılaştırılabilir

04. Oral | Paralel Monte Carlo araması, performans kaybı olmadan, doğrusal hızlanma ve "Eksik Eğlence" nin 1000 seviyesini cesurca aşma!

3. Gündem

01. Gündem | Bu kadar çok model parametresi varken, genelleme yeteneği neden bu kadar güçlü?

02. Gündem | Adalet ve hassasiyet aynı derecede önemlidir! CMU, algoritma adaletini sağlamak için öğrenmede adil bir temsil yöntemi önerir

03. Gündem | Zayıf kombinasyon genelleme yeteneği? Derin öğrenme füzyon kombinasyonu çözücüyü kullanmayı deneyin

04. Gündem | NAS'ı hızlandırın, aramayı yalnızca 0,1 saniyede tamamlayın

4. Afiş

01. Afiş | Huawei Noah: Zekice düşünme, NAS ve "yüzleşme" kombinasyonu hızı 11 kat artırıyor

02. Poster | Evrişimin yanı sıra, çok başlı öz-ilgi herhangi bir evrişim işlemini ifade edebilir

-

- AAAI Online Live | Dikkat HetSANN modeline dayalı olarak heterojen ağ semantik bilgilerini otomatik olarak madenciliği

-

- IJCAI 2020 o kadar acımasız ki, gönderilen bildirilerin% 42'si son incelemeden önce reddedildi! Reddedilen yazar: cahil bir güce bakın, bunun üzerine geribildirim mi?

-

- Pekiştirmeli öğrenmede her yerde bulunan Bellman optimallik denkleminin arkasındaki matematiksel ilke nedir?

-

- Yicai muhabirleri Şangay Otobanı G50'ye gece ziyaretleri, Şangay'a giren araçların salgın durumuna ilişkin 24 saat kesintisiz nokta kontrollerine başlıyor