Beyin dalgalarından metne kadar güçlü bir beyin-bilgisayar arayüzü, sadece bir makine çeviri modeline ihtiyaç vardır

Yazar | Jia Wei

Editör | Jiang Baoshang

Makine çevirisi gerçekten her şeye kadirdir: Sadece şiir yazabilir, beyit beyitleri yazabilir, diferansiyel denklemler türetemez, aynı zamanda beyin dalgası bilgilerini de okuyabilir.

Dün, San Francisco'daki California Üniversitesi'nden Joseph Makin ve diğerleri, Nature Neuroscience'da "Serebral kortikal aktiviteyi metne çevirmek için kodlayıcı-kod çözücü çerçevesini kullanma" (kortikal aktivitenin bir kodlayıcı ile metne makine çevirisi - kod çözücü çerçevesi).

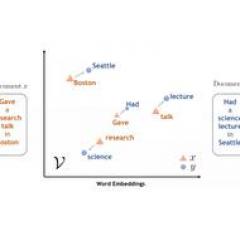

Bu yazının çalışma fikri çok basit. Beyin dalgalarının metne dönüştürülmesini makine çevirisi süreci, beyin dalgalarını girdi dizisi ve metin çıktı dizisi olarak görüyorlar.

Deneklerin metni yüksek sesle okumasına izin vererek, bir eğitim veri kümesi oluşturmak için ilgili beyin bölgesinin elektrik dalgalarını toplayın ve ardından uçtan uca bir makine çeviri modeli eğitin.

Böylelikle, deneğin beyin dalgalarını "doğru" ve "gerçek zamanlı" cümle metnine dönüştürebilen ve sadece% 3'lük bir hata oranıyla bir model elde ettiler.

Bu tür bir yenilik şüphesiz devrim niteliğindedir.

Şu anda, beyin kontrollü yazım için kullanılan beyin-bilgisayar arayüz teknolojilerinin çoğu, başın veya gözlerin artık hareketlerine dayanıyor. Hawking'i örnek alırsak, ifade etmek istediği kelimeleri yazmak için parmak hareketleriyle sanal klavyeyi kontrol edebilir. Ancak bu şekilde dakikada en fazla 8 kelime yazılabilir.

Sözlü konuşmanın (veya konuşma girişiminin) metne dönüştürülmesine yönelik bazı girişimler de vardır, ancak şimdiye kadar tek heceli veya tek heceli metinlerin kodunun çözülmesiyle sınırlıdır. Orta boyutlu metinlerde (yaklaşık 100 kelime) hata oranı genellikle% 60 veya daha fazladır .

Joseph ve arkadaşlarının bu çalışması, beyin dalgalarını neredeyse hiç gecikmeden doğrudan metne dönüştürür ve şüphesiz felçli hastalar için büyük bir nimettir.

1. Genel fikir

Daha önce bahsedildiği gibi, yazar doğal dil işleme alanından kavramlar ödünç almıştır Doğal dilde makine çevirisinde metin bir dilden diğerine çevrilir. Metnin beyin dalgaları aslında benzer bir "çeviri" sürecidir.

Kavramsal olarak, bu iki senaryonun amacı, iki farklı temsil arasında bir eşleştirme ilişkisi kurmaktır. Daha spesifik olarak, her iki durumda da amaç, herhangi bir uzunluktaki bir diziyi, herhangi bir uzunluktaki başka bir diziye dönüştürmektir. Burada "keyfi" yi vurgulamak önemlidir, çünkü girdi ve çıktı dizilerinin uzunluğu değişkendir ve aralarında mutlaka deterministik bire bir yazışma olması gerekmez.

Joseph ve arkadaşları tarafından yapılan bu çalışmada, derin öğrenmeye dayalı mevcut uçtan-uca makine çeviri algoritmasına benzer şekilde, her seferinde bir cümlenin kodunu çözmeye çalıştılar.

İkisi arasındaki benzerlik, aynı tür çıktıyla, yani bir cümlenin kelime dizisiyle eşleşecekleridir. Aradaki fark, makine çevirisinin girdisinin metin olması, Joseph ve arkadaşlarının çalışmasının girdisinin sinirsel sinyaller olmasıdır - denekler cümleleri yüksek sesle okur ve deneyciler, katılımcıların yüksek yoğunluklu elektroensefalogram ızgaralarını (ECoG ızgaraları) kullanır. Serebral kortekste sinyalleri toplayın.

Bu nedenle, sinir sinyalinin biraz işlenmesinden sonra, seq2seq mimarisinin makine çeviri modeli, temelde değişiklik yapılmadan doğrudan uçtan uca eğitim için kullanılabilir.

Bu çalışmada en zor olan şey yeterli eğitim veri setlerinin nasıl elde edileceğidir. Makine çevirisinin veri setinin milyonlarca ölçeğe ulaşabileceğini biliyoruz, ancak bu deneydeki her konu yalnızca en fazla birkaç binlik sırayla veri sağlayabilir. Bu seyrek eğitim verileri bağlamında, uçtan uca öğrenmeden tam anlamıyla yararlanmak için yazar, yalnızca 30-50 ayrı cümle içeren kısıtlı bir "dil" kullanır.

2. Model

Bu çalışmada, girdi verilerini toplamak için katılımcılardan cümleleri yüksek sesle okumaları ve beyin dalgası aktivitesini gözlemlemeleri istenmiştir. Sesli okunması gereken bir veri seti, bir resim açıklaması, yaklaşık 30 cümle, 125 kelime, diğer set MOCHA-TIMIT korpus veri tabanından 50 cümle küme olarak kullanır ve son set 60 cümle içerir.

Toplam dört katılımcı yüksek sesle okudu ve araştırmacılar sadece üç kez tekrarlanan cümle setlerini değerlendirdi, test için bir okumanın verisi ve eğitim için iki tane kullanıldı.

Katılımcılar yüksek sesle okuduğunda beyin dalgaları üretilir.Katılımcılar elektrotlarla bağlandıktan sonra, araştırmacılar katılımcıların serebral korteksinden sinyal toplamak için yüksek yoğunluklu elektroensefalogram ızgaraları (ECoG ızgaraları) kullanırlar.

Toplanan beyin dalgası sinyalleri ve yüksek sesle okunan karşılık gelen cümleler, "kodlama-kod çözme" mimarisinin yapay sinir ağına veri olarak girilecektir.

Yukarıdaki şekilde gösterildiği gibi, yapay sinir ağı, giriş verilerini üç aşamada işler:

1. Zamansal evrişim: Bazı benzer özellikler, EEG sinyal veri dizisinin farklı noktalarında yeniden ortaya çıkabilir ve bu açıkça, tamamen bağlı bir ileri beslemeli sinir ağı tarafından işlenemez. Bu kuralı etkili bir şekilde öğrenmek için ağ, belirli bir adım aralığında her aralığa aynı geçici filtreyi (geçici olarak kısa flter) uygular.

2. Kodlayıcı döngüsel sinir ağı: Zamanlı evrişim sürecinden sonra, karakteristik dizi üretilecek ve karakteristik dizi kodlayıcı döngüsel sinir ağına girilecektir Daha sonra sinir ağının gizli katmanı tüm dizinin yüksek boyutlu kodlamasını sağlayacaktır. Uzunluk önemsizdir.

3. Kod çözücü döngüsel sinir ağı: Kod çözme aşamasında, odak noktası yüksek boyutlu bir diziyi bir kelimeye "çevirmek" olacaktır. Bu sırada, tekrarlayan sinir ağı başlatılacak ve ardından kelimeyi her adımda tahmin edecek ve tahmin sonucu sekans sonu belirteci olduğunda kod çözmeyi durduracaktır.

Yazar tarafından kullanılan sinir ağı çerçevesi aşağıdaki şekilde gösterilmektedir:

Tüm ağı eğitmenin amacı, sinir ağını iyi sıralı kod çözme üretmesi için yönlendirebilen MFCC'ye (Mel Cepstrum Katsayı Özelliği) yakın olmaktır. Bununla birlikte, model test aşamasında, MFCC terk edildi ve kod çözme, tamamen kod çözücü sinir ağının çıktısına dayanıyordu. Model eğitiminde, stokastik gradyan iniş yöntemi tüm eğitim süreci boyunca çalışır ve bırakma tüm ağ katmanlarına uygulanır.

Model değerlendirmesi kelime hata oranı (WER) ile ölçülür.WER'in temel fikri, doğru cevabı makinenin tanıma sonucu, kelime çift kelime ile sıralamak ve fazladan kelimeleri, eksik kelimeleri ve hataları saymaktır. Tanınan kelimelerin tümü birbirine eklenir ve hata olarak sayılır ve ardından yanlış kelimelerin toplam kelime sayısına oranı hesaplanır.

Doğrulamadan sonra, tüm katılımcıların ortalama WER'si% 33'tür ve bu,% 60'lık mevcut son teknoloji konuşma kod çözme WER'den daha iyidir.

3. Deneysel sonuçlar

Yazar, makalede toplam iki deney gerçekleştirmiştir: Biri, bu modelin neden bu kadar iyi performans gösterdiğini görmek için benzer bir "kontrol değişkeni" yöntemini benimsemek, diğeri ise diğer katılımcıların modellerinin performansını aktarımla öğrenme yoluyla iyileştirmektir.

"Kontrol değişkeni" deneyinde, yazar ağı yeniden eğitmiştir Yukarıdaki şekildeki ikinci kutu, düşük yoğunluklu ECoG ızgaraları ve altörnekleme performansıdır. Ayrıca yazar kanalların sadece 1 / 4'ünü bırakmış yani 256 kanal yerine sadece 64 kanal kullanmış, şu anda kelime hata oranı orjinalinden dört kat daha fazladır. Bu, yüksek yoğunluklu EEG ızgaralarına ek olarak, algoritmaların da çok önemli olduğu anlamına gelir.

Üçüncü kutu, MFCC eklenmediğindeki performanstır Hata oranı düşük yoğunluklu EEG ızgarasına benzer, ancak önceki konuşma kod çözme girişimlerinden daha iyidir.

Dördüncü kutu, tamamen bağlı bir ağ kullanmanın sonucudur.Evrişimli bir ağ için, tam bağlanmanın hata oranı öncekinden 8 kat daha yüksektir. Ancak deneyde yazar, tamamen bağlı bir ağın kullanımından kaynaklanan kelime hata oranının, yüksek sinyal iletilmeden önce aşağı örneklenebileceğini buldu.

Son olarak yazar, tekrarlanan deneylerin yanlış kelimelerin oranını etkileyip etkilemediğini belirledi. Çalışmalar, en az 15 eğitim tekrarı olduğunda, hata oranının% 25'ten az olabileceğini bulmuştur.

Yukarıdaki şekilde gösterildiği gibi, eğitim seanslarının sayısı az olduğunda, katılımcı a ve katılımcı b'nin kod çözme performansı çok zayıftır Bu sorunu çözmek için yazar aktarım öğrenmeyi denedi.

Yukarıdaki Şekil a'daki ilk kutu, MOCHA-1 verileriyle eğitilmiştir ve hata oranı% 53'tür. Katılımcı b'nin daha zengin veri seti üzerinde ilk kez ön eğitim için ağın performansı göz önüne alındığında, bu tür bir aktarım öğrenme, hata oranını yaklaşık% 17 azaltabilir (yukarıdaki şekil a'daki ilk kutudan ikinci kutuya) Gösterildi).

Yazar ayrıca, kodlayıcı-kod çözücü ağının, katılımcı b'nin tüm MOCHA-TIMIT verilerine dayalı olarak önceden eğitildiği; daha sonra, her zamanki gibi, a katılımcısının tüm MOCHA-TIMIT verileri üzerinde eğitildiği birleştirilmiş bir aktarım öğrenme biçimini düşünmektedir Katılımcı a'nın MOCHA-1 bloğunda test edin. Bu "çift aktarımla öğrenme" (Şekil a, dördüncü kutu), görev aktarımıyla öğrenmeye kıyasla bir gelişme olan taban çizgisine kıyasla hata oranını% 36 azaltır.

Daha sonra, iyileştirmenin ters yönde, yani katılımcı a'dan katılımcı b'ye aktarılıp aktarılmaması, yukarıdaki şekil b'de gösterildiği gibi açıkça mümkündür.

MOCHA-TIMIT verileri üzerinde en kötü performansı gösteren katılımcı d için, kalan MOCHAT cümlelerini eğitim setine eklemek sonuçları iyileştirmedi (şekil c'de gösterildiği gibi).

4. Tartışma

Açıkçası bu araştırmanın en büyük eksiği veri setinin çok küçük olması, sadece 250 kelime, 30-50 cümle olmasıdır.

Bu teknolojiyi genel doğal dile genişletmek istiyorsanız, ne kadar veriye ihtiyaç olduğunu ve yeterli veriyi nasıl elde edeceğinizi keşfetmeniz gerekir.

Aslında, elektroensefalogram ızgarası (ECoG) deneğin beynine uzun süre yerleştirilebilirse, mevcut eğitim verilerinin miktarı bu deneyden birkaç kat daha büyük olacaktır (yalnızca yarım saatlik veri toplanmıştır). Gerçek uygulamalarda, bazı kişilerin konuşma yeteneğini kaybettiği bazı durumlar olacaktır, ancak yine de performans biraz düşecek olsa da bu yöntem uygulanabilir.

Burada, AI Technology Review ayrıca makine çevirisinin özünün bir tür bilgi dizisini diğerine eşlemek olduğunu vurgulamak istiyor. Özellikle mevcut uçtan-uca teknoloji altında, problem ifadenizi bir sekans-sekans haritalama problemine çevirebildiğiniz ve ardından yeterli eğitim verisi topladığınız sürece, mevcut makine çevirisi teknolojisini ödünç alabilirsiniz. Büyük bir değişiklik yapın.

-

- Düşük güçlü bilgisayarla görme teknolojisinin sınırı, dört ana yön, daha küçük, daha hızlı ve daha verimli arayış

-

- ICLR 2020 | "Eşzamanlı Ortalama Öğretim" çerçevesi, denetimsiz öğrenim için daha sağlam sözde etiketler sağlar

-

- Kuantum bilişim araştırma ilerlemesi: Çin ve Amerika Birleşik Devletleri'nde 4 ila 5 yıllık bir teknoloji açığı var

-

- 2020 Ulusal Bilim ve Teknoloji Ödülleri adaylıkları açıklandı, Yang Qiang ve Chen Yunjinin ekipleri kısa listeye alındı

-

- ELECTRA Çin ön eğitim modeli, yalnızca 1/10 parametreli açık kaynak kodludur ve performans hala BERT ile karşılaştırılabilir.